6.1. 매개변수 갱신

- 최적화(optimization) : 신경망 학습의 목적은 손실함수 값을 최소로 하는 매개변수를 찾는 것

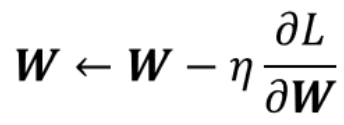

- 확률적 경사 하강법(SGD, Stochastic Gradient Descent)

1) 최적 매개변수 값 찾기 위해, 매개변수 기울기 구해 기울어진 방향으로 매개변수 값 갱신하는 것을 반복하는 방법

2) 현재 위치에서 가장 기울기가 큰 방향으로 이동

3) 기울어진 방향으로 일정 거리만 가겠다는 방법

4) SGD는 단순&구현 용이하나, 문제에 따라 비효율적 -> 대체 기법 : 모멘텀, AdaGrad, Adam

(수정중)