MichiganUniversity

1.미시간대 강의_Space Warping

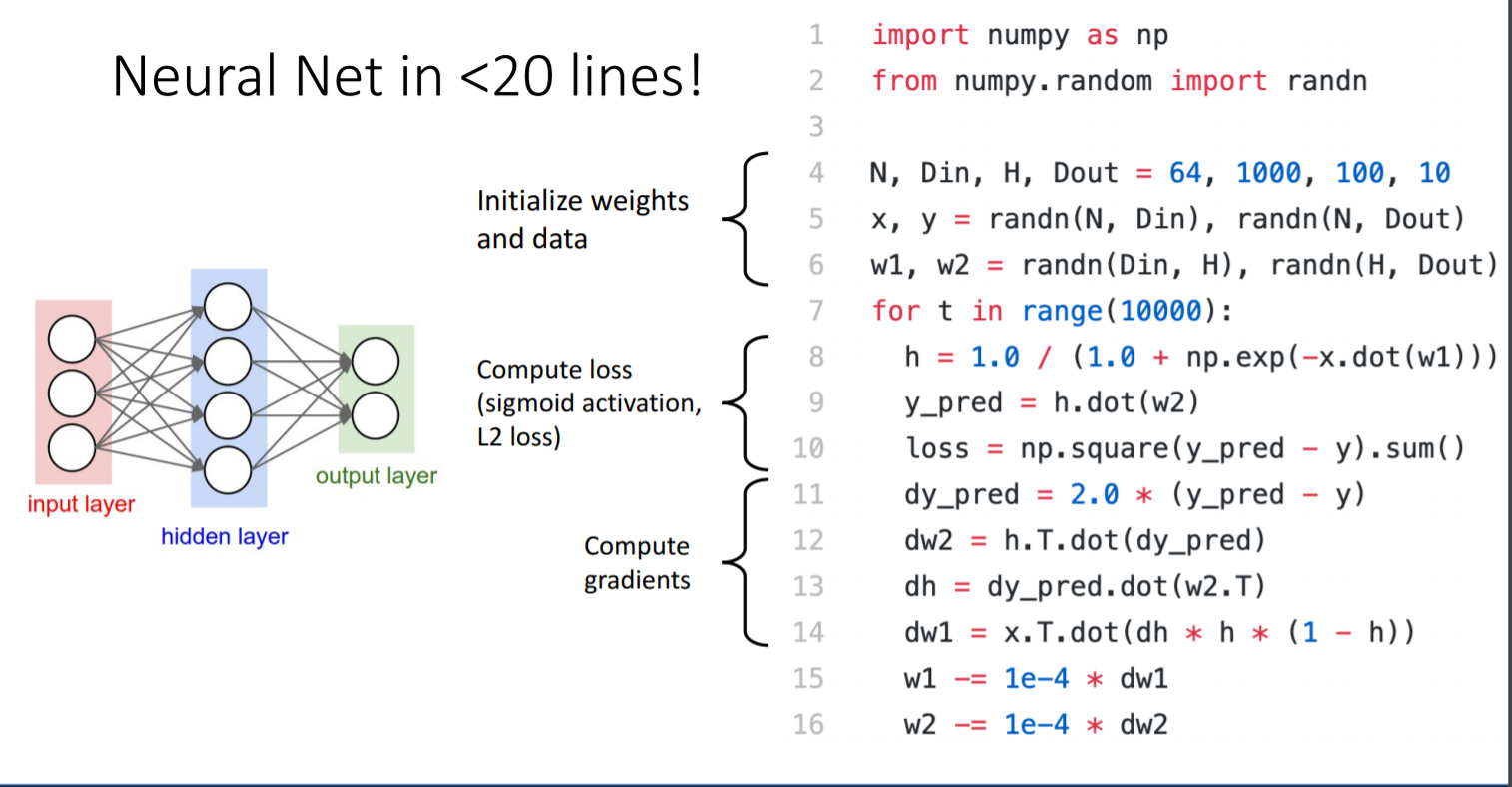

< 출처: 498_FA2019_lecture05>np.random.randn(m,n): 평균 0, 표준편차 1의 가우시안 표준정규분포 matrix array m, n을 생성한다. 예를 들어, 그렇다면 신경망 아이디어를 어디서 착안한 것일까? 뇌의 뉴런과 시냅스로부

2021년 8월 2일

2.미시간대 강의_batch normalization

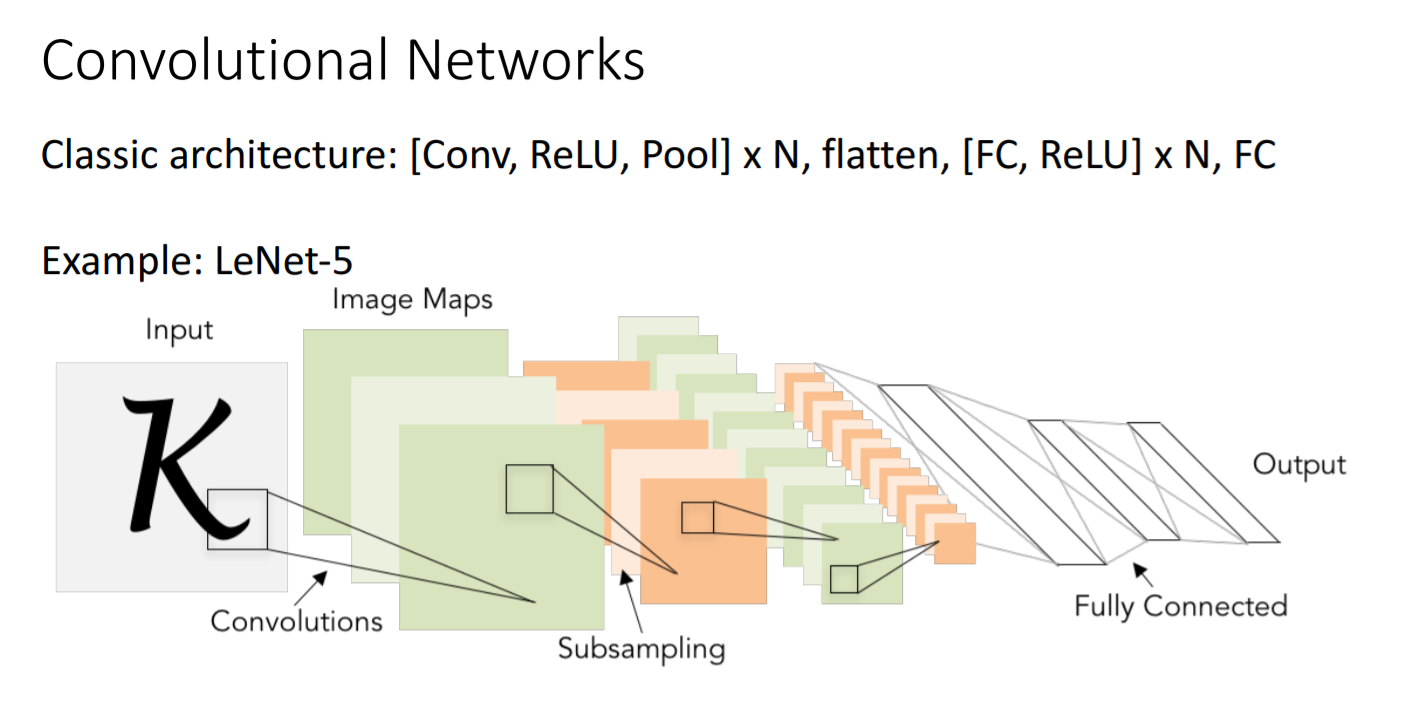

Convolutional Network는 convolutional layer과 max pooling layer으로 크게 두 부분으로 나눌 수 있다. Input layer는 색깔이 없는 1, 28 28크기의 이미지가 입력된다. Convolutional layer 뒤에는

2021년 8월 23일

3.미시간대 강의_dropout

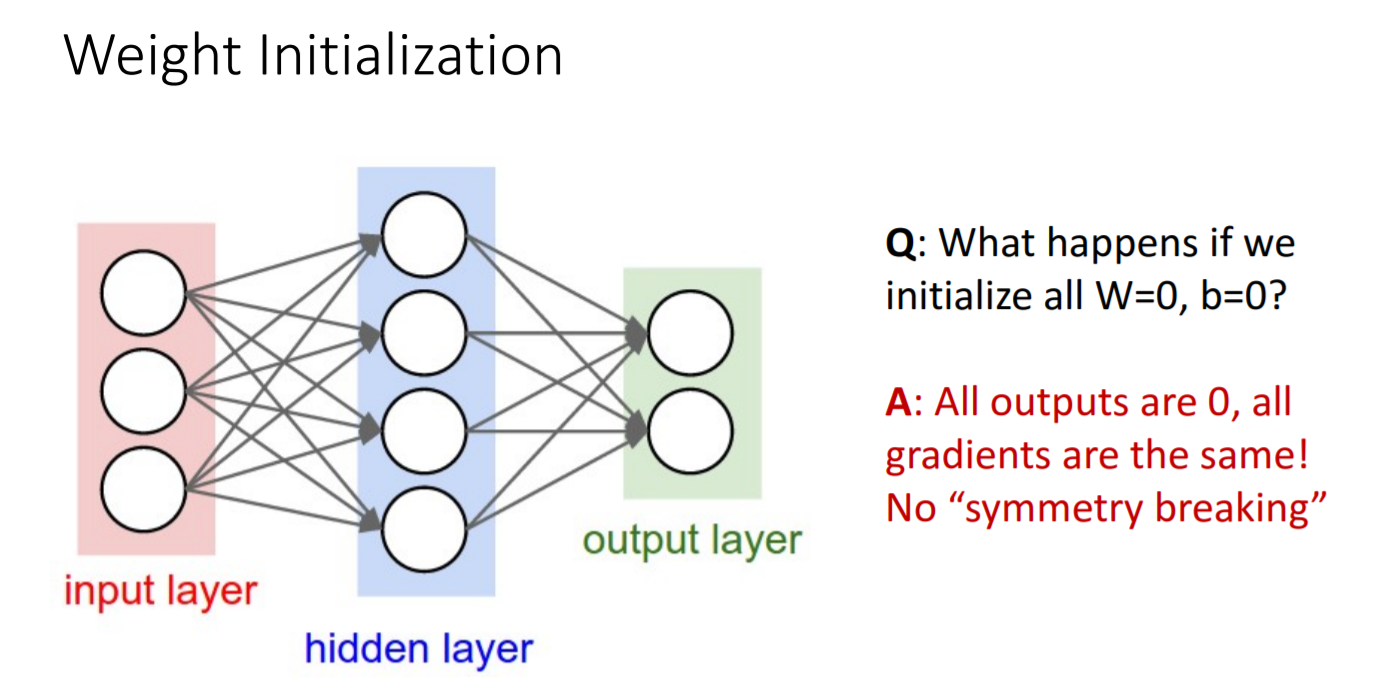

가중치의 초기값을 어떻게 설정해줘야 할까?시도 1) 만약 초기값을 모두 0으로 설정한다면 모든 gradient의 값이 0이 될 것이므로 의미없는 훈련을 하게되는 셈이다.시도 2) 그러면 무작위의 작은 숫자로로 설정해보는 것은 어떨까?6개의 layer만 통과해도 vani

2021년 8월 23일

4.미시간대 강의_LSTM : uninterrupted gradient super highway

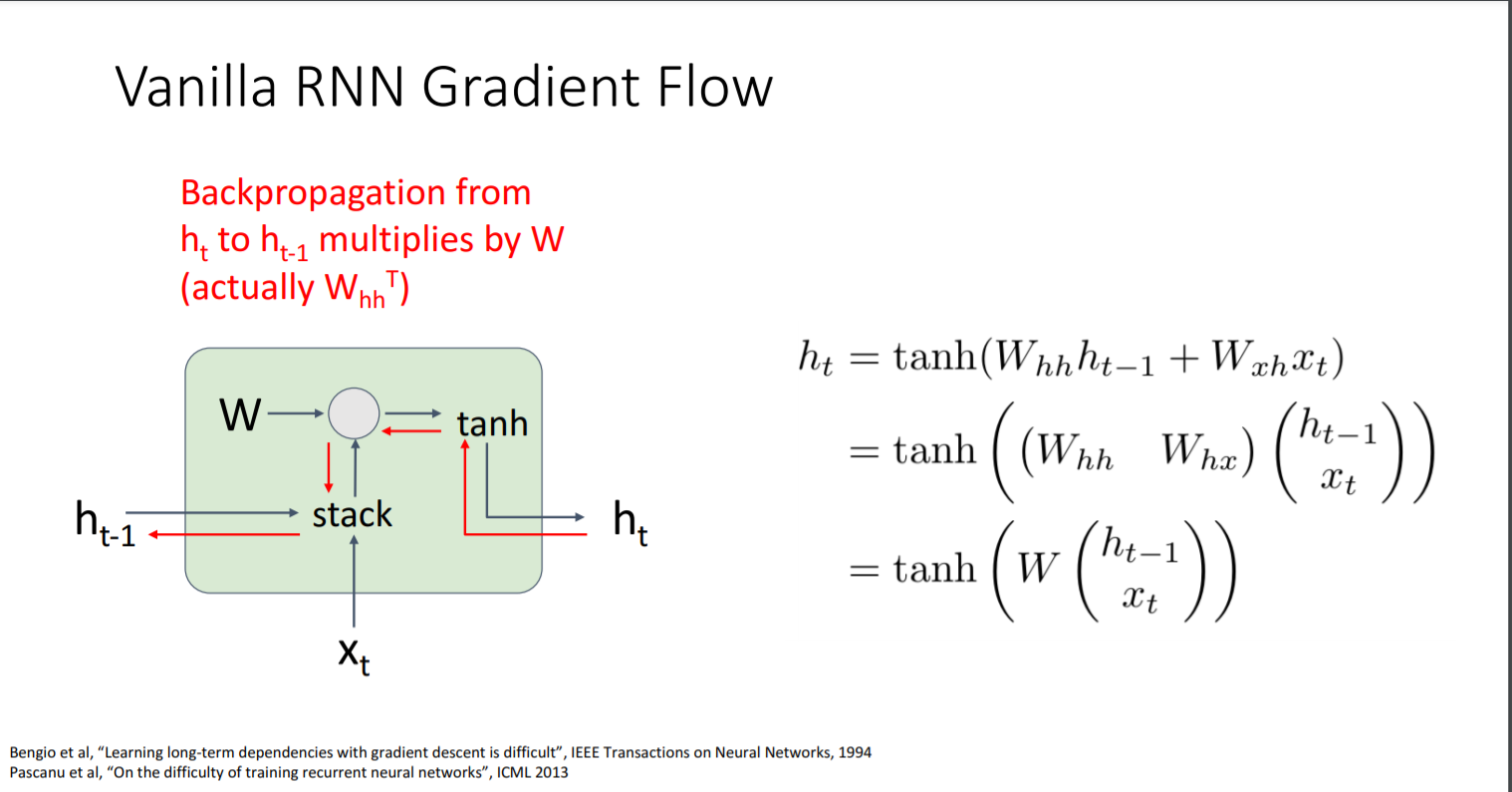

RNN은 같은 weight matrix를 사용하기 때문에 입력 sequence의 길이가 어떻든 간에 사용할 수 있다는 이점이 있다. 하지만 단점 역시 존재한다. 가장 기본적인 형태의 RNN형태를 통해 그 단점이 무엇인지 살펴보자. Backpropogation을 할 때

2021년 8월 30일