'25 아키텍처 스터디 5주차

paper link

[!summary] Abstract

1. 🤖 Perceiver는 Transformer를 기반으로 하며, 다양한 modality의 고차원 입력 처리를 위해 설계되었습니다.

2. ⚙️ 이 모델은 비대칭적인 attention 메커니즘을 사용하여 입력을 작은 latent bottleneck으로 반복적으로 압축하여 큰 입력도 처리할 수 있습니다.

3. 🏆 Perceiver는 이미지, 포인트 클라우드, 오디오, 비디오 등 다양한 modality에서 특화된 모델들과 경쟁력 있는 성능을 보여줍니다.

- 언어, 이미지, 소리, 영상공간 데이터 처리 모델

- Perceiver는 트랜스포머를 약간 수정해서 만든 모델로, 모든 종류의 입력 데이터를 다루도록 하여 이미지 인식 등 대개 별도의 신경망 개발이 필요한 태스크 또한 수행이 가능하다!

- 사람은 수많은 다양한 분야에 대해서 유용한 표현(특징, Representation)을 학습할 수 있고, 소량의 데이터 및 태스크 예시만으로도 빠르게 새로운 태스크를 풀 수 있음. 이게 가능한 건 사람은 이미 세상에 대해 알고 있는 모든 것을 새로운 영역에 활용하기 때문

-> Perceiver는 이러한 멀티태스킹 접근법을 가지며 이미지, 영상, 포인트 클라우드 세 가지 종류의 입력을 받아들일 수 있는 모델임! - 때문에 이러한 Perceiver의 유연성은 모델 설계에 드는 노력을 줄여주고, 다양한 modality의 데이터를 통합적으로 분석할 수 있는 가능성을 열어준다.

Introduction

- 이 논문에서는 단일 트랜스포머 기반 아키텍처를 이용하여 다양한 modality의 임의의 구성을 처리하도록 설계된 모델인 Perceiver를 소개한다!

- Transformer는

Methods

The Perceiver Architecture

- 특정 도메인 가정이 없이 다중 양식 좋바과 같은 고차원으로 확장되는 attention 원리에 기반한 아키텍처

- 주요 목표! : 매우 큰 입력 데이터(ex. 이미지 픽셀, 오디어 샘플, 긴 텍스트)를 효율적으로 처리하는 것.

1. 입력(input)

- byte Array(MXC) : 모델이 처리하려는 주된 입력 데이터이며 크기가 매우 클 수 있음(M). 각 요소는 C 차원의 특징 벡터를 가지고 있다.

- Latent Array(NXD) : 상대적으로 작은 크기의 학습 가능한 잠재(latent) 벡터 배열로 입력 데이터의 정보를 요약하고 처리하는 작업 공간의 역할을 한다.

2. 처리(Processing Block)

Cross Attention

이를 이용해 이차 복잡도를 해결할 수 있다.

-

Latent Array와 Byte Array를 입력으로 받는다.

-

Latent array에서 query(Q)를 생성하고, Byte array에서 Key(K)와 Value(V)를 생성한다. 그런 다음, Latent array의 각 벡터가 Byte array 전체에 대해 어텐션을 수행해서 정보를 가지고 온다.

-> 잠재 벡터들이 입력 데이터에서 어떤 정보에 주목해야 할지를 학습 -

출력 : Latent array와 동일한 크기(NXD)의 업데이트된 잠재 배열을 출력한다.

= 큰 Byte array의 정보가 작은 latent array로 압축/요약되는 것 -

계산 복잡도는 대략 O(N*M) : N이 작기 떄문에 Byte Array 전체에 대해서 셀프 어텐션을 수행하는 것보다 훨씬 효율적임!!

-

여기서 잠재 배열의 크기는 일반적으로 작으며 하이퍼파라미터로 정함!

[!note] Taming quadratic complexity with cross-attention

- attention을 중심으로 아키텍처를 구성하는 이유는 attention이 일반적으로 적용 가능하고 실제로 강력하기 때문!

Latent Transformer

-

입력 : 이전 Cross Attention 블록의 출력 (N x D 크기의 잠재 배열)을 받는다.

-

이전 step에서 Byte array에서 관련 정보르 끌어와 Latent array 벡터의 각 벡터를 업데이트함

= 잠재 벡터에는 입력 데이터의 특정 부분이나 측면에 대한 정보가 있음

= BUT! 이 정보들은 아직 개별적으로 존재하며, 서로 연결되거나 종합적으로 처리되지 않음 -

Latent Transformer은 Self-Attention와 Feed-Forward Network로 구성됨.

= Self-Attention을 통해 각 잠재 벡터는 다른 잠재 벡터들의 정보를 참고하여 자신의 표현을 업데이트 -

이때 latent transformer는 GPT-2 아키텍처를 사용함.

-

이 부분은 입력 크기와는 무관하기 때문에 아주 깊게 쌓아도 부담이 적다.

-

Cross-attention의 출력은 Latent 배열 형태를 가지므로 이를 통해 bottlenexk(병목)이 생긴다.

-

우리는 이 bottleneck을 통해 Latent 공간에서 깊은 Transformer를 만들 수 있음

= 이 경우 복잡도는 O(N^2) -

Perceiver는 이렇게 해서 입력 크기(M)와 네트워크 깊이(L)을 분리할 수 있음

= ==일반 Transforemer가 O(L x M^2) 의 복잡도를 가진다면 Perceiver는 O(M×N + L×N²)==

이 실험에서는 Latent Transformer 없이 오직 Cross-Attention 만 쌓아서 모델을 구성한 것이다. 또한, 각 Cross-Attention 레이어는 서로 가중치를 공유하지 않는다!

이때 레이어 수가 늘어남에 따라서 모델의 연상량이 급격하게 증가하다가, 12개에서는 결국 메모리 부족(OOM : Out Of Memory) 문제가 발생해 결과를 얻지 못했다.

= Latent Transformer가 필요함!

[!note] Feed Forward Network

- Self-attention이 정보의 관계와 혼합을 담당한다면, FFN은 개별 정보의 내용을 심화하고 변환하는 역할을 한다!

- 여러 층을 쌓는 방식으로 설계되며 각 층은 이전 층의 출력을 받아들여 다음 층에 전달함

- 활성화 함수(ex. RELU, Sigmoid, Tanh) 등을 사용해서 비선현 변환 수행 -> 복잡한 함수나 관계를 모델링할 수 있음 (better than 선형 회귀)

3. 반복과 가중치 공유

- Our model applies the cross-attention module and the Transformer in alternation

- Cross Attention과 Latent Transformer 블록 쌍이 여러 번 반복됨

- 반복되는 이유

잠재 배열의 크기(N)은 입력 바이트 배열의 크기(M)보다 훨씬 작다. 때문에 한 번의 cross attention 만으로는 거대한 입력(MXC)의 모든 중요한 정보를 작은 잠재 배열(NXD)로 완벽하게 압축하기 어려움! - 병목 현상의 심각성!

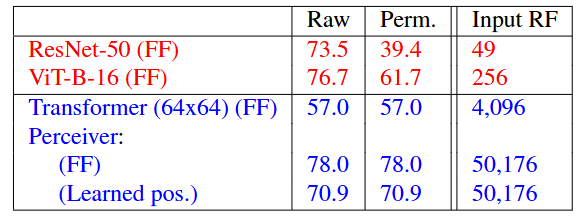

이 표는 Cross-Attention을 사이에, 그리고 시작점에 몰아서 배치했을 때 그 성능을 보여준다.

이때 Cross-Attention 수를 늘릴 수록 at start 방식은 점점 성능이 저하되는 것을 볼 수 있음!

= 점진적 정보 처리가 중요하다! = 입력을 한번에 처리하는 것보다 입력에서 정보를 가져오고, 그 정보를 잠재 공간에서 처리한 다음(Latent Transformer), 다시 또 처리된 정보를 바탕으로 입력에서 필요한 정보를 가져오는(다음 Cross Attention) 과정이 더 효과적임!

4. 출력(Output)

- 여러 번의 처리 블록 반복 후, 최종적으로 정체된 Latent array(NXD)가 생성된다.

평균

최종 잠재 배열의 모든 벡터(N개)를 평균내어 하나의 요약 벡터(D차원)을 만든다.

- 원래: N개의 벡터가 있었고, 각 벡터는 D차원(즉, 행렬의 크기는 N x D).

- 평균 연산 후: 1개의 벡터가 남게 되며, 이 벡터는 여전히 D차원 (즉, 벡터의 크기는 1 x D 또는 그냥 D).

Logits

이 최종 요약 벡터(D차원)를 선형 레리어에 통과시켜 분류나 회귀 등 특정 작업에 대한 최종 예측 값을 생성함.

Position Encodings

Attention은 공간 정보가 없기 때문에 위치 인코딩을 줘야 한다!

Positional Encoding은 주로 입력 데이터(byte array)에 한 번, 그리고 첫 번째 cross-attention 들어가기 전에 한 번 적용된다.

- Byte array의 각 요소가 원래 입력 데이터에서 어떤 절대적인 위치에 있었는지에 대한 정보를 제공함

Experiments

Image - ImageNet

ImageNet 데이터셋을 사용하여 단일 이미지 분류를 했고 Top-1 검증 정확도를 이용해서 평가를 진행하였다.

위치 인코딩 설정

ImageNet 실험에서 위치 인코딩은 어떻게 설정했을까?

1. 크롭된 이미지 픽셀 좌표 사용

ImageNet의 이미지는 크기가 다양하기 때문에 보통 모델에 넣기 전에 224x224 픽셀 크기로 이미지를 잘라내거나 크기를 조절한다.

여기서 왜 원본 이미지 전체가 아니라 ==크롭된 이미지의 좌표==를 쓰는 걸까?

만약 어떤 픽셀이든 절대적인 위치를 기준으로 계산된다고 한다면, 특정 위치에 있는 픽셀의 RGB 값이 특정 패턴이면 이건 강아지일 확률이 높구나! 라고 암기해버려 과적합이 일어날 수 있다.

Crop 좌표를 사용하면 위치와 가로세로 비율 모두에서 데이터 증강 효과가 발생하기 떄문에 RGB 값과 위치 특징 간의 고정된 상관관계를 깨트린다!

2. 좌표값은 [-1, 1] 범위로 변환

좌표값의 범위를 일정하게 맞추면 모델이 학습하기 더 쉬워지기 때문

3. 표준화된 좌표로 인코딩 벡터 만들기

이때 푸리에 특징(Fourier Features)을 사용한다.

푸리에 특징이란? 간단히 말해서 여러 가지 다른 주파수를 가진 cos와 sin을 사용하는 것!

4. 인코딩 벡터와 픽셀 정보 합치기

이 위치 인코딩 벡터를 해당 픽셀의 RGB 정보와 합쳐서 최종 입력 벡터를 만든다!

과정

학습은 120 에포크, 초기 학습률 0.004

Cross-attention은 총 8번 수행하였음며 이후에는 6개의 블록으로 구성된 Latent Transformer를 구성하였다.

= Cross-Att -> 6 Latent Blocks -> Cross-Att -> 6 Latent Blocks ... 8번 반복)

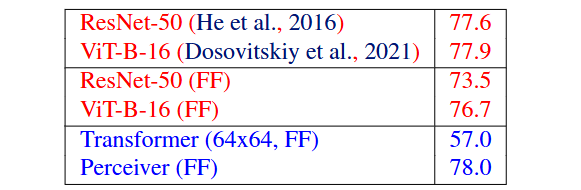

결과

==Standard ImageNet 결과==

최고 성능을 보여줌

==Permuted ImageNet 결과==

픽셀 순서를 임의로 섞음! 그러면 2D 격자 구조에서 당연했던 이웃 관계가 깨져버린다.

Resnet이나 Vit 에 비해서 원본 데이터와 순서를 무작위로 바뀐 데이터에서 높은 성능을 보이고 있음!

= 위치 인코딩의 역할 재확인

= 애초에 입력을 1D 시퀀스나 집합으로 간주하고 관계는 어텐션 메커니즘과 명시적 위치 인코딩을 통해 학습하므로 크게 상관이 없다!

= 특정한 공간구조(ex.2D)에 대한 가정이 거의 없는 매우 일반적인(general) 아키텍처다!!

(격자구조 아니어도 돼!)

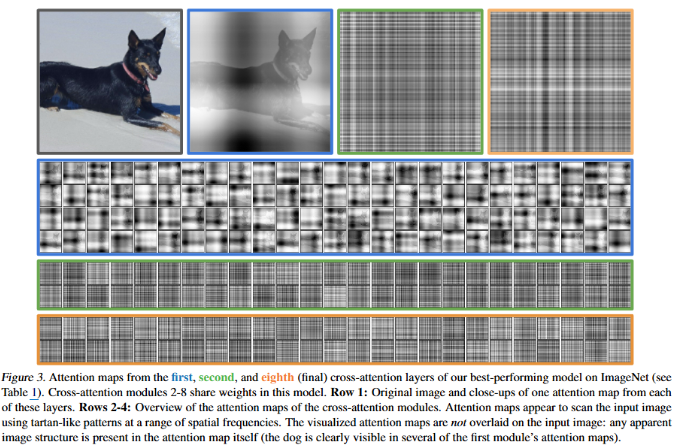

==Attention Map==

첫 번째 그림은 원본

파란 테두리는 어디에 집중할 것인지 핵심 대상 찾기

3~4번째 그림은 기술적으로 사진을 뜯어보는 것.

Audio and video - AudioSet

사용한 데이터셋은 AudioSet(170개의 10초짜리 비디오, 527개 소리 클래스)

평가 지표는 mAP(mean Average Precision)

입력 종류는 1) 소리만 입력 2) 영상만 입력 3) 소리+영상 동시 입력

==모델 구조==

AudioSet은 데이터 규모가 크므로 더 빠른 버전의 Perceiver를 사용함

-

Cross-attention : 8번 -> 2번

-

Latent Transformer 깊이 증가 : 블록당 6개 -> 8개

-

소리만 입력했을 경우나 비디오만 입력했을 경우 SOTA 모델에 근접함

-

특히 Raw audio에서도 좋은 성능을 낸다!

= 전통적으로 오디오를 딥러닝 모델로 처리할 때는 원시 오디오 파형을 그대로 사용하기 보다 스펙트로그램 같은 형태로 변환하는 것이 일반적이었음!

= 스펙트로그램 변환 과정에서 손실될 수 있는 모든 잠재적인 정보를 모델이 활용할 수 있는 가능성!! -

그러나 소리 +영상 융합 시 단일보다는 성능이 향상됐으나 다른 각 modality를 따로 학습시킨 후에 결과를 합치는 방식의 SOTA 모델보다는 성능이 약간 낮음 -> 추후 연구 과제!

Point Clouds - ModelNet40

3D 삼각형 메쉬에서 파생된 포인트 클라우드 데이터셋으로 40개 객체 카테고리를 포함하고 있으며 각 객체의 분류를 예측하는 것이 목표이다. 주어진 입력은 약 2000개의 점의 3D 공간에서의 좌표.

2개의 Cross-attention과 6개 깊이의 Self-Attentoion을 이용함!

![[Pasted image 20250430155136.png]]

Discussion

- Perceiver는 수십만 개 이상의 입력을 처리할 수 있는 일반적인 인지 아키텍처다.

- 그러나 유연성이 클 수록 과적합이 발생하기 쉽기 떄문에 이를 완화하기 위한 많은 설계 결정을 내렸다.

[!Question] 왜 유연하면 과적합 발생?

- 모델의 복잡성 증가 : 훈련 데이터의 노이즈나 비규칙적인 패턴까지 학습해, 실제 데이터에 대한 일반화 성능이 떨어질 수 있음

- 훈련 데이터에 대한 의존도 증가 : 모델이 훈련 데이터의 특성을 지나치게 배우면 예측 낮아짐

- 특히 적은 데이터셋에서 그럼