paper-review

1.[논문리뷰] Neural Machine Translation by Jointly Learning to Align and Translate(2015)

딥다이브 정기세션 첫 번째로 읽게 된 논문이자 Attention Mechanism의 시초라고 볼 수 있다는 논문을 리뷰해보려고 한다. 논문 리뷰는 엄청나야 한다는 생각에 시도도 못하고 있었는데 그냥 자유롭게 쓰면 된다는 딥다 멘토님의 조언에 따라 일단은 무작정 시작해보

2.[논문리뷰] Improving language understanding by generative pre-training(2018)

본 논문은 자연어 이해 태스크에서 강력한 성능을 달성하기 위해 생성 사전 학습과 판별 미세조정을 결합하는 프레임워크를 소개한다.지금까지의 NLP task들은 manually labeled data를 필요로 했다. unlabeled data 로 모델을 학습시켜 시간 소모

3.[논문리뷰] Retrival-Augmented Generation for Knoewledge-Intensive NLP Tasks(2020)

논문 리뷰를 시작하기 전, 해당 논문을 이해하기 위해 찾아봤던 개념들을 먼저 서술해보고자 한다. Open domain Question Answer의 약자로, 특정 도메인에 국한을 두지 않고 질문이 들어왔을 때 DB에 관련 문서를 찾아 정답을 찾아R주는 것을 말한다.OD

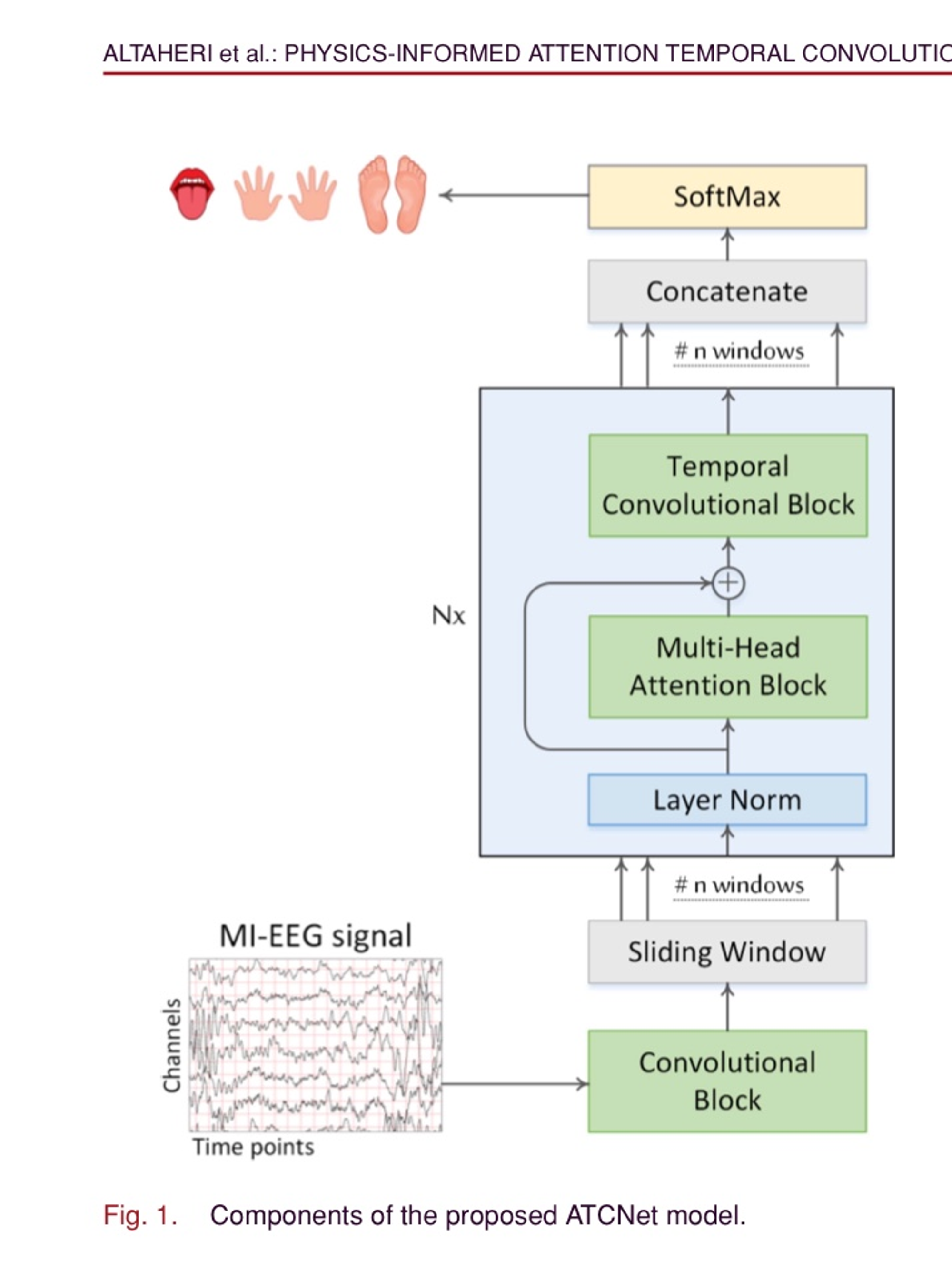

4.[논문리뷰] Physics-Informed Attention Temporal Convolutional Network for EEG-Based Motor Imagery Classification

해당 논문은 EEG(Elctroencephalogram) 기반 MI(Motor Imagine, 운동상상) 분류를 위한 어탠션 기반 시간 합성곱 네트워크, ATCNet 모델을 제안한다.ATCNet 모델은 원시 MI-EEG 신호를 압축된 시간 순서로 인코딩하는 CV 블록,

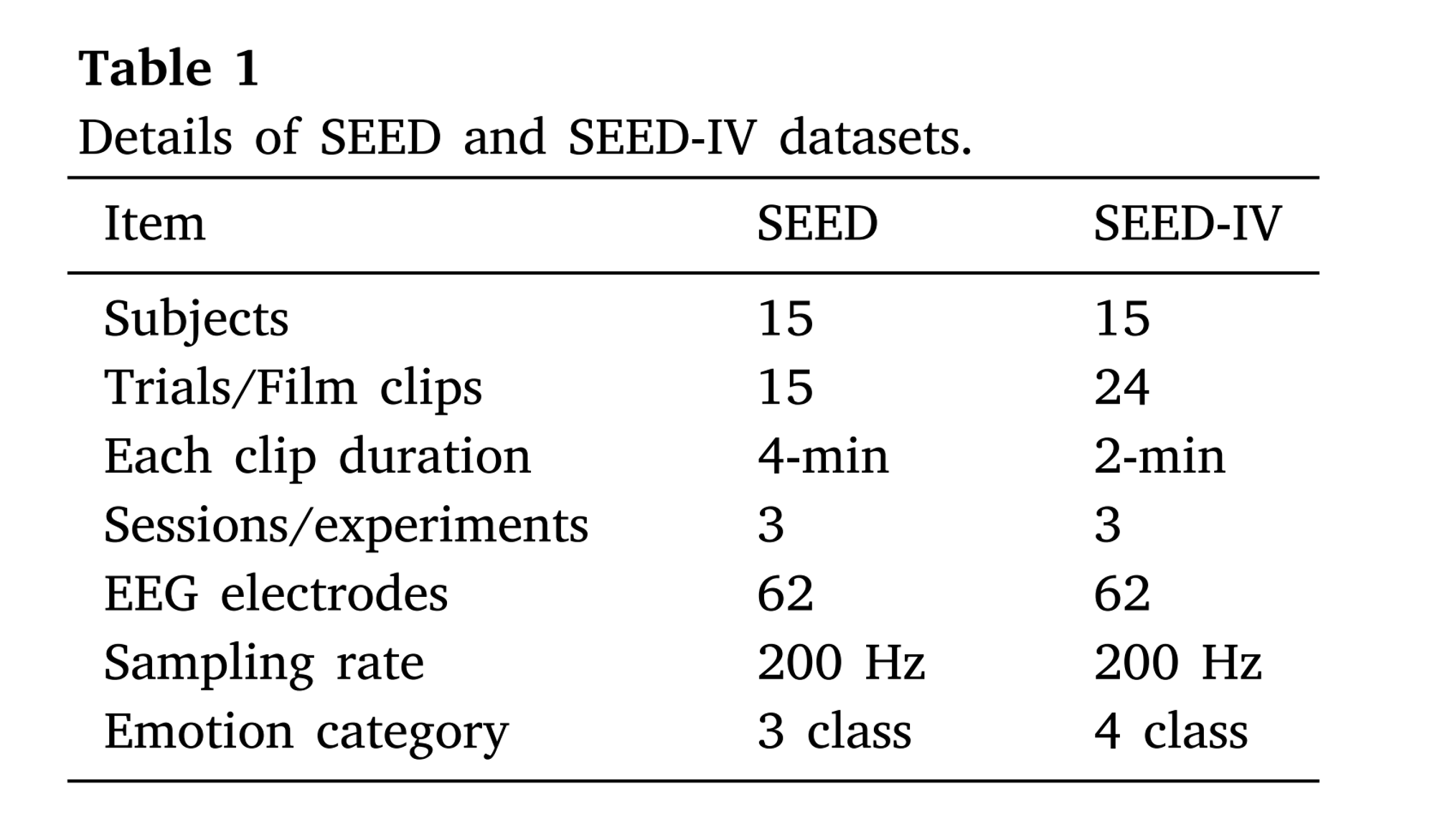

5.[논문리뷰] EEG emotion Recognition using Attention-based Convolutional transformer neural network

EEG 신호를 이용한 감정 인식에서 성능을 향상시키기 위해 공간적, 스펙트럼적, 시간적 정보를 효과적으로 결합하는 방법, ACTNN(Attention-based Convolutional Tranformer Neural Network)이라는 새로운 신경망 구조를 제안한다

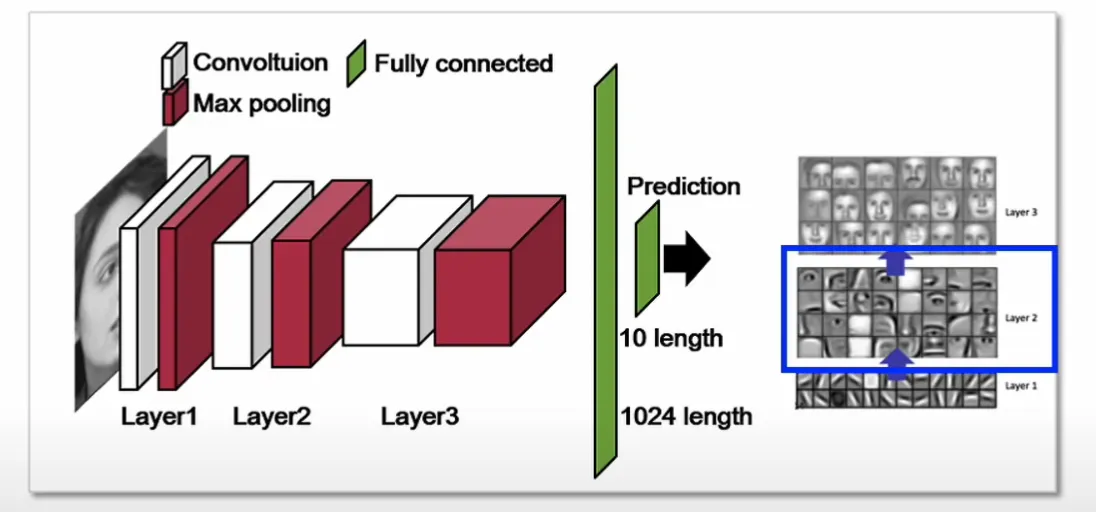

6.[논문리뷰] Visualizing and understanding convolutional networks

VisualizationCNN을 시각화한다는 것은 각 Layer들의 Filter들의 역할을 눈으로 볼 수 있게 하는 것FIlter를 시각화함으로써 CNN이 효과적으로 작동하는지 관찰Layer3에서 Feature Map의 특정값이 상당히 크다면 deconvolution을

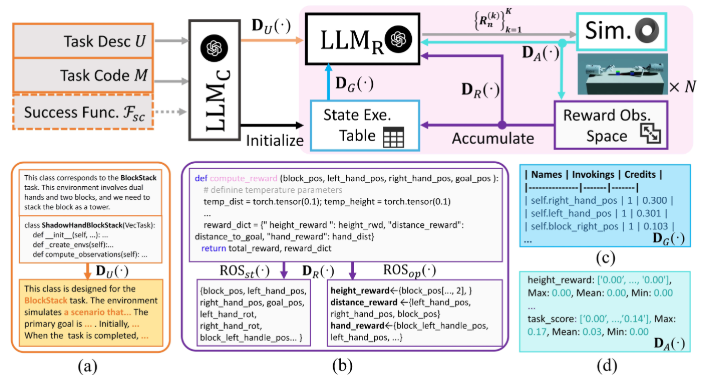

7.[논문리뷰] Boosting Universal LLM Reward Design through Heuristic RewardObservation Space Evolution

paper linkLLMs이 어떻게 강화학습 보상 설계를 자동화하는 데 사용될 수 있는지를 설명하고 있음보상관측 구간(ROS)을 구축 -> 관련 환경 상태 선택 Reward Observation Space!We propose 테이블 기반 탐색 캐싱 메커니즘과 텍스트-코

8.Vision Transformer 해부 및 구현

- '25 아키텍처 스터디 1주차 paper link ICLR 2021 Abstract 해당 논문은 컴퓨터 비전 분야에서 Transforemr 구조를 효과적으로 활용하는 법을 제시하며 특히 대규모 데이터셋에서 사전 학습된 Vision Transforer(ViT) 모

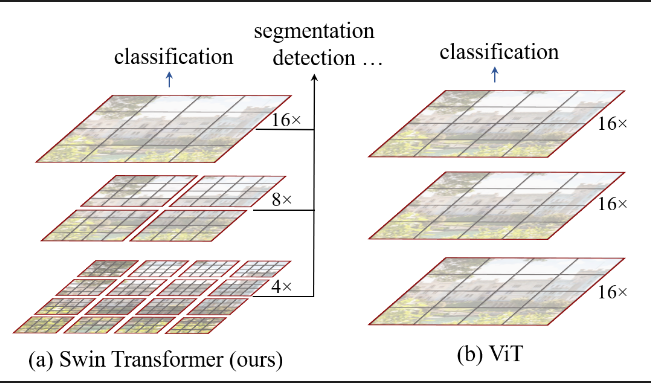

9.Swin Transformer - Hierarchical Vision Transformer using Shifted Windows(2021)

paper_link, github_codeA ConvNet for 2020 리뷰하려고 했는데 Swin Transformer 이야기가 자꾸 나와서 변경...컴퓨터 비전에서 범용적인 백본 역할을 수행할 수 있는 새로운 Vision Transformer인 Swin Trans

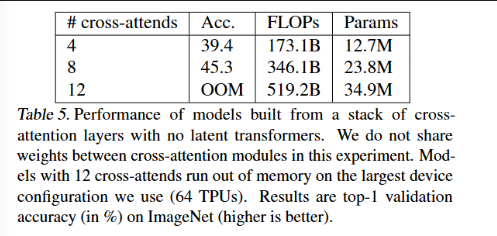

10.Perceiver - General Perception with Iterative Attention

!summary Abstract1\. 🤖 Perceiver는 Transformer를 기반으로 하며, 다양한 modality의 고차원 입력 처리를 위해 설계되었습니다.2\. ⚙️ 이 모델은 비대칭적인 attention 메커니즘을 사용하여 입력을 작은 latent bot

11.Flamingo 논문 리뷰하기

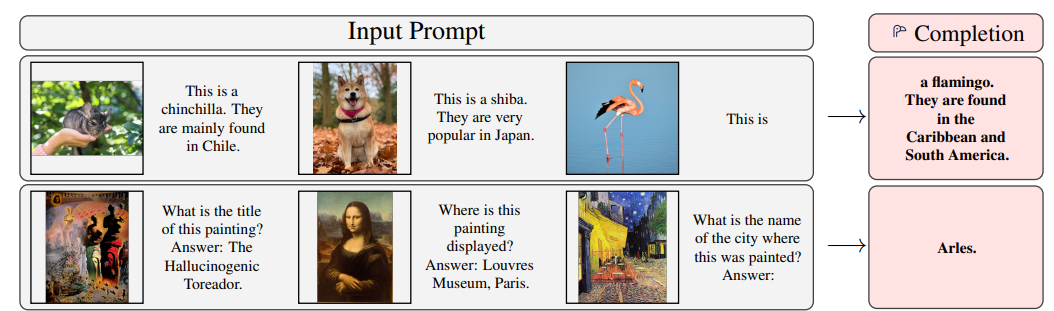

- 아키텍처 스터디 3주차 paper link 영어를 잘 해석하고 싶다는 생각이 들어서 좀 독특한 방식으로 리뷰함 CLIP은 zero-shot classification에서 뛰어난 성능을 보여주었지만, 여전히 한계가 있었다. 이러한 한계를 극복하고자 FLamingo는

12.CLIP 논문 리뷰하고 돌려보기

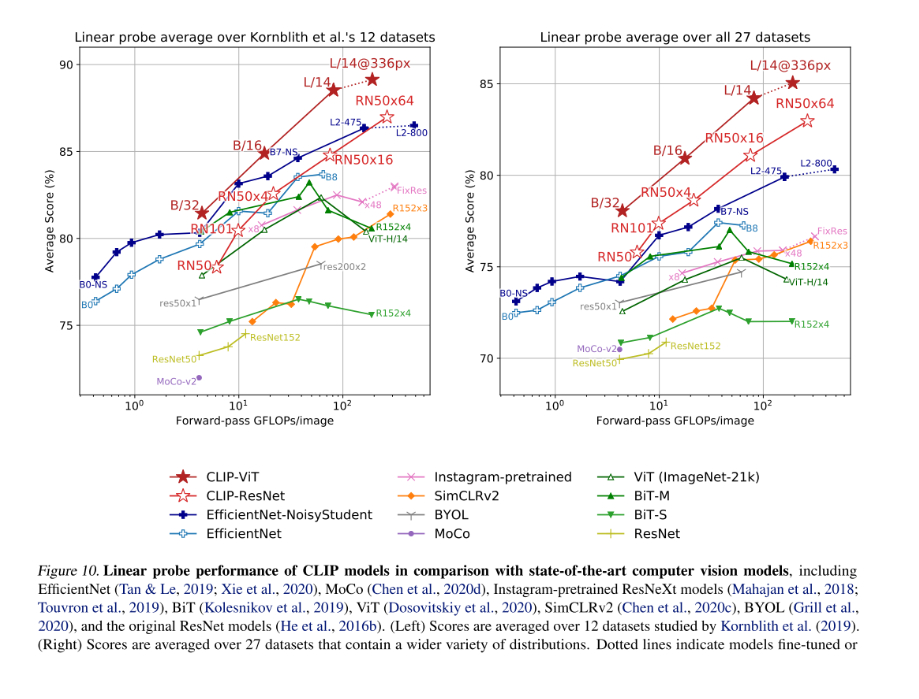

'25 아키텍처 스터디 2주차 이번에는 CLIP을 해부해보자~ LlaVA를 하려고 했는데 CLIP이 언급되길래 이것부터... paper link ICML 2021 Paper Abstract CV 시스템은 미리 결정된 객체 범주의 고정된 집합을 예측하도록 학습됨 이런

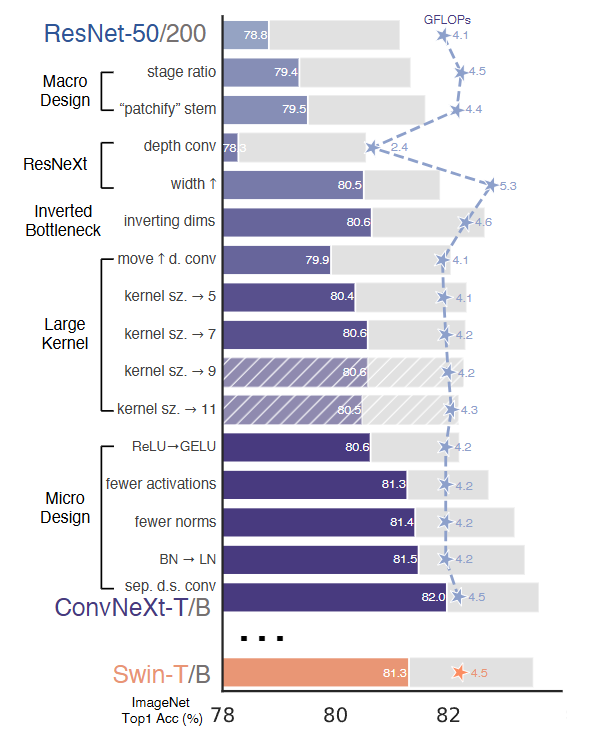

13.A ConvNet for the 2020s

CVPR 2022paper_linkConvNeXt는 Vision Transformer의 디자인 원리를 ResNet에 적용하여 현대화한 순수 ConvNet 모델A vanilla ViT, on the other hand, faces difficulties when app

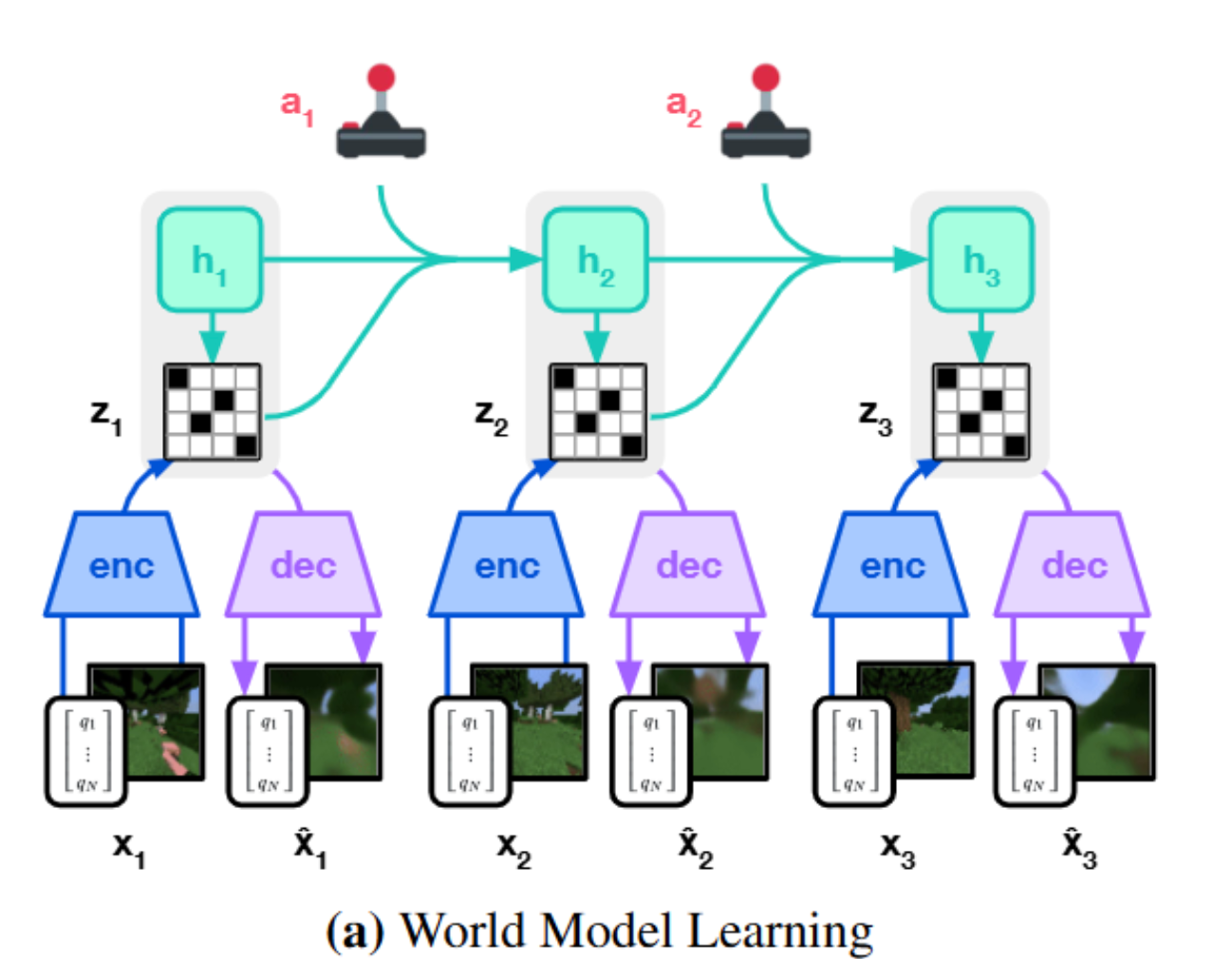

14.Mastering diverse control tasks through world models(NeurIPS 2025)

🍦왜 이걸 택했는가~일단 전통적인 RL에서는 구조가 단순했다. 그런데 Dreamer는 단순히 정책 네트워크만 사용하는 것이 아니라 "세상을 상상하는 뇌"를 만들고 이걸 기반으로 행동을 결정했다.... 는 점이 신기해서!ㅎㅎ 강화학습도 RNN이나 여타 아키텍처를 이용해

15.Decision Transformer - Reinforcement Learning via Sequence Modeling

NeurIPS 2021paper link본 논문은 강화학습(RL)을 시퀀스 모델링 문제로 추상화하는 프레임워크를 소개한다. 이를 통해 트렌스포머의 단순성과 확장성, 그릐고 GPT-x와 BERT와 같은 언어 모델링의 발전을 활용할 수 있다.이전의 RL이 value fun

16.[논문] ON DECODER-ONLY ARCHITECTURE FOR SPEECH-TO-TEXT AND LARGE LANGUAGE MODEL INTEGRATION

text-based model과 speech proceeing을 통합한 Speech-LLaMA 방법을 소개한다Speech-LLM 통합의 실용적인 요소들을 조사하였는데, 음향 특징의 압축이나 어탠션 마스크 선택, 파인튜닝 전략 등이다.Decoder-only 아키텍쳐가 E