Q1. 라쏘회귀와 L2 Normalization 의 형태가 같은데, 차이점이 있는지?

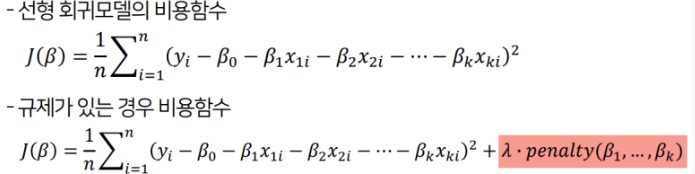

선형 회귀모델은 모델의 가중치를 제한하는 방법으로 Regularization 방법을 사용함

regularization 선형회귀모델은

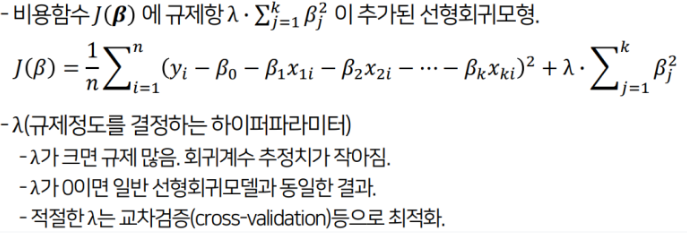

릿지회귀(Ridge Regression)

라쏘회귀(Lasso Regression)

릿지 회귀(Ridge Regression)와 L2 Regulation

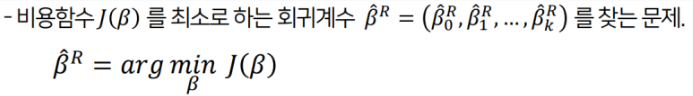

릿지회귀의 training

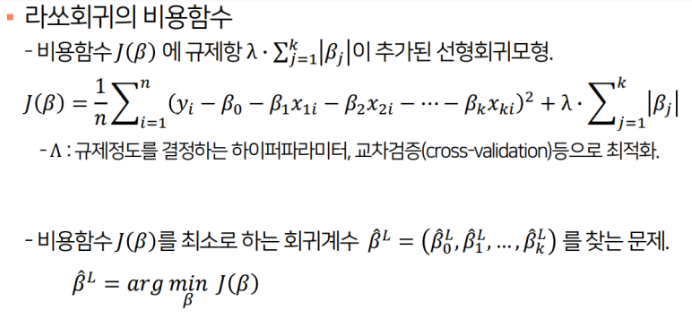

라쏘회귀(LASSO Regression)과 L1 Regulation

두 방식 모두 추정치는 일반선형회귀모델과 달리 편의가 발생하지만 분산은 더 작아지게 됨

-> 람다값에 따라 일반화오차가 더 작아질 수 있음

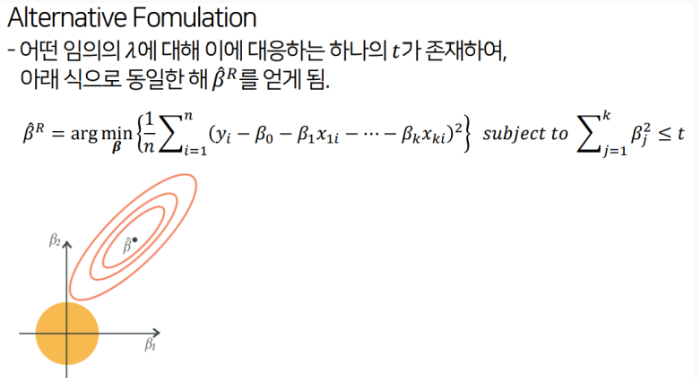

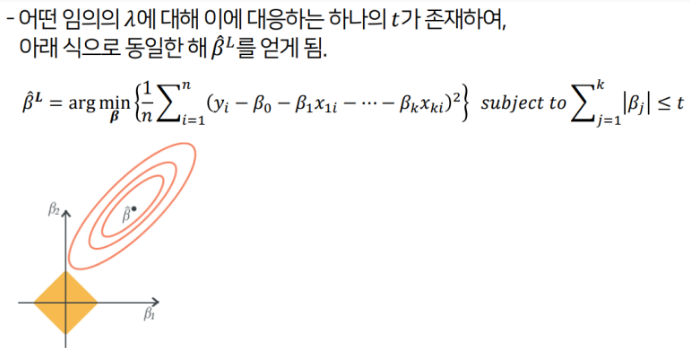

라쏘 회귀의 경우에는 제약 범위가 각진 형태임

-> 파라미터 일부가 0이 되는 경향이 있음(Sparce model)

릿지 회귀의 경우에는 제약 범위가 둥근 형태임

-> 파라미터가 0이 되지 않고 전반적으로 줄어드는 경향이 있음

Loss Function 식에 대해 릿지 회귀의 panelty term을 추가한 것이 L2 regularization임을 알 수 있었음

Q2. 이미지데이터 외에 Residual Block이 사용될 때 같은 kaiming initialliztion을 사용하는지?

Time series 데이터에서 Residual Block 사용한 Case 조사

-> initialization 할 때 Transfer learning 방법을 사용함을 확인함

모든 Residual Block이 kaiming initialization을 사용하지 않는 것으로 확인 (더 다양한 Case 서치 필요)