신입생 세미나

1.Lecture 10 : Training Neural Networks 정리

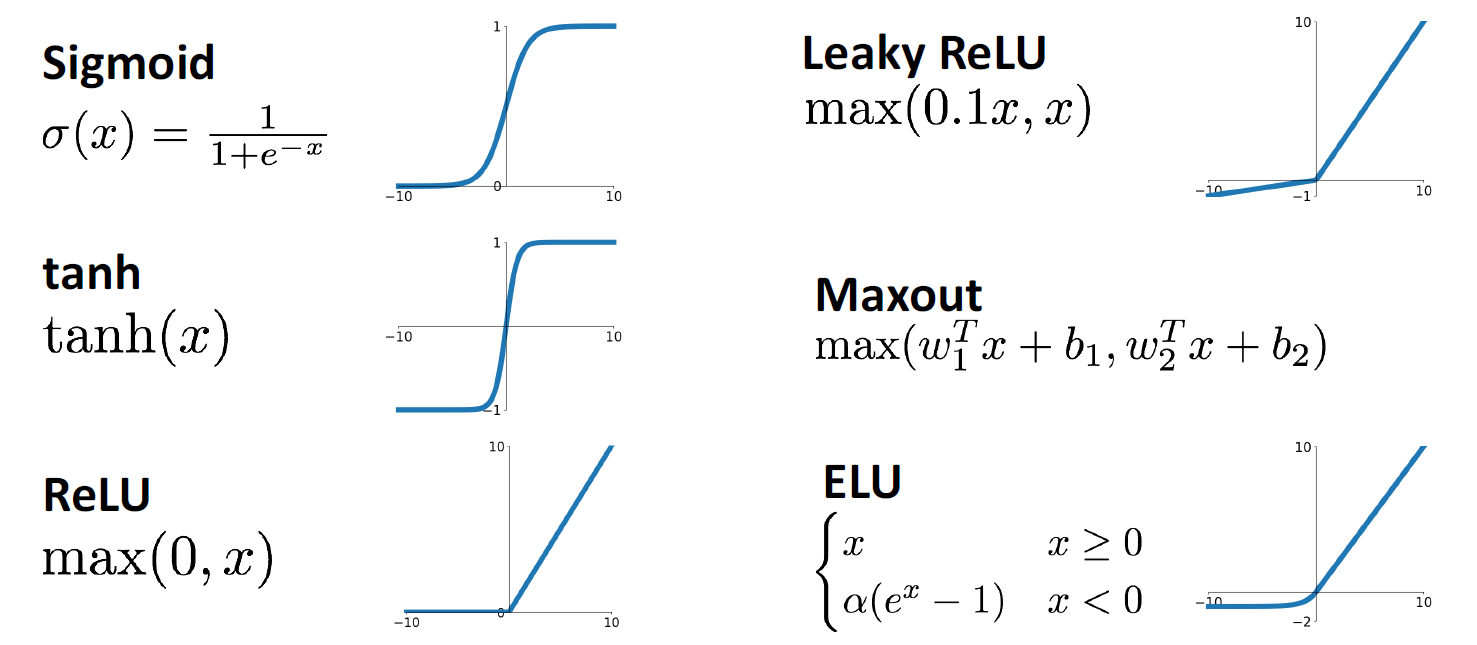

10장에서는 Neural Networks를 학습시키기 위해, 학습 이전에 필요한 설정들과 트레이닝을 진행하는 동안 필요한 것 알아봄6가지의 방법에 대해 장,단점을 살펴볼 예정전통적으로 사용해온 활성함수로서 0과 1을 확률로 output을 출력간단하게 nonlinear

2.Lecture 11: Training Neural Networks(Part 2)

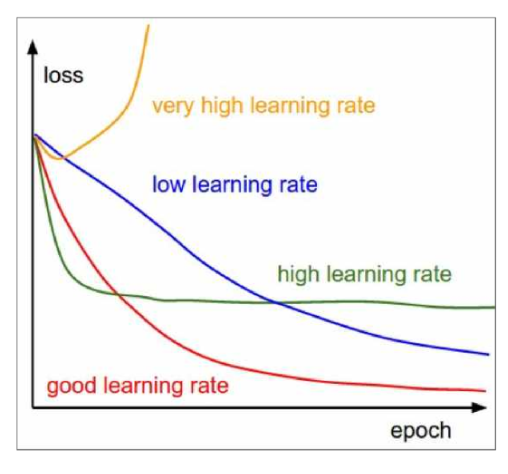

시간에 따라 learning rate를 변경시키는 것을 learning rate schdule이라고 함좋은 learning rate 는 큰 값에서 시작해서 epoch이 지나면서 learning rate를 decay 시키는 것일정 고정된 epoch에서 decay시켜주는

3.신입생 세미나 Lecture 10 발표 보충 자료

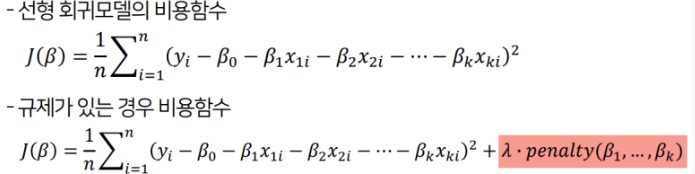

선형 회귀모델은 모델의 가중치를 제한하는 방법으로 Regularization 방법을 사용함regularization 선형회귀모델은릿지회귀(Ridge Regression)라쏘회귀(Lasso Regression)릿지 회귀(Ridge Regression)와 L2 Regula

4.Lecture 12 : Recurrent neural networks

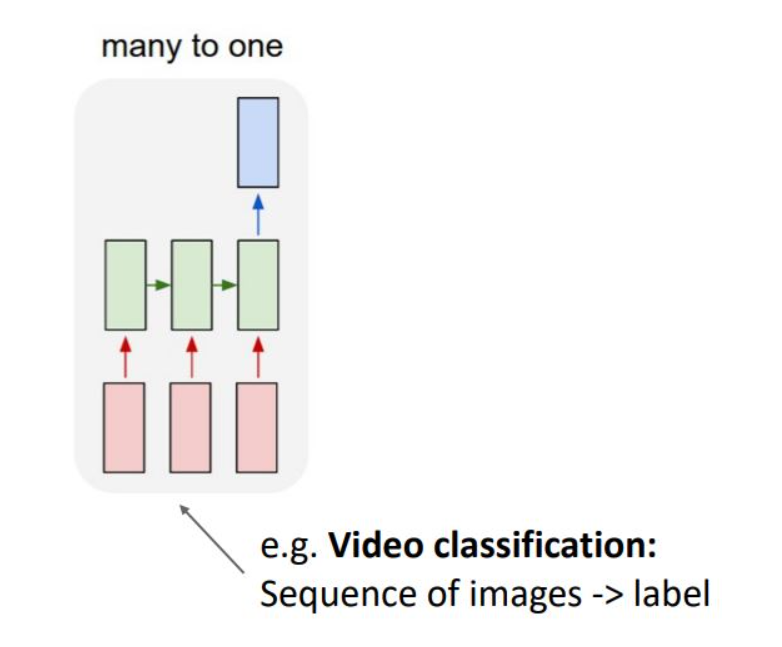

RNN 기본 구조 및 Vanilla RNN 수식, computational graph 다룸 RNN variants에 대한 구조도 알아볼 예정 Recurrent Neural Networks RNN은 언어 도메인에서 주로 사용 기존 CNN 혹은 Fully-Conne

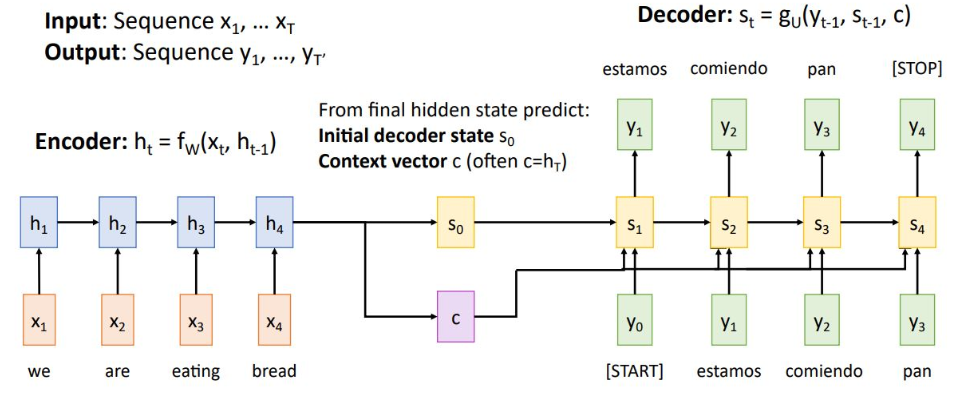

5.Lecture 13. Attention

Task 별 sequence data를 처리하는 attention 학습 예정context vector는 input sequence를 single vector로 요약하여 decoder에 전달함그러나 input이 sequence가 짧은 경우에는 잘 작동하지만, 한 권의 책

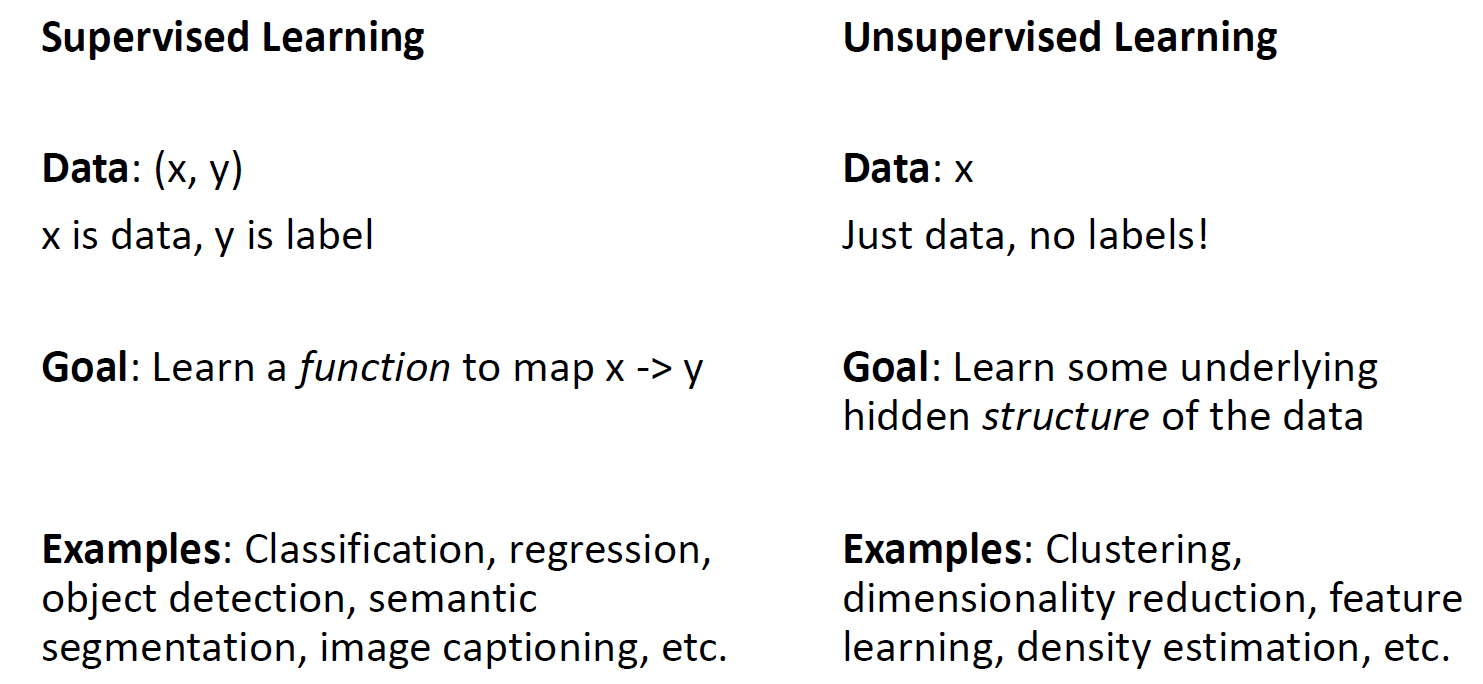

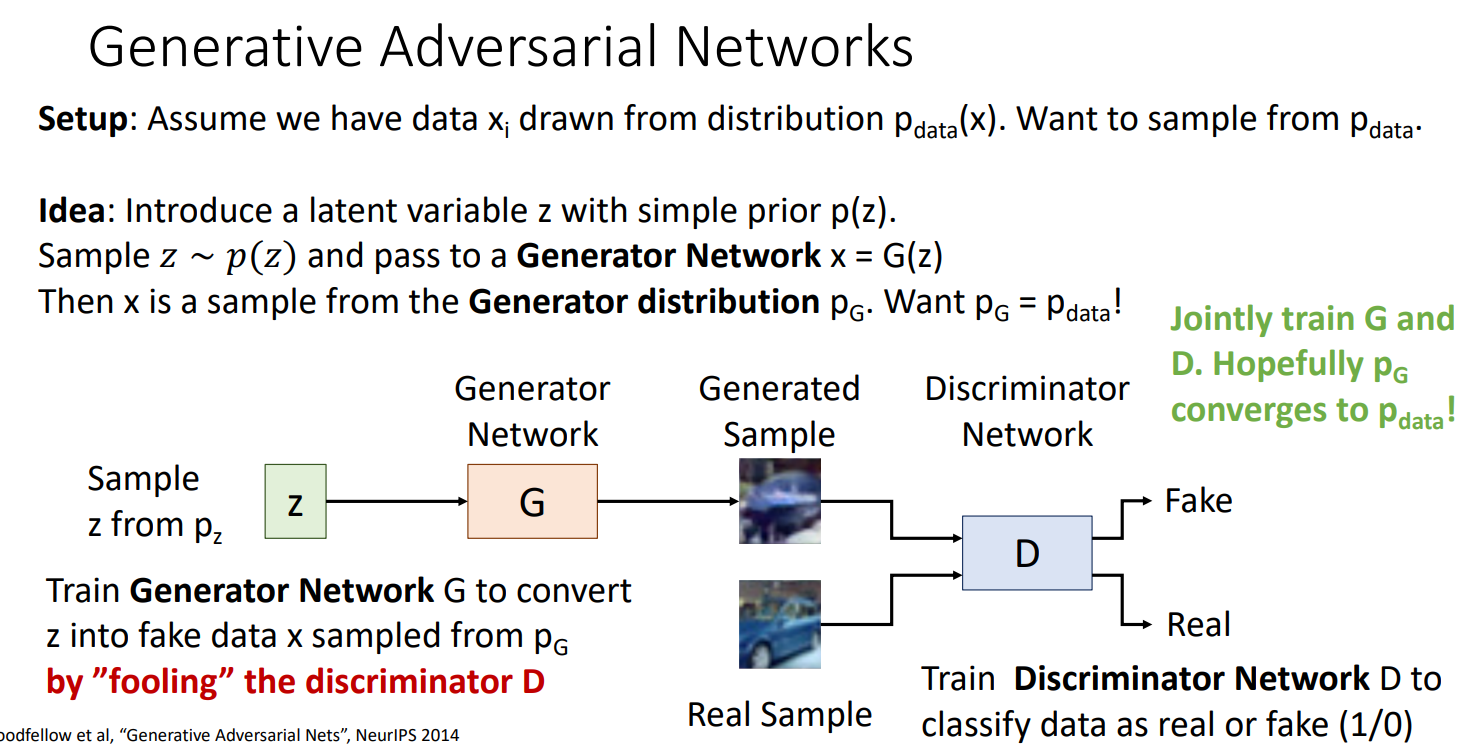

6.Generative Models, Part I

Supervised learning : Input X 를 Output Y로 mapping 찾는 것Unsupervised learning : Data annotation 이 필요 없으며 data의 hidden structer 을 찾는 것Clustering, PCA, Au

7.Generative Models, Part 2

Fully connected VAE MNIST data에 대해 fully connected VAE 모델 예시 z는 하이퍼 파라미터로 학습 이전에 세팅 해야 함 lower bound를 maximize 하기 위해 첫 번째로 training set에서 mini-batch