1. Text Classification

: Emotion classification

(1) 해결하고자 하는 문제가 무엇인가?

- 감정은 일상 생활의 중요한 부분입니다. 감정은 의사 결정, 지각, 인간 상호 작용 및 인간 지능에 영향을 미치기에 감성을 분석하는 것을 중요합니다.

- Emotion classification는 해당 text를 '중립적'이나 '감정이 없는것'으로 분류되거나 정신상태를 가장 잘 나타내는 몇가지 감정 중 하나 이상을 분류하는 작업합니다.

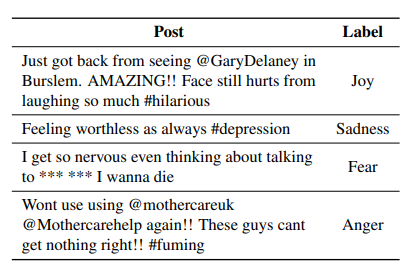

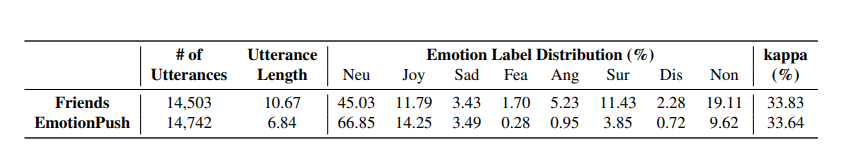

(2) 데이터: EmotionLines

- 텍스트 내용만을 기반으로 각 대화에서 모든 발언에 감정 레이블을 지정한 데이터

- 프렌즈 대본과 개인 페이스북 멘시저 대화에서 수집되었고, 2000개의 대화에서 총 29245개 발언이 레이블링되었습니다.

- labels (7): anger, disgust, fear, joy, sadness, surprise, neutral

- json형태, Post와 Label로 구분

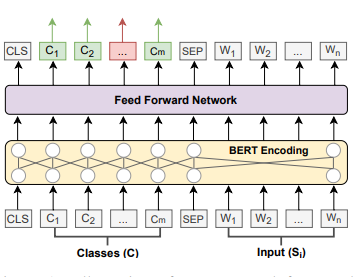

(3-1) SOTA 모델: SpanEmo

주요 키워드: Multi-label Emotion Classification, Span-prediction

- 기존에 감정이 공존한다는 점을 고려하지 않고 감정을 독립적으로 분류하여 여러 감정이 겹치는 잠재적 모호성을 간과하였습니다.

- ex) well my day started off great the mocha machine wasn’t working

==> anger, disgust, joy,sadness

- ex) well my day started off great the mocha machine wasn’t working

- 이런 문제를 해결하고자 다중 레이블 감정 분류하는 SpanEmo가 소개되었습니다.

- 모델이 입력 문장과 label set(즉, 감정 classes)를 모두 고려하여 출력으로 label set의 span을 선택하도록 훈련시키기 위해 "SpanEmo"를 도입

-

그림 설명

- 입력된 문장과 classes set

- 상황별 단어 representations을 학습하기 위해 기본 encoder를 사용하였습니다.

- 학습된 representations을 각 토큰에 대한 단일 점수로 투영하기 위해 feed forward network(FFN)를 사용하였습니다. (학습된 representations --> single score for token)

- 해당되는 감정 label에 대한 예측을 위해 label 토큰의 점수를 사용하였습니다.

- green box--> positive label, red box --> negative label

(3-2) SOTA 모델: Semi-supervision

주요 키워드: Label Semantics

- Semi-supervised learning은 레이블링된 데이터와 레이블링이 되지 않은 데이터 모두 사용하는데 Semi-supervision 또한 레이블링된 데이터와 레이블링이 되지 않은 데이터 사용합니다.

- label 임베딩을 통해 label class를 명시적으로 모델링하고, 훈련 및 추론 중에 label간의 상관 관계를 추적하는 메커니즘을 추가하였습니다.

- label이 지정되지 않은 데이터의 상관 관계에 대해 정규화합니다.

- Label Semantics using Embeddings: label 이름의 Semantics가 나타나는 임베딩으로 각각을 명시적으로 표현하는 것

- label 임베딩하는 법:

1.Label Attention Network

2.Labels as Additional Input

- label 임베딩하는 법:

- Label Semantics using Correlations: 한 사건에 의해 하나 이상의 감정이 유발될때, 독립적이지 않음

- 예) JOY와 SAD는 음의 상관관계 vs JOY와 TRUS는 양의 상관관계를 띔

- 레이블 상관 관계를 통합하는 방법:

- Correlations on Labeled Data

- Semi-supervision on Unlabeled Data

- Label Semantics using Embeddings: label 이름의 Semantics가 나타나는 임베딩으로 각각을 명시적으로 표현하는 것

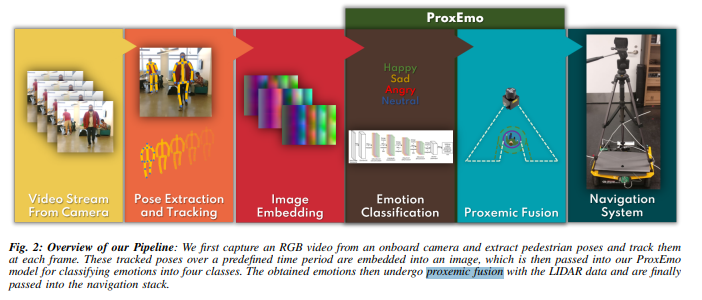

(cf) Emotion Classification의 VISON 적용

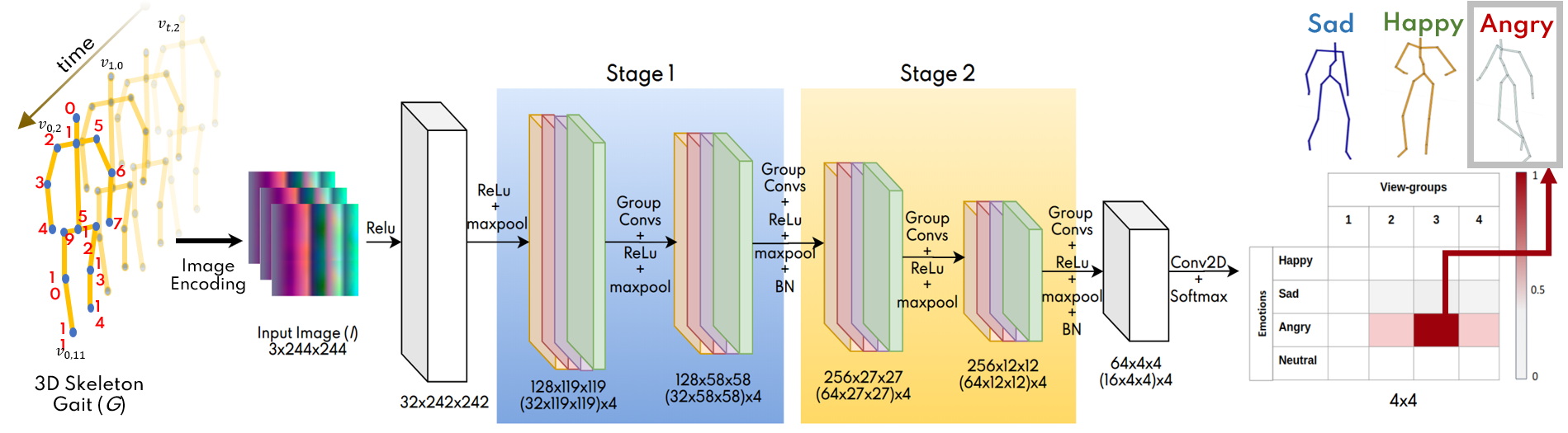

SOTA 모델: ProxEmo

주요 키워드: Proxemic Fusion, Socially-Aware Robot Navigation

- ProxEmo는 보행자들 사이에서 사회적으로 인식되는 로봇 네비게이션을 위한 새로운 종단 간 감정 예측 알고리즘입니다.

- 보행자의 걸음걸이에서 감지된 감정을 예측하며, 사회적 및 간접적 제약을 고려한 감정 유도 네비게이션에 사용하였습니다.

- pipline

- RGB 비디오에서 챕쳐하고 보행자의 자세를 추출하여 각 프로임을 추적한다.

- 추척된 포즈를 이미지에 내장하여 ProxEmo모델로 4개의 클래스로 분류

- 감정은 LIDAR data와 Proxemic Fusion 과정을 거쳐 네비게이션으로 전달됨

- Model Architecture

- 244x244까지 확장되는 5D 보행 세트 (G)의 이미지 임베딩을 훈련합니다

- 4개의 convolution 계층(GC)으로 구성되어 있습니다.

- 2-1. 각 GC layer는 4개로 쌓여있는 그룹으로 구성합니다.

--> 네개의 감정 라벨 각각에 대한 네개의 그룹 convolution 결과를 나타냅니다 - 2-2. 그룹 convolution은 1단계,2단계로 나뉩니다.

- 출력은 softmax층 통과후 4X4 크기를 갖고 최종 예측된 감정은 4X4축력의 최댓값에 주어진다

Architecture 출처

데이터: EmotionLines 설명 부분에 오타가 있습니다. joson 형태라고 오타가 있네요. 그리고 오늘 배우는 분야가 NLU분야인데 마지막에 ProxEmo 모델도 자연어 이해 분야로 보는게 맞나요? 컴퓨터 비전이라고 해석 될수도 있을 것 같습니다.