✏️ 딥러닝 학습방법

신경망(Neural Network)

- neural network는 선형 모델 + 비선형함수들의 결합 → 비선형모델

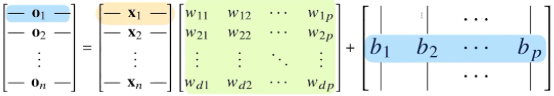

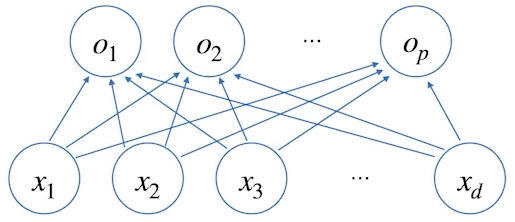

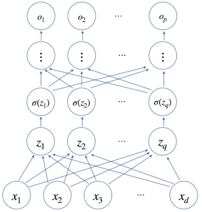

- 위 수식을 도식화하면 아래와 같다.

- 화살표의 역할 : W(가중치)

- d개의 변수로 p개의 선형모델을 만들어서 p개의 잠재변수를 설명하는 모델

소프트맥스(softmax)

- 모델의 출력을 확률로 해석할 수 있게 변환해 주는 연산함수 (분류 문제 모델에 쓰인다.)

- 주어진 데이터가 어떤 특정 클래스에 속할 확률을 구할 수 있기에 분류 문제에 적합

- 분류 문제를 풀 때 선형모델과 소프트맥스 함수를 결합하여 예측

- 딥러닝 학습을 할 경우 소프트맥스를 쓰지만, 추론할 경우 one-hot vector를 사용

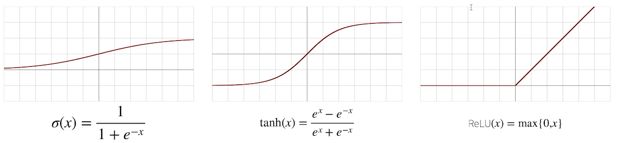

활성함수(activation function)

- 신경망은 선형모델과 활성함수를 합성한 함수

,

- 선형모델 or 행렬곱 사용하지 않고, 선형 모델로 나오는 출력물 각각의 원소에 적용되는 비선형 함수

- 활성함수를 쓰지 않으면 딥러닝은 선형모형과 차이가 없다.

활성함수 종류

- ReLU함수가 딥러닝에선 많이 쓰인다. (전형적인 비선형 함수이다!)

다층 퍼셉트론(Multi-layer Perceptron)

- 신경망이 여러층 합성된 함수 (perceptron ≈ neural network)

- more than two-layer NN → 선형모델과 활성함수를 반복적으로 사용하는 것이 오늘날의 일반적인 딥러닝 모델의 모습

- 층을 여러개 쌓는 이유 : 층이 깊을수록 목적함수를 근사하는데 필요한 뉴런(노드)의 숫자가 훨씬 빨리 줄어들어 좀 더 효율적으로 학습이 가능

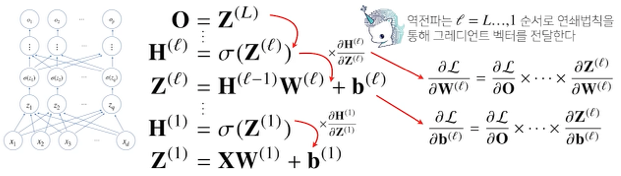

역전파(Backpropagation) 알고리즘

- 각 층 별로 gradient vector를 역순으로, 순차적으로 보내준다. (위층에서 아래로)

- 합성함수 미분법인 연쇄법칙(chain-rule) 기반 자동미분(auto-differentiation)을 사용