Naver Boostcamp AI Tech 2기

1.[1주차] 8.2 월

✏️벡터 벡터(Vector)란? 공간에서의 한 점 - 1차원(수직선)에선 scalar, 2차원(좌표평면)에선 (x,y)축의 point 원점으로부터의 상대적 위치 벡터에 숫자를 곱하면 길이만 변한다. 두 벡터의 덧셈은 상대적 위치이동을 표현 뺄셈은 방향을 뒤집은 덧셈이다. 벡터의 norm이란? 원점에서부터의 거리 임의의 차원 d에 대해 성립 L1-norm...

2.[1주차] 8.3 화

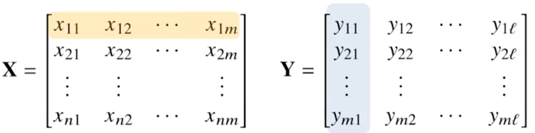

neural network는 선형 모델 + 비선형함수들의 결합 → 비선형모델$$O{(n, p)} = X{(n,d)}W{(d,p)}+b{(n,p)}$$위 수식을 도식화하면 아래와 같다.화살표의 역할 : W(가중치)d개의 변수로 p개의 선형모델을 만들어서 p개의 잠재변수를

3.[1주차] 8.4 수

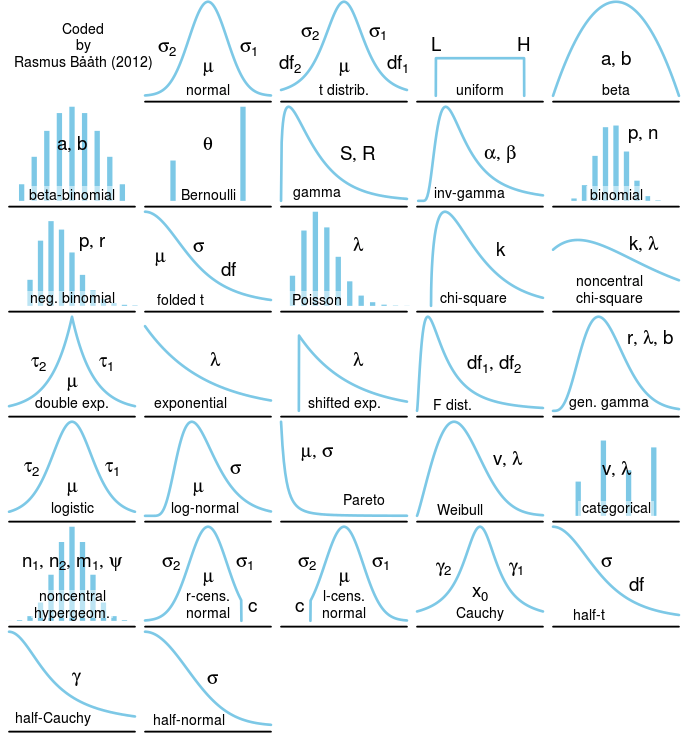

통계적 모델링은 적절한 가정 위에서 확률분포를 추정(inference)하는 것이 목표(출처 : https://priorprobability.com/2016/09/18/taxonomy-of-univariate-distributions/)유한한 개수의 데이터만 관

4.[1주차] 8.5 목

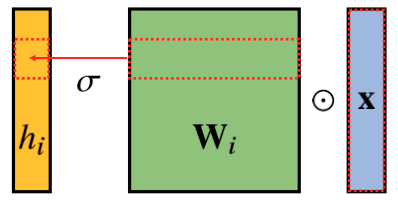

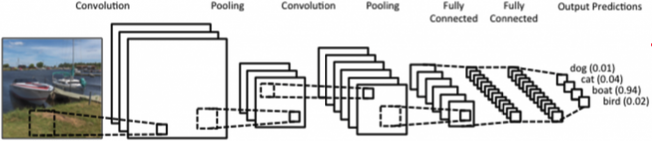

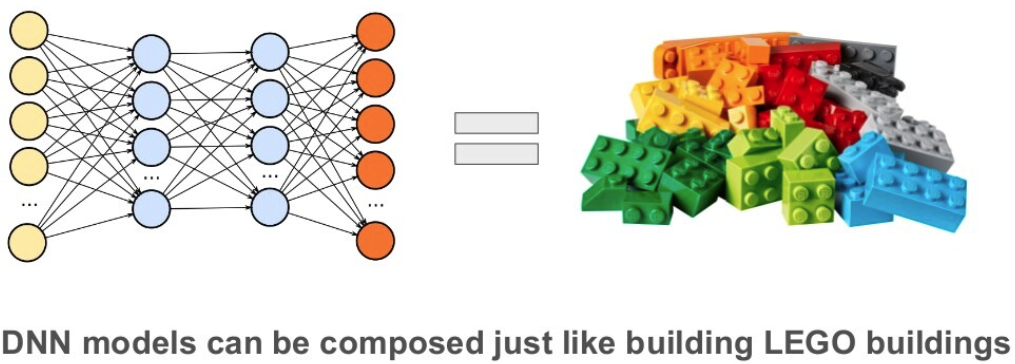

다층신경망(MLP)는 각 뉴런들이 선형모델과 활성함수로 fully connected된 구조이다.i, 즉 dimension이 늘어날수록 가중치 행렬의 사이즈가 커지고, 학습시킬 파라미터 수가 급격히 증가하여 모델 학습에 무리를 준다.MLP와 달리 커널(kernel)을 입

5.[1주차] 8.6 금

오늘은 목요일까지 배웠던 AI Math 복습을 진행하였고, 선택과제를 시작하였다.과제 수행 과정 / 결과물 정리:필수과제 1~5까지 완료 후 제출하였고, 피어 세션에서 팀원들끼리 각자 돌아가면서 본인 코드 리뷰 발표를 진행하고 피드백을 받는 시간을 가졌다. 선택과제는

6.[2주차] 8.9 월

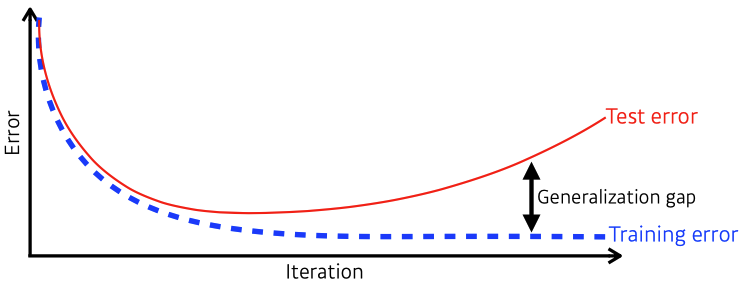

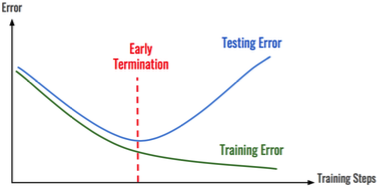

DataModelLoss FunctionLoss Function이 감소한다 해서 원하는 값을 항상 이룬다는 보장은 없다.→ 예컨데, linear regression 문제에서 data에 noise가 많이 껴있을 때, MSE의 제곱항은 outlier에 큰 영향을 받게 되어

7.[2주차] 8.10 화

✏️

8.[2주차] 8.11 수

✏️Convolutional Neural Networks(CNN) Convolution

9.[2주차] 8.12 목

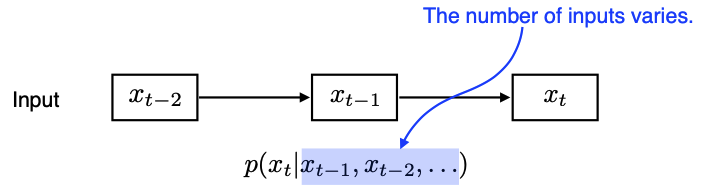

RNN

10.[2주차] 8.13 금

월 :화 :수 :목 :필수 과제 : 완료 및 제출선택 과제 : 진행 중지난 주와 비슷하게 그 날 공부한 강의를 그 날의 모더레이터가 리뷰하였고, 그 외 질문이 있다면 공유하고 서로의 의견을 말해주는 시간을 가졌다.또한 지난 주 임성빈 교수님의 마스터 클래스에서 추천 받

11.[3주차] 8.17 화

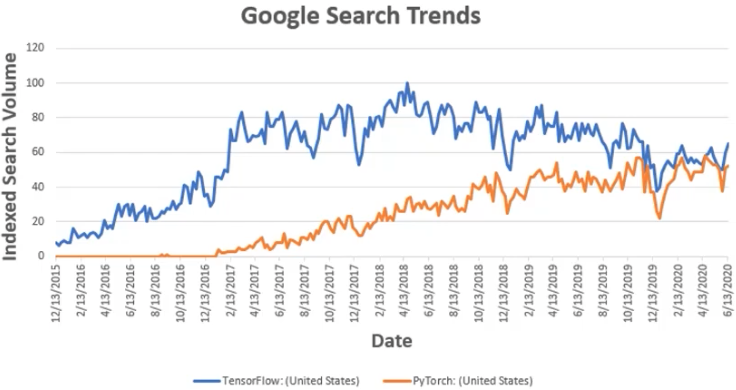

TensorFlowStatic graphs (Define and Run)그래프를 먼저 정의 → 실행시점에 data feedProduction, Cloud, Multi-GPU 등 scalability에 강점을 가짐PyTorchDynamic computation graph

12.[3주차] 8.18 수

✏️AutoGrad & Optimizer

13.[3주차] 8.19 목

Transfer Learning : 다른 데이터셋으로 만든 모델을 현재 데이터에 적용\-> backbone model(학습된 모델 = pretrained model)을 가져와서 우리 target에 맞춘 fine tuning을 진행하는 것이 현재 DL에서 가장 일반적인

14.[3주차] 8.20 금

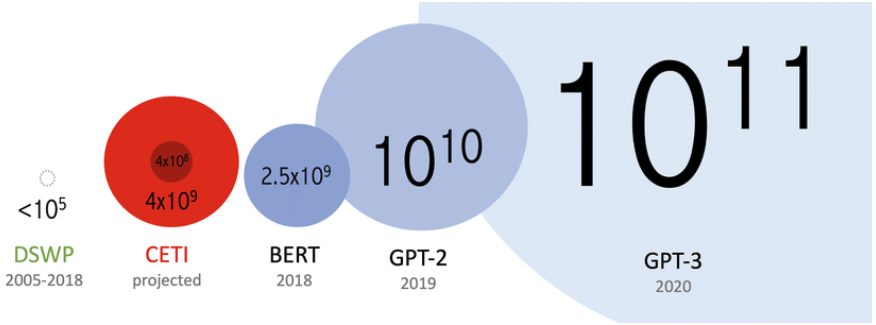

오늘날의 딥러닝은 엄청난 데이터와의 싸움최근 많아진 데이터로 인해 많은 GPU로 학습하는 것이 일상화가 된 시대에 도래했다.개념정리Single vs. Multi\-> 1개 vs. 2개 이상GPU vs. Node\-> GPU vs. System(computer with

15.[4주차] 8.23 월

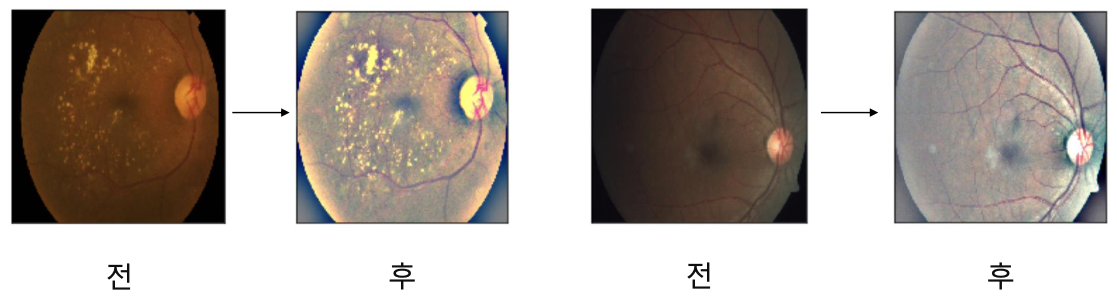

Data와 어떻게 친해질까? 생각해보자.탐색적 데이터 분석목적에 맞게 데이터를 이해하기 위한 노력각 task가 주제, domain, input, output이 모두 다르기 때문에 더욱 더 데이터를 이해해야 한다.주어진 데이터에 대한 본인의 생각을 자유롭게 서술하는 것쉽

16.[4주차] 8.24 화

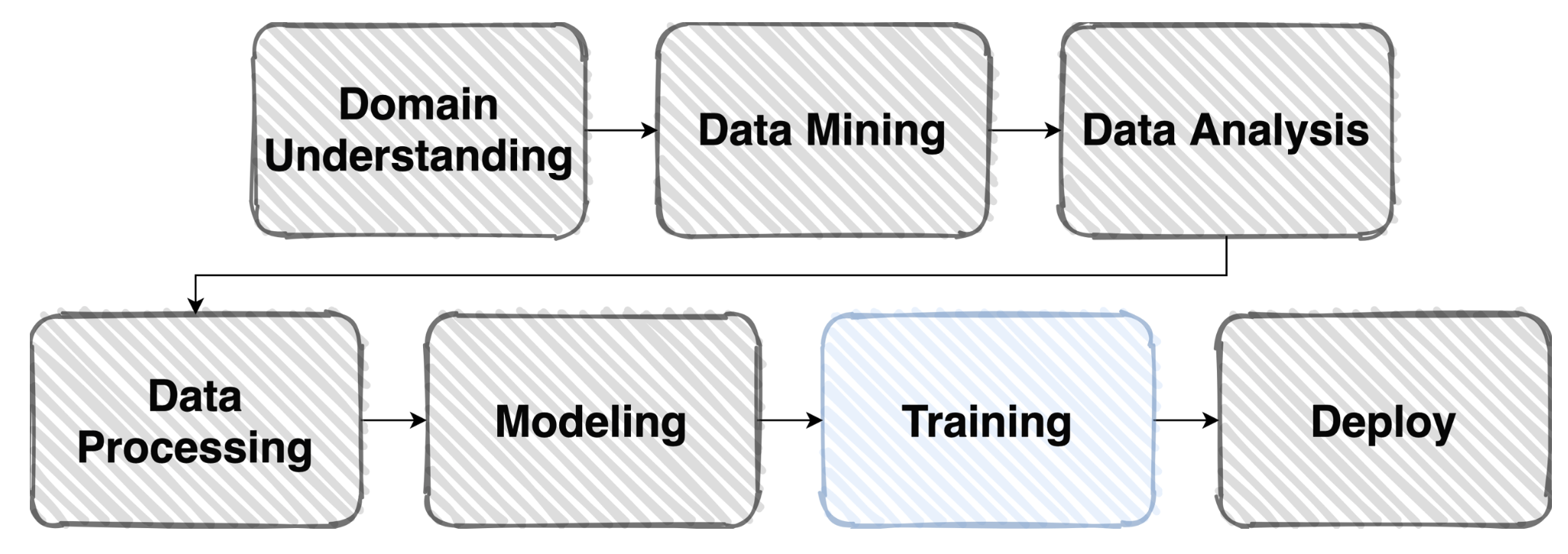

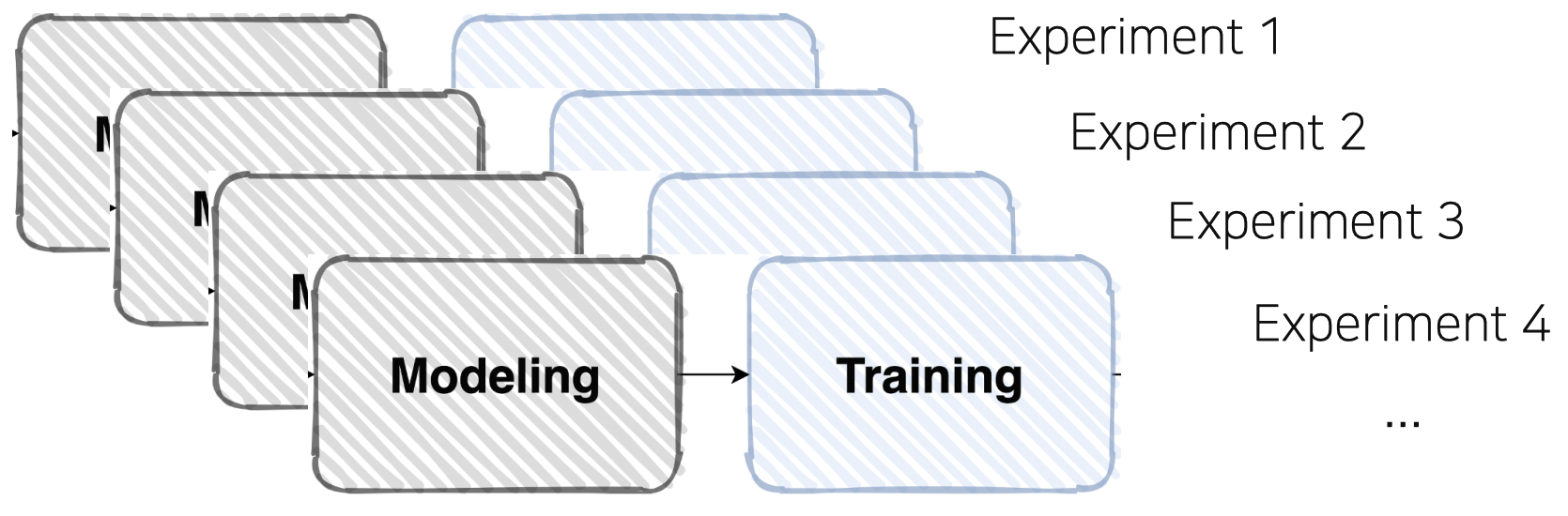

Vanilla dataset에서, 모델에 맞는 dataset으로 변환이 필요중요한 작업 - 80% pre-processing, 20% modeling, etc..\-> ML pipeline에 있어 큰 비중을 차지한다.Real data는 매우 raw하다. - outlie

17.[4주차] 8.25 수

📕(강의) - Model a model is an informative representation of a system. Pytorch 특징 : Low-level, Pythonic, Flexibility

18.[4주차] 8.26 목

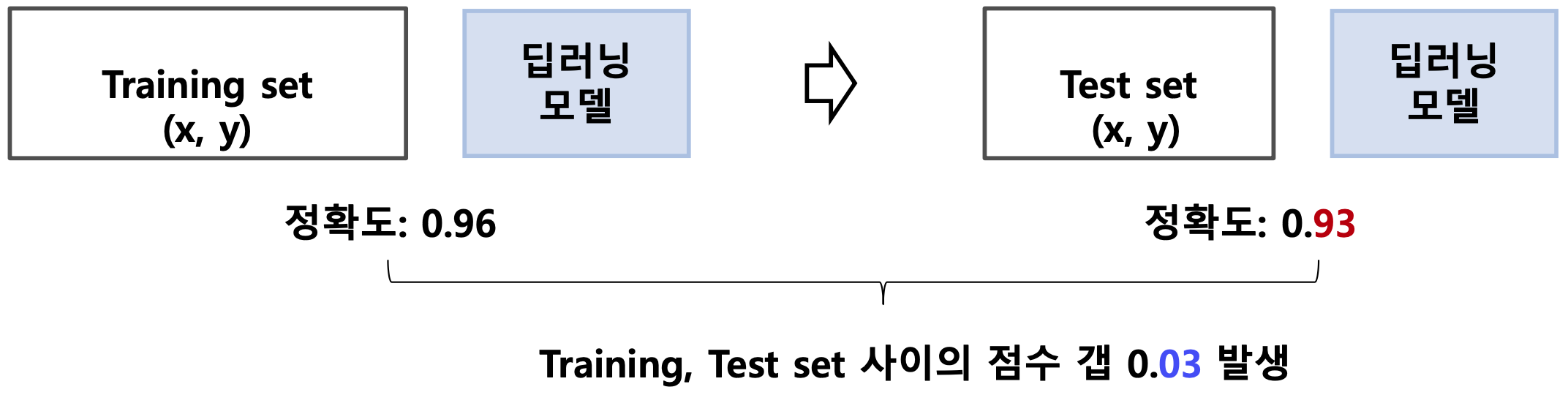

📕(강의) Training & Inference - Loss, Optimizer, Metric Loss Error Backpropagation Loss = Cost = Error function Pytorch에서 loss.backward()를 통해 모델의 파라미터

19.[4주차] 8.27 금

.

20.[5주차] 대회

.

21.[6주차] 9.6 월

22.[6주차] 9.7 화

.

23.[6주차] 9.8 수

.

24.[6주차] 9.9 목

.

25.[6주차] 9.10 금

.

26.[7주차] 9.13 월

.

27.[7주차] 9.14 화

.

28.[7주차] 9.15 수

.

29.[7주차] 9.16 목

.

30.[7주차] 9.17 금

.

31.[8주차] 9.23 목 - 특강

2010년 설립된 세계에서 가장 유명한 인공지능 대회 플랫폼2017년 3월 google이 인수kaggler!카카오 아레나 : 비공개 플랫폼 (카카오 계열사 전용?), 2018년 11월에 처음 대회 시작, 3개의 대회를 진행데이콘 : 타 기업/기관에게 공개된 플랫폼, 총

32.[8주차] 9.24 금 - 특강

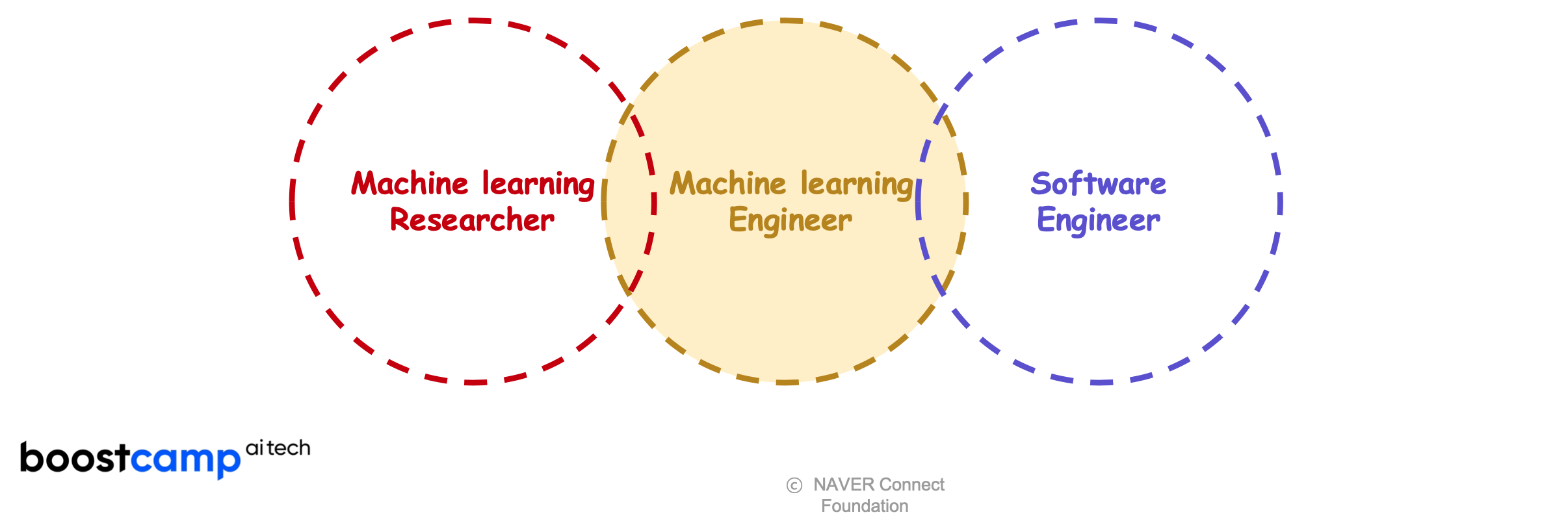

DL research를 이해하고 + ML product로 만들 수 있는 engineerFull stack ML service (back-end level)Full stack ML Edge device service (front-end level)Data collecti