GPT-1

Open AI에서 개발한 모델로 다양한 자연어처리 task를 처리할 수 있는 통합된 모델이 중요한 특징이다.

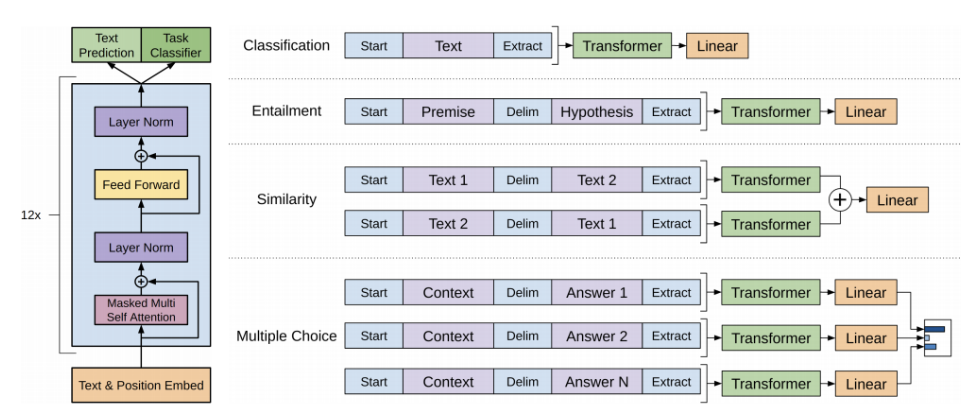

모델 구조와 학습 방식

- 우선 Text를 position 임베딩을 더한다.

- self-attention 블럭을 12개 쌓는다.

- Text Prediction : 첫 단어부터 다음 단어까지 순차적으로 예측하는 모델이다.

- 동시에 모델의 큰 변형없이 classification도 수행하기 위해 Text Classifier에 Extract 벡터를 최종 output layer에 전달하도록 한다.

- Classification이 외에 Entailment, Similarity, Multiple Choice와 같이 다른 task에도 사용가능하다.

다른 task의 transfer learning에 활용하고 싶다면

- output layer인 Linear를 떼어낸다.

- Transformer output인 워드별 인코딩 벡터를 이용하여 추가적인 하나의 레이터를 더 붙인 후 전체 레이어를 학습한다.

- 마지막 레이어는 random initialization이 되는 반면에 이전 레이어들은 학습이 되어있기 때문에 이전 레이어들은 많이 변하지 않으면서 마지막 레이어는 충분히 학습이 되도록 training한다.

다음 단어 예측하는 방향으로 학습된 모델을 문서분류에 활용하기에는 서로 다르다.

이러한 차이를 대규모 데이터를 가지고 self-supervised learning을 하여 이를 활용하는 방향으로 처리한다.

해당 task만을 위해 customized된 정확도 보다 더 높은 성능을 보여주는 것을 확인할 수 있다.

팀원들끼리 다음 논문 발표을 GPT로 정했기 때문에 간단하게 알아간다는 느낌으로 정리해보았다!