[NLP] Natural Language Processing

1.[NLP] Sequence-to-Sequence, seq2seq 모델

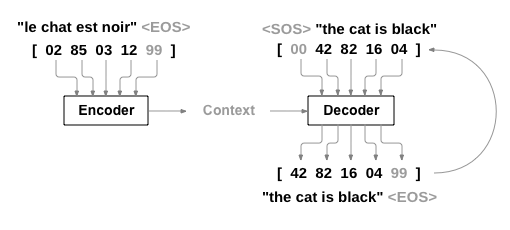

Sequence-to-Sequence(seq2Seq) 은 입력된 시퀀스(Input Sequence)로부터 다른 도메인의 시퀀스(Output Sequence)를 출력하는 모델입니다. NLP, Chatbot, Machine Translation이 대표적인 예입니다. Inp

2.[NLP] Sequence-to-Sequence를 사용해서 번역기 만들기

이번 포스팅에서는 NN을 통해 프랑스어를 영어로 번역하는 번역기를 Sequence to Sequence 네트워크를 활용해서 만들어보겠습니다. 해당 내용은 PyTorch를 참조해서 만들었습니다. 시작전, Seq2Seq 구조를 다시 한번 살펴보고 진행해보겠습니다.train

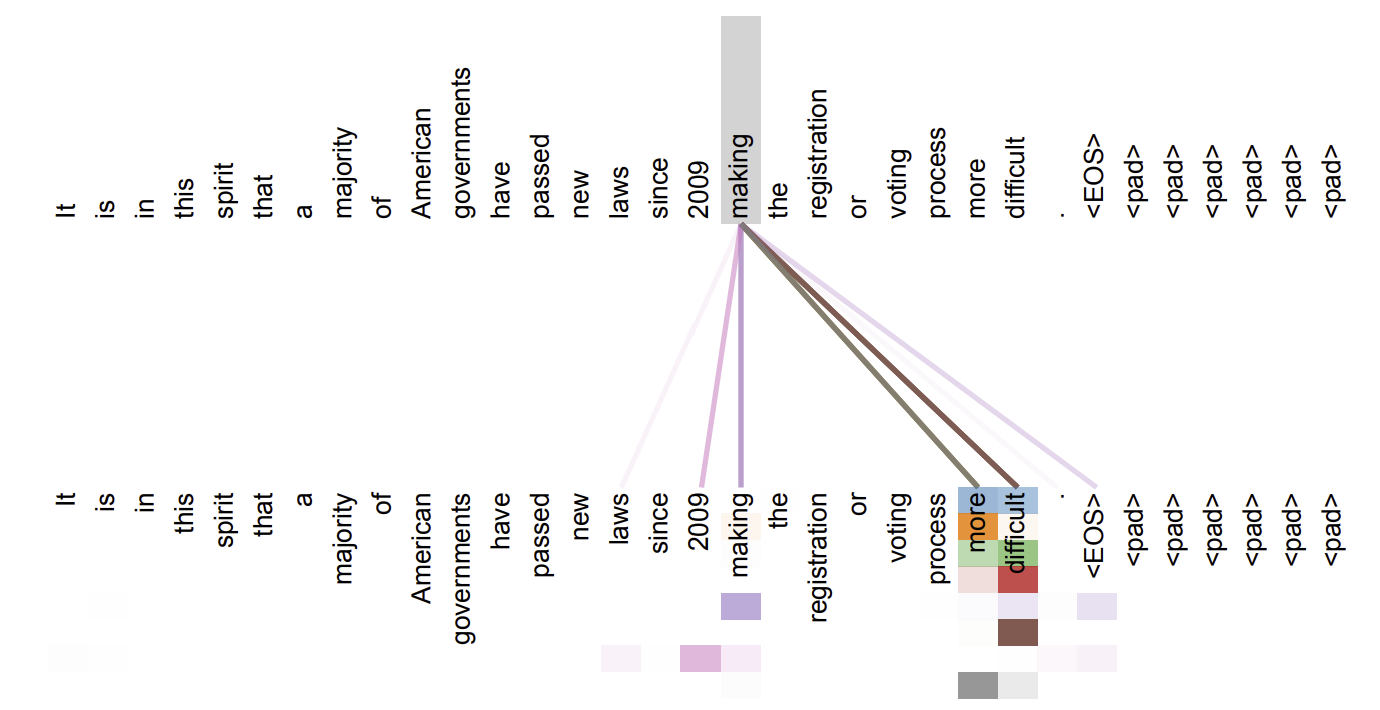

3.[NLP] Attention Mechanism

NLP 분야 중, 기계번역에서는 Encoder-Decoder 방식의 번역 알고리즘이 대부분 사용되었습니다. 이는 입력값을 encoder로 고정된 일정 크기의 context vector로 압축 시키고, decoder를 통해 원하는 출력 값을 산출하는 방식이였습니다. 하지

4.[NLP] Data Preprocessing

Model을 훈련하려면 dataset를 모델에 맞는 입력 형식(Tensor)으로 전처리 해야합니다. 우리의 데이터가 텍스트, 이미지, 오디오이던 간에, 모든 데이터는 Tensor batch 형태로 변환되어야 합니다.HuggingFace의 Transformers는 데이터

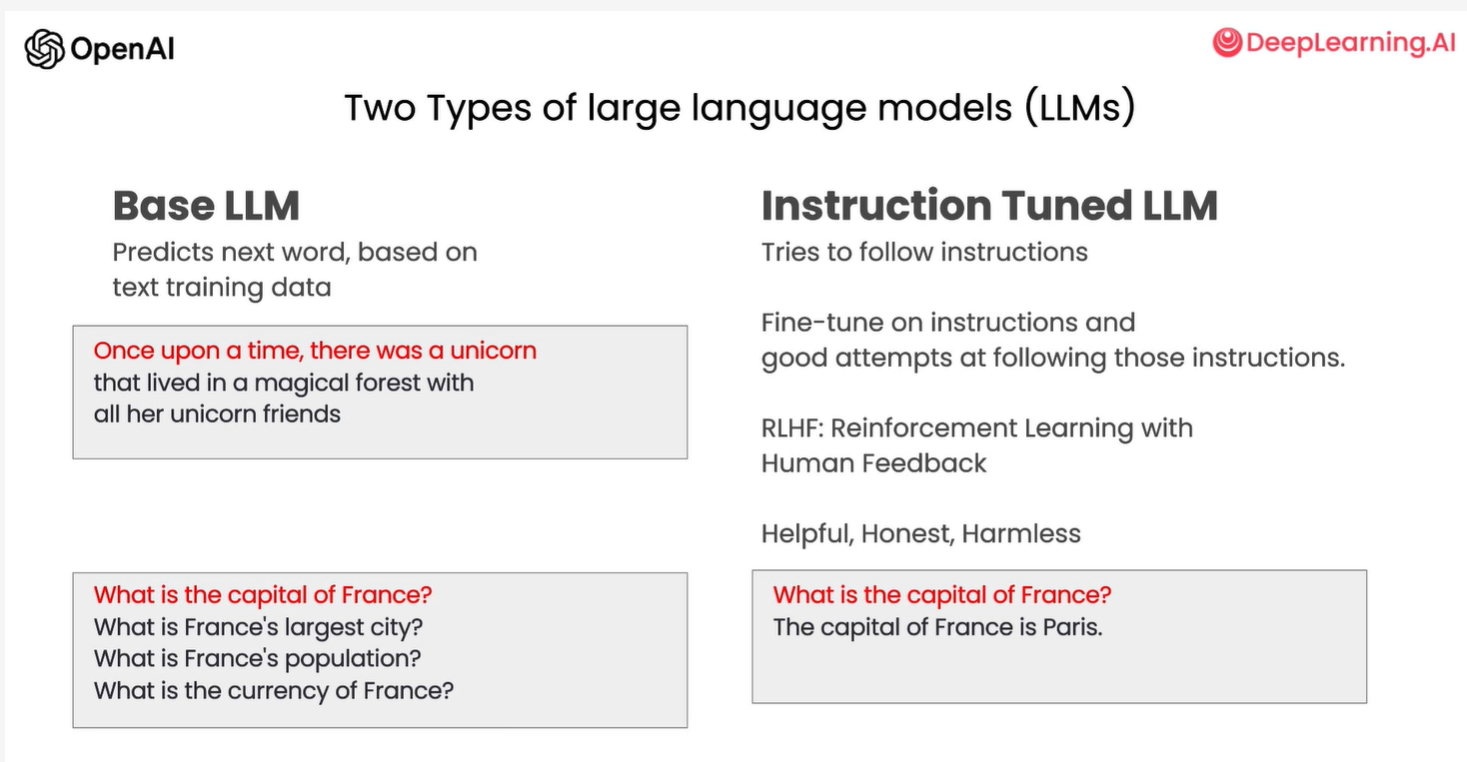

5.[NLP] Prompt Engineering

ChatGPT가 큰 인기를 끌게 되면서, AI를 모르는 대중들에게도 AI의 용어들이 점차 소개되고 있습니다.AI의 가장 큰 트렌드는 바로 LLM (Large Language Model)입니다. 현재, LLM에 대한 연구가 활발하게 진행되고 있으며, 가장 크게 두곽을 나