DL Workstation 구축과 DL 환경 구성 그리고 고민의 흔적

1.Deep Learning Workstation을 직접 구축하게 된 이유

클라우드 시대에 왜 나는 집안에 DL server(workstation)을 직접 구성하고 운영하게 되었을까 내가 주로 computing resource를 사용하는 목적은 다음과 같다. Data ingestion and processing (ETL, Preprocess

2.DL workstation 구축에 대한 고민, 조립 방법

deep learning workstation 구축 고민흔적, 그리고 조립 방법

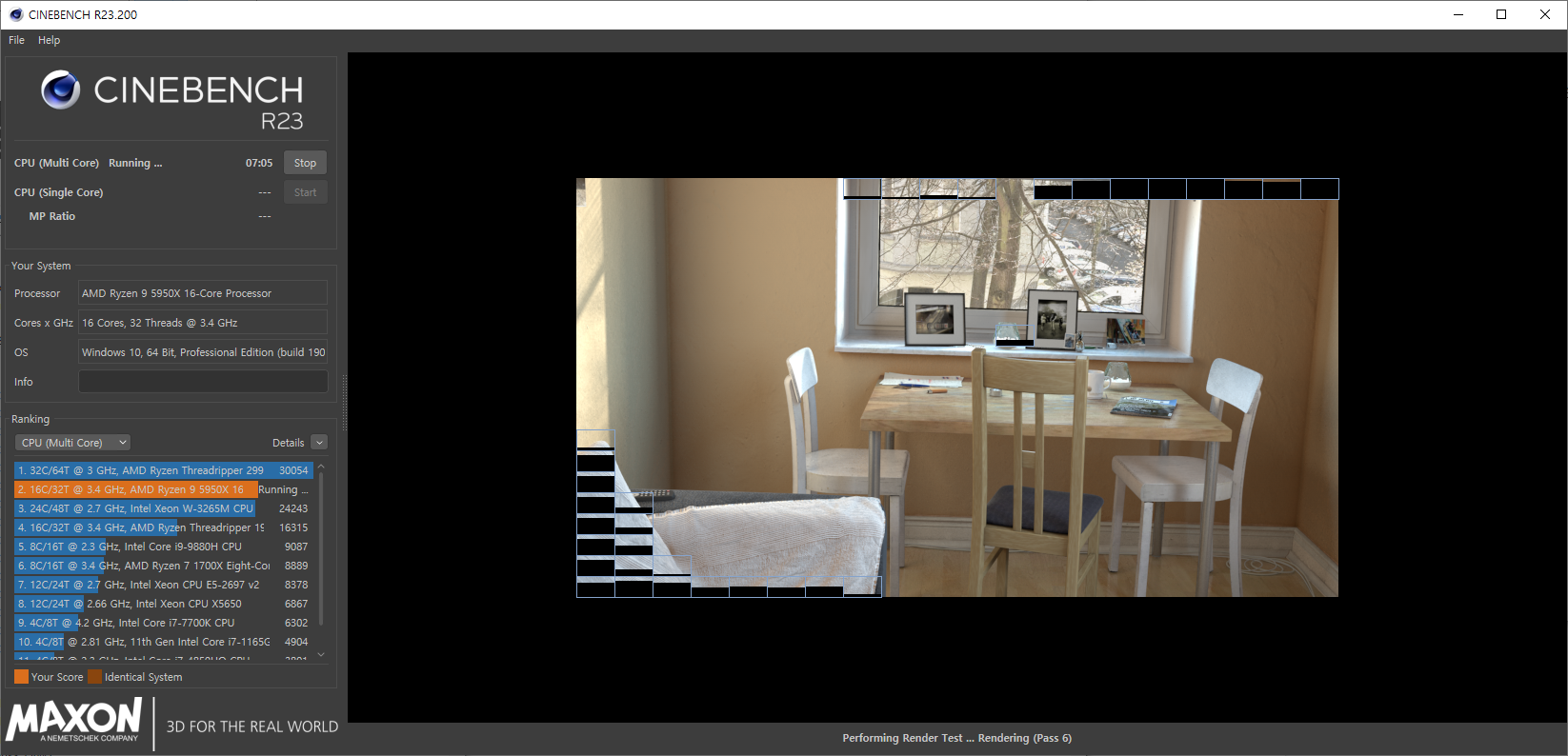

3.DeepLearning Workstation Benchmark (CPU, GPU benchmark)

DL Workstation을 구축하였으니 예상하는 수준의 성능으로 동작을 하는지 다양한 벤치마크를 통해 확인을 해보려고 한다. 꼭 직접 HW를 직접 구축하지 않았더라도 클라우드 환경에서 인스턴스를 사용할때 역시도 원하는 목적에 적합한 성능을 낼 수 있는지 또는 한계 성

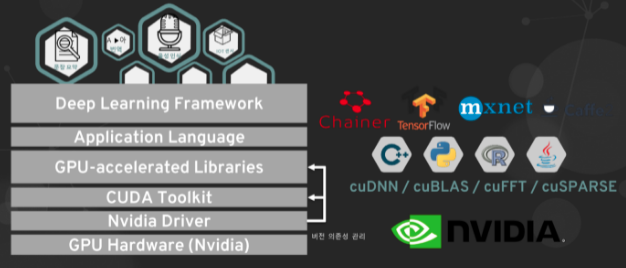

4.DL 환경 설정 - Nvidia driver / CUDA toolkit / cuDNN 설치

ubuntu package upgrade ubuntu에서 다양한 driver를 설치 해야 하지만 그중 ML/DL을 위해 중요한 드라이버는 nvidia driver를 설치 하는 일이다.드라이버 설치총 3가지 방법으로 설치 가능 하다.자동 설치선택 설치수동 설치Deep

5.Anaconda 설치 (on Ubuntu 20.04 LTS)

대상 환경Ubuntu 20.04 LTSAnaconda 사용자: 멀티 유저 고려Base Python version: 3.8 (TF2.2까지 cover)멀티 유저를 고려하여 Anaconda 설치를 진행한다.Anaconda old package listshttps:

6.JupyterHub 설치 및 관리(on Anaconda, ubuntu)

기준 환경Ubuntu 20.04 LTSAnaconda3 (multi-users)구축된 워크스테이션에 멀티 유저가 접속하여 사용하게 되는 만큼 사용자 그룹에 노트북의 기능을 제공하기 위해 jupyterHub를 설치하고 서비스 한다. jupyterhub를 설치하고 운여하는

7.Tensorflow, Pytorch 환경 구성 (Conda Env)

Anaconda 환경에서 tensorflow, pytorch 환경 구성하기. conda env

8.R studio server 설치

R studio server 설치 및 셋업

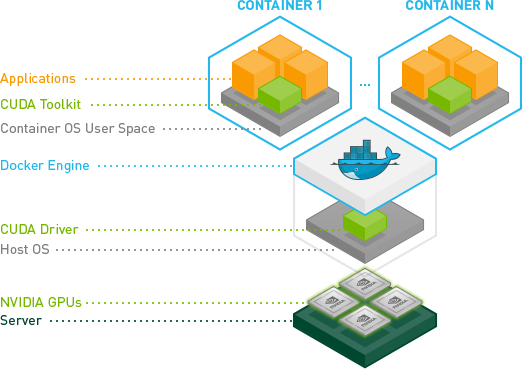

9.Nvidia-docker 설치 및 설정 (Ubuntu20.04)

기준 사양RTX A6000 (Ampere Arch)Nvidia driver 470.xxCUDA 11.xUbuntu 20.04 LTShttps://docs.docker.com/engine/install/ubuntu/이전 버전 삭제https를 통해 reposito

10.best jupyterlab extensions (추천)

jupyterlab-execute-time