본 내용은 인하대학교 정보통신공학과 홍성은 교수님의 인공지능응용 강의내용을 기반으로 작성한 내용입니다.

K-Nearest Neighbor with Pixel Distance

- pixel 거리 가반 KNN 알고리즘

- 차원수가 높으면 알고리즘이 잘 작동하지 않는다.

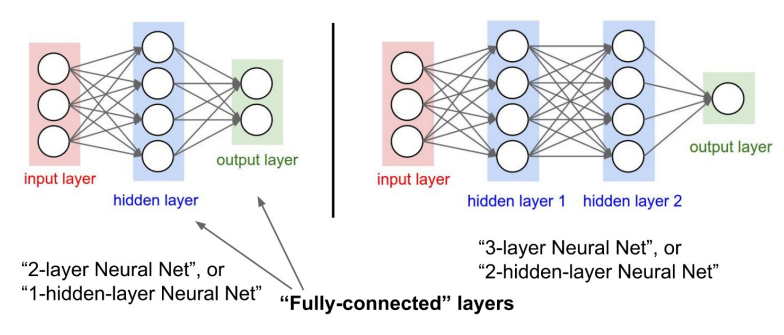

Neural Networks with Dimension

- NN에서 Weight(W)는 차원을 변경해주는 역할을 한다.

- W가 3x10 형태이다! → 10차원을 3차원으로 변환

- Neural Network의 Forward 과정에서 차원을 늘리고, 유지하고, 줄이는 과정이 존재한다.

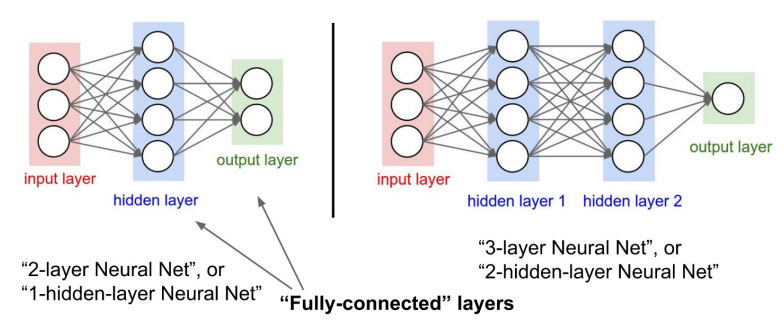

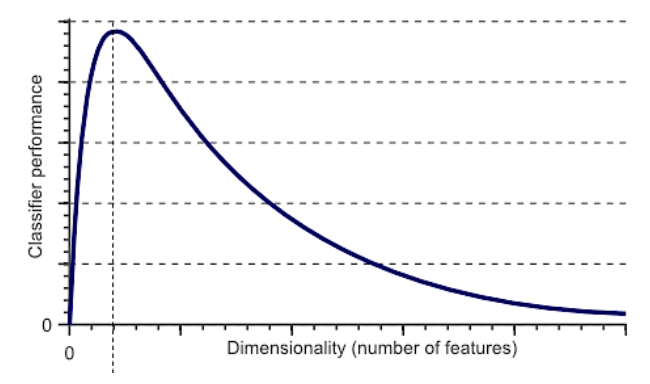

Curse of Dimensionality

-

차원수가 늘어나면 Train Data 수도 늘려줘야 Fitting을 잘 할 수 있다!

-

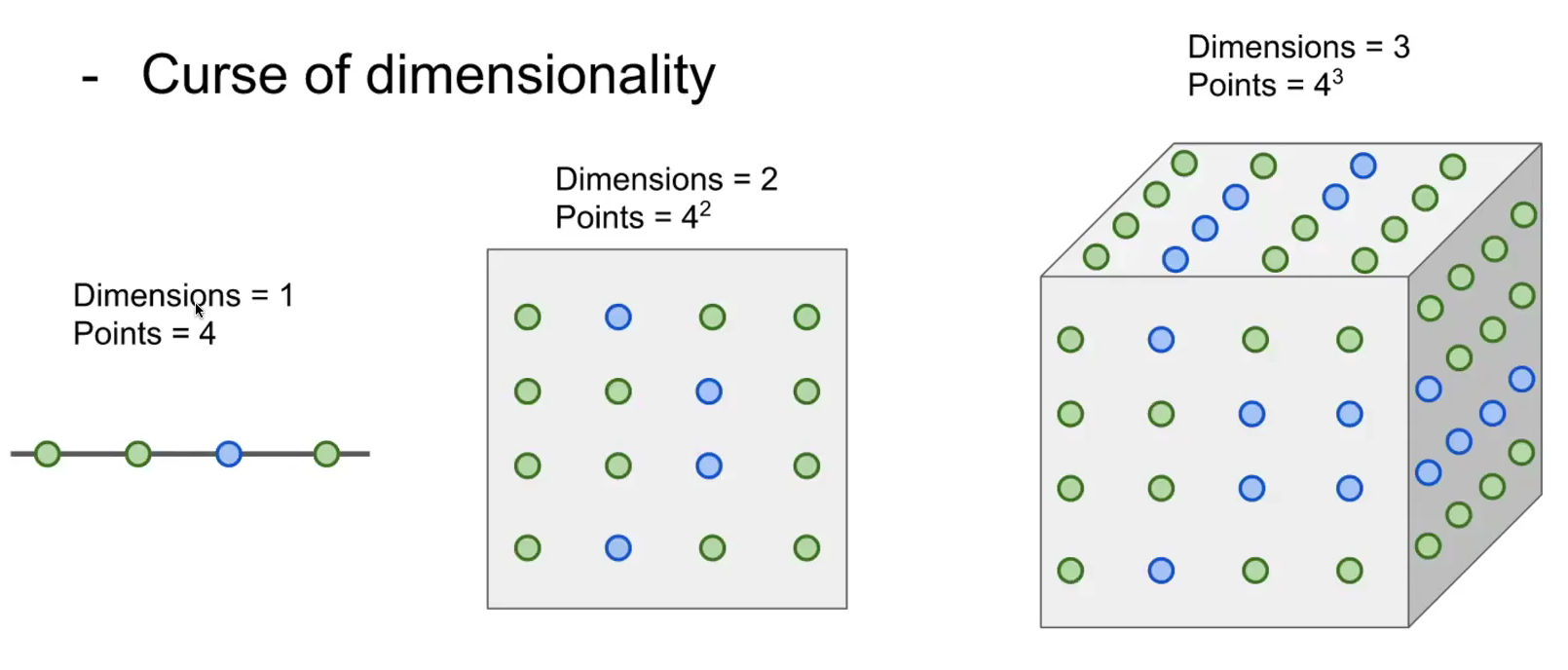

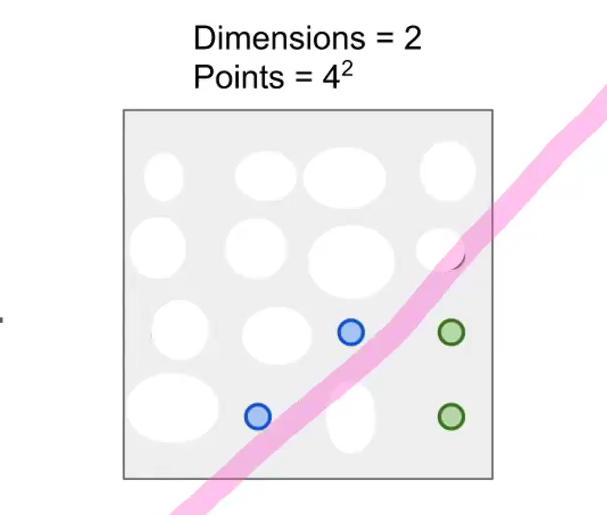

데이터의 개수가 동일하게 4개인데, 차원 수를 1차원에서 2차원으로 늘린다고 하자. 이를 구분하는 명확한 선을 표현할 순 있지만, Test Set에 대해서 예측하기 힘들다.

-

차원 수에 맞는 데이터의 개수가 충분하지 않을 시를 가정하면 다음과 같은 선이 그어진다. 이는 다른 데이터를 고려하면 적절하지 않은 구분선임을 알 수 있다.

-

이를 위해 차원수가 늘어남에 따라 데이터의 개수도 늘어나야 적절한 구분 선을 생성할 수 있다. -> 이를 Curse of dimensionality라고 한다.

-

다르게 말하면 차원수가 늘어나면 모델 fitting 하기 어렵다!

-

그래서 차원을 줄이려는 노력이 필요하다!

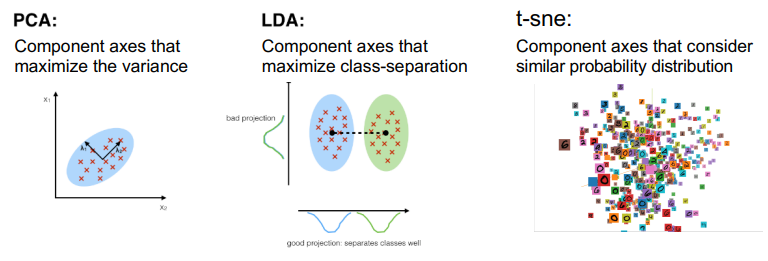

Dimensionality Reduction

- 차원 축소

- PCA : 주성분을 기준으로 낮은 차원으로 mapping 가능

- LDA : PCA가 반영되어 있음. Classification에 특화되어 있다.

- t-sne : 성능을 높이기 위한 기법(PCA, LDA)과 달리, 시각화를 위한 기법(차원수가 높으면 표현할 수 없는 부분을 표현함.) class별 경향성을 파악하는데 유용하다.

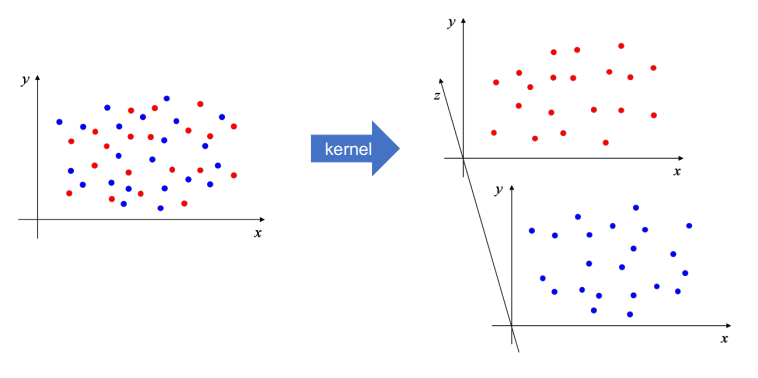

Dimensionality Expansion

- 차원 확장

- 너무 저차원일 때는 차원을 늘려주는 것이 모델 성능 향상에 도움이 될 수 있다.