[ AI&ML_Eng : 개념 공부.] AI&ML_Eng : 개념 공부. : DL 면접 대비 01.

▽ [ AI&ML_Eng : 개념 공부. ] AI&ML_Eng : 개념 공부. : DL 면접 대비 01.

딥러닝이란 무엇인가?

딥러닝이란 무엇인가??

-

딥러닝(Deep Learning)은 인공신경망(Artificial Neural Networks, ANN)을 기반으로 하는 머신러닝의 한 분야입니다.

-

딥러닝 모델은 여러 층(Layer)의 뉴런(Neuron)으로 구성되어 있으며,

이 층들이 입력 데이터를 단계적으로 변환해가며 복잡한 패턴과 특징을 자동으로 학습합니다.

👉 딥러닝은 대규모 데이터와 GPU 같은 연산 자원이 필요하지만,

사람이 직접 특징을 설계하지 않아도 자동으로 학습할 수 있어

복잡하고 대규모의 문제를 해결하는 데 강력한 성능을 발휘합니다.

📌 대표적인 딥러닝 모델.

-

CNN (Convolutional Neural Network) : 이미지·영상 처리 (예: 얼굴 인식, 자율주행 차량의 객체 탐지)

- 합성곱 연산을 통해 이미지 같은 공간적 데이터의 특징을 잘 추출합니다.

-

RNN (Recurrent Neural Network) : 시계열·순차 데이터 처리 (예: 음성 인식, 번역)

- 순차적 데이터를 다루며, 과거 정보를 기억할 수 있어 음성이나 텍스트 같은 시계열 데이터에 적합합니다.

-

Transformer : 병렬 학습 기반 구조 (예: ChatGPT, 번역기, 음성 합성)

- Self-Attention 메커니즘으로 병렬 학습이 가능하고, 긴 문맥을 처리하는 데 강점이 있어 최신 자연어 처리 모델에 주로 사용됩니다.

| 구분 | CNN (Convolutional Neural Network) | RNN (Recurrent Neural Network) | Transformer |

|---|---|---|---|

| 핵심 구조 | 합성곱(Convolution)과 풀링(Pooling) 계층으로 공간적 패턴 추출 | 순환 구조로 과거 정보를 기억하며 시퀀스 데이터 처리 | Self-Attention 메커니즘을 통해 입력 전체를 동시에 고려 |

| 입력 데이터 | 2D 데이터 (이미지, 영상) | 시계열·순차 데이터 (텍스트, 음성) | 텍스트, 멀티모달 (텍스트+이미지+음성) |

| 장점 | 이미지 특징 자동 추출, 파라미터 효율적 | 시퀀스 데이터에 특화, 시간적 의존성 학습 | 병렬 처리 가능, 긴 문맥 학습 우수 |

| 단점 | 시퀀스 처리에 부적합 | 긴 시퀀스에서 기울기 소실/폭발 문제 | 연산량이 많아 자원 소모 큼 |

| 대표 활용 | 얼굴 인식, 자율주행 객체 탐지 | 기계 번역(초기), 음성 인식 | GPT, BERT, ChatGPT 등 최신 NLP 모델 |

| 예시 모델 | LeNet, AlexNet, ResNet | LSTM, GRU | BERT, GPT, ViT |

👉 이미지와 같은 공간적 데이터는 CNN이 적합하지만,

텍스트나 음성처럼 순차적 구조가 중요한 데이터에는 RNN 또는 Transformer가 적합합니다.

특히 Transformer는 RNN의 기울기 소실 문제를 해결하고 병렬 처리가 가능하기 때문에, 대규모 NLP 문제에서 더 효과적입니다.

면접용 답변.

👉 딥러닝은 인공신경망을 기반으로 하는 머신러닝의 한 분야로, 여러 층의 신경망을 통해 복잡한 데이터에서 패턴을 자동으로 학습하는 기술입니다. CNN, RNN, Transformer 등이 대표적입니다.

딥러닝과 머신러닝의 차이점은 무엇인가?

| 구분 | 머신러닝 (Machine Learning) | 딥러닝 (Deep Learning) |

|---|---|---|

| 정의 | 데이터 기반 학습 전반 | 머신러닝의 하위 분야, 신경망 기반 학습 |

| 특징 추출 | 사람이 직접 Feature Engineering 필요 | 신경망이 자동으로 특징 추출 |

| 모델 구조 | 선형회귀, 의사결정나무, SVM 등 | 다층 신경망 (CNN, RNN, Transformer) |

| 데이터 요구량 | 적은 데이터에도 활용 가능 | 대규모 데이터 필요 |

| 연산 자원 | CPU로도 충분히 가능 | GPU/TPU 필요 |

| 적합한 문제 | 단순/중간 난이도 문제 | 복잡하고 대규모 데이터 문제 |

| 활용 예시 | 추천 시스템, 금융 모델링 | 이미지 인식, 음성·언어 처리, 자율주행 |

-

머신러닝은 컴퓨터가 데이터를 기반으로 학습하고, 패턴을 인식하여 예측이나 분류를 수행하는 기술.

-

딥러닝은 머신러닝의 한 분야로, 인공 신경망을 사용해 학습을 수행.

-

딥러닝 모델은 데이터에서 복잡한 패턴을 추출할 수 있는 능력을 가지고 있어, 머신러닝 기법보다 높은 성능을 보여주는 경우가 많음.

- 따라서 딥러닝은 보다 복잡한 문제에 적합하다고 볼 수 있음.

👉 요약

- 머신러닝은 데이터 기반 학습의 큰 틀

- 딥러닝은 그중에서도 신경망 기반으로 복잡한 문제 해결에 특화된 방법론

면접용 답변.

👉 머신러닝은 데이터를 기반으로 학습하는 알고리즘 전반을 의미하고, 딥러닝은 그중에서도 인공신경망을 사용하는 방법입니다.

머신러닝은 특징을 사람이 직접 설계해야 하는 경우가 많지만, 딥러닝은 신경망이 특징을 자동으로 추출하여 복잡한 문제에 더 적합합니다.

왜 딥러닝이 인공지능에 큰 영향을 미치고 있는가?

- 딥러닝은 인공지능(AI)의 발전에 있어 핵심적인 역할을 수행합니다. 이유는 아래와 같음.

1️⃣ 자동 피처 추출 (Automatic Feature Extraction).

- 딥러닝 모델은 여러 층(Layer)을 거치면서 데이터를 변환하여

사람이 직접 정의하지 않아도 데이터에서 중요한 특징(Feature)을 자동으로 추출. !

👉 예: CNN이 이미지에서 엣지 → 패턴 → 객체를 단계적으로 학습

2️⃣ 대규모 데이터 처리 (Big Data Friendly)

- 딥러닝은 방대한 데이터셋을 활용하여 복잡한 패턴을 학습하는 데 탁월한 성능을 보입니다.

- 이 점은 데이터 중심 사회에서 AI가 발전하는 데 필수적 요소

👉 예: 수백만 장의 이미지로 학습된 ImageNet 모델

3️⃣ 높은 일반화 능력 (Generalization Ability)

- 학습된 딥러닝 모델은 새로운 데이터에 대해서도 높은 예측 및 분류 성능을 보입니다.

- 이는 실제 응용 환경에서 매우 중요한 특성입니다.

👉 예: 새로운 환자의 X-Ray 이미지를 학습 모델로 진단

4️⃣ 다양한 응용 분야 (Wide Applications)

-

딥러닝은 다양한 인공지능 응용 분야에 적용.

-

이미지 인식 (자율주행, 의료 진단)

-

자연어 처리 (NLP) (번역기, 챗봇, 감정 분석)

-

음성 인식 (가상 비서, 자동 자막 생성)

-

추천 시스템 (Netflix, YouTube, 쇼핑몰)

-

5️⃣ 강력한 하드웨어 지원 (Hardware Acceleration)

-

GPU·TPU와 같은 고성능 하드웨어의 발전으로 딥러닝 모델의 학습 속도가 크게 향상.

-

덕분에 훨씬 깊고 복잡한 신경망 구조를 사용할 수 있게 되었고, AI 발전이 가속화.

6️⃣ 연구 및 기술 발전 (Ongoing Research & Innovation)

-

딥러닝 분야는 활발한 연구와 기술 혁신.

-

더욱 효율적이고 성능 좋은 모델들이 개발되고 있으며,

AI의 성장과 확산에 직접적인 기여.

면접용 답변.

👉

1. 자동 피처 추출 : 사람이 직접 특징을 설계하지 않아도 신경망이 학습

2. 대규모 데이터 처리 능력 : 방대한 데이터에서 복잡한 패턴 학습 가능

3. 일반화 성능 : 새로운 데이터에서도 높은 정확도 유지

4. 다양한 응용 분야 : 이미지, 음성, 언어, 추천 시스템 등

5. 하드웨어 발전 : GPU/TPU 덕분에 학습 속도와 모델 복잡도 증가

6. 지속적인 연구 발전 : 성능 개선과 새로운 구조 개발

👉 따라서 딥러닝은 AI 발전의 핵심 동력으로 작용

주요 딥러닝 알고리즘은 어떤 것들이 있나?

주요 딥러닝 알고리즘

- 딥러닝에는 다양한 신경망 구조가 있으며, 각기 다른 목적과 특성에 맞게 사용됩니다.

- 주요 딥러닝 알고리즘에는 합성곱(CNN), 순환 신경망(RNN), 장단기 메모리(LSTM), 게이트 순환 유닛(GRU), 생성적 적대 신경망(GAN), 오토인코더(Autoencoder)등이 있습니다.

- CNN은 이미지 처리, RNN 계열은 시퀀스 데이터, GAN은 생성, Autoencoder는 차원 축소와 이상치 탐지에 주로 사용됩니다.

| 알고리즘 | 특징 | 주요 활용 분야 |

|---|---|---|

| CNN (Convolutional Neural Network) | 합성곱과 풀링으로 이미지의 공간적 특징 추출 | 이미지 분류, 객체 탐지, 시맨틱 분할 |

| RNN (Recurrent Neural Network) | 순환 구조를 통해 시퀀스 데이터 학습 | 음성 인식, 자연어 처리, 시계열 예측 |

| LSTM (Long Short-Term Memory) | RNN의 장기 의존성 문제 해결 | 번역, 챗봇, 시계열 분석 |

| GRU (Gated Recurrent Unit) | LSTM의 간소화 버전, 학습 속도 빠름 | 텍스트 생성, 음성 인식 |

| GAN (Generative Adversarial Network) | 생성자(Generator)와 판별자(Discriminator)의 경쟁 | 이미지 생성, 딥페이크, 예술 창작 |

| Autoencoder (오토인코더) | 입력을 압축해 잠재 벡터로 변환 후 복원 | 차원 축소, 이상치 탐지, 이미지 노이즈 제거 |

면접용 답변.

👉 CNN, RNN, LSTM, GRU, GAN, Autoencoder 등이 있습니다.

CNN은 이미지 처리, RNN 계열은 시퀀스 데이터, GAN은 생성, Autoencoder는 차원 축소와 이상치 탐지에 주로 사용됩니다.

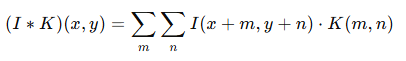

합성곱 신경망(CNN)이란 무엇이고, 언제 사용되는가?

정의.

- CNN(Convolutional Neural Network)은

이미지와 같은 2차원 데이터의 공간적 특징을 효과적으로 추출하기 위해 고안된 신경망 구조.

핵심 구조

-

합성곱 계층 (Convolution Layer) : 이미지 내 국소적 패턴(예: 엣지, 코너)을 추출

-

풀링 계층 (Pooling Layer) : 특징 맵의 크기를 줄여 연산 효율 증가 및 불변성 확보

-

완전 연결 계층 (Fully Connected Layer) : 추출된 특징을 기반으로 최종 분류

언제 사용되는가??

-

이미지 분류 (예: 고양이 vs 개 분류)

-

객체 탐지 (예: 자율주행에서 보행자 탐지)

-

시맨틱 분할 (예: 의료 영상에서 종양 위치 식별)

-

이미지 생성 (예: StyleGAN)

면접용 답변.

👉 CNN은 합성곱 계층과 풀링 계층을 통해 이미지의 공간적 특징을 자동으로 추출하는 신경망입니다.

주로 이미지 분류, 객체 탐지, 시맨틱 분할 같은 컴퓨터 비전 문제에 사용됩니다.

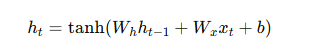

순환 신경망(RNN)이란 무엇이고, 어떤 경우에 사용되는가?

정의.

- RNN(Recurrent Neural Network)은 시퀀스(Sequential) 데이터를 처리하기 위해 고안된 구조로,

- 이전 단계의 출력을 다음 단계의 입력으로 전달하여 과거 정보를 기억 가능.

핵심 구조

-

은닉 상태(Hidden State)를 유지하여 시간적 의존성 학습

-

긴 시퀀스에서는 기울기 소실(Vanishing Gradient) 문제가 발생 → LSTM/GRU로 보완

언제 사용되는가??

-

자연어 처리 (번역, 감정 분석, 챗봇)

-

음성 인식 (가상 비서, 자동 자막)

-

시계열 분석 (주가 예측, 날씨 예측)

면접용 답변.

👉 RNN은 순환 구조를 통해 과거 정보를 기억하며 시퀀스 데이터를 처리하는 신경망입니다.

자연어 처리, 음성 인식, 시계열 분석 같은 순차적 데이터에 적합합니다.

mindmap

root((주요 딥러닝 알고리즘))

CNN

- 이미지 분류

- 객체 탐지

- 시맨틱 분할

RNN

- 자연어 처리

- 음성 인식

- 시계열 분석

LSTM

- 장기 의존성 해결

- 번역 / 챗봇

GRU

- 경량화된 LSTM

- 빠른 학습

GAN

- 이미지 생성

- 딥페이크

Autoencoder

- 차원 축소

- 이상치 탐지

- 이미지 복원

합성곱 신경망(CNN) / 순환 신경망(RNN)/ 장단기 메모리(LSTM)/ 게이트 순환 유닛(GRU)의 구조 비교

1️⃣ CNN, RNN, LSTM, GRU 구조 비교.

| 알고리즘 | 핵심 구조 | 주요 역할 | 장점 | 단점 |

|---|---|---|---|---|

| 합성곱 신경망(CNN) | 합성곱(Convolution) + 풀링(Pooling) + FC Layer | 공간적 특징 추출 (이미지) | 자동 피처 추출, 이미지 처리에 강점 | 시퀀스 처리 불가 |

| 순환 신경망(RNN) | 은닉 상태(Hidden State)를 순환 연결 | 시퀀스 데이터 처리 | 시간적 의존성 학습 가능 | 긴 시퀀스에서 기울기 소실/폭발 |

| 장단기 메모리(LSTM) | 입력 게이트, 망각 게이트, 출력 게이트 + 셀 상태(Cell State) | 장기 의존성 문제 해결 | 긴 문맥 유지, NLP에 강점 | 구조 복잡, 연산량 많음 |

| 게이트 순환 유닛(GRU) | 업데이트 게이트 + 리셋 게이트 | 경량화된 LSTM | 학습 속도 빠르고 성능 유사 | 장기 의존성은 LSTM보다 약간 열세 |

2️⃣ 내부 연산 비교.

1️⃣ CNN (합성곱 신경망)

공식.

👉 쉽게 말하면, 이미지에 작은 확대경(커널)을 가져다 대고 살펴보는 과정.

-

I(x,y) : 원본 이미지

-

K(m,n) : 확대경 역할을 하는 작은 필터(커널)

-

결과 : 특정 패턴(예: 엣지, 모서리)을 강조한 새로운 이미지

풀링 연산 (Max Pooling / Average Pooling).

👉 중요한 부분만 남기고 불필요한 세부정보를 줄이는 과정.

-

Max Pooling : 확대경 안에서 가장 큰 값만 선택 (예: 가장 강한 특징)

-

Average Pooling : 평균을 내서 부드럽게 만듦

비유:

사진에서 중요한 윤곽선만 남기고 잡음을 줄이는 과정.

2️⃣ RNN (순환 신경망)

공식.

👉 쉽게 말해,

-

h_t : 현재 기억 상태

-

h_{t-1} : 어제의 기억

-

x_t : 오늘의 입력 정보

-

tanh : 정보를 적절히 조절해 저장하는 뇌의 필터

=> 즉, 오늘의 정보(xt)와 어제의 기억(h{t-1})을 합쳐서 현재 기억(h_t)을 만든다는 뜻.

비유:

책을 읽을 때, 오늘 읽은 내용을 어제 읽은 내용과 연결해서 이해하는 과정

3️⃣ LSTM (장단기 메모리 신경망)

👉 RNN의 기억력이 짧은 문제를 해결하기 위해 게이트(문)를 추가한 구조

게이트의 역할.

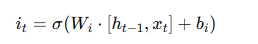

- 입력 게이트 (i_t) : 새로 들어온 정보를 받아들일지 결정

-

i_t: 새로 들어온 정보를 얼마나 받아들일지 결정.

- 👉 시험 공부에서 새로 배운 공식 중 암기할지 여부

-

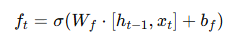

망각 게이트 (f_t) : 과거 정보를 버릴지 유지할지 결정.

- f_t: 과거 정보 중 버릴 부분 선택.

- 👉 시험 공부에서 새로 배운 공식 중 암기할지 여부

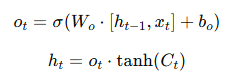

- 출력 게이트 (o_t) : 현재 출력할 정보 선택(최종적으로 얼마나 보여줄지 결정).

- o_t, h_t: 현재 상황에서 보여줄 정보 결정

- 👉 시험 문제에 맞게 필요한 정보만 꺼내 답안 작성.

-

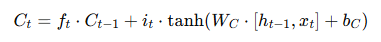

셀 상태 업데이트 (C_t) : 긴 시간 동안 유지되는 "장기 기억".

- C_t: 이전 기억에서 중요한 건 유지 + 새로 필요한 건 추가

- 👉 핵심 노트에 계속 업데이트

- C_t: 이전 기억에서 중요한 건 유지 + 새로 필요한 건 추가

비유:

시험 공부할 때,

입력 게이트: 새로 배운 개념을 암기할지 말지 선택

망각 게이트: 오래된 정보 중 불필요한 건 버림

출력 게이트: 시험 문제에 답할 때 필요한 정보만 꺼냄

셀 상태: 계속 유지되는 핵심 노트

👉 이렇게 해서 필요한 정보는 오래 기억하고, 불필요한 건 잊어버리며, 시험에 맞게 활용.

4️⃣ GRU (게이트 순환 유닛)

👉 LSTM을 단순화한 버전 (게이트 수 3개 → 2개)

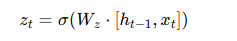

게이트의 역할

- 업데이트 게이트 (z_t) : 과거 기억을 얼마나 유지할지 결정(기억 유지 비율)

-

z_t: 과거 정보를 얼마나 유지할지 결정.

- 👉 지난 회의록 중 이번 회의에 그대로 반영할 내용

-

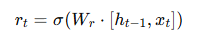

리셋 게이트 (r_t) : 과거 기억을 얼마나 무시할지 결정(과거 정보 무시 여부)

- r_t: 과거 정보를 무시할지 결정.

- 👉 지난 회의록 중 쓸모없는 부분 과감히 삭제

- r_t: 과거 정보를 무시할지 결정.

-

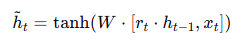

후보 은닉 상태(h~_t) : 최종 기억 상태(업데이트 된 기억)

-

\tilde{h}_t: 현재 정보를 기반으로 만든 새 기억 후보

- 👉 새 회의 안건에서 작성된 내용

-

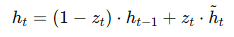

최종 은닉 상태 (h_t) : 최종 기억 상태(업데이트 된 기억)

- h_t: 과거 정보와 새로운 정보를 적절히 섞은 결과.

- 👉 최종 회의록: 과거 유지 + 새로운 내용 반영.

- h_t: 과거 정보와 새로운 정보를 적절히 섞은 결과.

비유:

회의록 작성할 때,

업데이트 게이트: 지난 회의 내용 중 이번에도 참고할 부분을 선택

리셋 게이트: 지난 회의 중 필요 없는 부분은 과감히 무시

은닉 상태: 이번 회의록에 반영된 결과

👉 LSTM보다 빠르게 학습하면서도 성능은 비슷

📊 요약 (문과가 이해해보려고 온몸을 비틀어봄)

| 모델 | 핵심 아이디어 | 비유 |

|---|---|---|

| CNN | 작은 창으로 이미지를 훑어가며 특징을 뽑음 | 사진에서 윤곽선만 남기는 과정 |

| RNN | 오늘의 정보 + 어제의 기억 → 새로운 기억 | 책 읽으며 앞 내용과 연결 |

| LSTM | 기억할지/버릴지/꺼낼지 선택하는 3개의 문 사용 | 시험 공부할 때 필요한 것만 기억 |

| GRU | 기억 유지/무시를 선택하는 2개의 문 사용 | 회의록에서 중요 내용만 추림 |

| 항목 | LSTM | GRU |

|---|---|---|

| 게이트 수 | 3개 (입력·망각·출력) | 2개 (업데이트·리셋) |

| 기억 저장소 | 셀 상태 C_t + 은닉 상태 h_t | 은닉 상태 h_t만 사용 |

| 장점 | 장기 의존성에 매우 강함 | 계산 효율적, 속도 빠름 |

| 단점 | 연산량 많음 | 장기 기억력은 LSTM보다 살짝 약함 |

👉 즉,

-

CNN = 눈(시각) 같은 모델

-

RNN = 단기 기억

-

LSTM = 필터링이 가능한 장기 기억

-

GRU = 효율적인 장기 기억