Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

Paper Review

목록 보기

29/29

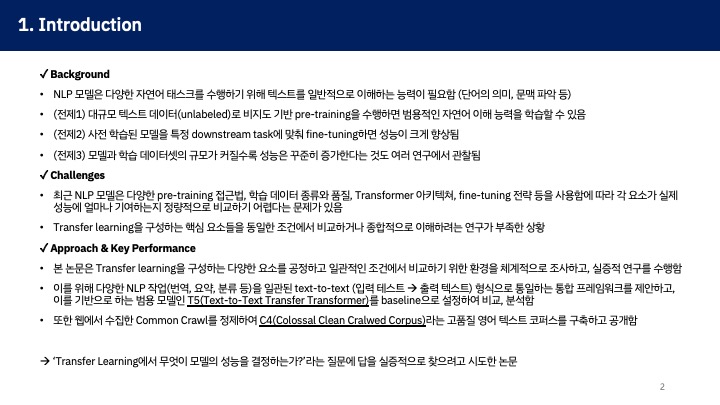

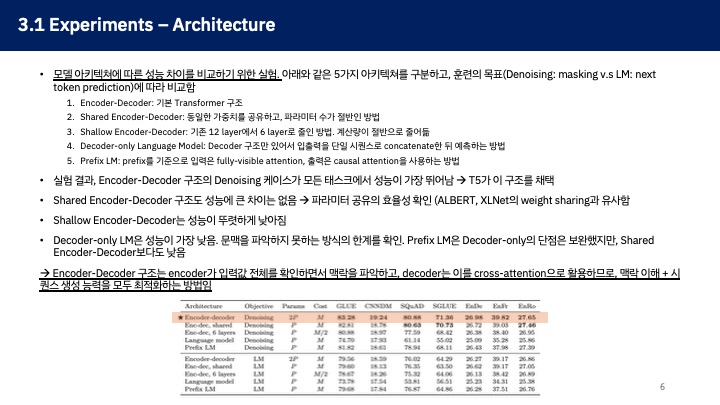

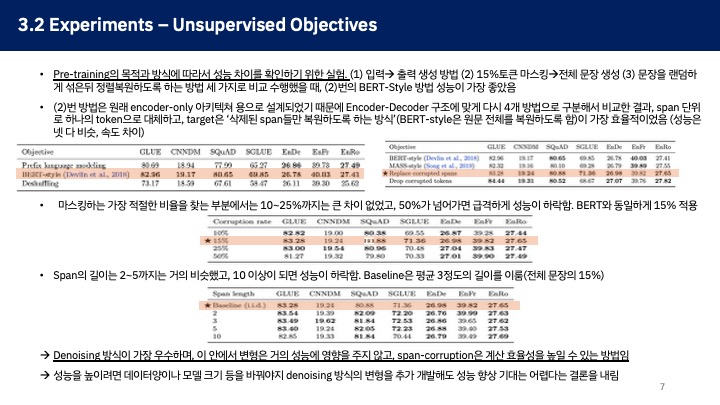

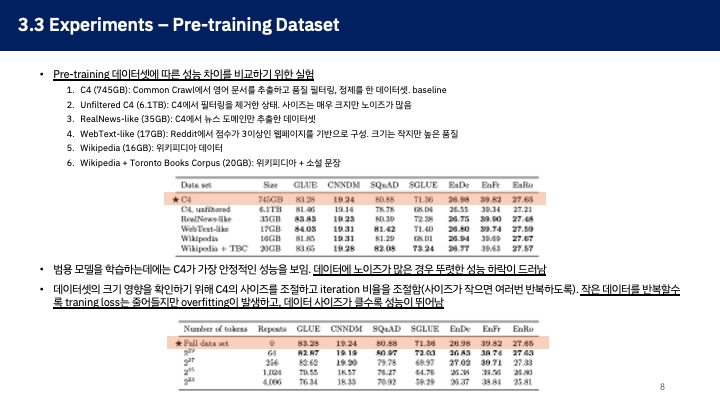

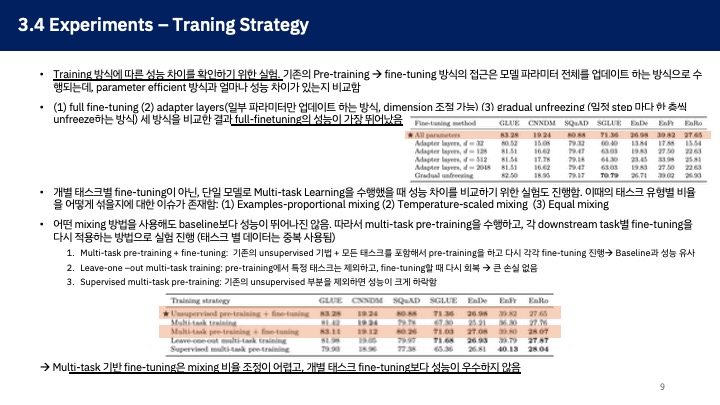

2020년에 Google에서 발표한 T5 모델 논문이다. 새로운 모델이라기 보다는 기존의 Encoder-Decoder 기반의 Trnasformer 구조를 그대로 가져와서 일부 개선된 기능들을 추가하고, 학습을 위한 양질의 대규모 데이터셋 구축을 주요 연구 성과로 제시하고 있다.

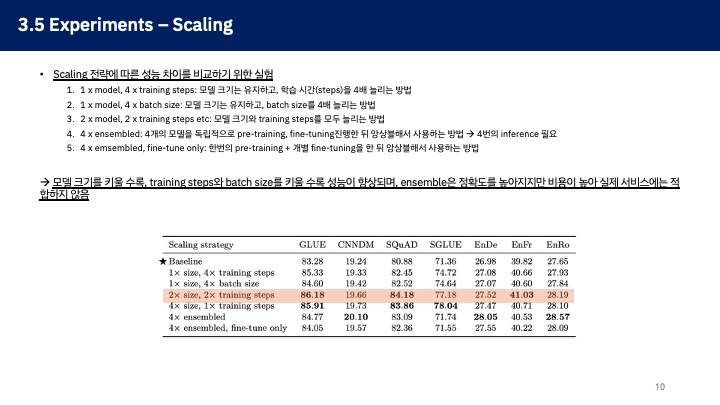

논문의 주요 포인트는 어떤 요소가 Transfer learning에서 모델의 성능에 실질적으로 기여하는지를 ablation study와 같은 형식으로 제시한다는 점이라고 생각했다. 나온지 꽤 된 논문인만큼, 현재의 관점 혹은 일반적인 통념과는 일부 다른 내용도 존재하는데(Encoder-Decoder가 단일 Decoder 모델보다 성능이 훨씬 뛰어나다..와 같은), 해당 내용들을 현재 기준으로 비교해보면서 읽어보는 것도 좋을 것 같다.