Document Classification

🎬 IMDB 영화 리뷰 감정 분류 (Sentiment Classification)

IMDB 데이터셋은 사용자가 작성한 영화 리뷰와 평점을 기반으로 구성된텍스트 데이터셋이다.- 각 리뷰는

감정 레이블(sentiment label)이 지정되어 있으며,긍정(positive)또는부정(negative)으로 나뉜다. - 이 문제는

자연어 처리(NLP)분야의 전형적인 텍스트 분류 문제로, 텍스트 데이터를숫자 기반의feature로 변환하는 작업이 핵심이다.

부정 리뷰 예시:

"The plot was predictable and the acting was wooden."

긍정 리뷰 예시:

"Absolutely loved it. The performances were powerful and moving."

👜 Bag-of-Words 모델 (텍스트를 숫자로 표현하는 방법)

- 문서마다 길이는 다르고, 단어의 순서도 존재하지만 BoW는

단어의 존재 여부만을 고려한다. - 자주 등장하는 단어 10,000개를 사전(dictionary)으로 선택

- 각 문서는 길이 10,000의 이진 벡터로 표현 → 단어가 등장하면 해당 위치에

1아니면0 - 결과적으로, 문서 수가 25,000이므로 25,000 x 10,000 크기의 희소 행렬(sparse matrix) 생성 (실제로는 1.3%만 0이 아님)

BoW는 문서를 단어들의 집합으로만 요약하기 때문에 문맥 정보는 반영되지 않는다.

→ 단어의 순서를 고려하지 않기 때문에, "not good"과 "good"은 동일한 긍정적인 의미로 해석될 수 있다.

Uni-gram: 단어 하나 단위 (기본 BoW 모델)Bi-gram: 연속된 단어 쌍 고려 (예: "not good")m-gram: m개의 연속된 단어 조합

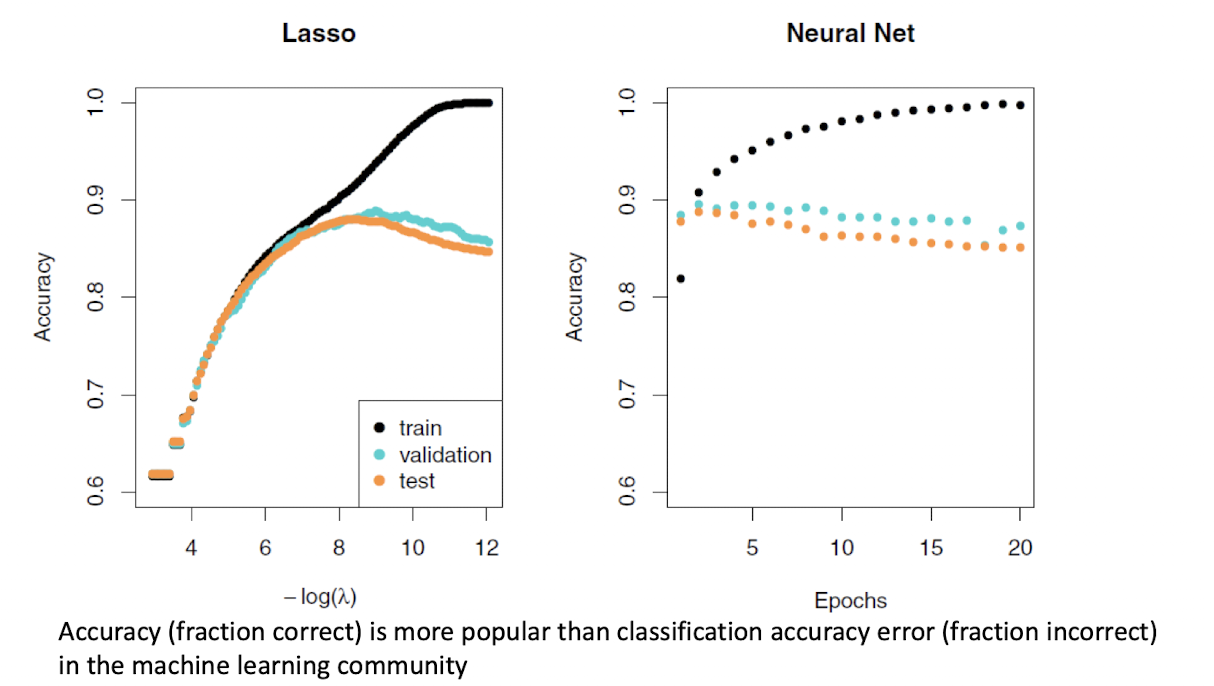

🆚 Lasso 로지스틱 회귀 vs. 이진 분류 신경망

Lasso Logistic Regression (glmnet 사용)

two-hidden layers Neural Network (각 층에는 ReLU 유닛 16개씩 존재)

🖇️ 공통점

학습 정확도(training accuracy)는 두 모델 모두 학습이 진행됨에 따라단조 증가(monotonic increase)한다.- 하지만

검증 오류(validation error)를 기준으로 적절한 모델을 선택하는 것이 중요하다.

과적합(overfitting)을 방지하기 위해 validation set의 성능이 더 중요함.

🖇️ Lasso 로지스틱 회귀

- 간단한 선형 모델이지만 성능은 신경망 못지않다.

- 특히 BoW의

희소 행렬(sparse matrix)을 활용할 수 있기 때문에,glmnet패키지를 사용해 매우 효율적으로 학습 가능하다. - 이 모델은

파라미터 수를 줄이고(feature selection),해석 가능성도 높다.

🖇️ 이진 분류 신경망

비선형로지스틱 회귀 모델로 볼 수 있으며,Softmax 활성화 함수를 통해 클래스 확률을 출력한다.- 출력 확률 계산 방식 (2-class case):

- 여기서 𝐴ℓ 은 은닉층의 활성화 값들이다.

- 표현력은 높지만, 이 예제에서는 단순한 Lasso 모델과 비슷한 성능을 보여준다.

‼️ 복잡한 신경망 모델이 항상 더 나은 건 아니다. 이 경우처럼 데이터 구조가 단순하고 희소할 때는,

Lasso 같은 선형 모델도 충분히 좋은 성능을 낼 수 있다.

Recurrent Neural Networks (RNN)

✅ 시퀀스 데이터를 위한 모델, RNN

현실 세계의 많은 데이터는 시퀀스(sequence) 형태로 존재한다. 이 시퀀스 구조는 단순히 데이터를 나열한 것이 아니라, 순서 자체가 의미를 갖는다.

🖇️ 시퀀스 데이터의 예시

문서: 단어들이 순차적으로 구성되며, 순서에 따라 의미가 달라짐시계열 데이터: 날씨, 주식 지수, 센서 데이터 등 시간 흐름에 따라 기록음성/음악: 시간에 따라 변화하는 연속 신호필기체: 손글씨는 글자 순서와 선의 흐름이 중요 (예: 의사 처방전)

이러한 데이터를 처리하기 위해 고안된 모델이 바로 RNN (Recurrent Neural Network) 이다.

🖇️ RNN의 핵심 아이디어

-

시퀀스의 이전 정보를 기억하면서 다음 출력을 예측

-

입력 는

벡터들의 순서로 구성됨

(예:IMDB리뷰에서는 이 한 단어, 전체 는 하나의 리뷰 문서를 의미) -

출력 는 보통

단일 값(예: 감정 레이블) 혹은 다중 클래스(one-hot 벡터)

하지만 더 복잡한 경우에는 출력도 시퀀스가 될 수 있다:

-

예:

기계 번역(입력: 영어 문장, 출력: 같은 문장의 한국어 번역) -

이 경우, RNN은 입력 시퀀스를 처리해 문맥을 요약하고, 그 요약을 바탕으로 출력 시퀀스를 생성

RNN은 순서를 인식하는 신경망이다.

과거 정보를 축적해 현재의 결정을 돕고, 필요에 따라 출력도 시퀀스로 생성할 수 있다.

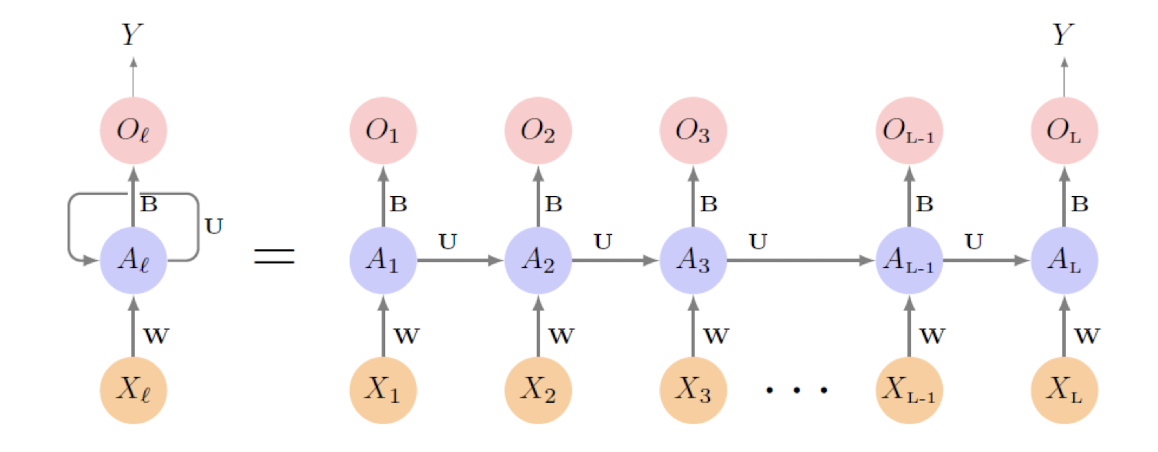

✅ 기본 RNN 구조

RNN(Recurrent Neural Network)의 핵심은 입력 시퀀스를 시간에 따라 하나씩 처리하며, 과거 정보를 누적하는 구조이다.

🖇️ 입력과 출력

-

입력 시퀀스:

여기서 은 단어의 개수처럼 시퀀스 길이를 의미한다.

-

출력:

보통 하나의 단순한 출력 (예: 감정 분류, 다음 단어 예측 등)을 생성

🖇️ 은닉층 (Hidden States)

-

각 시점 에서의 은닉상태 은 다음을 입력으로 받는다:

현재 입력직전 은닉 상태

-

즉, 은닉 상태는 다음과 같이 계산된다.

- 는 각각

입력 가중치,이전 상태 가중치,편향 - 모든 시점에서 같은 가중치를 사용하기 때문에 "recurrent"라고 불린다

- 는 tanh 또는

ReLU같은비선형 활성화 함수

- 는 각각

-

각 은닉 상태 는 또 하나의 출력 을 생성할 수 있다 (필요에 따라)

RNN은 하나의 입력만 보는 것이 아니라, 이전의 모든 입력들을 기억한 상태에서 다음 출력을 결정한다.

이게 바로 단순한 Feedforward 신경망과의 가장 큰 차이점이다.

❓ RNN 작동 방식 _in Detail

🖇️ 입력과 은닉 상태

-

하나의 시점 에서 입력 벡터는 다음과 같이 구성된다:

-

은닉 상태 벡터는 다음과 같다:

🖇️ 은닉 유닛 계산

-

은닉층의 각 유닛 에 대한 계산식은 다음과 같다:

- : 활성화 함수 (보통 tanh 또는 ReLU)

- : 입력층 가중치 → 는 크기의 행렬

- : 이전 은닉 상태로부터의 가중치 → 는 행렬

- : 바이어스(bias) 항

현재 입력 과 바로 직전 은닉 상태 를 합쳐서 새로운 은닉 상태 을 만든다.

🖇️ 출력 계산

- 출력값 은 은닉 상태의 선형 결합으로 계산된다:

- 여기서는 출력층의 가중치

- 전체 는 차 벡터

- 실제로는 마지막 지점 에서의 출력 만 사용하는 경우가 많다. (→ 전체 문서를 읽은 후 감정을 분류)

🖇️ 손실함수 (Loss)

- 개의 시퀀스-정답 쌍이 있을 때,

평균 제곱 오차 (Squared Error Loss)를 사용하면 다음과 같다:

즉, 마지막 은닉 상태 까지 순차적으로 정보를 통합한 후, 이를 기반으로 출력 을 만들고,

그 결과가 실제 정답 와 얼마나 차이가 있는지를 기준으로 모델을 학습하게 된다.

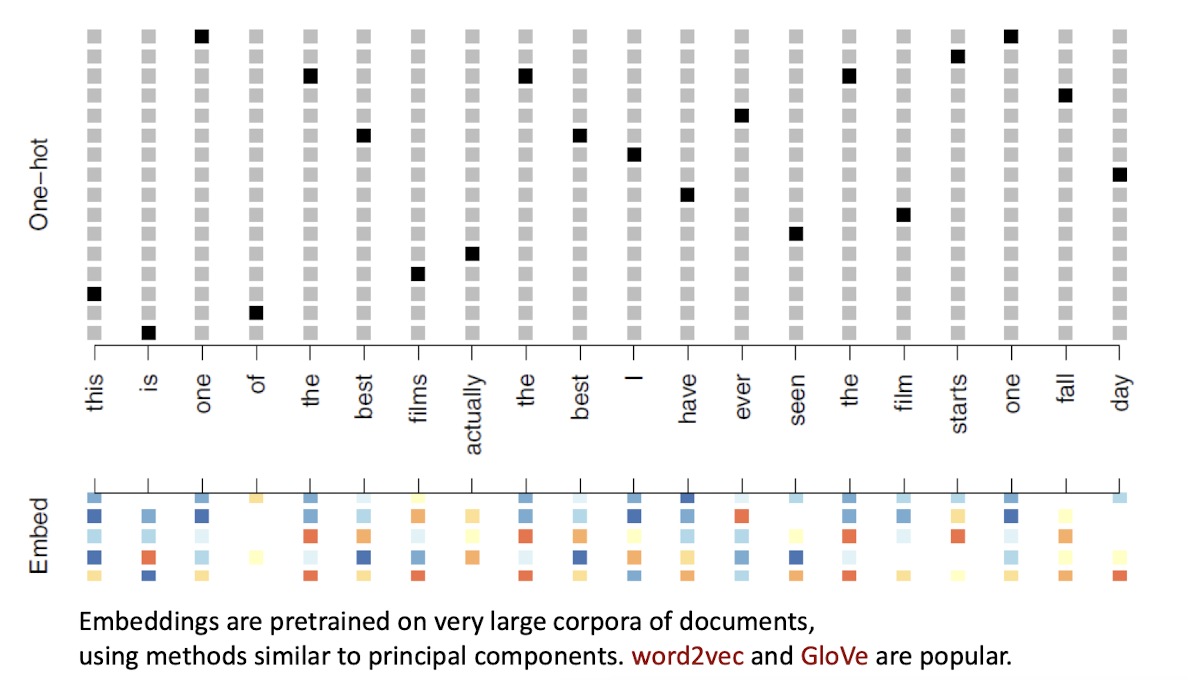

⁉️ 텍스트를 RNN에 넣는 법: 워드 임베딩 사용하기

문서나 문장은 단어들의 시퀀스로 구성된다.

RNN에 이런 데이터를 넣기 위해서는 먼저 숫자 벡터 형태로 변환해주는 전처리 과정이 필요하다.

🖇️ 문서 길이 맞추기

- 문서마다 단어 개수가 다르기 때문에, 일정한 길이 로 맞춰주는 작업이 필요하다.

- 너무 긴 문서는

자르고(truncate) - 너무 짧은 문서는

0으로채운다(pad)

- 너무 긴 문서는

🖇️ 단어 표현: 원-핫 인코딩의 한계

- 각 단어 는 원-핫 벡터 로 표현된다.

- 길이: 10,000 (자주 등장하는 단어 1만 개 기준)

해당 단어위치만1이고, 나머지는 모두0

- → 결과적으로 매우

희소한(sparse) 벡터가 된다.- 거의

대부분이 0이라서 계산비효율적이고, 의미 정보도 없음

- 거의

🖇️ 워드 임베딩의 등장

이 문제를 해결하기 위해, 우리는 미리 학습된 단어 임베딩(embedding) 을 사용한다.

- 원-핫 벡터를 곧바로 쓰지 않고, 임베딩 행렬 에 매핑한다.

- 이 행렬은 매우 큰 말뭉치(corpus) 를 기반으로 만들어졌으며, 단어 간의 의미적 관계를 잘 반영하도록 학습되었다.

🖇️ PCA와의 연결

이러한 임베딩 행렬은 때때로 PCA(Principal Component Analysis, 주성분 분석) 를 응용한 방식으로 생성되기도 한다.

- PCA는

고차원 데이터를저차원 공간에 의미 있게 압축하는 기법이다. - 단어 간의 공동 등장 패턴(co-occurrence) 을 분석하여, 고차원의 단어 공간을 의미 기반의 저차원 공간으로 줄여준다.

ex) 10,000차원이던 원-핫 벡터가실수(real number)벡터로수백 차원(m ≪ 10,000)정도로 줄어든다 (보통 )

워드 임베딩은 텍스트 데이터를 효율적이고 의미 있게 표현할 수 있게 해 주며, PCA와 같은 차원 축소 기법의 아이디어를 기반으로 만들어졌다는 점에서 단순한 인코딩 그 이상을 제공한다.

🎞️ RNN에서 LSTM으로: 성능의 진화

기존의 기본 RNN 구조로 IMDB 영화 리뷰 감정 분류를 학습한 결과는…

정확도: 76%

많은 공을 들였지만 기대에 못 미치는 성능이었다. 그 이유는?

- 기본 RNN은

장기 의존성 문제(long-term dependency)를 잘 처리하지 못함 - 과거 정보가 시간이 흐르며

기울기 소실(gradient vanishing)로 인해 사라지는 문제가 있음

🖇️ LSTM 등장

보다 발전된 RNN 구조인 LSTM (Long Short-Term Memory) 네트워크를 적용한다.

- 기존 은닉 상태 만 사용하는 것이 아니라, 장기 기억을 위한 별도의 경로(long-term memory) 도 추가됨

LSTM은 정보가언제저장되고,버려지고,출력될지를 제어하는게이트(gate) 구조를 사용함

LSTM은 중요한 정보는 오래 기억하고, 불필요한 정보는 빨리 지워서,

더 똑똑하게문맥을 유지한다!

🖇️ LSTM 성능

정확도: 87%

- 기존 RNN(76%)에 비해 훨씬 좋고, 심지어 Lasso 로지스틱 회귀(glmnet) 모델(88%)과 거의 비슷한 수준이다.

IMDB 데이터는 오랫동안 신경망 구조 성능을 비교하는 벤치마크로 사용되어 왔다.

2020년 기준으로는 가장 좋은 모델이 다음과 같은 성능을 보였다:

SOTA 정확도: 약 95%

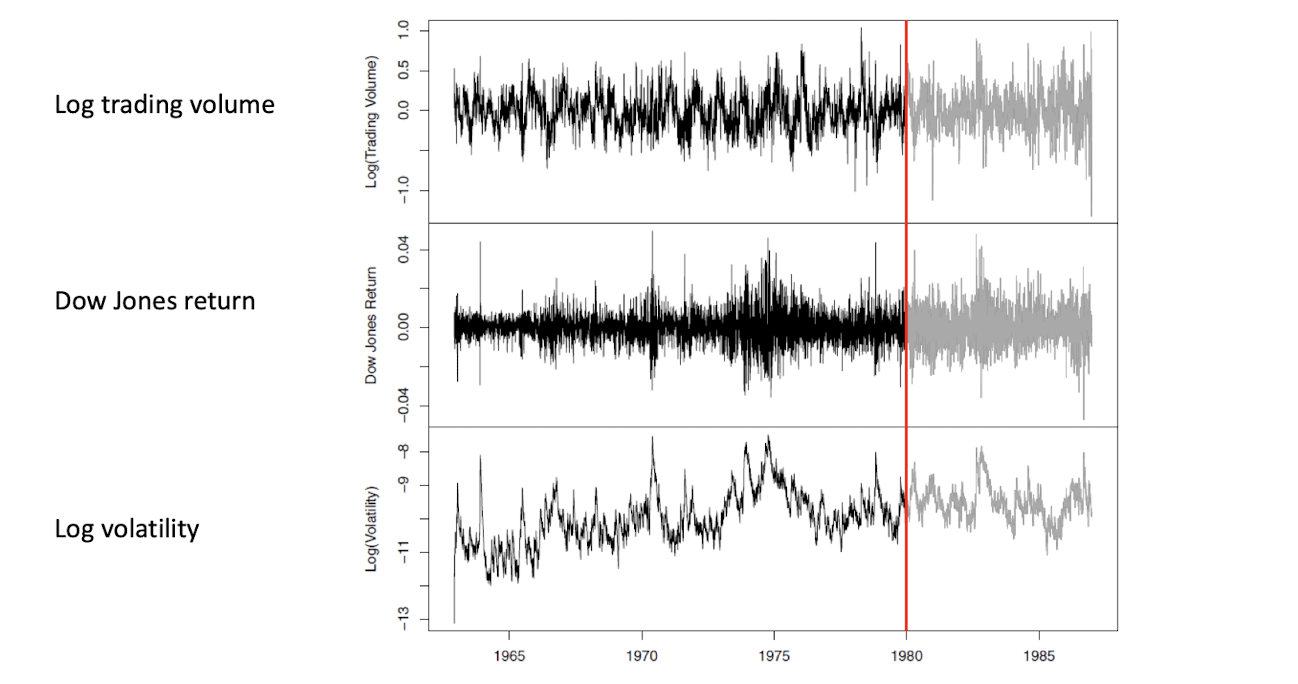

Time Series Forecasting

🖇️ 시계열 예측: 뉴욕 증시 데이터를 활용한 실전 예제

데이터셋 소개: NYSE (New York Stock Exchange)

- 기간: 1962년 12월 3일 ~ 1986년 12월 31일

- 총 6,051개의 거래일 데이터

- 하루 단위로 기록된 3가지 시계열 변수:

- Log 거래량 (Log Trading Volume)

- 당일 거래량을 최근 100일 평균 거래량과 비교한 비율

- 로그 스케일로 표현

- 다우존스 수익률 (Dow Jones Return)

- 두 연속된 거래일의 지수 로그 차이

- 수익률의 일간 변화량

- Log 변동성 (Log Volatility)

- 당일 가격 변동폭의 절댓값 기반으로 계산

- 로그 스케일 사용

🖇️ 문제 정의

목표: 다음 날의 Log 거래량을 예측하는 것

-

입력:

- 오늘까지의 Log 거래량 시퀀스

- 오늘까지의 다우존스 수익률

- 오늘까지의 Log 변동성

-

출력:

- 내일의 거래량 (log scale) 예측값

🖇️ 이 예제의 특징

- 단어 시퀀스 대신 수치형 시계열 데이터

- 과거 데이터가 미래를 설명한다는 시계열의 기본 가정에 기반

- RNN, LSTM 같은 모델을 적용해, 시간에 따른 패턴을 학습할 수 있음

자연어 처리에서 문장이 입력이었다면,

시계열 문제에서는 숫자 흐름 자체가 모델의 입력이 된다!

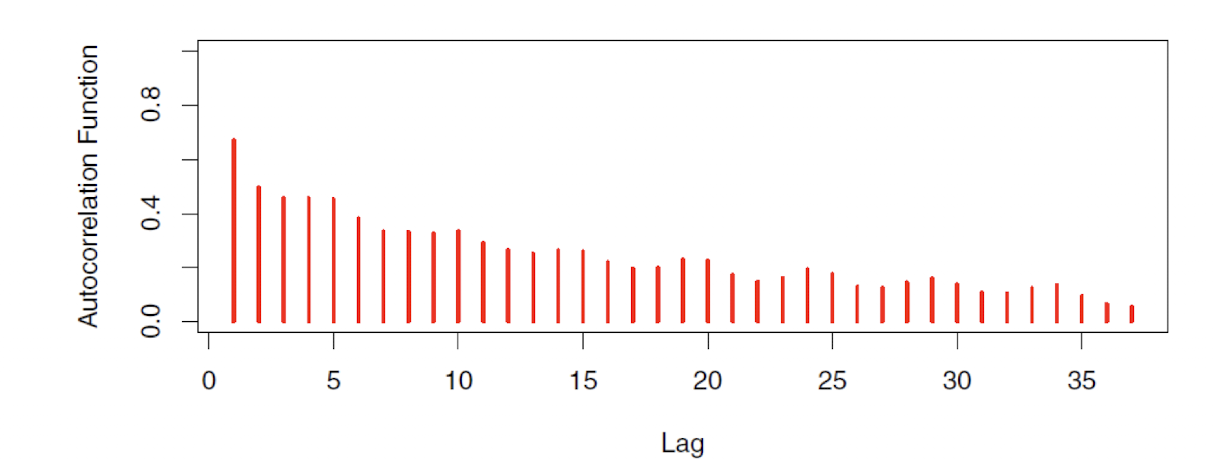

[과거로 갈수록 Correlation이 떨어지는 구조]

시차 에서의 자기사오간은 일 간격을 둔 값 쌍 사이의 상관관계를 의미한다.

이러한 유의미한 자기상관은 과거 값들이 미래 예측에 도움이 될 수 있다는 신뢰를 준다.

이 예측 문제의 흥미로운 점은, 예측하려는 값 자체가 과거 시점에서는 입력 특성으로도 사용된다는 것이다.

RNN Forecaster

🕰️ 단일 시계열로 RNN 학습시키기

IMDB처럼 수만 개의 리뷰가 있는 게 아니라, 하나의 긴 시계열만 있을 땐 RNN을 어떻게 학습시킬 수 있을까?

🖇️ 해결 방법: 미니 시퀀스 추출

- 전체 시계열에서 짧은 구간의 시퀀스(micro-series) 를 여러 개 잘라낸다.

- 각 시퀀스의 길이 을 lag라고 부르며, 다음과 같이 입력 시퀀스를 구성할 수 있다:

- : 로그 거래량

- : 다우존스 수익률

- : 로그 변동성

- 예측 대상 는 다음 날의 거래량

🖇️ 데이터 구성

- 전체 = 6,051일 데이터를 가지고, 라면 총 6,046개의 (X, Y) 쌍을 만들 수 있다.

- 4,281개 → 학습용(train)

- 1,770개 → 테스트용(test)

🖇️ RNN 설정

우리는 lag step마다 은닉 유닛 12개를 갖는 RNN을 구성해 학습을 진행했다.

하나의 시계열이라도 잘게 쪼개면,

수천 개의 훈련 샘플을 만들어 RNN을 학습시킬 수 있다!

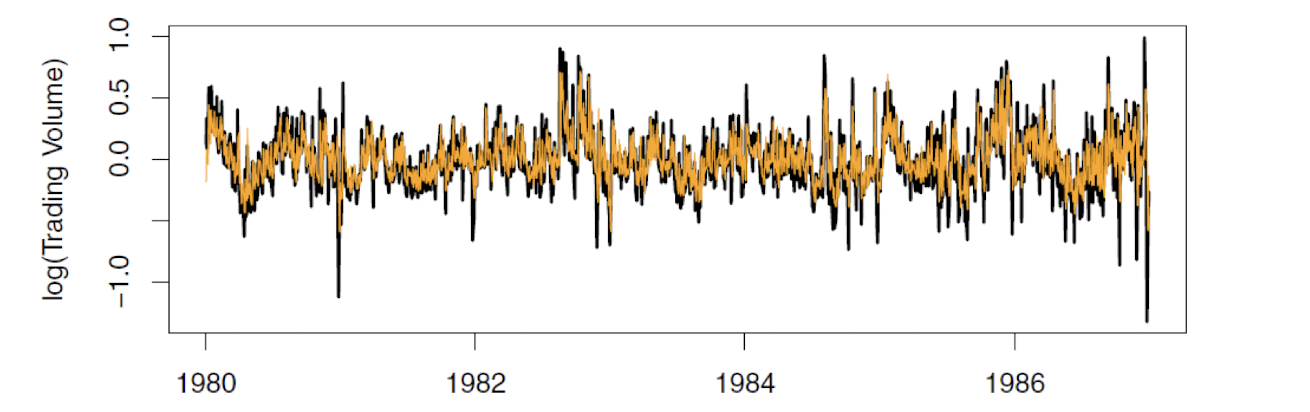

테스트 기간 동안의 예측 결과와 실제 값을 비교해본 결과, RNN이 꽤 괜찮은 성능을 보여줬다.

- RNN의 결정 계수 : → 전체 변동성 중 약 42%를 설명함

- 어제의 거래량 값을 오늘의 예측값으로 그대로 사용하는 단순 모델:

단순한 하루 전 값에만 의존하는 예측보다는,

RNN이 과거 패턴을 학습해서 더 정확한 예측을 제공할 수 있다

자기회귀 예측기 (Autoregression Forecaster)

RNN forecaster는 전통적인 AR (AutoRegrestion) 모델과 구조적으로 비슷하다.

이 행렬 에 대해 OLS (최소제곱) 회귀를 수행하면 다음과 같은 예측식을 얻는다:

→ 이 모델은 차수 의 자기회귀 모델, 즉 AR() 로 불린다.

확장: 다변량 자기회귀

NYSE 데이터에서는 다우존스 수익률과 로그 변동성도 예측에 사용 가능

각각의 지표에 대해 개의 시차값을 사용하면, 총 개의 입력 특성 (3개 변수 × L 시차 + 상수항)

전통적인 AR 모델은 선형 회귀 기반이지만,

RNN은 같은 입력 구조를 사용하면서도 비선형 관계를 학습할 수 있는 유연함이 장점이다.

📌 모델별 비교

| 모델 | ( R^2 ) | 파라미터 수 | 비고 |

|---|---|---|---|

| AR(5) (선형 회귀) | 0.41 | 16개 | 기준 모델 |

| RNN (L=5, K=12) | 0.42 | 205개 | 비선형 구조, 더 많은 파라미터 |

| AR(5) + Neural Net | 0.42 | - | 선형 회귀 대신 비선형 모델로 대체 |

| + 요일 정보(day_of_week) 포함 | 0.46 | 증가됨 | 월요일·금요일 거래량 특성 반영 |

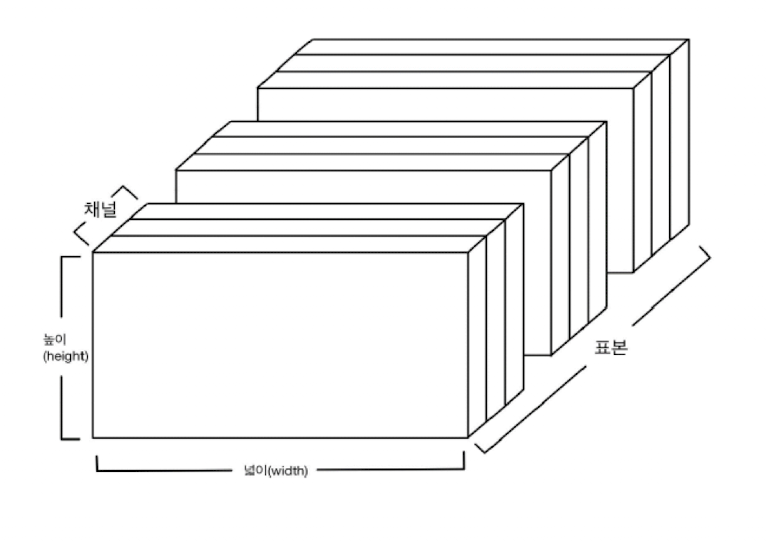

3D Tensor: (#Samples, #Time Steps, #Features)

3D Tensor: (#Samples, #Time Steps, #Features)