- 전체보기(424)

- python(120)

- DL(93)

- ML(57)

- Backend(37)

- sql(34)

- aws(28)

- db(26)

- NLP(26)

- algorithm(21)

- datastructure(19)

- git(18)

- Linear Algebra(16)

- Paper(13)

- LLM(10)

- cs231n(9)

- pandas(8)

- API(5)

- rag(4)

- CS224W(4)

- Q&A(4)

- 회고(3)

- RL(3)

- OpenAI(3)

- math(2)

- numpy(2)

- optimization(2)

- PyTorch(2)

- BEV(2)

- github(2)

- docker(1)

- CV(1)

- linux(1)

- Computer Vision(1)

- Palantir Learning(1)

Git: cannot checkout branch - error: pathspec '...' did not match any file(s) known to git

이 에러는 Git에서 브랜치를 체크아웃할 때 자주 발생하는 문제입니다.출처: https://stackoverflow.com/questions/5989592/git-cannot-checkout-branch-error-pathspec-did-not-match-an

Git 커밋 메시지 작성에 대한 일반적인 규칙과 컨벤션

Git 커밋 메시지 작성에 대한 일반적인 규칙과 컨벤션에 대한 정리입니다.잘 작성된 커밋 메시지는 프로젝트의 히스토리를 깔끔하게 관리하고, 다른 팀원들이 변경 사항을 쉽게 이해하도록 돕는 중요한 역할을 합니다.제목과 본문을 빈 줄로 구분하기첫 줄은 제목(subject)

AWS Lambda 애플리케이션 로그 레벨 설정 방법

이 가이드는 Python Lambda 함수에서 logger를 사용한 로그가 CloudWatch에 보이지 않는 문제를 진단하고 해결하는 전체 과정을 정리한 것입니다.현상: 코드에 logger.info(), logger.debug() 등 로그 출력 구문을 작성했음에도 불구

`psycopg2` 라이브러리의 핵심 개념

Python에서 PostgreSQL 데이터베이스를 다룰 때 널리 쓰이는 라이브러리가 바로 psycopg2입니다.데이터베이스와의 상호작용 과정을 이해하기 쉽게 레스토랑에서 주문하고 식사하는 과정에 비유해 보겠습니다.connect() / conn (연결): 레스토랑에 들어

파이썬 로깅 레벨(Logging Level)

로그의 중요도를 구분하는 등급입니다. 개발자가 프로그램의 실행 상태를 기록할 때, 모든 기록이 다 같은 중요도를 갖지 않습니다. 로깅 레벨을 사용하면 "이 로그는 단순 정보야", "이 로그는 심각한 에러야" 와 같이 각 로그의 성격을 명확히 할 수 있습니다.

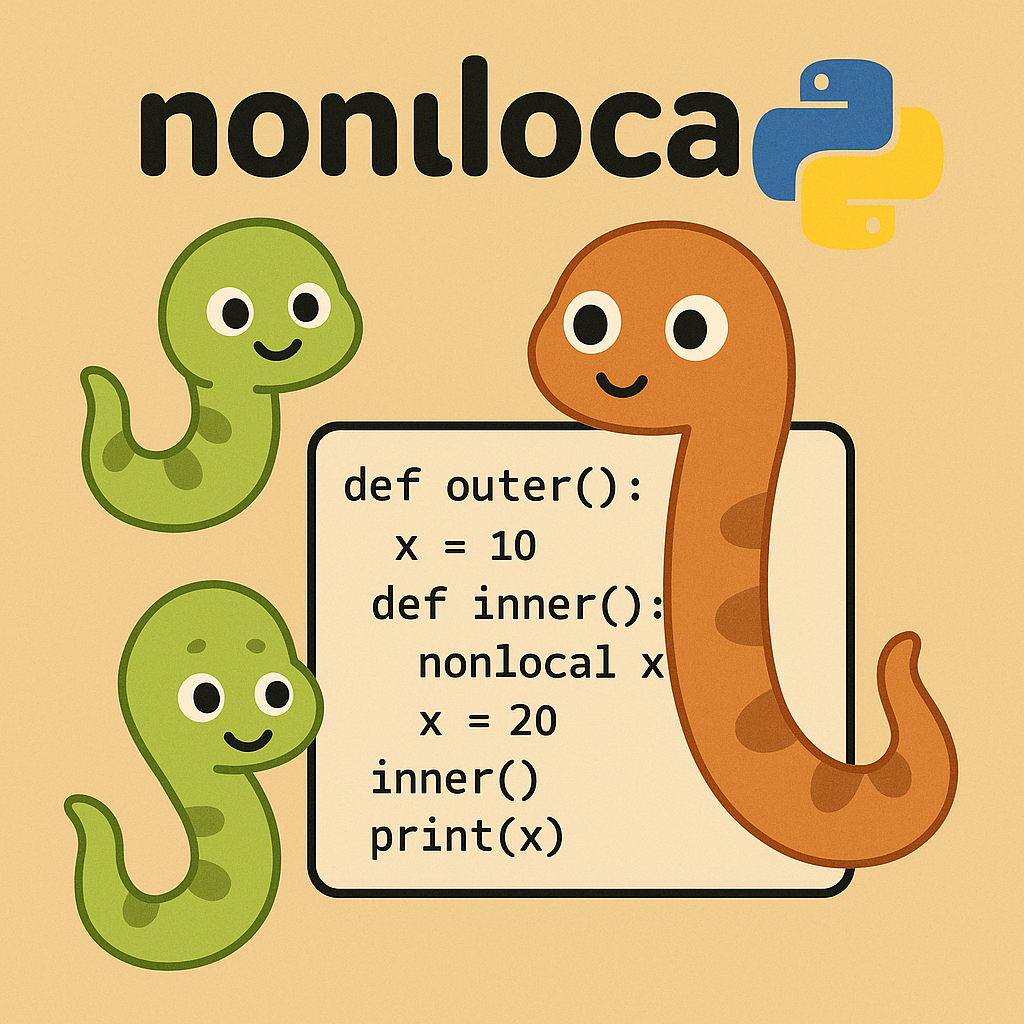

파이썬 nonlocal` 완벽 가이드

프로그래밍의 본질은 '데이터를 효과적으로 관리하고 조작하는 기술'이라고 할 수 있습니다. 이 데이터는 '변수'라는 이름표를 달고 메모리 어딘가에 저장됩니다. 그런데 이 변수들은 프로그램의 아무 곳에서나 마음대로 접근할 수 있는 것이 아닙니다. 모든 변수에는 자신만의 '

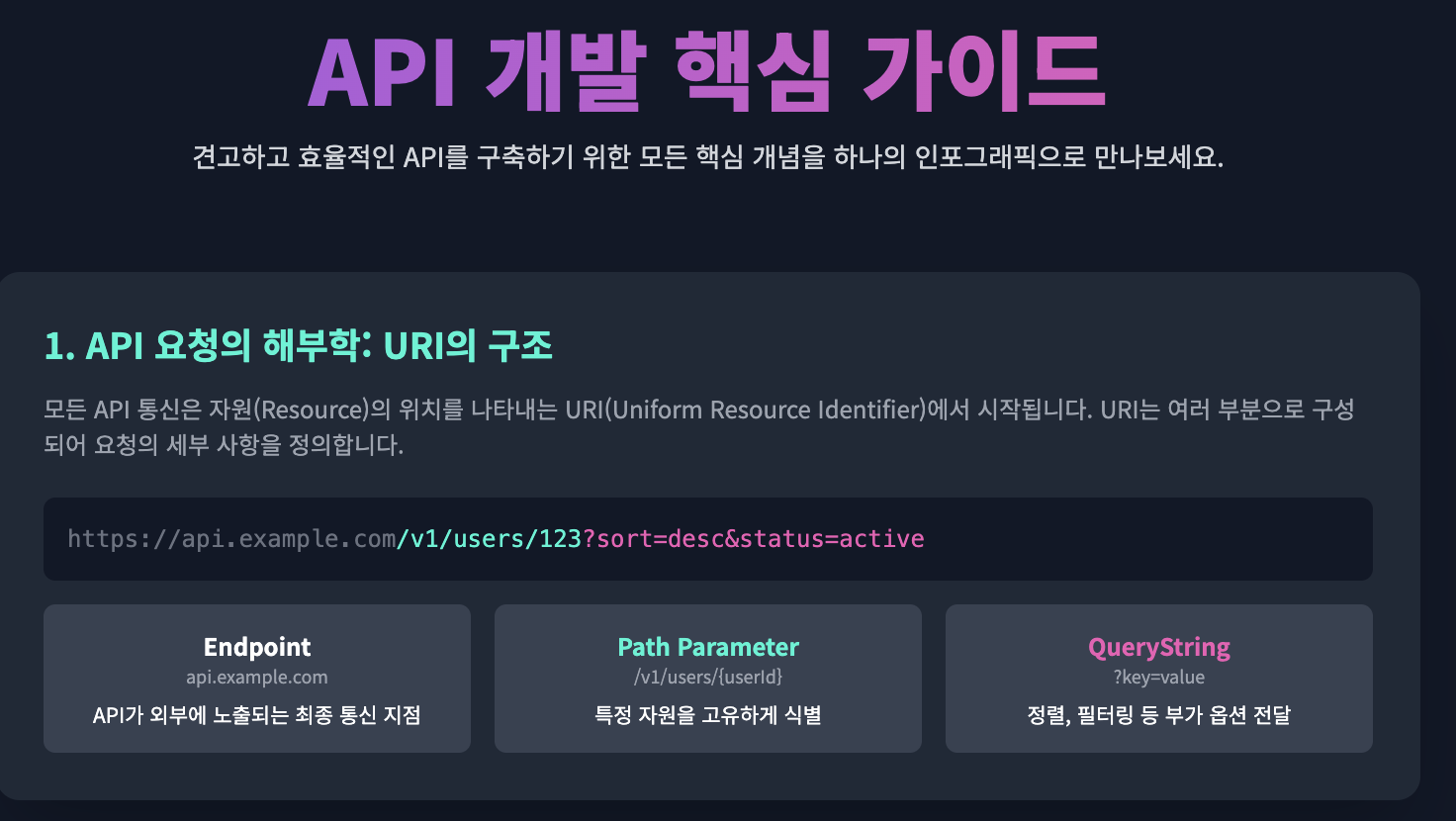

개발자의 나침반: 최신 API 기초 완벽 가이드

오늘날 우리가 사용하는 거의 모든 최신 애플리케이션은 API(Application Programming Interface)에 의해 구동됩니다. 스마트폰의 날씨 앱부터 복잡한 기업용 대시보드에 이르기까지, API는 우리 디지털 세계를 함께 엮는 보이지 않는 실과 같습니다

🔀 Git 브랜치 전략 & 명령어 매뉴얼 총정리

실무에서 바로 쓰는 흐름대로, 개념→명령어→주의점→복구까지 한 번에 정리했습니다.시작 준비 – 사용자 정보, 편집기, 줄바꿈저장소와 원격 – clone, remote, fetch vs pull, tracking브랜치 만들기/이동 – 안전한 파생 규칙하루 업무 흐름(권장

Computer Vision 기본 개념 CLAHE

다리나 건축 구조물의 안전 점검에서는 미세한 균열(crack)을 빠르고 정확하게 찾는 것이 매우 중요합니다.이 작업을 자동화하려면, 사람이 육안으로 보는 것보다 이미지 전처리를 통해 균열을 더 뚜렷하게 드러내야 합니다.이번 글에서는 CLAHE(Contrast Limit

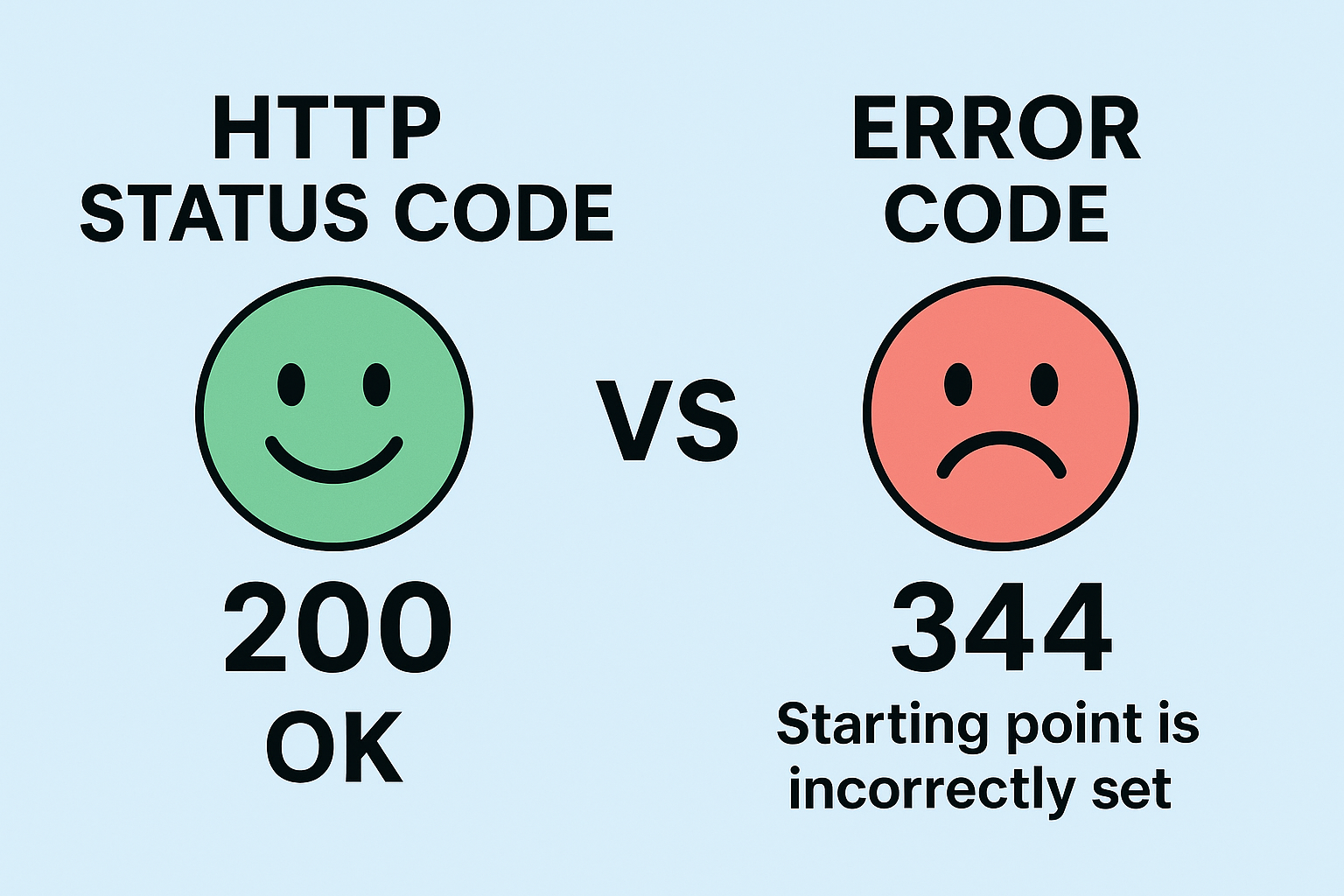

HTTP 상태 코드와 에러 코드: 차이점과 효과적인 설계 방법

API를 설계하다 보면 HTTP 상태 코드와 에러 코드를 혼용하거나, 명확하게 구분하지 않고 사용하는 경우가 종종 있습니다.하지만 이 둘은 역할과 목적이 다르며, 잘 설계하면 디버깅과 유지보수 효율이 크게 올라갑니다.

Python psycopg2.errors 사용법: PostgreSQL 오류 코드보다 편한 예외 처리

Python과 PostgreSQL을 연결하고, 오류까지 똑똑하게 처리하는 방법을 배워봅니다

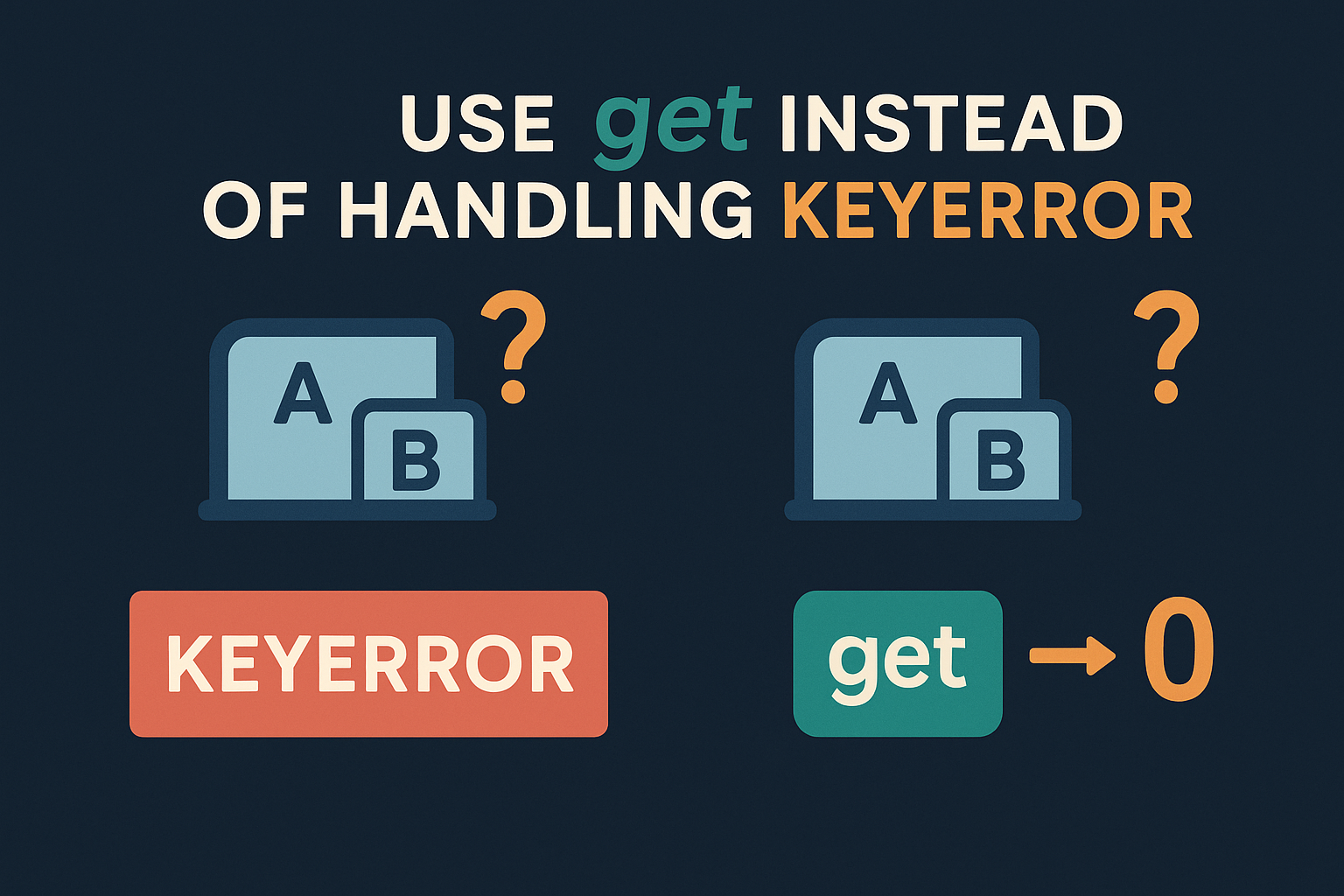

in보다 더 나은 선택: 파이썬 딕셔너리 실전 패턴 모음

딕셔너리에서 키가 존재하지 않을 수 있는 상황을 처리하는 방법은 여러 가지가 있습니다. 각 방법의 장단점을 이해하고 상황에 맞는 최적의 방법을 선택하는 것이 중요합니다.

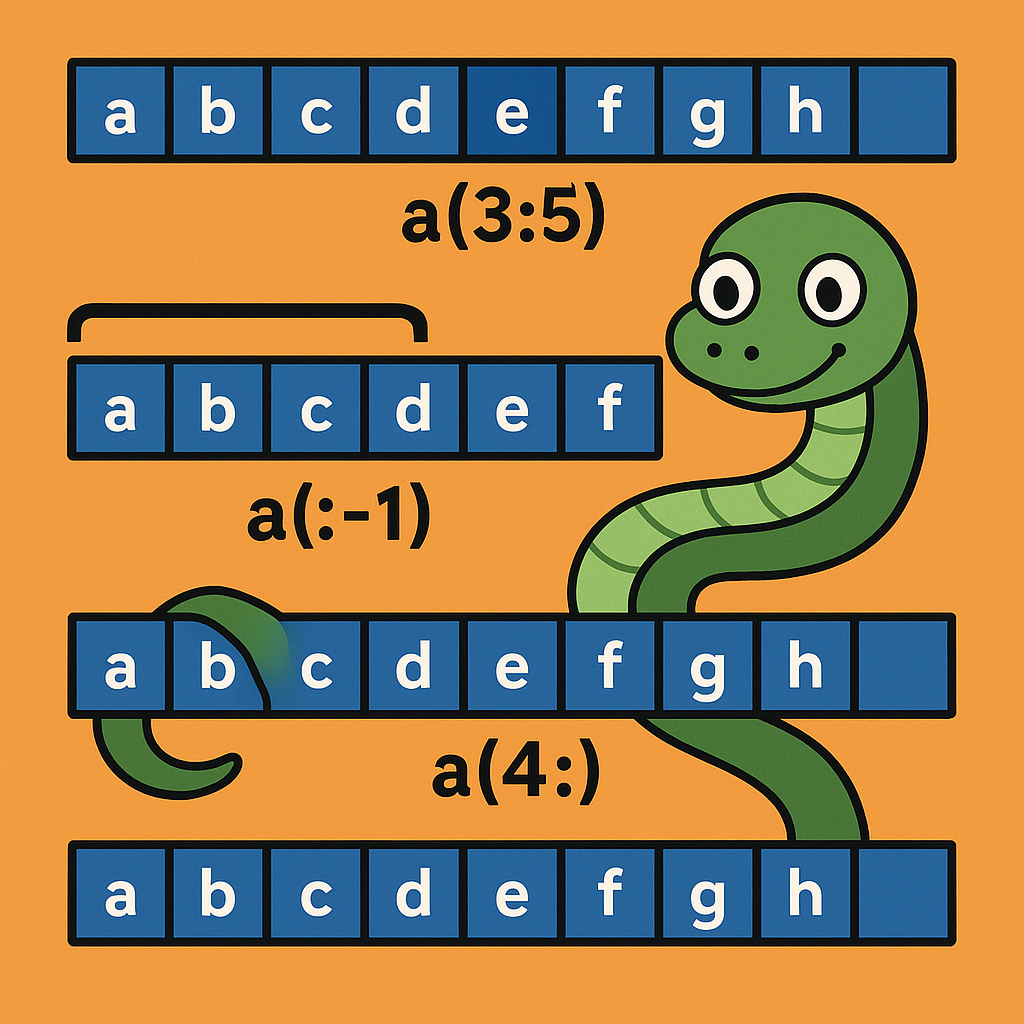

리스트 조작의 핵심 기술, 슬라이싱 제대로 배우기

파이썬의 슬라이싱은 시퀀스(리스트, 튜플, 문자열 등)의 일부를 효율적으로 가져오거나 수정할 수 있는 강력한 기능입니다. 하지만 제대로 이해하지 못하면 혼란스럽고 버그를 만들어낼 수 있습니다.

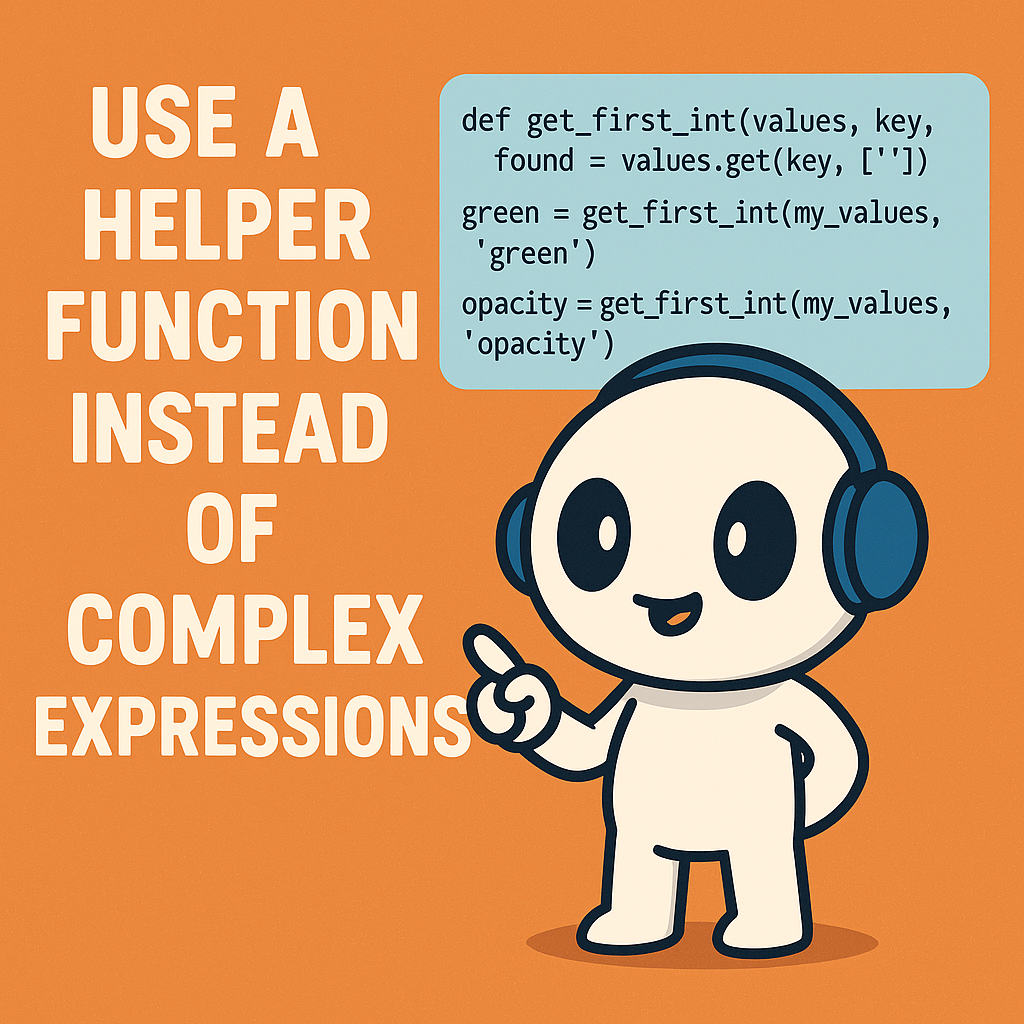

파이썬에서 복잡한 식 대신 도우미 함수를 쓰는 이유

한 줄로 복잡한 로직을 표현하려는 시도는 종종 가독성을 해치고, 잠재적인 버그를 만들어내기 쉽습니다. 이럴 때 잘 명명된 도우미 함수(Helper Function)를 사용하는 것이 훨씬 효과적입니다.

Postman 테스트 스크립트 개념 및 활용 정리

즉, 스크립트를 작성하면 → 수동 확인 없이 자동으로 Pass/Fail이 판단되어 테스트 품질이 향상됨.수동으로 할 경우, 시간이 오래 걸리며, 테스트 결과 기록이 남지 않는다는 단점이 있다. 예시로 403 응답이 맞는지, 메시지에 "어노테이션"이 들어있는지 직접 확인

🐍 파이썬에서 assert vs raise 완벽 가이드

이 글에서는 assert와 raise의 차이, 상황별 사용법, 그리고 실전 예제를 통해 개념을 정리합니다.

🐍 파이썬에서 __repr__과 eval(repr(obj)) 관계 완벽 이해하기

이 글에서는 __repr__의 역할, eval(repr(obj))의 의미, 그리고 두 개념의 관계를 상세히 설명합니다.

🐍 파이썬에서 isinstance vs issubclass 완벽 가이드

이 글에서는 isinstance와 issubclass의 함수의 차이, 사용법, 비교를 초보자도 이해할 수 있도록 설명하였습니다.

logging보다 직관적인 디버깅? repr로 해결!

아래는 「파이썬 코딩의 기술 (Effective Python)」 2판의 아이템 75 "디버깅 출력에는 repr 문자열을 사용하라" 내용을 초보자도 쉽게 이해할 수 있도록 개념 → 코드 분석 → logging과의 차이 → 정리 순으로 꼼꼼하게 설명한 정리입니다.