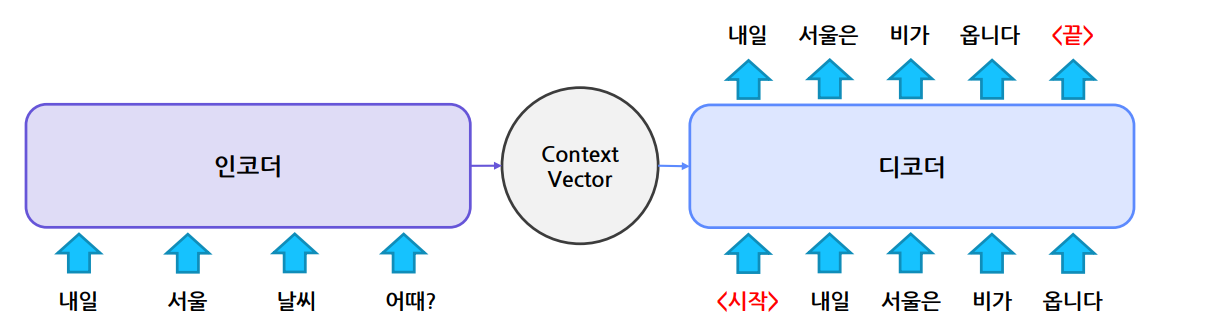

N2M

N개의 데이터를 입력으로 받아 M개의 데이터를 출력하는 task

Encoder + Decoder 모델이 주로 활용

Encoder

입력 정보를 잘 encoding(수치화) 하기 위해 활용

긴 sequence 정보를 잘 추출하는 것이 중요

Decoder

encoding된 정보를 활용해 출력 sequence를 순차적으로 생성

encoding된 정보와 앞서 생성된 토큰을 함께 활용해 다음 토큰 생성

- 번역, 품사 태깅, 질의응답, 이미지 태깅 등 문제에 활용

Encoder-Decoder Model

-

Encoder-Decoder RNN

-

LSTM이 주로 사용

-

데이터가 길어지면 성능 하락

-

-

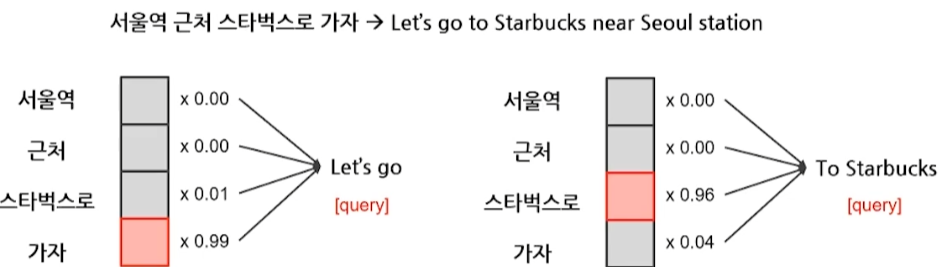

Attention

- 입력 정보에 가중치 적용해 정보를 취사선택

- Transformers

Transformers

Attention만으로 구현된 Encoder-Decoder 모델

모델 종류

-

Encoder Only : BERT, ALBERT, ROBERTa, ELECTRA

-

Decoder Only : GPT-1, 2, 3

-

Encoder-Decoder : T5, BART

Encoder Only

-

정보를 양방향으로 취합

-

분류 문제에 주로 활용

-

모델 학습 방법

-

Masked Language Model (MLM)

-

Next Sentence Prediction (NSP)

-

Decoder Only

-

정보를 단방향으로 취합

-

생성 문제에 주로 활용

-

모델 학습 방법

- Auto-regression : 생성한 단어를 다시 입력으로 사용해 모든 단어를 순서대로 예측

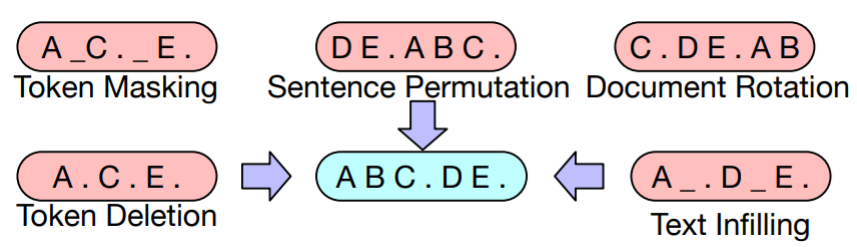

Encoder-Decoder

- BART : BERT + GPT 결합

원래 문장을 복원하도록 학습- T5 : 모든 입출력을 text로 구성하여 학습

Encoder-Decoder 동작 과정

Transformer의 동작 과정과 동일

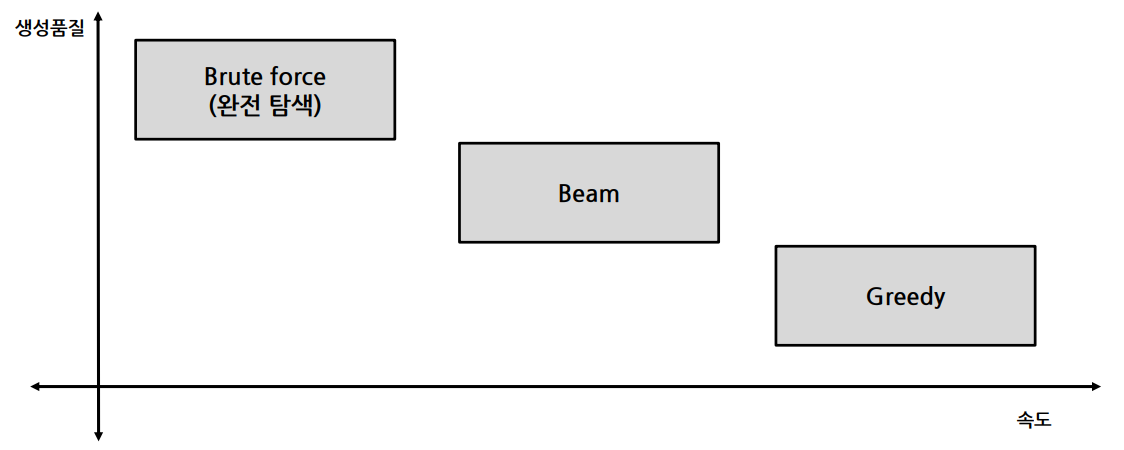

Decoding 방법

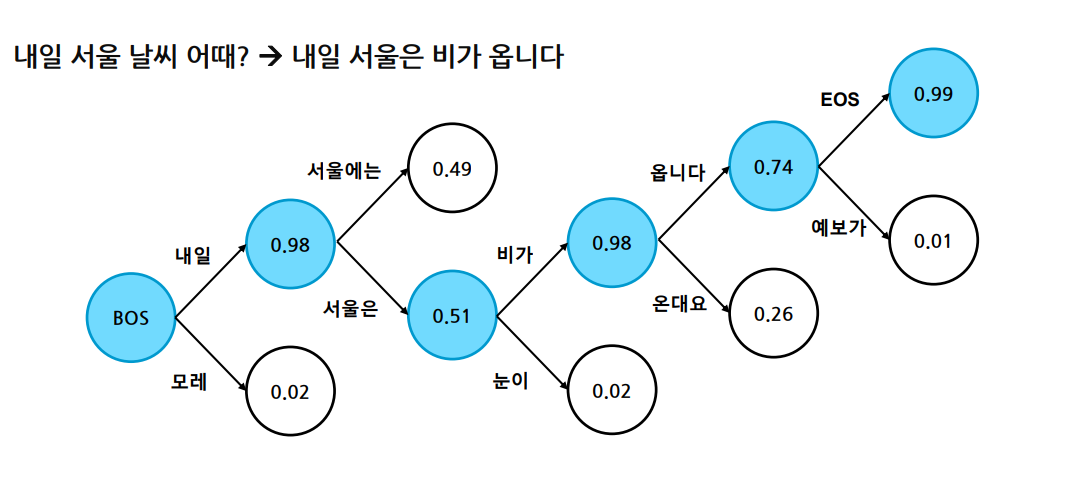

Greedy

- 매 순간 가장 확률이 높은 것 선택

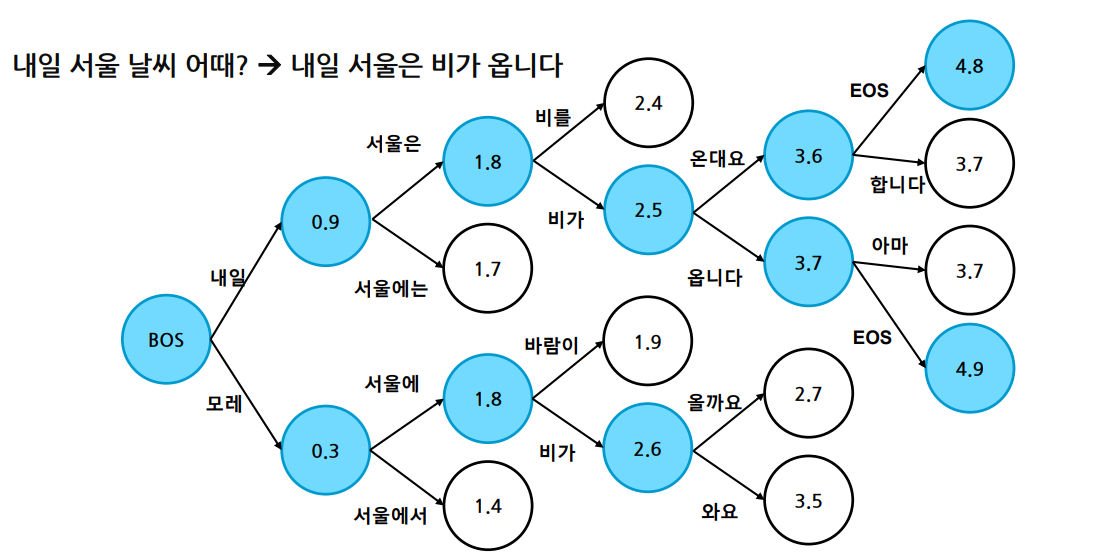

Beam Search

- K개의 candidate을 고려해서 가장 확률이 좋은 것을 탐색

※ 모든 이미지 및 코드 출처는 네이버 커넥트재단 부스트캠프 AI Tech 5기입니다. ※