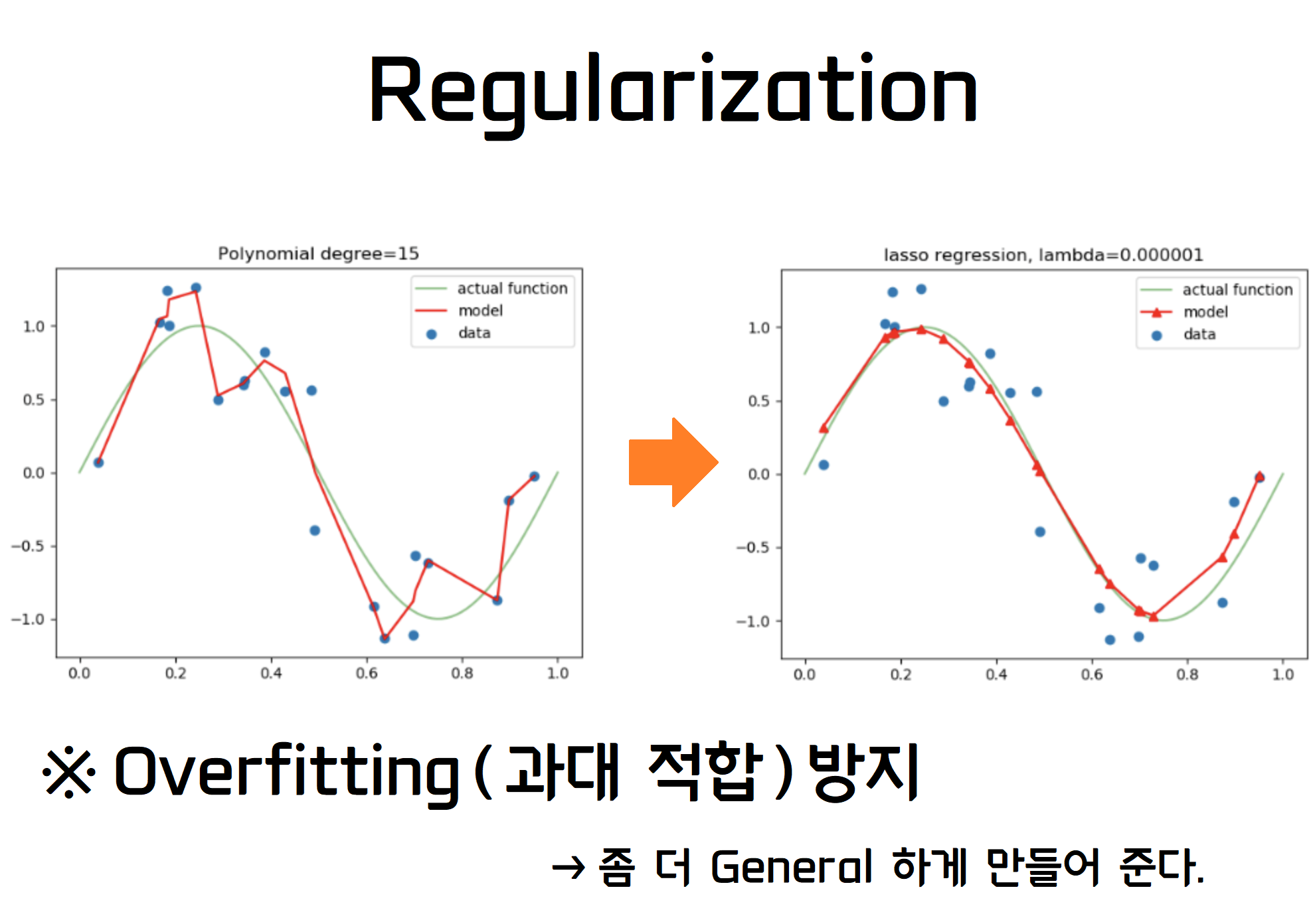

Regularization (정규화)

모델 복잡도에 대한 패널티로, 정규화는 Overfitting (과대 적합)을 예방하고 Generalization (일반화) 성능을 높이는데 도움을 준다.

가중치가 큰 값을 가진다는 것 (과대 적합, Overfitting) 은 모델의 일반화 성능이 떨어진다는 것을 의미.

학습데이터에 대한 설명력을 다소 포기하는 대신 미래 데이터 변화에 상대적으로 안정적인 결과를 낸다.

<종류>

L1 Regularization, L2 Regularization, Dropout, Early stopping 등

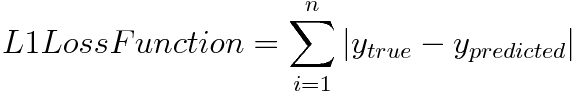

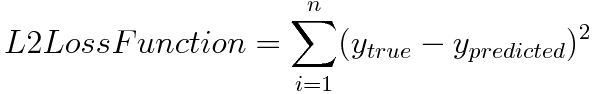

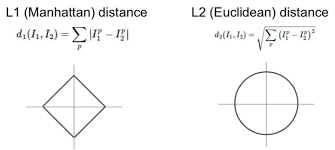

L1 norm , L2 norm의 컨셉을 가져와 학습에 영향을 미치는 cost function을 조정한다.

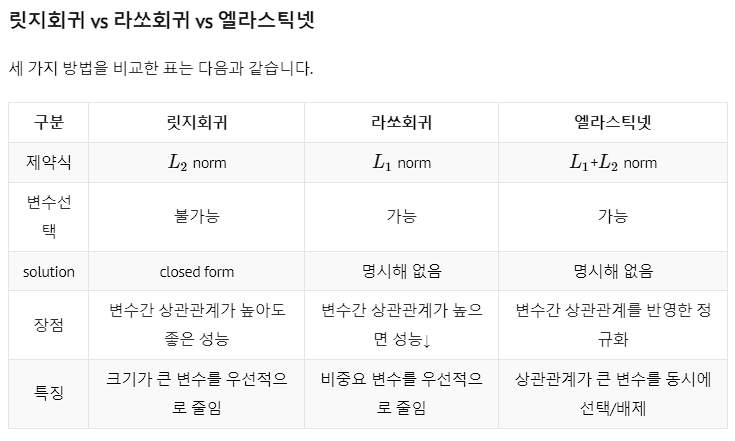

L1 Regularization - Rasso

라쏘회귀는 예측에 중요하지 않은 변수의 회귀계수를 감소시킴으로써 변수선택(Feature Selection)하는 효과를 낸다.

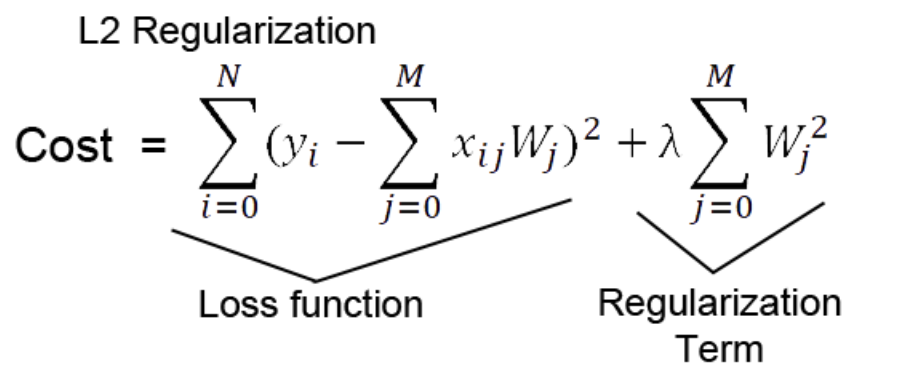

L2 Regularization - Ridge

기존의 cost function 에 가중치의 제곱을 포함하여 더함으로써, L1 Regularization 과 마찬가지로 가중치가 너무 크지 않은 방향으로 학습되게 된다. 이를 Weight decay 라고도 한다.

L1 Reg vs L2 Reg

-

L1 Reg을 사용하는 선형 회귀 모델을 Lasso model

-

L2 Reg을 사용하는 선형 회귀 모델을 Ridge model

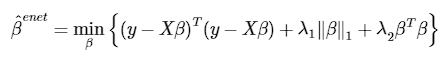

※ L1 Reg과 L2 Reg을 둘 다 사용 하는 모델인 Elastic Net model

L2 Norm 은 각각의 벡터에 대해 항상 Unique 한 값을 내지만, L1 Norm 은 경우에 따라 특정 Feature(벡터의 요소) 없이도 같은 값을 낼 수 있다.

Ref )

https://junklee.tistory.com/29

https://wooono.tistory.com/221

https://huidea.tistory.com/154

https://seongkyun.github.io/study/2019/04/18/l1_l2/

https://velog.io/@lswkim/L1-L2-%EC%A0%95%EA%B7%9C%ED%99%94%EC%97%90-%EB%8C%80%ED%95%B4-%EC%84%A4%EB%AA%85%ED%95%B4%EC%A3%BC%EC%84%B8%EC%9A%94

https://otugi.tistory.com/121

https://blog.pabii.co.kr/l1-l2-regularization-intuitive-understanding/

https://ratsgo.github.io/machine%20learning/2017/05/22/RLR/

https://light-tree.tistory.com/125