Feature Scaling

Feature들의 크기, 범위를 정규화시켜주는 것

좋은 성능을 얻으려면 매개변수(Hyper-Parameter)인 C와 gamma를 잘 조정해줘야 한다.

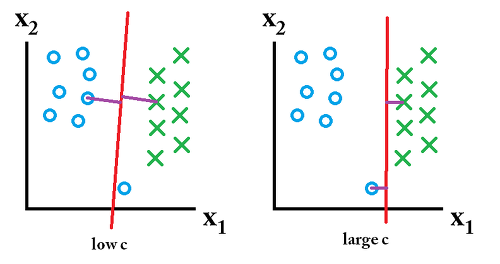

- C : 데이터 샘플들이 다른 클래스에 놓이는 것을 허용하는 정도를 결정.

- C는 얼마나 많은 데이터 샘플이 다른 클래스에 놓이는 것을 허용하는지를 결정.

→ C가 커질수록 이상치의 존재 가능성을 낮게 본다.

- gamma : 결정 경계의 곡률을 결정

두 값 모두 커질수록 알고리즘의 복잡도는 증가하고, 작아질수록 복잡도는 낮아진다.

- gamma는 하나의 데이터 샘플이 영향력을 행사하는 거리를 결정.

→ gamma가 클수록 한 데이터 포인터들이 영향력을 행사하는 거리가 짧아지는 반면, gamma가 낮을수록 커진다.

※ 매개변수 C와 마찬가지로 gamma가 너무 낮으면 과소적합될 가능성이 크고, 너무 높으면 과대적합의 위험.

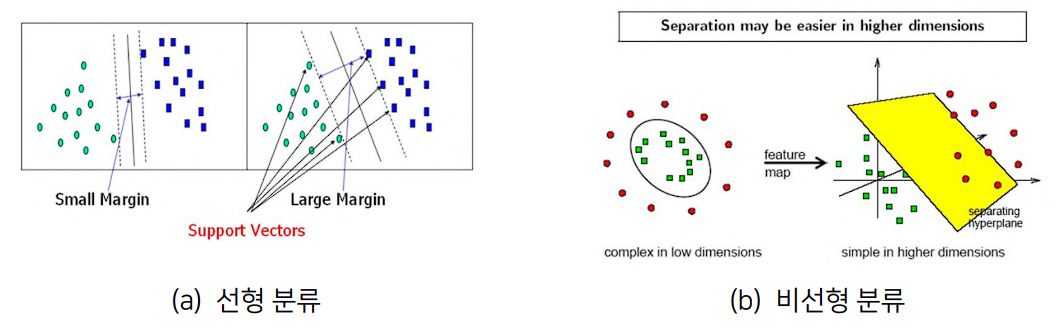

Linear SVM

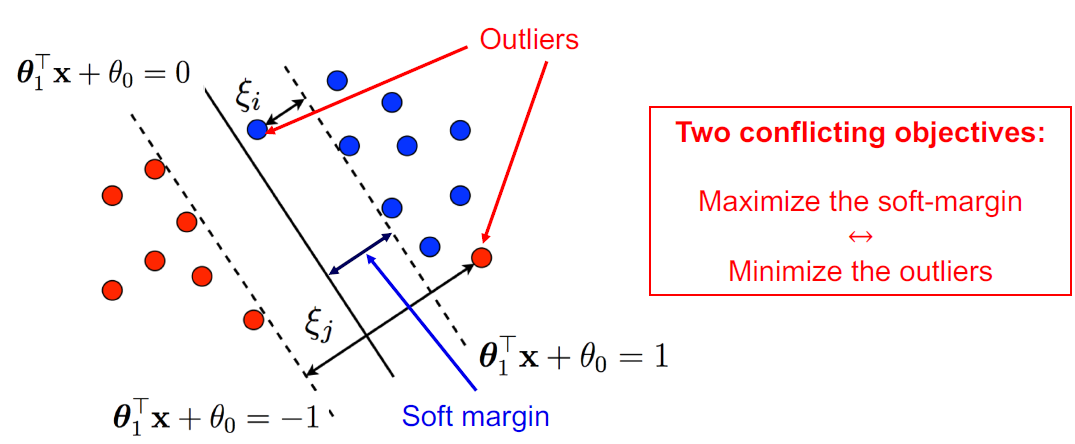

- 최대 마진 분류기(Max-margin classifier) : 하드 마진(hard margin)

- 서포트 벡터 분류기(Support Vector Classifier, SVC) : 소프트 마진(soft margin)

C의 유무에 따라 하드마진(hard-margin) SVM, 소프트마진(soft-margin) SVM 으로 나뉜다.

C가 너무 낮으면 과소적합(underfitting)이 될 가능성이 커지고, C가 너무 높으면 과대적합(overfitting)이 될 가능성이 커지니, 적합한 C값을 찾아내는 것이 중요하다.

※ soft margin을 최대화 하는 것과 outlier를 최소화 하는 것은 tradeoff관계이며, C를 통하여 margin과 error의 trade-off를 조절한다.

Non-Linear SVM

- 커널 SVM

커널 서포트 벡터 머신 (Kernel Support Vector Machine, Kernel SVM)

서포트 벡터 분류기에서 확장된, 비선형의 클래스 경계를 수용하는 분류 방법.

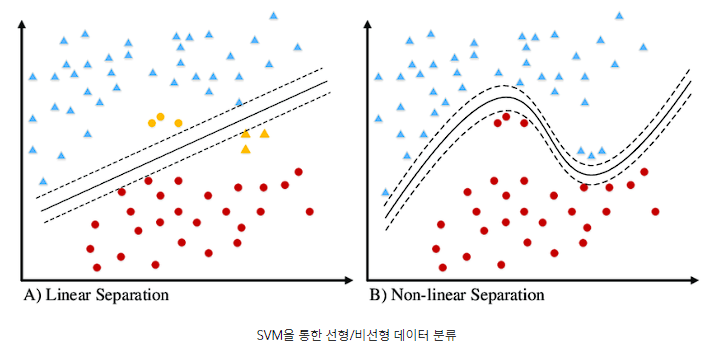

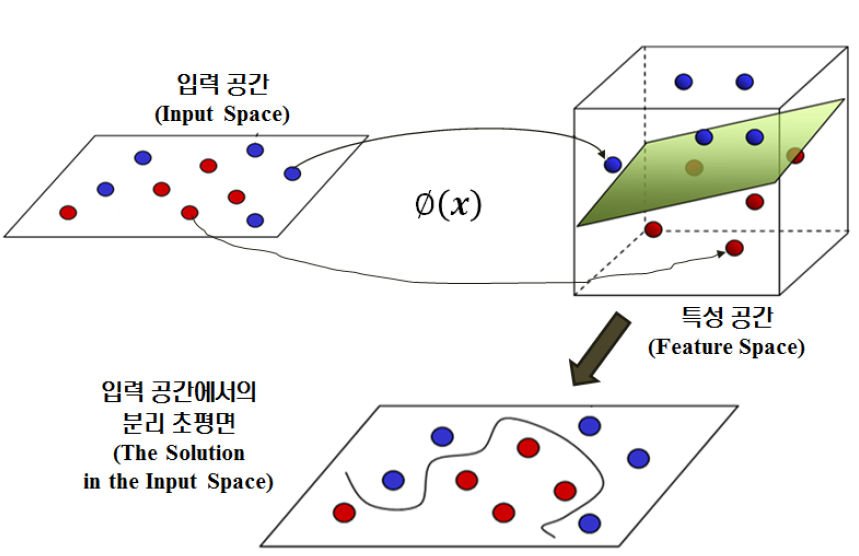

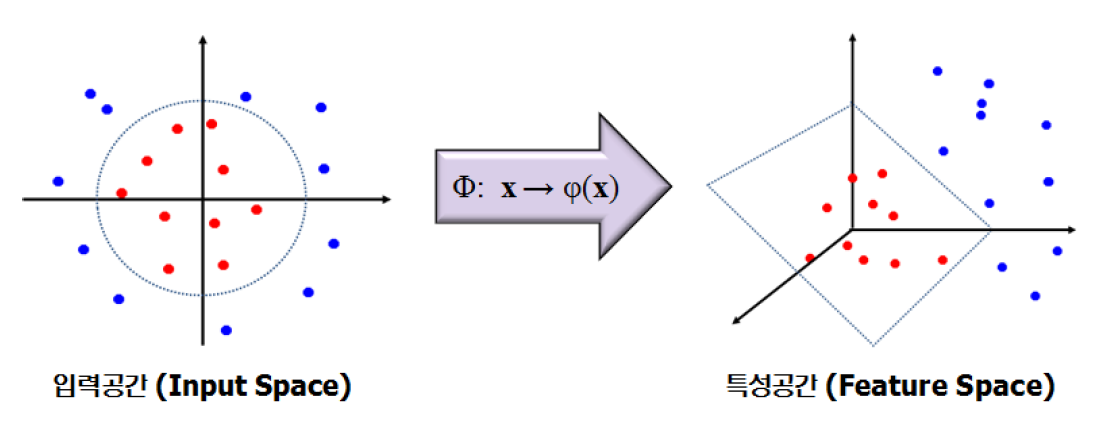

즉, 아래 그림과 같이 decision boundary가 비선형일 경우에 선형분류기를 비선형 구조로 변경해서 관측값들을 분류하기 위해 사용하는 방법.

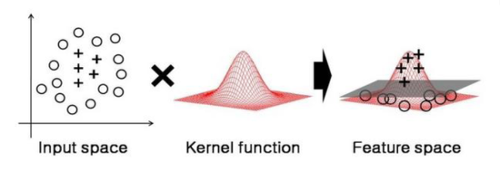

Kernel Function

클래스들 사이의 비선형 경계를 수용하기 위해 변수 공간을 확장하고자 할 때 사용하는 계산기법으로, 저차원 공간을 고차원 공간으로 매핑시켜주는 작업.

( 커널 함수를 적용 후, 선형적으로 분류할 수 있는 결정 경계를 찾을 수 있게 됨. )

( 커널 함수를 적용 후, 선형적으로 분류할 수 있는 결정 경계를 찾을 수 있게 됨. )

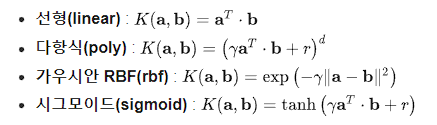

커널에는 Polynomial 커널, Sigmoid 커널, 가우시안 RBF 커널 등 종류가 많은데, 그 중 가장 성능이 좋아 자주 사용되는 것이 가우시안 RBF 커널이다.