Today I Learned

오늘은 확률론 공부!

확률론

딥러닝에서 확률론이 필요한 이유

-

딥러닝이 확률론 기반의 기계학습이론에 바탕을 두고 있기 때문.

-

기계학습에서 사용되는 손실함수(loss function)의 작동 원리는 데이터 공간을 통계적으로 해석해서 유도

-

회귀분석에서 손실함수로 사용되는 L2-노름은 예측오차의 분산을 최소화하는 방향으로 학습

-

분류문제에서 사용되는 교차엔트로피(cross-entropy)는 모델예측의 불확실성을 최소화하는 방향으로 학습

확률변수

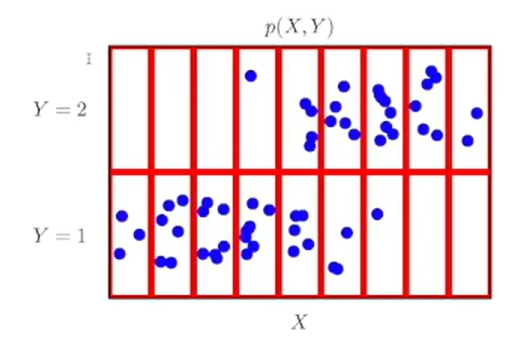

- 파란 점이 데이터 공간 상에서 관측한 데이터. 데이터 추출 시 확률변수 사용

확률분포 D

-

이 확률변수를 추출한 데이터의 분포 즉,

확률분포를 D라고 한다.

확률 분포는 확률 변수가 취할 수 있는 값들과 그 값들이 일어날 확률을 정의하는 함수다. -

(x,y) ~ D

데이터 공간을 x * y로 표기하고 D는 데이터 공간에서 데이터를 추출하는 분포

데이터는 확률 변수로 (x,y) ~ D로 표기한다.

x와 y라는 두 확률 변수가 어떤 특정한 분포 D를 따르며, 이 분포가 x와 y의 값들과 그들 간의 관계를 결정한다는 뜻이다.

확률변수의 종류

- 확률변수는 확률분포 D에 따라

이산형(discrete)과연속형(continuous) 확률변수로 구분한다. 이는 데이터 공간 x * y가 아니라 D에 의해 결정된다.

-

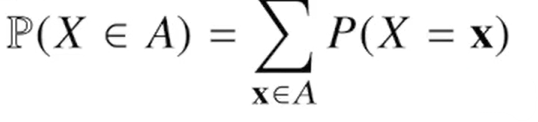

이산형 확률변수는 확률변수가 가질 수 있는 경우의 수를 모두 고려해 확률을 더해서 모델링한다. P(X=x)는 확률변수가 x값을 가질 확률을 의미한다.

-

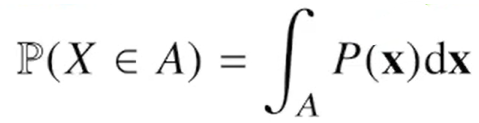

연속형 확률변수는 값이 특정 구간 내의 모든 실수 값을 가질 수 있는 확률변수다. 데이터 공간에 정의된 확률 변수의 밀도(density)위에 적분을 통해 모델링한다. 밀도함수 P(x)는 누적 확률 분포의 변화율이지 확률로 해석하면 안된다.

-

결합분포(두 개 이상의 확률변수에 대한 분포) P(x,y)는 D를 모델링한다.

-

원래 확률 변수의 분포 D와 상관없이 결합 분포는 이산형이든 연속형이든 모델링 방법에 따라 결정할 수 있다.

-

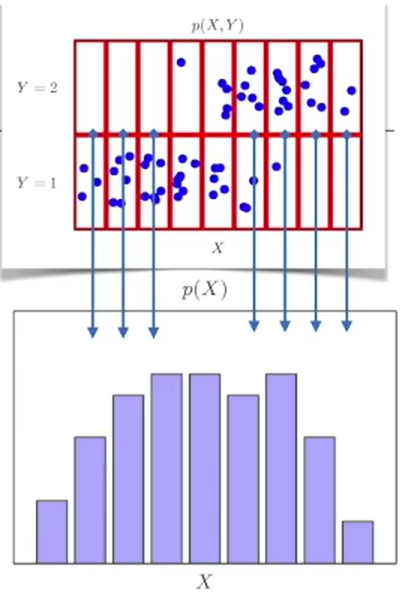

P(x)는 입력 x에 대한 주변 확률 분포로 y에대한 정보는 없다. 각 x칸마다 파란 점의 개수를 센 것이기 때문이다.(y=1,2 구분않고 센다.)

조건부 확률

-

조건부확률분포 P(x|y)는 데이터공간에서 입력 x와 출력 y 사이 관계를 모델링한다. (y가 특정 조건일때 x의 확률)

-

조건부확률 P(y|x)는 입력변수 x에 대해 정답이 y일 확률을 의미한다.

-

로지스틱 회귀에서 사용했던 선형모델과 소프트맥스 함수의 결합은 데이터에서 추출된 패턴을 기반으로 확률을 해석하는데 사용된다.

-

분류 문제에서 softmax는 데이터 x로부터 추출된 특징패턴과 가중치행렬 W을 통해 조건부 확률 P(y|x)을 계산한다.

-

회귀문제에서는 조건부 확률이 아니라 조건부기대값 E[y|x]을 추정한다.

조건부기대값은 L2-노른을 최소화하는 함수 f(x)와 일치한다.

기대값

-

데이터를 대표하는 통계량.(평균보다 좀 더 넓은 개념)

-

확률분포를 통해 다른 통계적 범함수(statistical functional)를 계산하는 데 사용된다.

-

연속확률분포는 적분을, 이산확률분포는 급수를 사용해 계산한다.

-

기대값을 이용해 분산, 첨도, 공분산 등 여러 통계량을 계산할 수 있다.

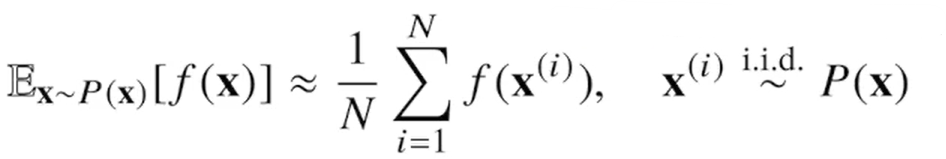

몬테카를로 샘플링

-

기계학습의 많은 문제들은 확률분포를 명시적으로 모를 때가 대부분인데, 이때 데이터를 이용해 기대값을 계산하려면 몬테카를로 샘플링을 사용해야 한다.

-

이 방법은 이산형, 연속형 상관없이 성립한다.

-

몬테카를로 방법은 랜덤 샘플링을 이용해 수치적 결과를 얻는 방법이다.

-

이 방법은 샘플링 과정에서

독립추출만 보장된다면 대수의 법칙에 의해 수렴성을 보장한다. -

타겟 f(x)의 x자리에 샘플링한 데이터를 대입하고, 데이터들의 산술평균을 구하면 이 값이 구하고자 하는 기대값과 근사하게 된다.

본 포스트의 학습 내용은 부스트클래스 <AI 엔지니어 기초 다지기 : 부스트캠프 AI Tech 준비과정> 강의 내용을 바탕으로 작성되었습니다.