DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning technical report 훑어보기

- technical report 링크 : DeepSeek-R1 paper

- 허깅페이스 링크 : deepseek-ai/DeepSeek-R1

- 깃허브 링크 : Git

요즘 중국이 ai 강세로 떠오르고 있는데, 그 주역 중 하나인 DeepSeek에서 최근 DeepSeek LLM에 강화학습을 곁들인 R1 모델이 소개되었다고 해서 technical report를 살짝 맛보기로 한다.

DeepSeek-R1 1분 요약

-

DeepSeek-R1-Zero

: 강화학습만을 활용한 순수 학습(기존의 supervised finetuning을 생략)추론능력이 자동으로 발전하여 강력한 CoT 추론 능력을 보임

문제점 : 가독성이 떨어지는 출력 형식과 다국어 혼합 문제 발생

-

DeepSeek-R1

: 멀티스테이지 학습 : 초기 단계에서 소량의 고품질 데이터를 사용하여 cold-start를 수행한 후, 반복적인 강화학습과 supervised finetuning(SFT)를 통하여 모델 성능 극대화수학, 코딩, 과학 추론 등에서 Openai o1-1217 모델에 필적함

인간 친화적 출력형식으로 사용자 경험 개선

-

Distillation을 통한 소형 모델 개발

: DeepSeek-R1의 대규모 모델에서 얻은 추론 패턴을 소형 모델(Qwen, Llama)에 증류하여 높은 성능 달성(1.5B, 7B, 14B, 32B, 70B 모델이 다양한 벤치마크에서 좋은 결과를 기록)

1. Introduction

최근 LLM의 빠른 발전은 AGI에 점점 가까워지고 있다. 특히 post-training은 모델의 추론능력을 향상시키고 사용자 선호도와 사회적 가치에 부합하도록 조정하면서도 pre-training에 비해 적은 계산 자원을 요구한다.

OpenAI의 o1 시리즈 모델은 Chain-of-Thought (CoT) 방식을 활용하여 수학, 코딩, 과학적 추론과 같은 다양한 추론 작업에서 큰 성과를 보여주었지만, 테스트 시의 확장성 문제는 여전히 해결 과제로 남아 있다.

이 논문은 다음 두 가지 목표를 중심으로 강화학습(RL)을 통해 LLM의 추론 능력을 개선하고자 한다.

- 지도학습(Supervised finetuning, SFT) 데이터를 사용하지 않고 순수 강화학습만으로 모델을 학습시켜 추론 능력을 향상시키는 가능성 탐구

- 자체 학습(Self-evolution) 과정을 통해 모델이 점진적으로 복잡한 추론 작업을 해결하는 능력 개발

위 목표 달성을 위해, DeepSeek-V3-Base 모델을 기반으로 GRPO(Group Relative Policy Optimization) 알고리즘을 사용하여 DeepSeek-R1-Zero를 개발했다. 해당 모델은 다음의 성과를 보여준다.

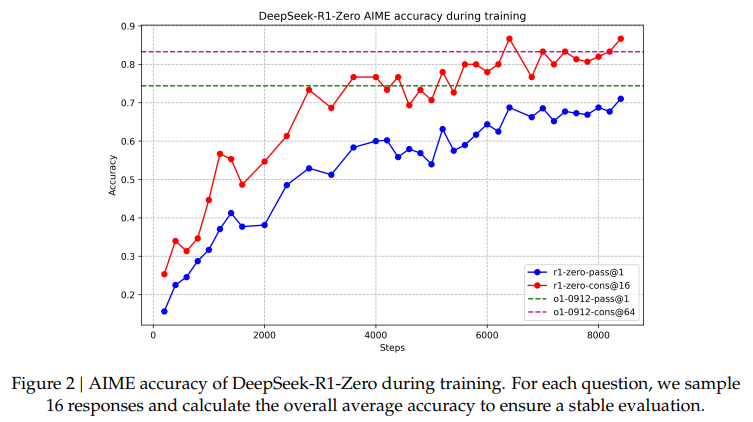

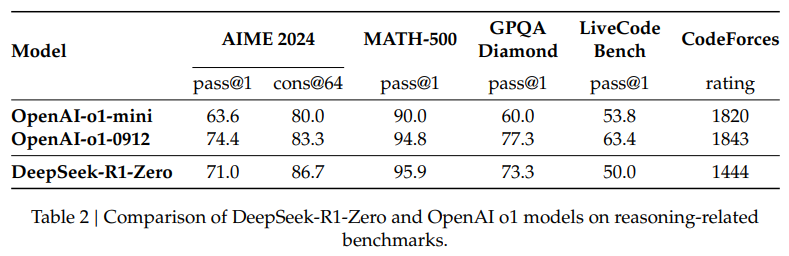

- AIME 2024 벤치마크에서 pass@1 score를 15.6%에서 71.0%로 향상

- Majority voting을 통해 86.7%까지 성능을 개선하며 OpenAI-o1-0912와 유사한 성능 달성

그러나 DeepSeek-R1-Zero는 출력형식의 가독성이 떨어지고, 다국어가 혼합되는 문제를 겪는다. 이를 위해 DeepSeek-R1에서는

- 초기 단계에서 고품질 데이터로 콜드 스타트(Cold Start)를 수행

- 다단계 학습 파이프라인을 통해 추론 능력을 더욱 강화

결과적으로, DeepSeek-R1은 OpenAI-o1-1217 수준의 성능을 달성하였으며, 이 연구는 순수 RL을 통한 LLM 추론 능력 강화의 가능성을 입증했다.

2. Approach

기존 연구는 대량의 지도 학습 데이터에 의존했지만, 이 논문은 순수 강화학습을 사용하여 지도 학습 없이도 모델의 추론 능력을 크게 향상시킬 수 있음을 입증한다.

DeepSeek-R1-Zero : Reinforcement Learning on the Base Model

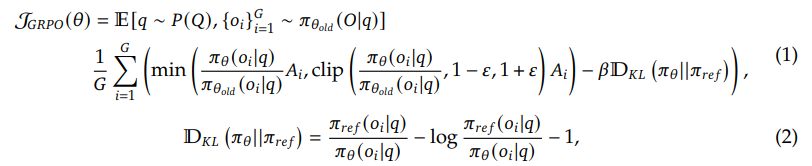

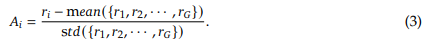

- Reinforcement Learning Algorithm

Group Relative Policy Optimization (GRPO): 일반적인 RL 알고리즘과 달리 비판자(critic) 모델 없이 그룹별 점수 기반으로 최적화하여 계산 비용 절감, 모델 출력의 advantage()를 계산하여 업데이트, 정확도와 clipping 기반으로 정책 최적화

- Reward Modeling

Accuracy rewards: 답변이 정확할 경우 점수를 부여Format rewards: 출력이 지정된 형식(CoT 태그)을 따를 경우 점수를 부여 신경망 기반 보상 모델은 "Reward Hacking" 문제를 피하기 위해 사용하지 않음

- Training Template 학습 템플릿을 다음과 같이 간단한 구조로 설정 :

<think>태그 안에 추론 과정을 기술하고,<answer>태그에 최종 답안을 제공

구조적 형식만 강제하고, 특정 내용이나 문제 해결 전략에는 영향을 미치지 않음

- Performance, Self-evolution Process and Aha Moment of DeepSeek-R1-Zero

-

Performance of DeepSeek-R1-Zero

- RL 과정을 통해 DeepSeek-R1-Zero는 시간이 지남에 따라 성능이 꾸준히 향상

-

AIME 2024 avg Pass@1 score 15.6% → 71.0%로 증가 (OpenAI-o1-0912과 유사한 성능)

-

Majority voting 사용 시 86.7%까지 성능 상승

-

다양한 추론 관련 벤치마크에서 OpenAI-o1-mini를 능가하는 성과 기록

-

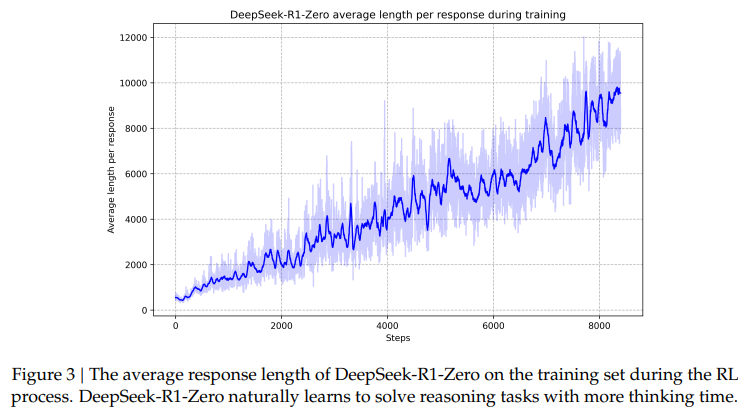

Self-evolution Process of DeepSeek-R1-Zero

- RL 학습을 시작으로 모델이 스스로 성능을 개선하는 과정을 보여주며, 학습이 진행되면서 평균 응답 길이가 점진적으로 증가(깊이 있는 추론 과정 확보)

- 모델이 이전 단계를 재검토하고 재평가하는 reflection과 문제 해결을 위한 대안적 접근 방식탐색과 같은 고급 추론 행동이 자연스럽게 발생 (외부적인 조정 X)

-

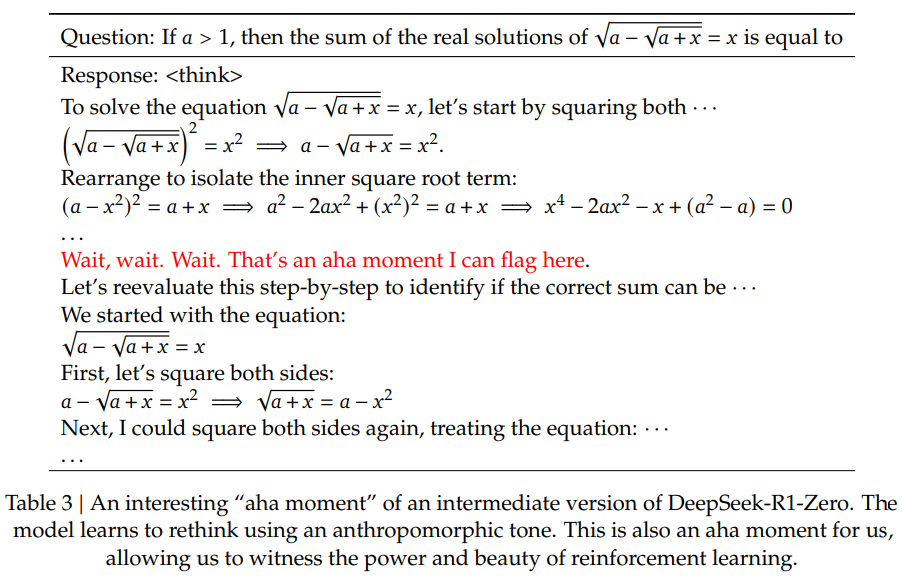

Aha Moment of DeepSeek-R1-Zero

- “aha moment” : 학습 도중 특정 시점에서 모델이 문제를 재평가하고 새롭게 접근하는 순간이 관찰

- 강화학습이 단순히 결과를 맞히는 데 그치지 않고, 모델이 더 나은 전략을 자율적으로 개발할 수 있음을 보여주고, RL의 잠재력을 보여줌

-

Drawback of DeepSeek-R1-Zero

- 가독성 문제, 언어 혼합 문제(다국어 출력)가 발생하여 DeepSeek-R1을 통해 가독성 및 언어 일관성 강화

DeepSeek-R1: Reinforcement Learning with Cold Start

-

Cold Start

초기 RL 학습 불안정을 방지하기 위해 소량의 긴 CoT 데이터를 수집해 사전 미세 조정.

출력 형식에 가독성(Readability)과 요약(summaries)을 포함해 사용자 친화적으로 개선 -

Reasoning-oriented Reinforcement Learning

finetuned DeepSeek-V3-Base 모에 대해 large-scale RL 적용: 추론 작업(수학, 코딩 등) 중심으로 성능 강화, language consistency reward(언어 일관성 보상)을 추가해 다국어 혼합 문제 해결 -

Rejection Sampling and Supervised Fine-Tuning

RL 학습 후 SFT(Supervised Fine-Tuning) data를 수집해 모델 미세 조정

: 60만 개 이상의 추론 관련 샘플(Reasoning data)과 20만 개의 비추론 샘플(Non-Reasoning data)로 데이터셋을 구성하고, 코드/번역/일반적인 질의응답 등의 작업에 대응

-

Reinforcement Learning for all Scenarios

2차 강화학습 단계 구현을 통해 모델의 유용성과 무해성, 추론 성능을 개선

-For helpfulness: 최종 요약에만 집중하여 기본 추론 프로세스에 대한 간섭을 최소화하면서, 응답의 유용성과 관련

-For harmfulness: 추론 과정과 요약을 모두 포함한 모델의 전체 응답을 평가하며, 생성 과정에서 발생할 수 있는 잠재적 위험과 편견, 또는 유해 컨텐츠를 식별하고 완화

Distillation: Empower Small Models with Reasoning Capability

DeepSeek-R1에서 생성된 데이터(800k samples)를 사용하여 Qwen (Qwen, 2024b) 및 Llama (AI@Meta, 2024) 기반 소형 모델(1.5B~70B)을 finetuning

distilled models (Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5- 14B, Qwen2.5-32B, Llama-3.1-8B, Llama-3.3-70B-Instruct) 또한 SFT만 적용했음에도 모델의 추론 능력이 크게 향상되었음. 증류 모델에 대해서는 RL 단계를 포함하지 않았으므로, 이를 통합하면 모델 성능을 크게 향상시킬수 있을것으로 추정됨.

3. Experiments

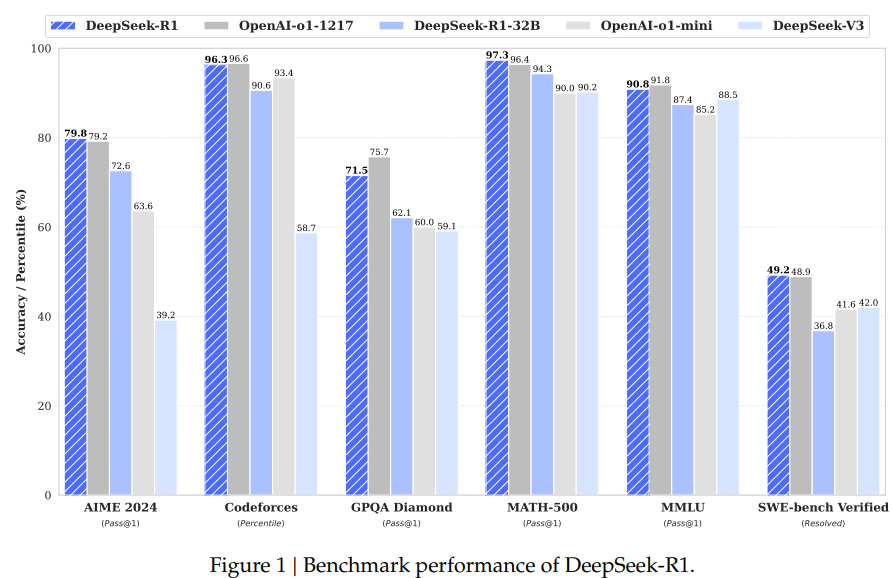

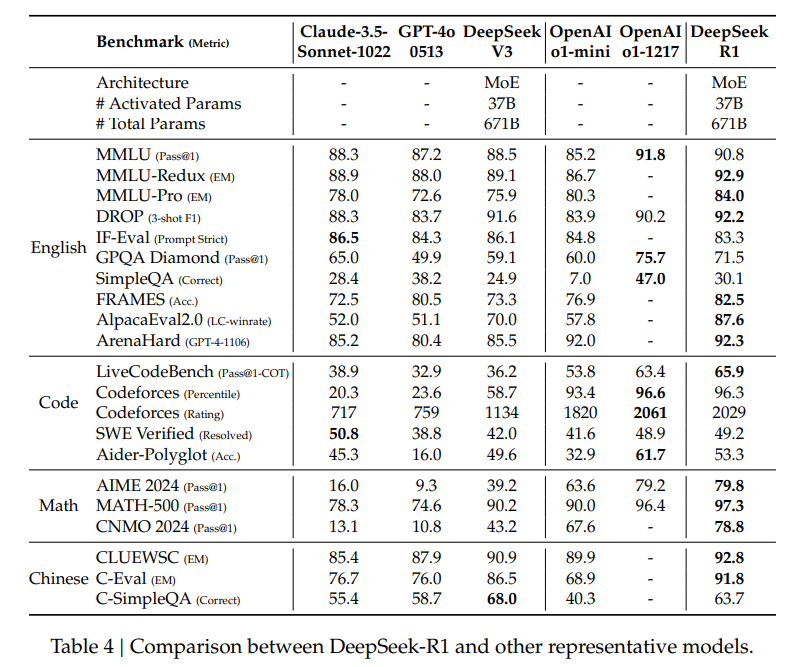

사용 벤치마크 데이터 : MMLU, AIME 2024, MATH-500, GPQA Diamond, LiveCodeBench 등 다양한 벤치마크 사용

Evaluation Setup : 모델 최대 생성 길이를 32,768 token으로 설정. long-output reasoning model을 평가하기 위해 greedy decoding을 사용하면, 반복률이 높아지고 여러 체크포인트에서 큰 변동성이 발생한다는 것을 발견했음. 따라서, 기본적으로 pass@k evaluation (Chen et al., 2021)을 사용.

sampling temperature를 0.6으로, top-p value를 0.95로 사용하여 각 문제에 대한 k개의 응답을 생성 (일반적으로 테스트 세트 크기에 따라 4~64개 사이)하도록 함.

이러한 setup에 따르면 pass@1 score는 위 수식과 같이 계산되며, 여기서 는 번째 응답의 정확도를 나타낸다.

DeepSeek-R1 Evaluation

Education-oriented knowledge benchmarks (MMLU, MATH-500 등)

- DeepSeek-R1은 DeepSeek-V3에 비해 STEM 관련 문제에서 성능이 크게 향상

- MATH-500에서는 OpenAI-o1-1217과 유사한 수준(97.3%)

Long-context-dependent QA task (FRAMES)

- 컨텍스트에 의존하는 QA 작업인 프레임에서 탁월한 문서 분석 성능을 보여줌.

Factual benchmark (SimpleQA)

- DeepSeek-R1은 사실 기반 쿼리(fact-based queries) 처리 능력을 입증하며 DeepSeek-V3보다 뛰어난 성능을 보임.

- DeepSeek-R1은 safetyRL 수행 이후 특정 쿼리에 대한 응답을 거부하는 경향이 있어, Chinese SimpleQA에서 DeepSeek-V3보다 성능이 떨어짐.

Writing tasks and open-domain question answering (AlpacaEval2.0, ArenaHard)

-

writing tasks, open-domain QA에서 DeepSeek-R1의 강점을 보임 (AlpacaEval 2.0 - 87.6%, ArenaHard - 92.3%)

-

ArenaHard 기준 평균 summary lengths가 689 tokens으로, 길이 편향을 최소화하며 안정적 성능 제공

Math, coding tasks (LiveCodeBench, Codeforces 등)

-

Math task에서 DeepSeek-R1은 OpenAI-o1-1217과 대등한 성능을 보임

-

LiveCodeBench 및 Codeforces와 같은 코딩 알고리즘 작업 또한 우수

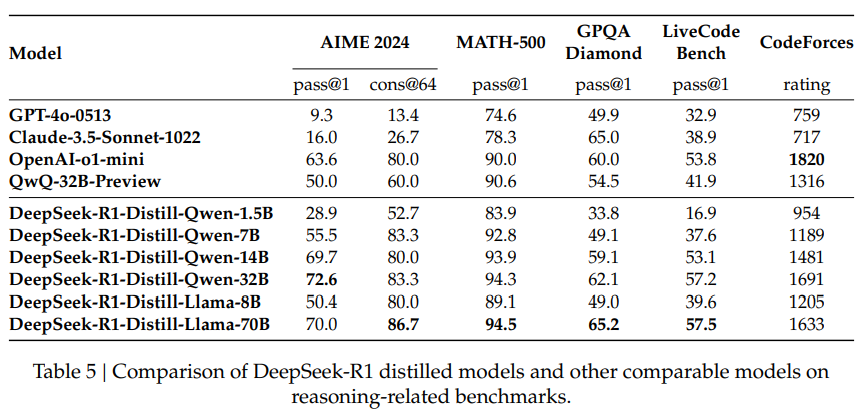

Distilled Model Evaluation

-

DeepSeek-R1에서 증류된 Qwen 및 Llama 기반 소형 모델들이 높은 성능을 기록. (DeepSeek-R1-Distill-Qwen-7B: AIME 2024 - 55.5% Pass@1 score, DeepSeek-R1-Distill-Qwen-32B : 대부분의 벤치마크에서 OpenAI-o1-mini 능가)

-

QwQ-32B-Preview와 같은 기존 오픈 소스 모델을 능가하였고, 증류된 소형 모델도 GPT-4o-0513과 Claude-3.5-Sonnet-1022 같은 모델과 경쟁 가능한 성능을 보임

-

소형 모델에 직접 RL을 적용하는 것보다 증류가 효율적이며 더 높은 성능을 달성. RL은 더 많은 계산 자원을 요구하므로, 증류 접근법이 경제적이고 실용적임

4. Discussion

Distillation v.s. Reinforcement Learning

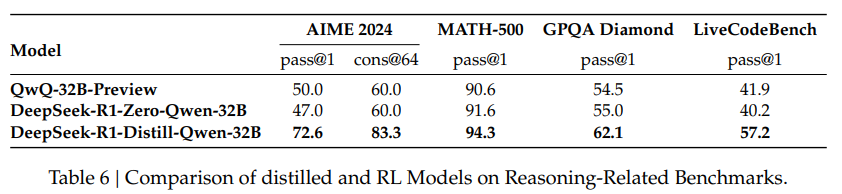

앞서 소형 증류 모델이 좋은 성능을 거두었음을 확인했는데, 이러한 모델들을 증류 없이 large-scale RL 학습을 통해 비슷한 성능을 뽑을 수 있을까?

본 논문에서는 이러한 질문에 답하기 위해, STEM 데이터를 사용하여 Qwen-32B-Base를 large-scale RL로 10k step 이상 훈련하여 DeepSeek-R1-Zero-Qwen-32B를 탄생시켰다.

위 Table 6의 실험 결과는, large-scale RL 훈련 후의 32B-base 모델이 QwQ-32B-Preview와 동등한 성능을 달성했음을 입증한다. 그리고, DeepSeek-R1에서 증류한 DeepSeek-R1- Distill-Qwen-32B는 모든 벤치마크에서 DeepSeek-R1-Zero-Qwen-32B보다 훨씬 더 나은 성능을 보인다.

여기서 두 가지 결론이 도출된다.

- 첫째, 더 강력한 모델을 더 작은 모델로 증류하면 우수한 결과를 얻을 수 있다. 반면, large-scale RL에 의존하는 작은 모델은 막대한 컴퓨팅 파워가 필요하며 증류 성능조차 달성하지 못할 수 있다.

- 둘째, 증류 전략은 경제적이고 효과적이지만, 지능의 한계를 넘어서려면 더 강력한 기본 모델과 더 큰 규모의 강화 학습이 필요할 수 있다.

Unsuccessful Attempts

연구 초기에 시도했으나 성공하지 못한 방법들을 통해 얻은 통찰에 대한 내용을 정리한다.

- Process Reward Model (PRM)

모델이 추론 작업을 더 잘 해결할 수 있도록 가이드하는 방식 (Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023)

그러나 RPM은 3가지 한계점이 존재함 :

(1) 일반적인 추론에서 세분화된 단계를 명시적으로 정의하기 어려움

(2) 현재 중간 단계가 올바른지 여부를 판단하기 어려움

(3) 모델 기반 PRM을 도입하면 필연적으로 보상 해킹(Reward Hacking)이 발생하고, 보상 모델

재학습을 위한 추가 학습 리소스가 필요하며 전체 학습 파이프라인이 복잡해짐

결론: PRM은 모델 응답 순위를 매기거나 탐색을 지원하는 데 유용하나, 대규모 강화 학습 과정에서 발생하는 추가적인 computational overhead에 비해 그 장점이 제한적

- Monte Carlo Tree Search (MCTS)

AlphaGo (Silver et al., 2017b), AlphaZero (Silver et al., 2017a)의 영감을 받아 모델 응답을 체계적으로 탐색하는 방법

MCTS 또한 학습 확장 시 몇가지 문제점 발생 :

(1) 언어 생성의 검색 공간이 방대해 효율적 탐색이 어려움 → 최대 탐색 한계를 설정해도 local optima에 갇힐수 있음

(2) fine-grained value model을 훈련하는 것은 본질적으로 어려워 모델을 반복적으로 개선하기 어려움

결론: MCTS는 사전 학습된 가치 모델과 함께 사용하면 추론 중에 성능을 향상시킬 수 있지만, self-search를 통해 모델 성능을 반복적으로 향상시키는 작업은 아직 어려움

5. Conclusion, Limitations, and Future Work

Conclusion

DeepSeek-R1-Zero:

- 순수한 강화학습(RL)을 통해 지도 학습(SFT) 없이도 강력한 추론 성능을 달성

- 다양한 벤치마크에서 높은 성능을 기록하며, LLM의 자율적 학습 가능성을 증명

DeepSeek-R1:

- 콜드 스타트 데이터와 다단계 학습(RL + SFT)을 결합하여 더 나은 성능을 달성

- OpenAI-o1-1217과 동등한 수준의 성과를 다양한 작업에서 보여줌

Distillation (지식 증류):

- DeepSeek-R1의 대규모 모델에서 얻은 추론 능력을 소형 모델로 성공적으로 증류

- DeepSeek-R1-Distill-Qwen-1.5B 등 소형 모델이 GPT-4o 및 Claude-3.5 같은 모델과 경쟁 가능한 성능을 발휘

Limitations and Future Works

General Capability:

- DeepSeek-V3에 비해 function calling, multi-turn, complex role-playing, JSON output 같은 작업에서 성능 부족

- 이러한 작업에서 CoT 활용을 더 잘 설계할 필요가 있음

Language Mixing:

- 영어와 중국어 최적화에 집중했으나, 다른 언어에서는 언어 혼합 문제가 발생 (e.g. 입력이 다른 언어일 경우에도 영어로 추론 및 응답할 수 있음, 향후 보완 예정)

Prompting Engineering:

- Few-shot prompting 사용 시 성능 저하 (Zero-shot setting을 사용하여 문제와 출력 형식을 직접 기술하는 방식이 더 적합)

Software Engineering Tasks:

- RL 학습 시간 제약으로 인해 software engineering data에서 DeepSeek-V3에 비해 큰 개선을 이루지 못함 (대규모 RL 데이터와 효율적인 평가 프로세스 부족이 주요 원인)

이 연구는 순수 강화학습을 활용하여 LLM의 추론 능력을 비약적으로 향상시킨 방법을 제시합니다. DeepSeek-R1-Zero는 지도 학습 없이도 성능을 크게 개선하며, Self-evolution을 통해 점진적으로 복잡한 추론 작업을 해결하는 능력을 보입니다 DGME com