Linear Regression Model

-

-

실제로 여러 학습 데이터에서 하나로는 라벨 예측 불가

Least Square

-

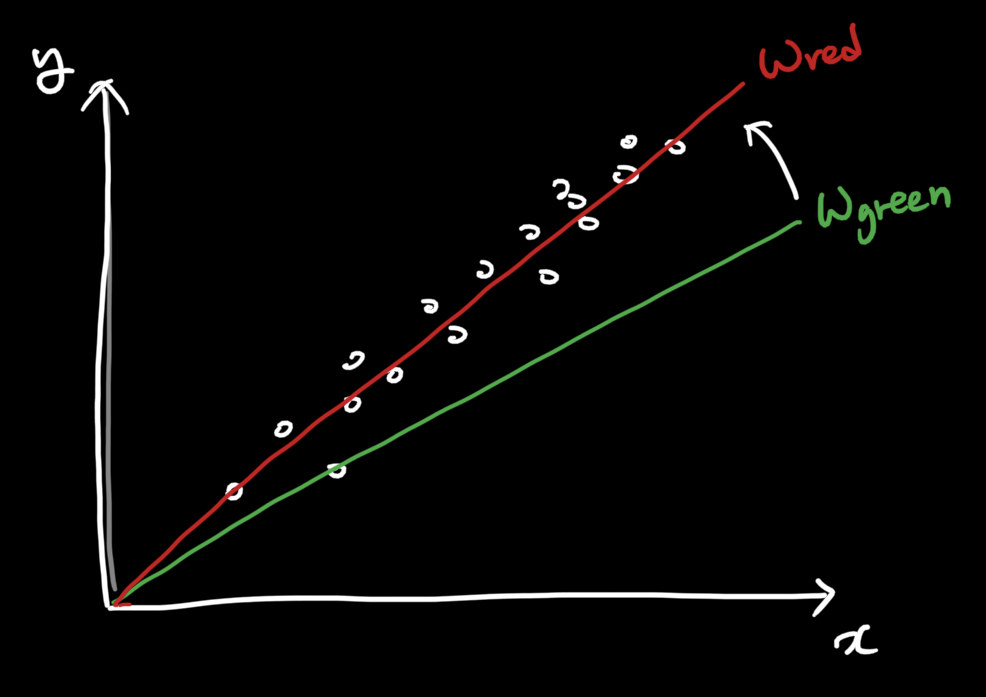

예측값과 실제값의 차이를 최소화 하는 선형 모델을 찾는 것

-

Least Square Objective

-

위 그림기준으로 이다.

-

-

의 최소값을 찾는 문제이다. 에 관한 양의 이차 방정식 이므로 인 값을 찾으면 된다.

-

N-dimension

-

-

가 features 개수()만큼 있으므로 총 번 미분해야합니다.

-

미분 결과

-

-

벡터에서의 미분 동작 방법

- (단, 가 symmetric 이어야합니다.)

-

벡터 형태의 Least Square

-

-

-

위 식을 성립하는 가 최소일 때의 값입니다.

-

-

Least Square의 남아있는 문제점

Bias variable

원점을 지나지 않는 모델을 구해야 할 수 있습니다. 따라서 Bias를 고려해야합니다.

기존에 존재하던 데이터에 가상의 feature를 추가합니다.

이외의 문제들

-

정답이 한 개만 존재하는 경우가 많지 않음

-

역행렬을 계산할 수 없는 경우도 많음

-

Outlier에 상당히 취약하게 동작함

-

데이터가 너무 클 경우 -> 벡터곱 혹은 역행렬 계산이 어렵습니다.

-

x가 작을 때는 선형이었다가, x가 충분히 커지면 y가 더 이상 증가하지 않는 경우가 있을 수 있습니다.