Parameter Learning

Gradient Descent

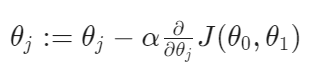

Gradient Descent는 Cost Function의 최솟값을 구하는 알고리즘이다. Linear Regression 말고도 모든 곳에서 실제로 사용되고 있다. 여기서 α는 learning rate를 의미하며, 0과 1 사이의 값을 가진다.

처음에 가 어떻게 초기화 되느냐에 따라 minimum 값이 달라질 수 있다. 이는 local minimum이 여러개 있을때 나타날 수 있는 현상이다. 단, hypothesis function이 linear인 경우, θ 초기화와 관계 없이 global minimum을 갖게 된다.

위와 Correct 경우와 같이 θ를 update할 때 simultaneous하게 해야한다.

미분계수의 값이 양수이면 minimum을 향해 작아지고, 음수이면 minimum을 향해 커지게 된다. 위의 그림을 통해 이해할 수 있다.

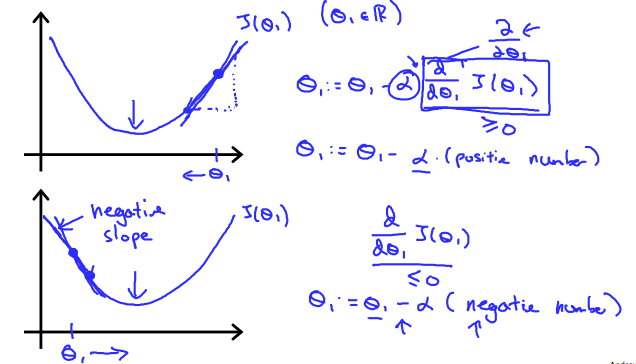

위는 α에 따른 gradient descent가 이루어지는 모습을 나타낸 것이다. α가 작으면 gradient descent는 천천히 이루어지며 수렴하게 된다. α가 매우 크면 수렴하지 않고 발산할 수 있다. 따라서 적절한 learning rate를 설정하는 것이 중요하다.

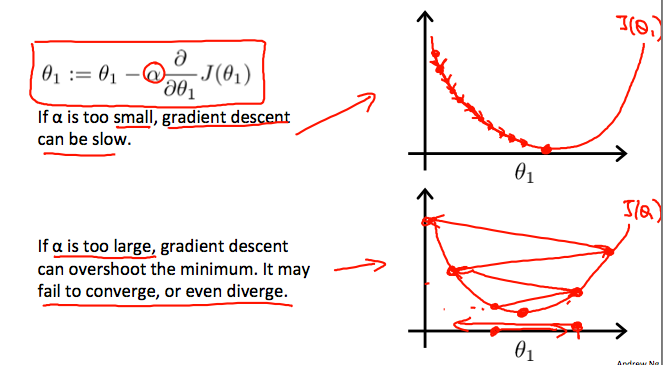

또한 α 값이 줄어들지 않더라도, minimum에 가까워질 수록 미분계수의 절댓값이 작아지기 때문에 천천히 가게 된다. 따라서 시간의 흐름에 따라 α를 줄일 필요가 없다.