심층학습

심층학습의 성공 이유

- 혁신적 알고리즘 등장

- 합성곱 신경망(CNN) 구조

- 부분 연결과 가중치 공유를 통해서 효율적인 신경망 학습 구조 제공

- 경사 소멸 문제 해결을 위한 ReLU 활성함수

- 과잉적합을 방지하는데 효과적인 다양한 규제 기법

- 층별 예비학습 기법 개발

- 값싼 GPU의 등장

- 학습 데이터 양과 질의 향상

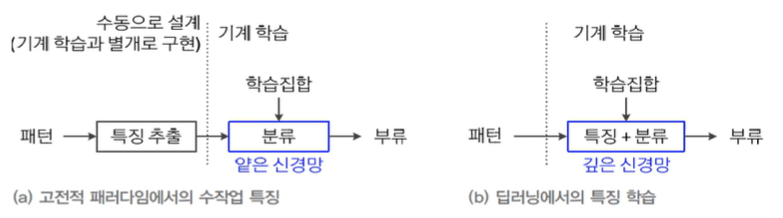

표현학습의 부각

-

전통적인 다층 퍼셉트론

- 은닉층은 특징 추출기

얕은 구조이므로 원래 패턴을 그대로 입력하면 낮은 성능

→ 사람이 수작업으로 특징을 선택하거나 추출하여 신경망에 입력 -

현대 기계학습(심층학습)

- 학습에 의해 자동적으로 데이터로부터 특징 추출 ← 표현 학습(representation learning)

- 특징 벡터를 신경망의 입력 ← 종단간 학습(end-to-end learning)

- 깊은 신경망의 표현 학습(또는 특징 학습; feature learning)

- 낮은 단계 은닉층은 선, 모서리 등의 단순한(저급) 특징 추출

- 높은 단계 은닉층은 추상적인 형태의 복잡한(고급) 특징 추출

구조와 동작

- 깊은 다층 퍼셉트론(deep MLP)의 구조

- 입력(차원의 특징벡터)와 출력(개 분류)

- 개의 은닉층(입력층은 0번째 은닉층, 출력층은 번째 은닉층으로 간주)- 번째 은닉층의 노드 수를 로 표기

-

DMLP의 동작

- MLP의 동작을 나타내는 식을 보다 많은 단계로 확장

-

- 번째 층의 연산: -

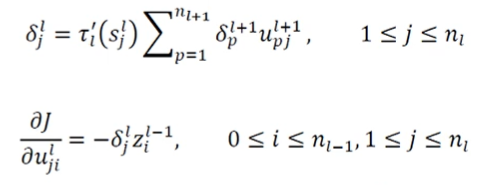

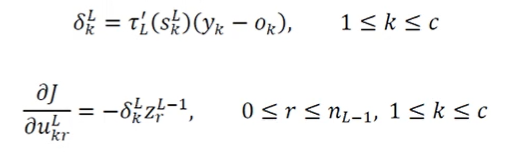

오류 역전파 알고리즘

- 번째 층(출력층)의 경사도 계산

- 번째 층의 정보를 이용하여 번째 층의 경사도 계산