📝 Language Models are Unsupervised Multitask Learners

Abstract

-

기존 자연어 처리 태스크는 지도 학습이 필요했지만, WebText로 학습한 모델은 명시적 지도 없이도 태스크를 수행함

-

CoQA 데이터셋에서 F1 55점을 기록하며, 기존 모델 중 3개 이상의 성능을 달성함

-

모델 크기가 클수록 제로샷 학습 성능이 증가하며, GPT-2(15억 파라미터)는 7개 태스크에서 최신 성능을 기록함

-

GPT-2는 여전히 WebText 데이터에 대해 과소적합 상태이며, 자연 발생 데이터를 활용한 태스크 학습 가능성을 보임

1 Introduction

-

기존 머신러닝 모델은 특정 태스크에 특화된 전문가 수준이지만, 일반적인 문제 해결 능력은 부족함

-

멀티태스크 학습이 일반화에 도움될 수 있으나, 기존 연구는 태스크 수가 제한적이며 확장이 어려움

-

현재 최고 성능 모델들은 사전 학습 + 지도 학습 기반이지만, 지도 학습 없이도 NLP 태스크를 수행할 수 있는 언어 모델 연구가 증가하고 있음

-

본 논문에서는 언어 모델이 제로샷 환경에서 다양한 태스크를 수행할 수 있음을 보이며, 최신 성능과 경쟁하거나 이를 초월할 가능성을 제시함

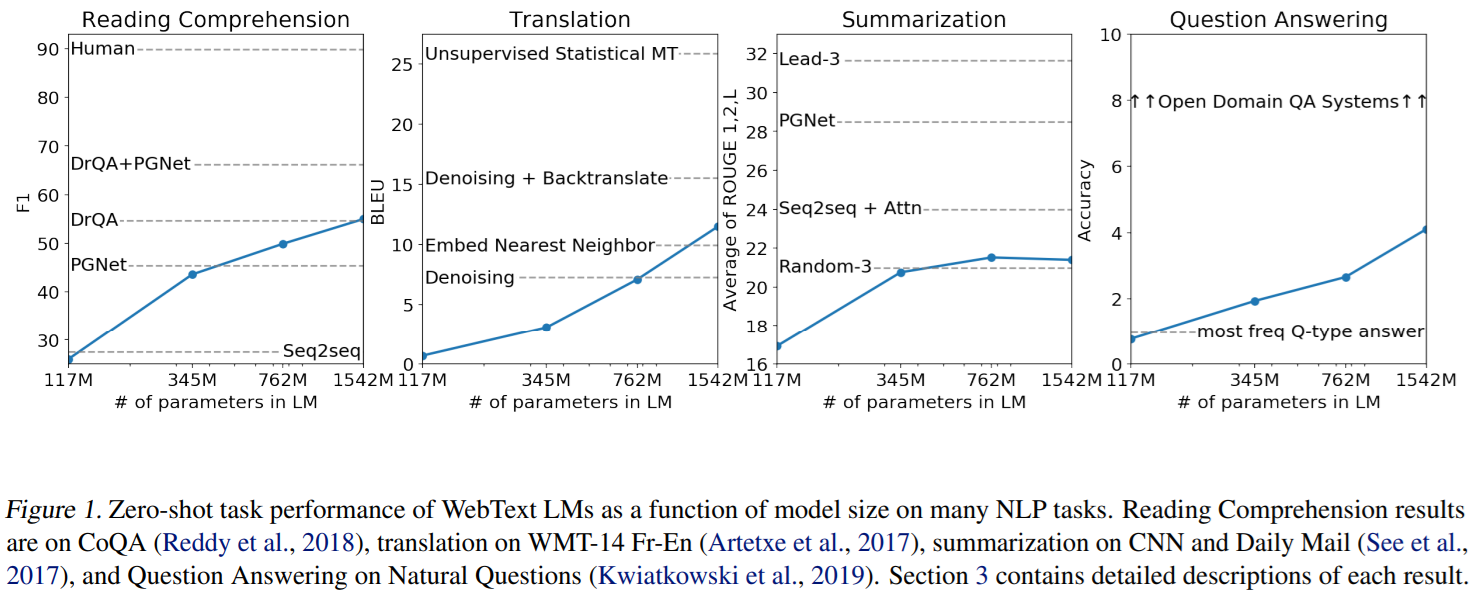

(이미지에 대한 설명)

"Zero-shot" 설정에서 WebText 언어 모델의 크기에 따른 성능 변화를 다양한 NLP 작업에서 측정한 결과

1. Reading Comprehension (독해 능력)

-

평가지표: F1 스코어 — 모델의 예측과 정답 간 겹치는 부분을 측정하는 지표

-

결과:

-

모델 크기가 증가할수록 F1 스코어가 지속적으로 향상됨

-

117M 파라미터 모델의 성능은 약 30점에서 시작해, 1542M 모델에서는 50점 이상으로 상승함

-

기존의 특정 모델들(DrQA, PGNet 등)과 비교했을 때, 큰 모델일수록 더 나은 성능을 보여줌

-

그러나 인간 성능에는 아직 미치지 못함

-

2. Translation (번역)

-

평가지표: BLEU 스코어 — 번역 품질을 측정하는 지표

-

결과:

-

모델 크기가 증가할수록 BLEU 스코어가 꾸준히 상승함

-

작은 모델(117M)은 기존의 단순한 Denoising 수준에 그치지만, 큰 모델(1542M)은 Denoising + Backtranslate 수준에 도달함

-

여전히 Unsupervised Statistical MT 모델보다 성능이 낮지만, 파라미터 수가 많아질수록 성능이 개선되는 추세를 보임

-

3. Summarization (요약)

-

평가지표: ROUGE (1, 2, L) — 생성된 요약과 실제 요약 간 겹치는 n-그램을 기반으로 요약 품질을 평가

-

결과:

-

모델 크기가 커질수록 ROUGE 점수가 증가함

-

특히 117M에서 345M 모델로 확장될 때 큰 성능 향상이 있으며, 이후로는 점진적으로 개선됨

-

기존 요약 모델들(Lead-3, PGNet)에는 미치지 못하지만, Seq2seq + Attention 모델을 따라잡는 수준에 도달함

-

4. Question Answering (질문 응답)

-

평가지표: Accuracy (정확도) — 모델이 질문에 대해 올바른 응답을 했는지 측정

-

결과:

-

모델 크기에 따라 정확도가 꾸준히 향상됨

-

117M 모델은 most freq Q-type answer 수준에 불과하지만, 1542M 모델에서는 정확도가 약 4.5까지 상승함

-

여전히 Open Domain QA Systems와 비교하면 성능이 낮음

-

2 Approach

2.1 Training Dataset

-

기존 연구들은 뉴스, 위키백과, 소설 등 단일 도메인 데이터만으로 언어 모델을 학습했지만, 우리는 보다 다양한 데이터셋을 구축하는 것이 중요하다고 판단함

-

웹 크롤링(Common Crawl)은 대규모 데이터를 제공하지만 데이터 품질이 낮은 문제가 있어 직접 사용할 수 없음

-

WebText는 800만 개의 문서(40GB)로 구성되며, 위키백과 문서는 제거하여 훈련-평가 데이터 중복 문제를 방지함

2.2 Input Representation

-

일반적인 언어 모델은 문자열을 처리할 때 전처리 과정이 필요해 표현 가능한 문자열 범위가 제한됨

-

기존 바이트 수준 모델은 성능이 낮아 단어 수준 모델과의 절충안으로 Byte Pair Encoding (BPE)를 활용함

-

BPE를 바이트 시퀀스에 직접 적용하면 비효율적인 병합이 발생하므로, 문자 범주를 초월한 병합을 방지하는 방식으로 개선함

-

이 방식을 통해 단어 수준 모델의 장점과 바이트 수준 모델의 범용성을 결합, 사전처리 없이 어떤 데이터셋에도 적용 가능함

2.3 Model

-

Transformer 기반의 OpenAI GPT 모델을 따르되, Layer Normalization 위치를 조정하고 Self-Attention 후 추가 적용함

-

잔차 경로의 가중치를 스케일링 방식으로 초기화하여 모델 안정성을 향상시킴

-

어휘 크기를 50,257개로 확장하고, 문맥 크기를 1024 토큰으로 증가시켜 더 긴 문장을 학습할 수 있도록 개선함

-

배치 크기를 512로 증가하여 학습 안정성과 성능을 높임

3 Experiments

-

4개의 다양한 크기의 언어 모델을 학습해 여러 태스크(언어 모델링, 어린이 도서 테스트, LAMBADA, Winograd, 독해, 요약, 번역, 질문 응답)에서 평가함

-

GPT-2는 대부분의 태스크에서 제로샷 설정 하에 최첨단 성능을 갱신하거나 큰 개선을 보임

-

모델 크기가 클수록 성능이 꾸준히 향상되며, de-tokenizer, 태스크 힌트, 도메인 적응 등이 중요한 역할을 함

-

일부 태스크(예: One Billion Word Benchmark, 질문 응답)에서는 여전히 개선의 여지가 있음

4 Generalization vs Memorization

-

최근 이미지 데이터셋처럼, WebText에도 학습-테스트 간 중복이 일부 존재함

-

Bloom 필터를 이용해 8-gram 중복률을 분석했는데, 대부분 1~6% 정도로 나타남

-

중복이 성능에 미치는 이점은 작지만 일관되게 존재하며, GPT-2는 여전히 WebText에 대해 과소적합 중임

-

중복 제거는 새로운 NLP 데이터셋 제작 시 중요한 검증 단계로 활용해야 함

5 Related Work

-

대형 데이터셋에서 훈련된 대형 언어 모델의 성능 측정에 관한 연구가 주를 이루고 있음

-

생성 모델이 학습한 기능(예: 줄 너비 추적, 인용/댓글 감지, 이름 번역) 등이 이전에 문서화되어 연구에 영감을 줌

-

다양한 사전 학습 및 멀티태스크 학습 기법들이 언어 태스크 성능 개선에 기여해왔으며, 최신 연구들은 이를 더욱 발전시키고 있음

6 Discussion

-

지도 및 비지도 사전학습 방법의 표현 학습과 평가에 관한 연구가 활발히 이루어짐

-

우리의 결과는 비지도 태스크 학습이 태스크를 직접 수행할 수 있는 유망한 연구 분야임을 시사함

-

GPT-2는 독해에서는 제로샷으로 경쟁력이 있으나, 요약 등 일부 태스크에서는 정량적 성능이 아직 기초적임

-

미세 조정의 한계와 단방향 표현의 비효율성 문제를 해결하기 위해 decaNLP, GLUE 등의 벤치마크에서 추가 연구가 필요함

7 Conclusion

-

충분히 크고 다양한 데이터셋에서 대형 언어 모델을 훈련하면, 다양한 도메인과 데이터셋 전반에서 우수한 성능을 발휘할 수 있음

-

GPT-2는 테스트한 8개의 언어 모델링 데이터셋 중 7개에서 제로샷(zero-shot) 상태로 최첨단 성능을 달성함

-

고용량 모델은 지도 없이도 다양한 태스크를 수행하는 방법을 스스로 학습함