이번 시간에는 고급 순환층인 LSTM과 GRU에 대해 공부하겠습니다.

일반적으로 기본 순환층은 시퀀스가 길수록 순환되는 은닉 상태에 담긴 정보가 희석되기 때문에 학습이 어려워집니다. LSTM과 GRU 셀은 이 문제를 해결하기 위해 발명된 모델입니다.

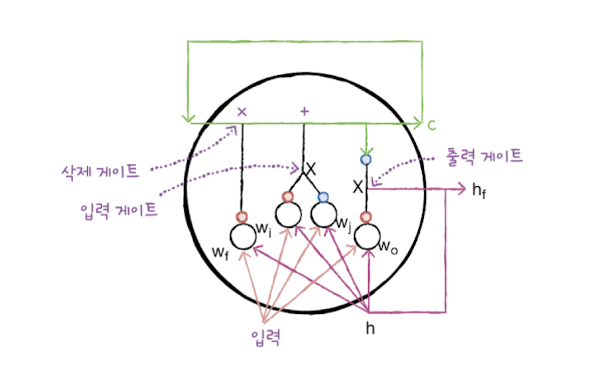

1. LSTM 구조

LSTM(Long Short-Term Memory)

- 단기 기억을 오래 기억하기 위해 고안된 순환층

- 입력 게이트, 삭제 게이트, 출력 게이트 역할을 하는 작은 셀이 포함

셀 상태(cell state)

- LSTM에서 다음 층으로 전달되지 않고 셀에서 순환만 되는 값

LSTM 구조

- 삭제 게이트

- 입력 게이트

- 출력 게이트

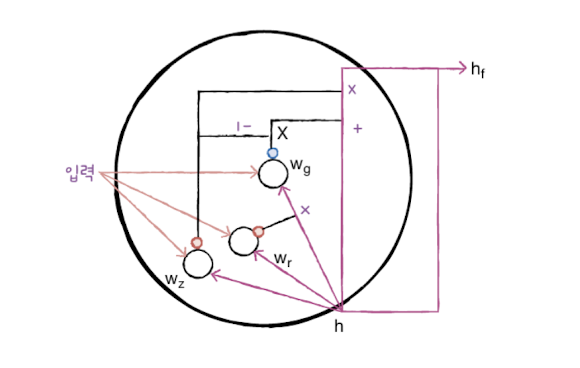

2. GRU 구조

GRU(Gated Recurrent Unit)

- LSTM의 간소화 버전

- LSTM 처럼 셀 상태를 계산하지 않고 은닉 상태 하나만 포함

- LSTM보다 가중치가 적기 때문에 계산량이 적지만 LSTM 못지 않은 성능