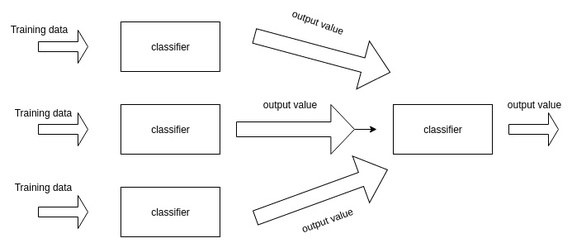

스태킹(Stacking)은 개별적인 여러 알고리즘을 결합해 예측 결과를 도출하는 것이 배깅(Bagging), 부스팅(Boosting)과 비슷하지만, 개별 알고리즘으로 예측한 데이터를 기반으로 다시 예측을 한다. 즉, 개별 알고리즘의 예측 결과 데이터 세트를 최종적인 메타 데이터 세트로 만들어 별도의 머신러닝 알고리즘으로 최종 학습하고 테스터 데이터를 기반으로 다시 최종 예측을 하는 방식이다.

Source: https://flonelin.wordpress.com/2016/08/02/stacking이란/

스태킹 with 위스콘신 암 데이터 세트

import numpy as np

from sklearn.neighbors import KNeighborsClassifier

from sklearn.ensemble import RandomForestClassifier, AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_breast_cancer

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

cancer_data = load_breast_cancer()

X_data = cancer_data.data

y_label = cancer_data.target

X_train, X_test, y_train, y_test = train_test_split(X_data, y_label, test_size=0.2, random_state=0)# 개별 ML 모델 생성

knn_clf = KNeighborsClassifier(n_neighbors=4)

rf_clf = RandomForestClassifier(n_estimators=100, random_state=0)

dt_clf = DecisionTreeClassifier()

ada_clf = AdaBoostClassifier(n_estimators=100)

# 스태킹으로 만들어진 데이터 세트를 학습, 예측할 최종 모델

lr_final = LogisticRegression(C=10)

# 학습

knn_clf.fit(X_train, y_train)

rf_clf.fit(X_train, y_train)

dt_clf.fit(X_train, y_train)

ada_clf.fit(X_train, y_train)

AdaBoostClassifier(n_estimators=100)knn_pred = knn_clf.predict(X_test)

rf_pred = rf_clf.predict(X_test)

dt_pred = dt_clf.predict(X_test)

ada_pred = ada_clf.predict(X_test)

print(f'KNN 정확도: {np.round(accuracy_score(y_test, knn_pred), 4)}')

print(f'Random Forest 정확도: {np.round(accuracy_score(y_test, rf_pred), 4)}')

print(f'Decision Tree 정확도: {np.round(accuracy_score(y_test, dt_pred), 4)}')

print(f'AdaBoost 정확도: {np.round(accuracy_score(y_test, ada_pred), 4)}')KNN 정확도: 0.9211

Random Forest 정확도: 0.9649

Decision Tree 정확도: 0.9123

AdaBoost 정확도: 0.9561pred = np.array([knn_pred, rf_pred, dt_pred, ada_pred])

print(pred.shape)(4, 114)# transpose로 행과 열 교환. 칼럼 레벨로 각 알고리즘의 예측 결과를 피처로 만듦

pred = np.transpose(pred)

print(pred.shape)(114, 4)lr_final.fit(pred, y_test)

final = lr_final.predict(pred)

print(f'최종 메타 모델의 예측 정확도: {np.round(accuracy_score(y_test, final), 4)}')최종 메타 모델의 예측 정확도: 0.9737원래 스태킹을 한다고 성능이 무조건 좋아지는 것은 아니지만 여기서는 각각의 개별 모델의 정확도에 비해 증가한 것을 알 수 있다.

CV 세트 기반의 스태킹

CV 세트 기반의 스태킹 모델은 과적합을 개선하기 위해 최종 메타 모델을 위한 데이터 세트를 만들 때 교차 검증 기반으로 예측된 결과 데이터 세트를 이용한다. 개별 모델들이 각각 교차 검증으로 메타 모델을 위한 학습용, 테스트용 데이터를 생성한 뒤 이를 기반으로 메타 모델이 학습과 예측을 수행한다.

from sklearn.model_selection import KFold

from sklearn.metrics import mean_absolute_error

# 개별 기반 모델에서 최종 메타 모델이 사용할 학습 및 테스트용 데이터를 생성하는 함수

def get_stacking_base_datasets(model, X_train_n, y_train_n, X_test_n, n_folds):

kf = KFold(n_splits=n_folds, shuffle=False, random_state=0)

# 추후에 메타 모델이 사용할 학습 데이터 반환을 위한 넘파이 배열 초기화

train_fold_pred = np.zeros((X_train_n.shape[0], 1))

test_pred = np.zeros((X_test_n.shape[0], n_folds))

print(model.__class__.__name__, ' model 시작 ')

for folder_counter, (train_index, valid_index) in enumerate(kf.split(X_train_n)):

# 입력된 학습 데이터에서 기반 모델이 학습/예측할 폴드 데이터 세트 추출

print('\t 폴드 세트: ', folder_counter, ' 시작 ')

X_tr = X_train_n[train_index]

y_tr = y_train_n[train_index]

X_te = X_train_n[valid_index]

model.fit(X_tr, y_tr)

# 폴드 세트 내부에서 다시 만들어진 검증 데이터로 기반 모델 예측 후 데이터 저장

train_fold_pred[valid_index, :] = model.predict(X_te).reshape(-1, 1)

# 입력된 원본 테스트 데이터를 폴드 세트내 학습된 기반 모델에서 예측 후 저장

test_pred[:, folder_counter] = model.predict(X_test_n)

# 폴드 세트 내에서 원본 테스트 데이터를 예측한 데이터를 평균하여 테스트 데이터로 생성

test_pred_mean = np.mean(test_pred, axis=1).reshape(-1, 1)

return train_fold_pred, test_pred_meanknn_train, knn_test = get_stacking_base_datasets(knn_clf, X_train, y_train, X_test, 7)

rf_train, rf_test = get_stacking_base_datasets(rf_clf, X_train, y_train, X_test, 7)

dt_train, dt_test = get_stacking_base_datasets(dt_clf, X_train, y_train, X_test, 7)

ada_train, ada_test = get_stacking_base_datasets(ada_clf, X_train, y_train, X_test, 7)/Users/andylee/opt/anaconda3/lib/python3.8/site-packages/sklearn/model_selection/_split.py:293: FutureWarning: Setting a random_state has no effect since shuffle is False. This will raise an error in 0.24. You should leave random_state to its default (None), or set shuffle=True.

warnings.warn(

/Users/andylee/opt/anaconda3/lib/python3.8/site-packages/sklearn/model_selection/_split.py:293: FutureWarning: Setting a random_state has no effect since shuffle is False. This will raise an error in 0.24. You should leave random_state to its default (None), or set shuffle=True.

warnings.warn(

KNeighborsClassifier model 시작

폴드 세트: 0 시작

폴드 세트: 1 시작

폴드 세트: 2 시작

폴드 세트: 3 시작

폴드 세트: 4 시작

폴드 세트: 5 시작

폴드 세트: 6 시작

RandomForestClassifier model 시작

폴드 세트: 0 시작

폴드 세트: 1 시작

폴드 세트: 2 시작

폴드 세트: 3 시작

폴드 세트: 4 시작

폴드 세트: 5 시작

폴드 세트: 6 시작

/Users/andylee/opt/anaconda3/lib/python3.8/site-packages/sklearn/model_selection/_split.py:293: FutureWarning: Setting a random_state has no effect since shuffle is False. This will raise an error in 0.24. You should leave random_state to its default (None), or set shuffle=True.

warnings.warn(

/Users/andylee/opt/anaconda3/lib/python3.8/site-packages/sklearn/model_selection/_split.py:293: FutureWarning: Setting a random_state has no effect since shuffle is False. This will raise an error in 0.24. You should leave random_state to its default (None), or set shuffle=True.

warnings.warn(

DecisionTreeClassifier model 시작

폴드 세트: 0 시작

폴드 세트: 1 시작

폴드 세트: 2 시작

폴드 세트: 3 시작

폴드 세트: 4 시작

폴드 세트: 5 시작

폴드 세트: 6 시작

AdaBoostClassifier model 시작

폴드 세트: 0 시작

폴드 세트: 1 시작

폴드 세트: 2 시작

폴드 세트: 3 시작

폴드 세트: 4 시작

폴드 세트: 5 시작

폴드 세트: 6 시작 # concatenate는 여러 개의 넘파이 배열을 칼럼 또는 로우 레벨로 합쳐주는 기능을 제공

Stack_final_X_train = np.concatenate((knn_train, rf_train, dt_train, ada_train), axis=1)

Stack_final_X_test = np.concatenate((knn_test, rf_test, dt_test, ada_test), axis=1)

print(f'원본 학습 피처 데이터 shape: {X_train.shape}, 원본 테스트 피처 shape: {X_test.shape}')

print(f'스태킹 학습 피처 데이터 shape: {Stack_final_X_train.shape}, 스태킹 테스트 피처 데이터 shape: {Stack_final_X_test.shape}')원본 학습 피처 데이터 shape: (455, 30), 원본 테스트 피처 shape: (114, 30)

스태킹 학습 피처 데이터 shape: (455, 4), 스태킹 테스트 피처 데이터 shape: (114, 4)Stack_final_X_train 은 메타 모델이 학습할 학습용 피처 데이터 세트, Stack_final_X_test 는 메타 모델이 예측할 테스트용 피처 데이터 세트이다.

lr_final.fit(Stack_final_X_train, y_train)

stack_final = lr_final.predict(Stack_final_X_test)

print(f'최종 메타 모델의 예측 정확도: {np.round(accuracy_score(y_test, stack_final), 4)}')최종 메타 모델의 예측 정확도: 0.9737Source: 파이썬 머신러닝 완벽 가이드 / 위키북스