- 작성한 이유 : 잔차 학습 방법을 공부하면서 그레디언트 소실 문제를 막는 효과가 있다고 하는데 그전에는 시그모이드 함수의 역시도 미분하면 최댓값이 0.25이고 0도 나와서 결국 Gradiant vinishing problem이 발생해서 그것을 보완하는 것이 RELU인데 왜 그런지 알고 싶어서 작성함

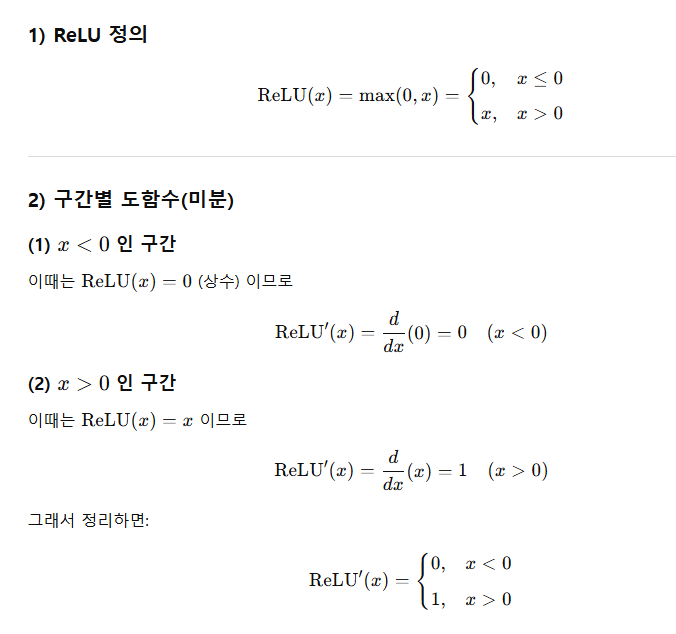

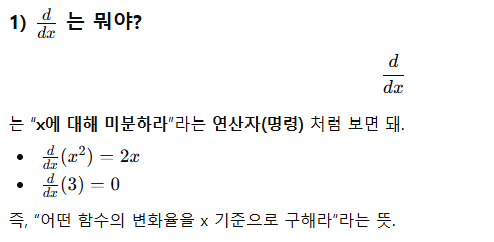

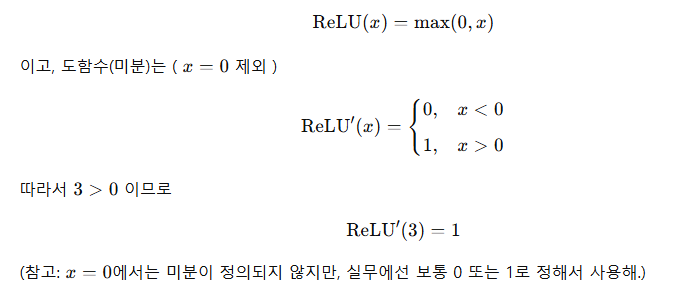

RELU 함수

- 0이 나오면 프레임워크에 따라서 0 또는 1 사용 아마도 1사용할 듯

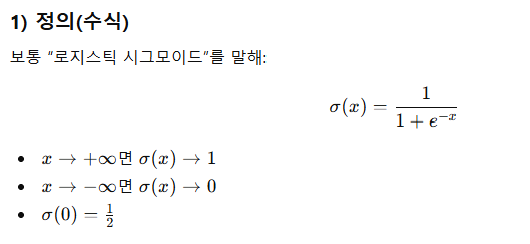

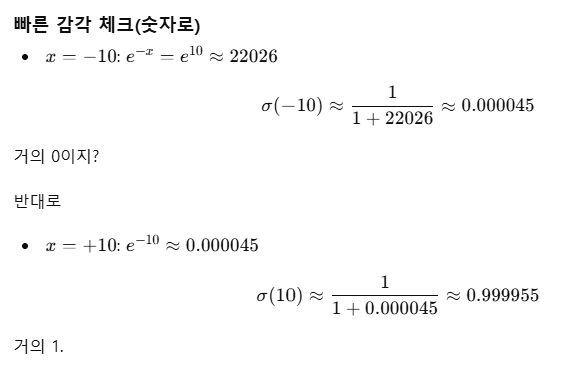

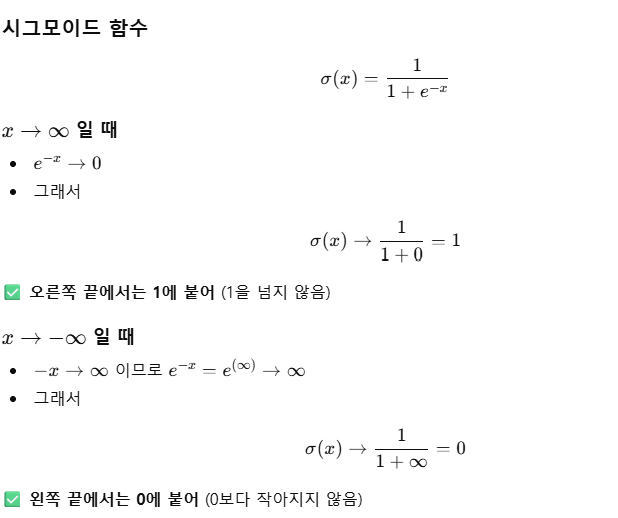

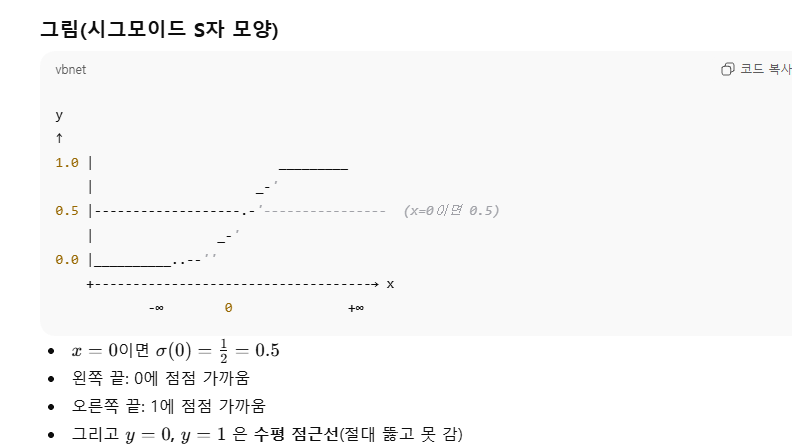

시그모이드 함수

- 시그모이드(sigmoid) 함수는 실수 전체 입력을 0~1 사이 값으로 “눌러서” 내보내는 S자 형태 함수야. 확률처럼 해석하기 좋아서 예전엔 분류 신경망 출력층/은닉층에 많이 썼어.

지수함수 이해

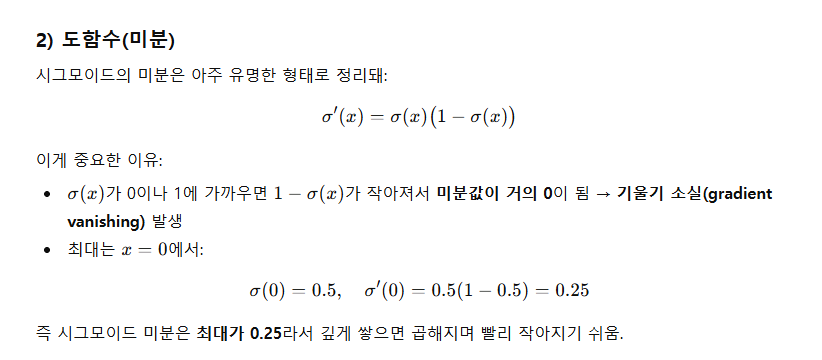

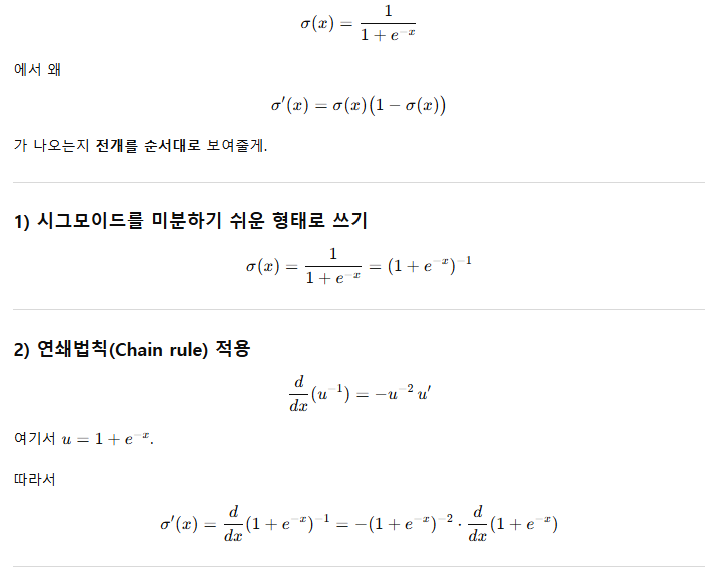

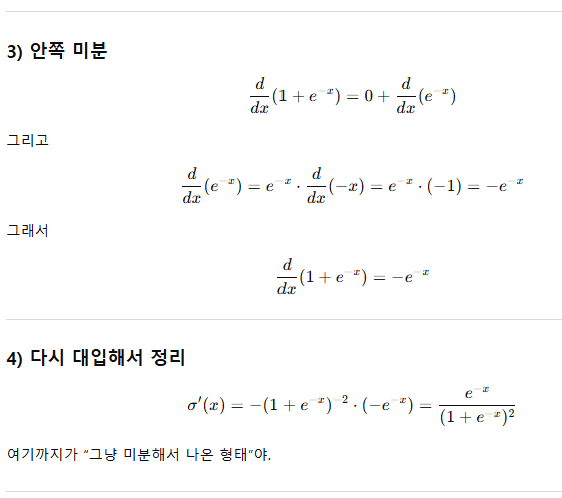

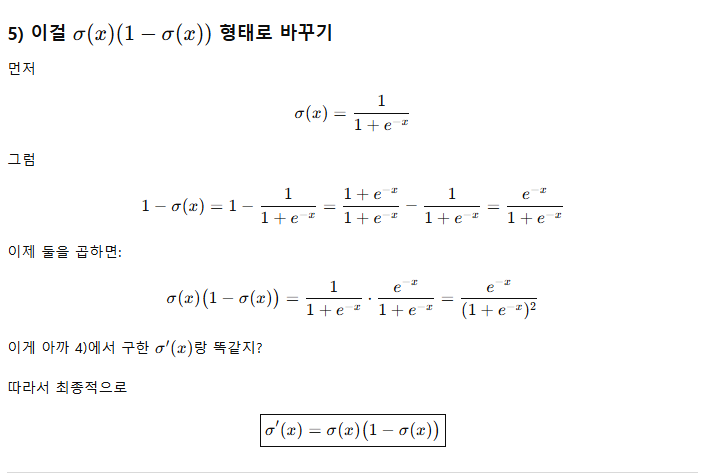

시그모이드 함수의 미분