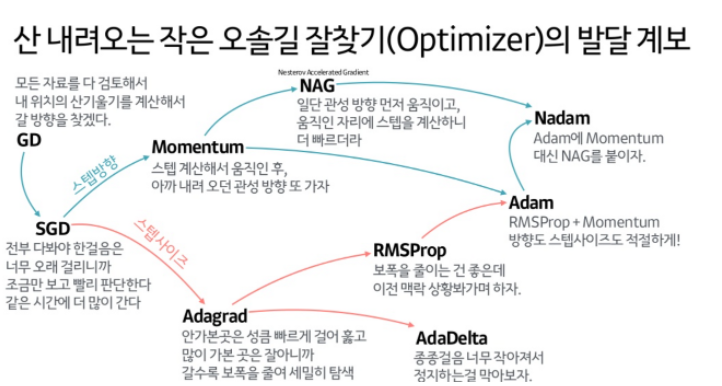

Optimizer

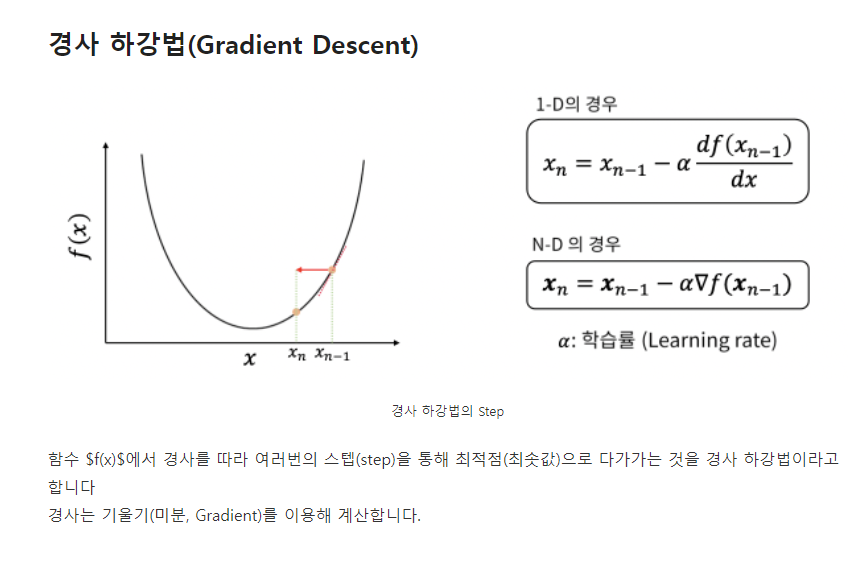

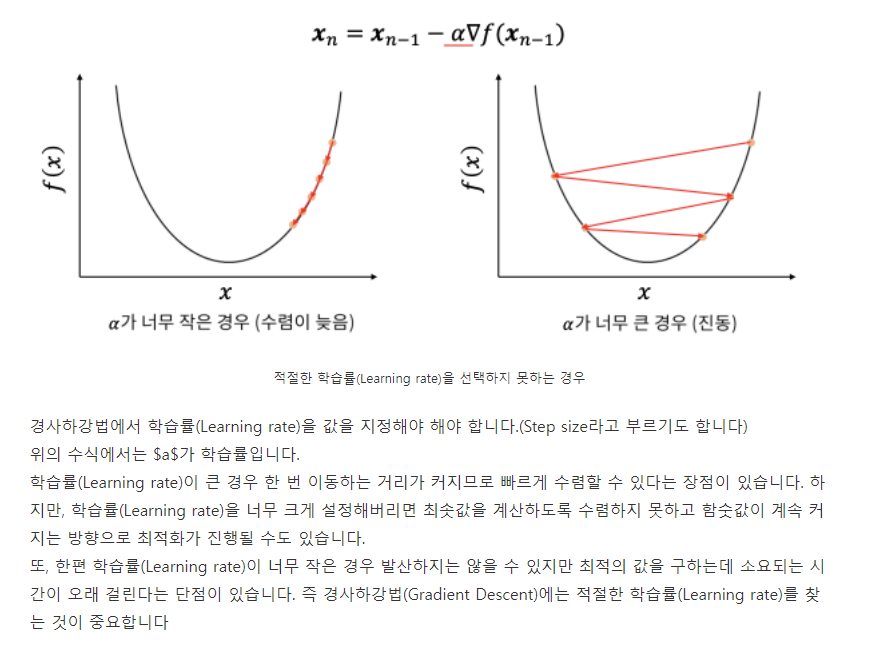

- GD (Gradient Descent)

단순 GD의 문제점

관련 paper 소개

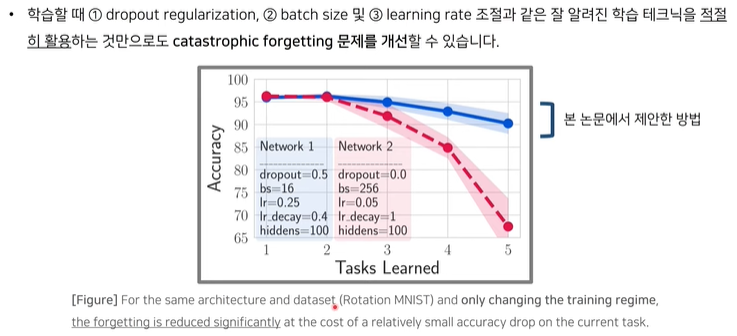

Stable SGD: Understanding the Role of Training Regimes in Continual Learning (NIPS 2020)

배경

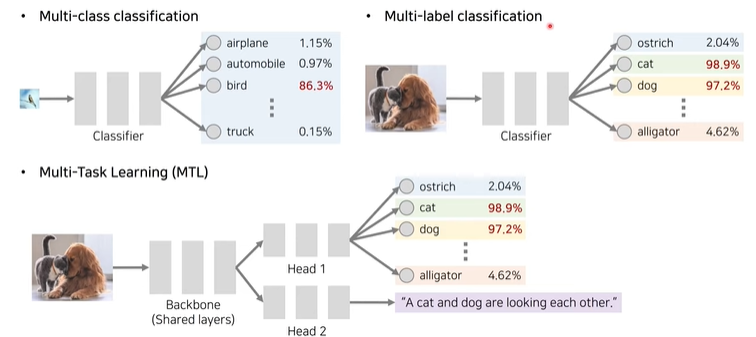

MTL

ex) object detection

하나의 입력 -> 여러개의 output, task 처리

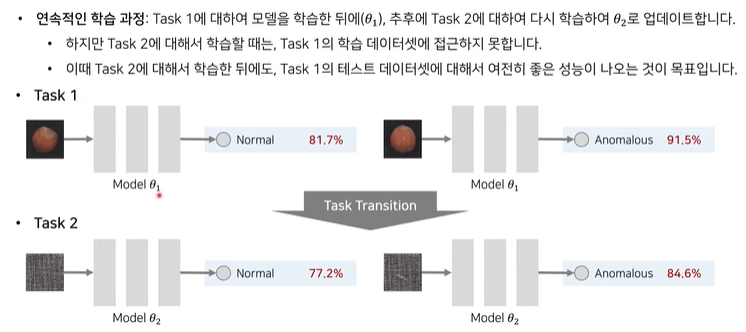

continual learning(연속 학습)

여러개의 task를 처리

단, 앞의 task에서 좋은 성능을 낸다는 것이 보장되어 있어야 함.

여기에는 파괴적 망각(이전의 Task에서 학습했던 것을 잊는 현상)의 문제가 존재함.

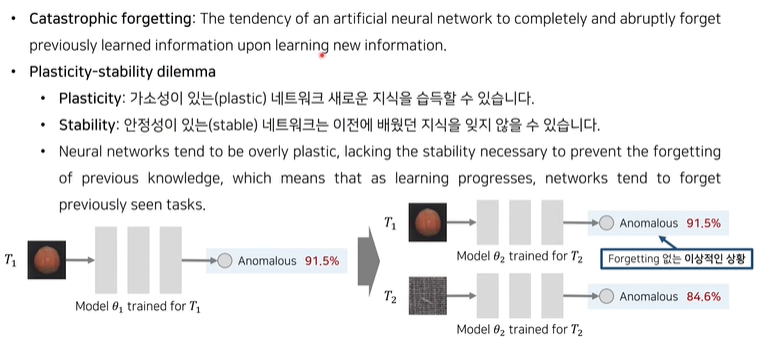

Catastrophic Forgetting(파괴적 망각)

새로운 task에 대한 학습은 수월하겠지만, 이전에 학습한 task에 대해 잊는 현상

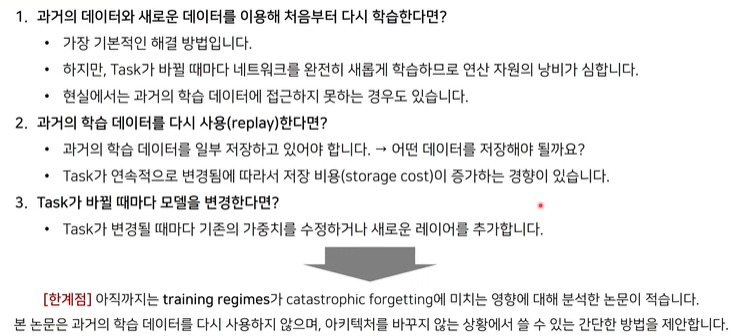

[연구배경] 파괴적 망각 예방 방법