오늘도 이어서 https://ratsgo.github.io/speechbook/docs/phonetics/acoustic 를 참고하여 공부한다 !!

2 Phonetics

사람 말소리에 대한 이해 !!

개요

- 언어학 => 말 소리 체계적인 설명 위해

- 음성학 (Phonetics)

- 말의 실체에 물리적으로 접근해, 기술/분석하는 분야

- 물리적인 말소리 생성 / 음향&인지 초점

- 음운론 (Phonology)

- 음성학 (Phonetics)

Phonetics

음성학

-

사람이 말할 때 이용하는 소리를 물리적으로 분석

- 예) 말소리 위해 만들어진 기관 관찰, 말소리 분류, 음파가 뇌로 전달되는 과정 등

-

세부 분야 => 음향음성학 중심 !!으로 보자 !!

- 조음음성학:

- 말이 어떻게 만들어지나에 대한 연구 분야

- 각 언어의 말소리를 만들기 위해, 사람 몸의 어떤 기간, 어떤 부분을 어떤 모양으로 움직이어야 하나? 연구

- 음향음성학

- 말소리의 물리적 특성 연구하는 분야

- 음향 분석기 등을 이용해 -> 발음 하는 기관들의 움직임에 따라 변하는 말소리의 음파 분석 및 연구

- 청취음성학

- 말소리를 인지하는 과정에 대한 연구 분야

- 말이 귀를 통과하는 과정, 해석하는 과정 연구

- 공기를 통해 전달되는 말소리의 파형은 청자의 귀로 들어오면 고막을 울리고, 고막의 울림이 세포를 진동시키는데, 이 진동이 신경을 거쳐 뇌에 이르면 말소리가 전달하고자 하는 '의미'가 해석되게 됨

Phonology

음운론

-

말소리의 물리적인 실체를 다루기 보다는, 언어를 쓰는 사람의 머릿속에 있는 말소리에 대한 지식을 체계적으로 기술+ 설명하는 분야

- = 개별 언어에서 쓰이는 말소리의 특징 + 언어를 쓰는 사람이 가진 말소리에 대한 지식

- 설명방법이 심리적, 추상적이긴 함

- 그건, 음운론에서 설명하려는 지식이 인간의 머릿속에 있기 떄문

-

음운론과 관련한 주제로는,

- 언어의 뜻을 구별해주는 최소 단위인 "음운의 설정"

- 음운들 사이의 관계를 파악하는 "음운 체계의 확립"

- 의미를 가진 최소 단위인 형태소가 결합되었을 때 일어나느 "음운 변동의 문제" 등

2-1 Acoustic Phonetics

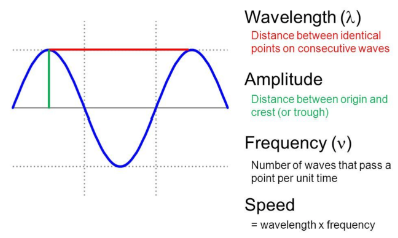

Wave

- = 파동

- 반복적으로 진동하는 신호

- 종류

- 단순파 (하나의 웨이브), 복합파 (여러 웨이브)

- 푸리에 정리에 따르면, 복잡해보이는 웨이브라도 사인,코사인의 합으로 표현 가능

-

단순파 (파란색)

-

x축: 시간 (초) / y축: 음압 (공기 입자가 진동에 의해 인접 공기 입자를 미는 힘)

-

음압

- => 녹음은 사람의 말이 음성 마이크에 달린 진동판을 울리면서 진행됨

- 이런 진동판의 떨림이 전기신호를 강하게?약하게 하는 정도가 => y축

- => 녹음은 사람의 말이 음성 마이크에 달린 진동판을 울리면서 진행됨

-

진폭: 웨이브의 최대값(녹색)

-

사이클: 패턴의 반복

-

주기" 한 사이클을 도는데 걸리는 시간(빨강)

-

주파수: 1초에 몇 번 주기가 반복되는가 (cycles per second => 헤르츠 라고도 부름)

- (주파수 = 헤르츠)

-

주기(T) = 1/f(주파수)

-

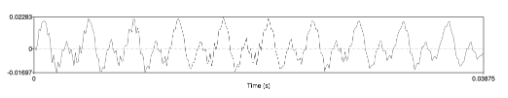

사람 말소리

-

주기가 길고/짧은 여러 개의 단순파의 합 => 복합파 형태로 나타나짐

-

주파수 계산 가능 (반복되는 패턴 통해)

-

예) 사이클 10회 반복까지 0.03875초 걸려서 -> 웨이브 주파수는 10/0.03875 = 258Hz

Digitization

Q. 말소리를 디지털 신호로 어떻게 변환할까? (음성신호의 디지털 변환)

- 웨이브 -> 아날로그 형태

- 자연에서 얻은 신호 -> 연속적인 값

- 둘이 다르네? 근데 자연에서 얻은 신호를 컴퓨터가 처리하려면 "디지털로 바뀌어야 됨"

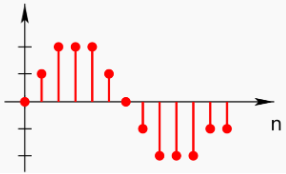

1. Sampling

-

일정한 시간 간격마다, 음성 신호를 샘플해

- 연속 신호 -> 이산신호 변환

-

1초에 몇 번 샘플하는지 나타내는 지표 = sampling rate

- 예) 1초에 44100번 샘플 -> sampling rate는 44.1KHz

-

말소리를 전송, 녹음했다가 재생하는 경우가 있음

- 이때 디지털 변환을 위해, "샘플링"을 거치게되어, 신호의 정보량이 일부 손실되게 됨

- 근데 이때 만약에, 샘플링된 신호로부터, 원래 신호로 복원하고 싶다면? (어떻게 해야 최대한 자연스럽게 가능할까?)

-

해결책: 나이퀴스트 정리

- 신호가 가진 최대 주파수의 2배 이상으로 샘플링하면, 원래 신호 재생이 가능해진다 !!

- 사람의 가청 주파수 영역대 20~20000Hz 정도

- 만약 40000Hz 이상의 sample rate로 샘플링을 하면, 사람이 들을 수 있는 거의 모든 소리 복원이 된다는 으미 !

- 목표 음성 신호의 최대 주파수 (20000Hz) = 나이퀴스트 주파수

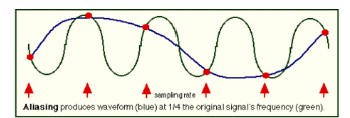

그런데 "문제가 있어서" 등장한, [Anti-Aliasing]

- 나이퀴스트 정리로 샘플링을 하면, 음성 복원에 이론적으로 문제 X

- 그러나, 자연의 소리에는 나이퀴스트 주파수(목표 주파수) 보다 높은 주파수 성분이 있을 수도 있음

-

나이퀴스트 정리 기반, 6번 샘플링 (빨간 화살표)

- 원래 신호 (초록색)이 더 높음

-

그러면, 복원한 결과(파랑) => 왜곡생김

-

샘플링 때문에, 저주파로 왜곡된 나이퀴스트 주파수(여기서는 파란색)보다 높은 원래 신호의 고주파 성분을 => "alias frequency", "ghost frequency"

-

그래서 왜곡 현상 막기 위해 "Anti-aliasing filter" 사용

- 샘플을 수집하기 이전 아날로그 신호에 적용

- 나이퀴스트 주파수보다 낮은 주파수 영역대만 통과시키는 bandpass filter를 사용해, 샘플링도 전에 미리 높은 주파수 영역대를 없애버림 !!

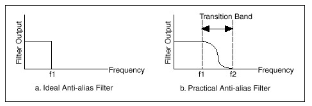

(a) 주파수 도메인에서 이상적인 "bandpass filter"

문제점 -> 이렇게 사각형 모양이 되려면, 시간 도메인에서 필터의 길이가 무한해야 함 (시간이 무제한으로 있어야지, 계속 높은 애들을 필터링 할 수 있다는 뜻인건가?????)

(b) 현실적으로 쓰는 "bandpass filter"

- CD 음질의 sample rate = 44.1Hz -> 왜?

- 사람의 가청 주파수가 20~20000Hz

- 나이퀴스트 정리에 따라 목표 주파수 (20000Hz)의 2배를 샘플링해야 원래 신호 복원 가능

- 시간 도메인에서 유한한 길이의 bandpass filter를 쓰기 위해 transition band가 존재하게 되고, 이런 주파수 영역대가 추가로 필요함

Quantization

2. 샘플링된 신호에 양자화 실시

- 양자화: 실수 범위의 이산신호 => 정수 이산신호

-

예) 8비트 양자화 -> 실수 범위의 이산신호 -128~127 사이 정수 / 16비트 양자화 -> 실수 범위 이산신호 -32768~32767 사이 정수

-

양자화 비트수가 커지면 => 원래 음성 신호 정보 손실 줄일 수 있음 (장점) + 저장 공간 늘어남 (단점)

-

양자화 잡음(noise): 양자화 실시에 따른 정보 손실

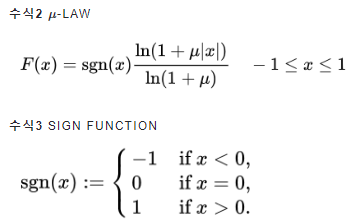

- 양자화 잡음 줄이고자 => 압신(companding) 기법 사용 (정보 압축과 해제 관련해서 규칙 정했다 ~~ 이런느낌)

- 압신 = 압축 (compression) + 신장 (expanding)

- e.g.,) μ-law

- 압신 = 압축 (compression) + 신장 (expanding)

- 양자화 잡음 줄이고자 => 압신(companding) 기법 사용 (정보 압축과 해제 관련해서 규칙 정했다 ~~ 이런느낌)

-

양자화 대상 실수 범위의 이산신호 (x) -> 해당 신호를 양자화하는 함수 F

- 양자화 비트 수 = 8 이면 => μ = 255

- 양자화 비트 수 = 8 이면 => μ = 255

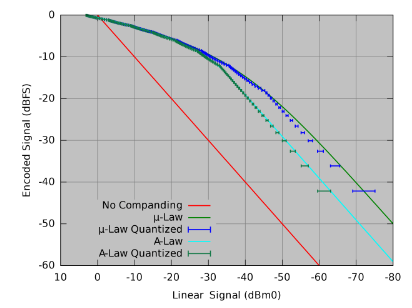

- x축: 양자화 이전 실수 범위의 이산신호 / y축: 양자화 이후 정수 범위의 이산신호

- 결과

- 압신 기법 없으면(빨강) -> 양자화 이전, 이후의 신호범위는 선형관계임

- μ-law로 압신하면 => (1) 입력 신호의 값이 작으면 조밀하게 양자화, (2) 신호 값이 크면 듬성듬성 양자화 (파란색이 앞쪽에서는 조밀한데 -50 뒤쪽은 좀 범위 커지는 그거네)

- 진폭이 작은 입력신호 => 양자화 계단 크기를 적게 (입력신호가 작으면 양자화가 조밀하게 되니까)

- 진폭이 큰 입력신호 => 양자화 계단 크기를 크게

- 사람은 진폭 작은 신호는 세밀하게 인식하고, 큰 신호는 덜 세밀하게 인식하는 경향 있음

- 사람이 듣기에 자연스럽게 음성 신호를 압축/해제 하는 것이 목표이므로, μ-law가 좋은 압신방법임 (파란색, A-Law보다 상대적으로 작은신호는 세밀하게 큰 신호는 덜 세밀하게 인식하는게 그림에 나와져있다 !!! 그 얘기네)

Encoding

- 인코딩: 정보 소스를 디지털 형식으로 변환/압축/저장하는 일련의 과정

- 입력 신호를 전송/처리 가능한 형태의 파일로 변환

- 예) wav(압축 안한 오디오 포맷), flac(무손실압축), mp3(손실압축)

Loudness

- Loudness: 어떤 소리가 크다/작다고 느끼는 것 => 음성 신호의 파워와 관련

- 파워 = 신호의 진폭과 직접적 관련

- 사람의 진폭이 큰 음성신호 = 큰/시끄러운 소리로 인식

- 파워 = 신호의 진폭과 직접적 관련

-

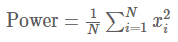

이산 신호 샘플 수 (N)개 일때 power의 수식

-

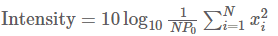

power외에 intensity라는 지표도 자주 쓰임

=> 해당 지표를 통해, 사람이 들을 수 있는 가장 작은 소리 (P_0) 대비 데시벨(dB) 기준으로 power가 얼마나 큰지 확인 가능

[decibel]

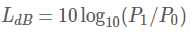

- 벨 = 어떤 값과 값 사이의 상대 비율을 나타내는 단어 (소리 크기 나타낼 때 사용)

- 실생활에서 그대로 쓰기에 너무 커스 -> 10분의 1벨 "데시벨"을 주로 사용

- 사람이 인식하는 가장 작은 소리의 진폭을 P_0(2 X 10^(-5)), 측정 대상 소리 P_1

- 데시벨은,

이렇게 정의

이렇게 정의

- 데시벨은,

- loudness, power는 선형 관계 X

- 사람은 power가 작은 음성신호를 power가 큰 음성신호에 비해 세밀하게 인식함

- 사람은 특정 주파수 영역대의 신호는 상대적으로 큰 소리로 인식함

- => loudness는 power + 주파수랑도 관련

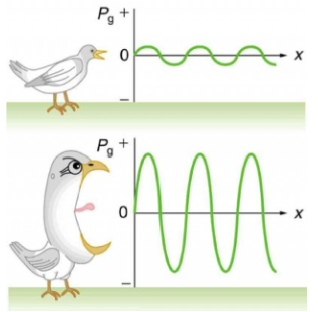

Pitch

-

피치: 말소리의 높낮이

- 입력 음성 신호의 주파수와 관련

-

사람은 100Hz~1000Hz에 이르는 구간의 소리는 -> 주파수가 커질 수록 피치도 높아진다고 느끼는 경향 있음

- "그런데" 1000Hz 이상의 구간에서 -> 주파수와 피치 인식 사이의 관계는 로그 형태임

- = 1000Hz 이상의 구간에서 -> 주파수가 100배 정도 되어야 높낮이 차이를 2배라고 느끼는 정도

- => 결론: 사람은 1000Hz 이상의 고주파 소리에 대해, 세밀하게 인식 못함(저주파 대비)

- "그런데" 1000Hz 이상의 구간에서 -> 주파수와 피치 인식 사이의 관계는 로그 형태임

-

전체 주파수 영역대를 사람이 인식하는 피치의 단계로는 못나눌까?

- 예) 10개로 나눈다면? -> 1~2단계, 9~10단계 어디던, 사람이 인식하는 말소리 높낮이 차이를 거의 비슷하게 두도록 하자

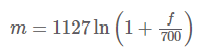

- => 멜 스케일 도입 (그니까 사람이 고주파를 세밀하게 인식 못하니까 임의로 나누어서 비슷하게 바꾸어버리자는건가?)

- 사람이구분 잘하는 1000Hz 이하는 선형에 가깝게 세밀하게! / 분간 잘못하는 고주파는 듬성듬성하도록 => 멜스케일이 변하는 그런 값을 나오도록 수식짜버림

- 사람이구분 잘하는 1000Hz 이하는 선형에 가깝게 세밀하게! / 분간 잘못하는 고주파는 듬성듬성하도록 => 멜스케일이 변하는 그런 값을 나오도록 수식짜버림

Vowels

-

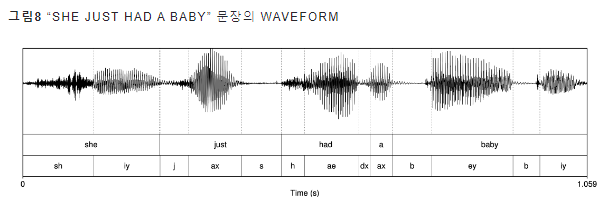

예) She just had a baby

=> 모음이 진폭 크고, 패턴 규칙적 (자음보다) -

왜?

- 모음은 음절의 핵 역할을 해서! (모음 없이 음절 구성 불가능, 모음 짱 중요 !!)

-

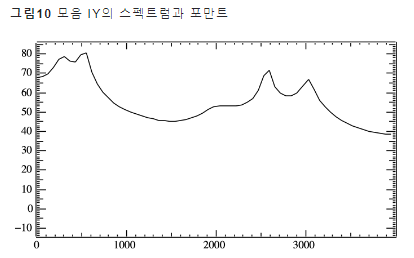

모음 iy(시간 도메인의 웨이브)에 푸리에 변환(Fourier Transform)을 수행해 주파수 도메인으로 변환하면 -> 패턴 !

(x축 주파수, y축 진폭)

(이 그림은 화자가 맨 마지막 단어의 마지막 음소(iy)를 발화할 때의 순간의 스냅샷? -> 그걸 스펙트럼으로 분석했다고 이해해보자 !) -

스펙트럼: 특정 시점의 입력 음성 신호를 주파수 도메인으로 변환한 것

-

포만트: 그림 10의 스펙트럼에서 음향 에너지가 몰려있는 각각의 봉우리

- 540Hz, 2581Hz => 각각을 "1번 포만트 F_1", "2번 포만트 F_2"라 함 (낮은 주파수부터 차례대로 번호 부여함)

- 모음의 특질을 구성하는 중요 요소 (사람이 포만트가 같으면 동일한 모음으로 생각해서)

-

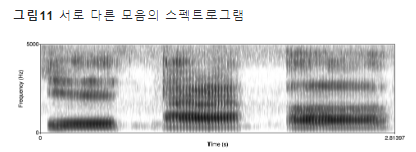

x축 시간, y축 주파수, 명도 - 진폭

-

동일한 화자가 발화한 모음 ih, ae, uh 스펙트로그램

- 스펙트로그램: 특정 시점의 스펙트럼을 시간 순서대로 쭉 이어 붙인 것

-

음성 인식

- 목적: 컴퓨터에게 말소리를 사람이 느끼는 것처럼 따라하게 만들기

- 사람의 말소리 인식에서 중요한 "포만트" 정보를 얼마나 잘 처리하냐가 성능을 좌우할 수 밖에 없음

-

말소리: 여러 주파수로 구성

-

기본 주파수: 주파수에서 최대공약수 (말소리의 특색을 결정하는 데 중요한 역할을 함)

-

배음: 기본 주파수에 정수배에 해당하는 주파수

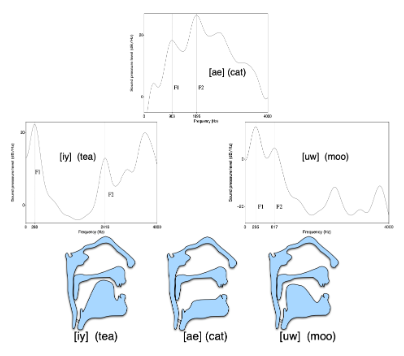

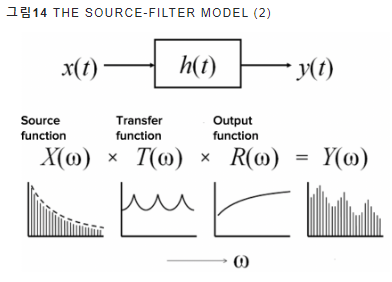

The Source-Filter Model

-

정의: 음성학에서 사람의 말소리가 생성되는 과정을 모델링한 이론

-

사람의 성문을 Source, // 소스, 혀 입술 등 조음기관을 Filter

-

예) 모음 iy, ae, uw 는 사실 같은 source에서 파생되었지만, 조음 방법에 따라 (Filter가 바뀜에 따라) => 말소리가 달라짐

- 발음해보면, 입술모양/혀는 바뀌지만 성문에서 나오는 소리는 동일

- 발음해보면, 입술모양/혀는 바뀌지만 성문에서 나오는 소리는 동일

- 사람은 각기 다른 source 가지지만, 같은 사람이 내는 소리는 거의 비슷함

- 혀, 입술, 잇몸 같은 조음 기관들도 주파수를 가지고 있음

- 공명(reasonance): 성문에서 발생한 소스가 필터를 지나면서, 특정 주파수가 증폭/감쇄되는 현상

- 이 때 모음의 특질을 결정하는 포만트가 형성됨

- 이 때 모음의 특질을 결정하는 포만트가 형성됨

- 예) 2개 source, 2개 filter => 서로 다른 소리 내는 것

- source가 다르면 -> 음색/피치가 달라짐 / filter 가 다르면 -> 모음 종류가 달라짐