확률론을 배워야 하는 이유?

- 딥러닝이 확률론 기반의 ML 이론에 바탕을 두고 있음

- Regression: L-2 norm으로 예측오차의 분산을 최소화하는 방향으로 학습

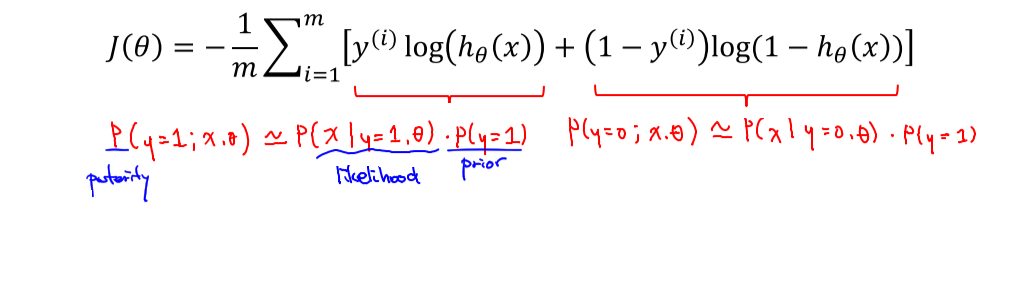

- Classification: cross-entropy로 모델 예측의 불확실성을 최소화하는 방향으로 학습

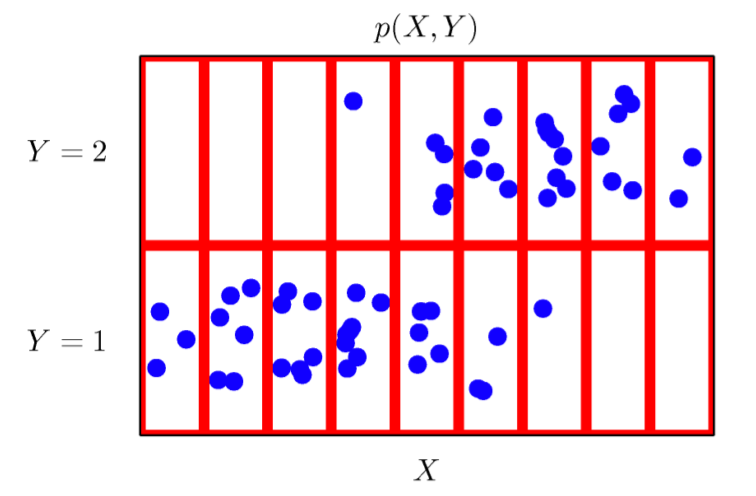

확률분포

- 데이터를 표현하는 초상화

- X × Y: 데이터공간

- D: 데이터공간에서 데이터를 추출하는 분포

- (x, y) ~ D: 데이터, 그림 상에서 파란색 점에 해당

- (x, y) ∈ X × Y: 데이터공간 상에서 관측가능한 데이터

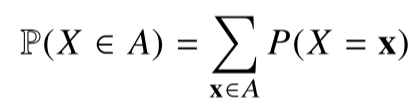

이산확률변수 vs 연속확률변수

- 확률변수는 D에 의해 결정된다

- P(X=x): 확률변수가 x값을 가질 확률

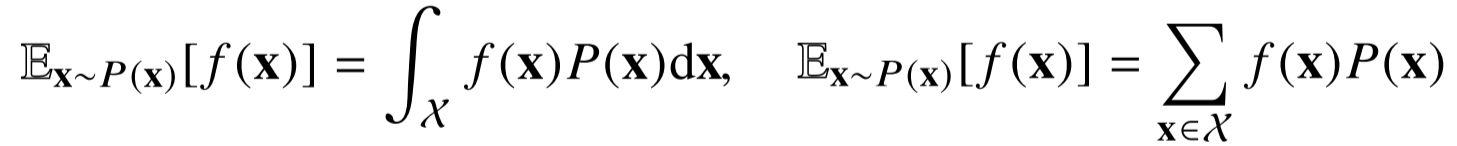

- 이산(discrete) 확률변수: 확률변수가 가질 수 있는 모든 경우의 수를 고려해 확률을 더해서 모델링

- 연속(continuous) 확률변수: 데이터공간에 정의된 확률변수의 밀도(density)위에서의 적분을 통해 모델링

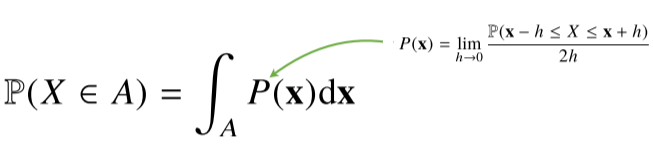

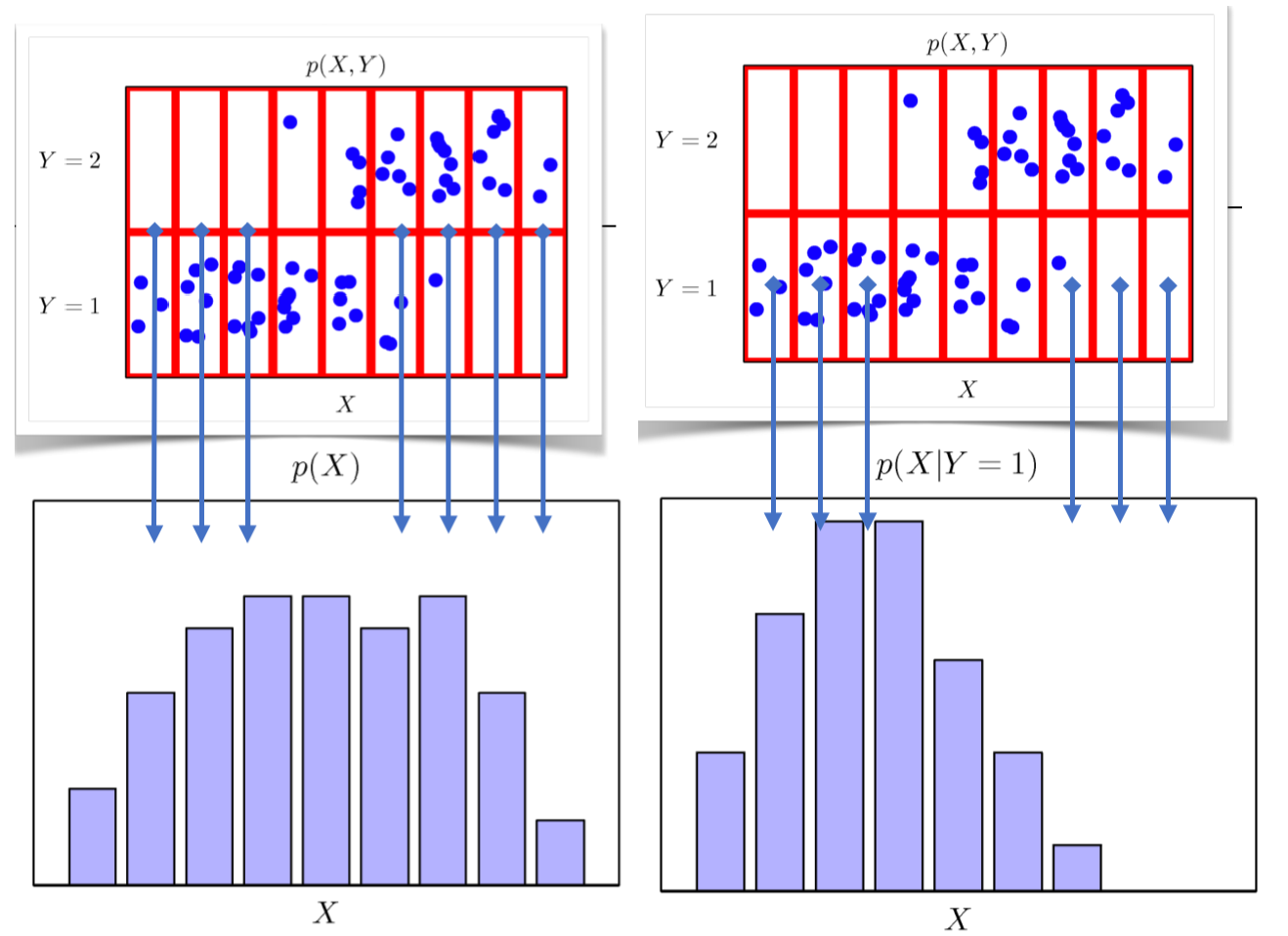

결합분포

- P(x, y): 결합분포. D를 모델링한다.

Y의 범위, X의 범위에 따라 존재하는 데이터(파란 점)의 갯수를 모델링한다.

원래 확률분포가 이산/연속이든 상관없이 모델링 방법에 따라 이산/연속을 결정할 수 있다.

- P(X): 주변확률분표(marginal distribution). 입력 X에 대한 정보만 줄 뿐 y에 대한 정보는 주지 않는다.

결합분포를 각각 Y에 대해 더해주거나, 적분을 해서 구할 수 있다.

Y에 대한 주변확률분포도 동일한 방법으로 구할 수 있다. - P(X|Y): 조건부확률분포. 특정 클래스가 주어진 조건에서 데이터의 확률분포를 보여줌.

좀 더 명확하게 통계적 관계를 유추할 수 있다.

조건부확률

- P(y|x): 입력변수x에 대해 정답이 y일 확률.

연속확률분포일 경우엔 확률이 아니고 밀도.

-

Logistic regression에서 사용했던 선형모델과 softmax 함수의 결합은 데이터에서 추출된 패턴을 기반으로 확률을 해석하는데 사용.

-

Classification: softmax로 조건부확률 P(y|x)를 계산

-

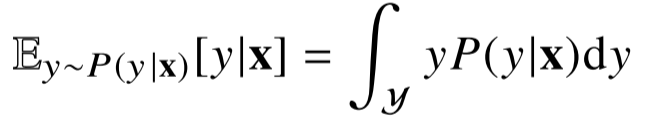

Regression: 조건부기대값 E[y|x]를 추정

조건부기대값은 E||y-f(x)||2를 최소화하는 함수 f(x)와 일치

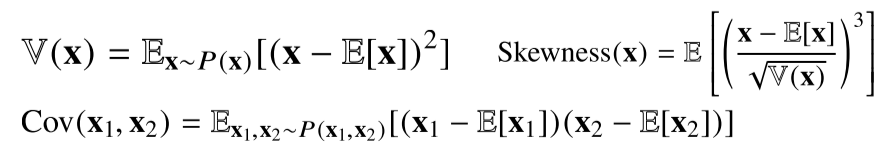

기대값

- expectation: 데이터를 대표하는 통계량.

확률분포가 주어지면 데이터를 분석하는데 사용 가능한 여러 종류의 통계적 범함수(statistical functional)을 계산 가능

- 분산, 첨도, 공분산 등 여러 통계량 계산 가능

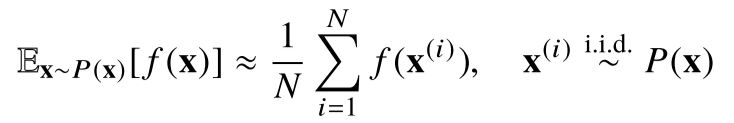

몬테카를로 샘플링

- 확률분포를 모를때 데이터를 이용해 기대값을 계산

- 이산, 연속에 상관없이 성립

- 독립항등분포(iid, independent and identically distributed)일 경우에만 성립한다.

- 독립추출만 보장된다면 대수의 법칙(law of large number)에 의해 수렴성을 보장

Loss / Cost / Objective function의 차이

- loss function: 손실함수, single data에 대한 grond truth와 estimated output 사이의 오차.

- cost function: 비용함수, 모든 data set에 대한 오차를 계산하는 함수.

- objective function: 학습을 통해 최적화를 시키려는 함수.

--> 즉 Objective Function >= Cost Function >= Loss function 이라고 볼 수 있다는 얘기.