모수란?

모수: 모집단의 특성(모평균,모분산 등..)을 나타내는 값

제한된 데이터(모수)로 모델을 만들어도 되는 이유: 데이터와 추정방법의 불확실성을 고려한 상태에서 예측의 위험을 최소화 하는 방향으로 학습하는 것으로 충분하기 때문!

모수적 방법론: 데이터가 특정 확률분포를 따른다고 선험적으로(a priori) 가정 후 그 분포를 결정하는 모수(parameter)를 추정하는 방법

비모수 방법론: 특정 확률분포를 가정하지 않고 데이터에 따라 모델의 구조 및 모수의 개수를 유연하게 바꾸는 방법

--> 모수가 무한히 많거나 계속 바뀌는 것이지, 모수가 없는 것이 아님!

- 확률분포 가정은 데이터를 생성하는 원리를 고려 후 모델을 선정해야함

데이터로 모수 추정하기

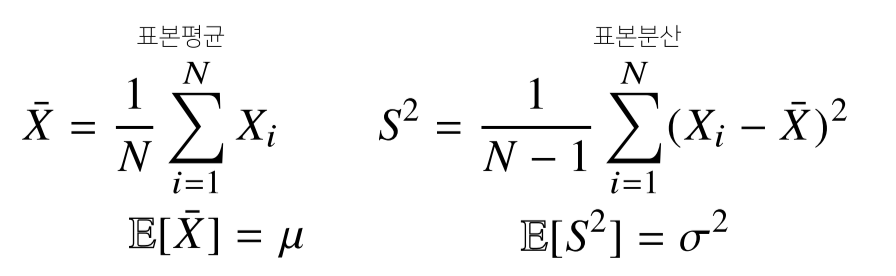

정규분포의 모수: 모 평균μ, 모 분산 σ2

통계량: 표본평균, 표본분산

- N-1로 나누는 이유는 unbiased 추정량을 구하기 위해서

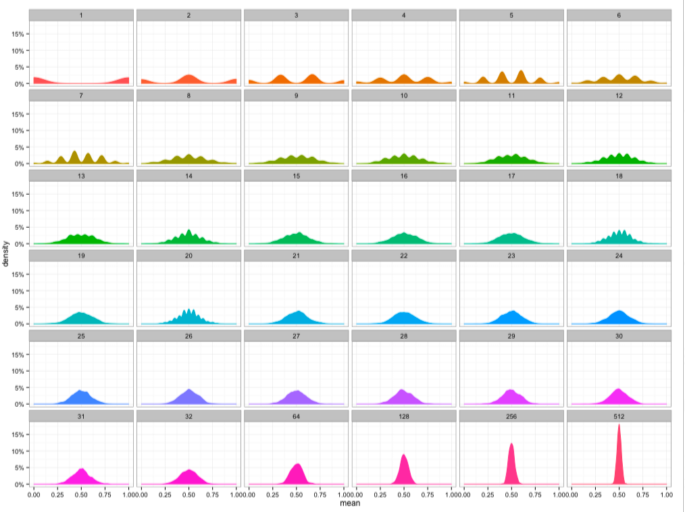

표집분포(sampling distribution)

- 통계량의 확률분포

- N이 커질수록 정규분포N(μ, σ^2)를 따름

--> 중심극한정리(Central Limit Theorem): 모집단의 분포가 정규분포를 따르지 않아도 표집분포는 정규분포를 따름, 표본분포는 모집단이 정규분포가 아니면 정규분포를 따르지 않음

실제 얻을 수 있는 모집단 분포,표본 분포와는 달리,

. 통계적 추론을 위해,

. 무수히 많은 기회 표본 집단에 대한 표본 통계량을 확률변수로 취하는,

. 이론적인 확률 분포

- 베르누이 분포의 표집분포. 데이터가 늘어날수록 정규분포를 향하는 것을 볼 수 있음, 평균은 중간으로, 분산은 작아짐

표본분포(sample distribution)

- 모집단에서 추출된 대상군의 확률 분포

표집분포와 표본분포의 차이

- Do not confuse the sampling distribution with the sample distribution. The sampling distribution considers the distribution of sample statistics (e.g. mean), whereas the sample distribution is basically the distribution of the sample taken from the population.

출처: https://towardsdatascience.com/data-distribution-vs-sampling-distribution-what-you-need-to-know-294819109796 - 표집분포: 모집단에서 추출한 sample data들의 분포도, 여러개 샘플들을 뽑아 각 샘플의 평균에 대한 분포

- 표본분포: 모집단에서 추출한 1개의 sample data의 분포

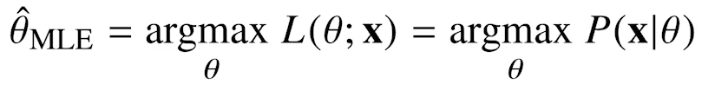

최대가능도 추정법(MLE, Maximum Likelihood Estimation)

원래 확률밀도함수는 모수θ가 주어져있을때 x에 대한 함수로 해석하지만 likelihood는 주어진 x에 대해 모수θ를 변수로 둔 함수.

data가 주어져있는 상황에서 θ를 변형시킴에 따라 값이 바뀌는 함수.

θ에 따라 x를 관찰할 가능성. θ에 대한 확률이 아니라 대소비교만 하는 느낌.

- argmax: 함수를 최댓값으로 만들기 위한 값.

- L(θ|x), 가능도함수, likelihood: 결과 x가 주어졌을때, parameter가 θ일 가능성

각 사건이 일어날 가능성(확률밀도함수)의 곱(정의) - P(x|θ), 확률밀도(질량)함수: parameter θ가 주어졌을때, 결과가 x일 가능성(probability)

- 참고: https://stats.stackexchange.com/questions/284816/why-do-people-use-mathcall-thetax-for-likelihood-instead-of-px-theta

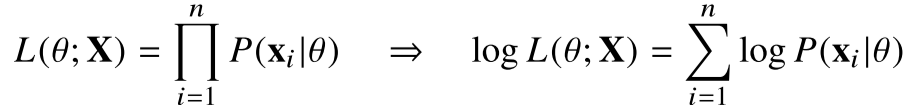

데이터집합 X의 각 행벡터가 독립추출 되었을 경우 확률질량함수들의 곱으로 표현 가능

--> log로 곱셈을 덧셈으로 바꿔줌(연산량, 정확도를 위해)

MLE가 unbias 추정량을 보장하진 않지만 consistency는 보장 가능

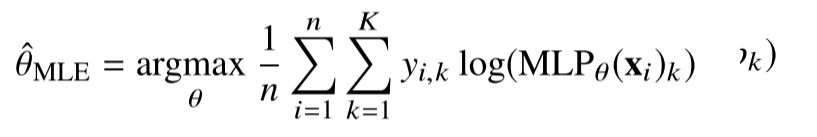

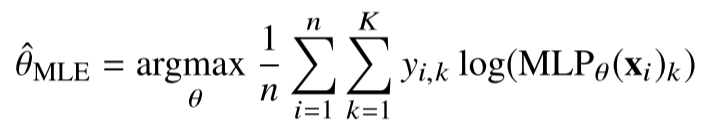

딥러닝에서 최대가능도 추정법

딥러닝 모델의 weight를 θ(W(1) ~ W(L))로 표현했을 때 분류문제(classification)에서 소프트맥스 벡터가 카테고리분포의 모수(p1 ~ pk)를 모델링

정답레이블 y를 원핫벡터로 표현해 로그가능도 최적화 가능

cost function은 모델이 학습하는 확률분포와 데이터에서 관찰되는 확률분포의 거리릍 통해 유도

--> Kullback-Leibler Divergence, KL을 이용

정답레이블이 P, 모델 예측이 Q일 경우 MLE == KL을 최소화 하는 것과 같다