HETFORMER: Heterogeneous Transformer with Sparse Attention for Long-Text Extractive Summarization

NLP Papers

목록 보기

2/33

Abstract

- 요약 테스크에 대한 논문

- 의미 그래프를 담기 위해서 GNN을 주로 사용했음

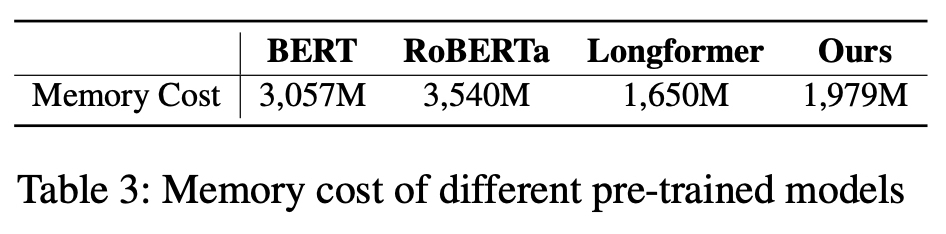

- 긴 텍스트에서 사용하기 위한 좀 더 효율적인 모델

- 적은 메모리와 파라미터로 Rouge, F1 좋은 점수를 냈다.

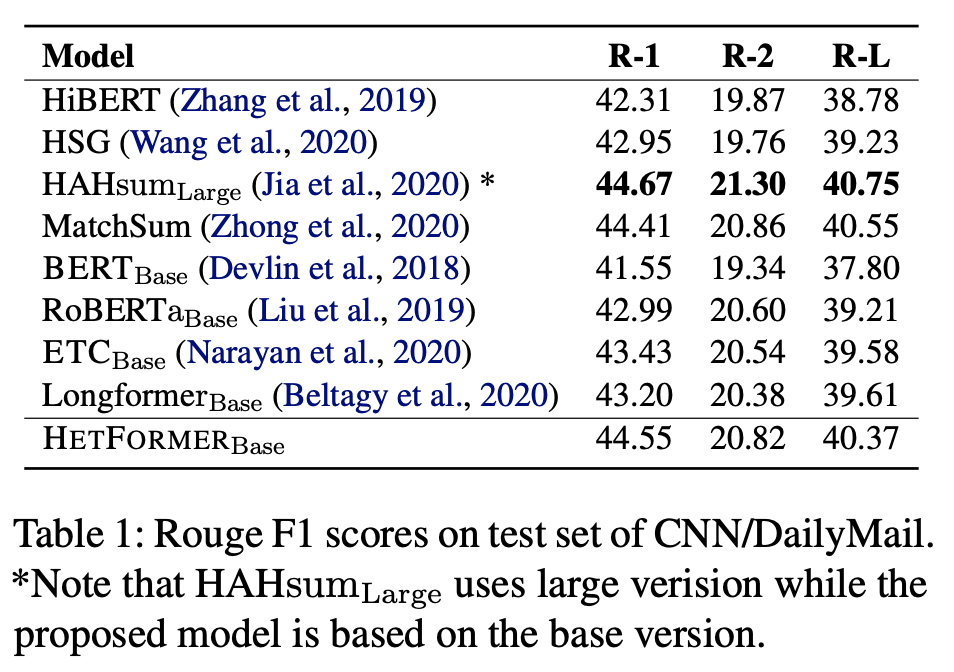

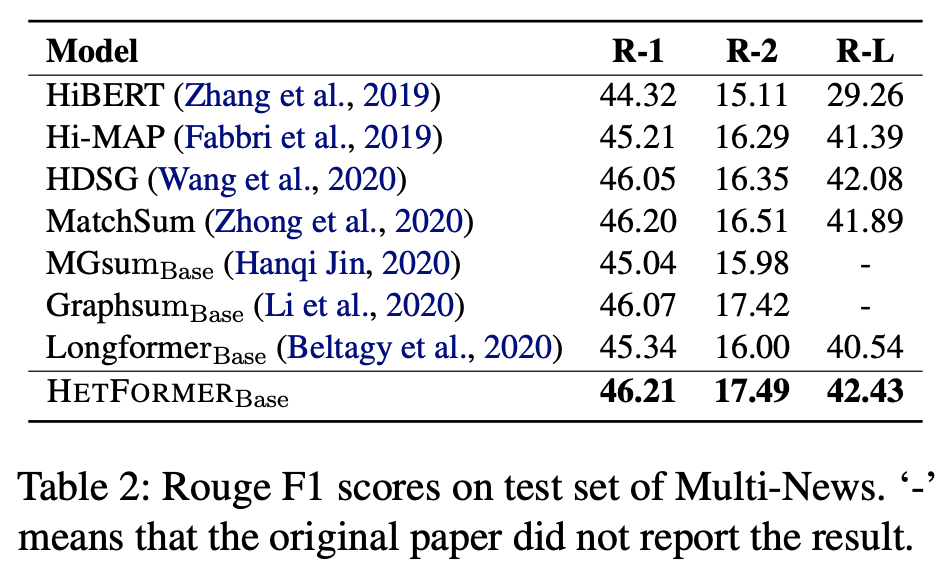

HETFORMER on Summarization

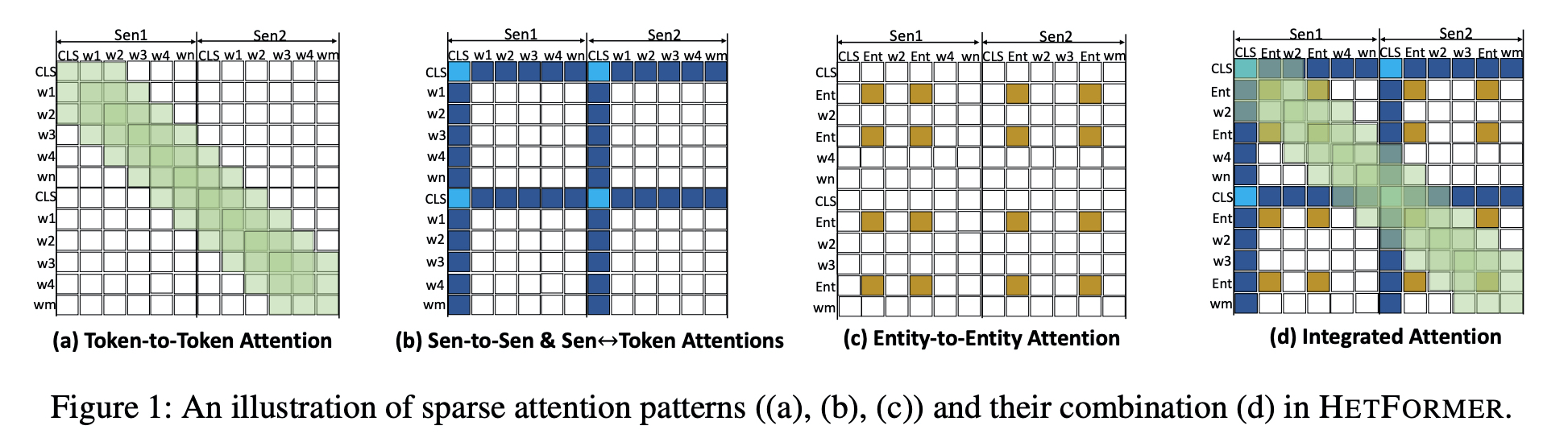

토큰, 문장, 엔티티 세 타입을 나누어서 그 관련성은 어텐션 행렬에 반영하고자 하였다.

아래와 같이 다섯 개의 관계성을 보고자 했으며, 각 타입 내에서 관계성, 토큰과 문장의 관계성을 보고자 하였다.

한 문단이 여러 문장으로 구성된다는 점을 각 문장 앞에 CLS 토큰을 놓아 사용하는 것으로 반영하였다. 문장 간의 관계를 포함하도록 하였다.

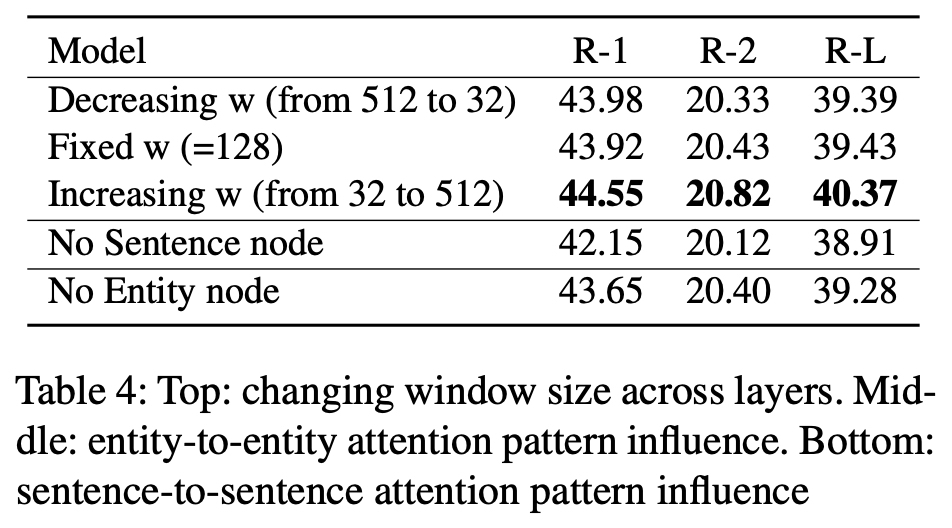

- token-to-token (t2t)

윈도우 만큼만 어텐션에 반영된다. - token-to-sentence (t2s), sentence-to-token (s2t)

- sentence-to-sentence (s2s, light blue)

- entity-to-entity (e2e)

같은 엔티티가 한 토큰에 담기지 않는 점을 해결하기 위해서 이 부분을 포함하였다.

전체 주제 내의 엔티티 간의 관계를 학습하기 위한 역할도 수행하였다.