Google research.

(들어가는 질문)

- Self-attention의 시간과 공간복잡도는?

- Self-attention의 시간과 공간복잡도가 그렇게 되는 이유는?

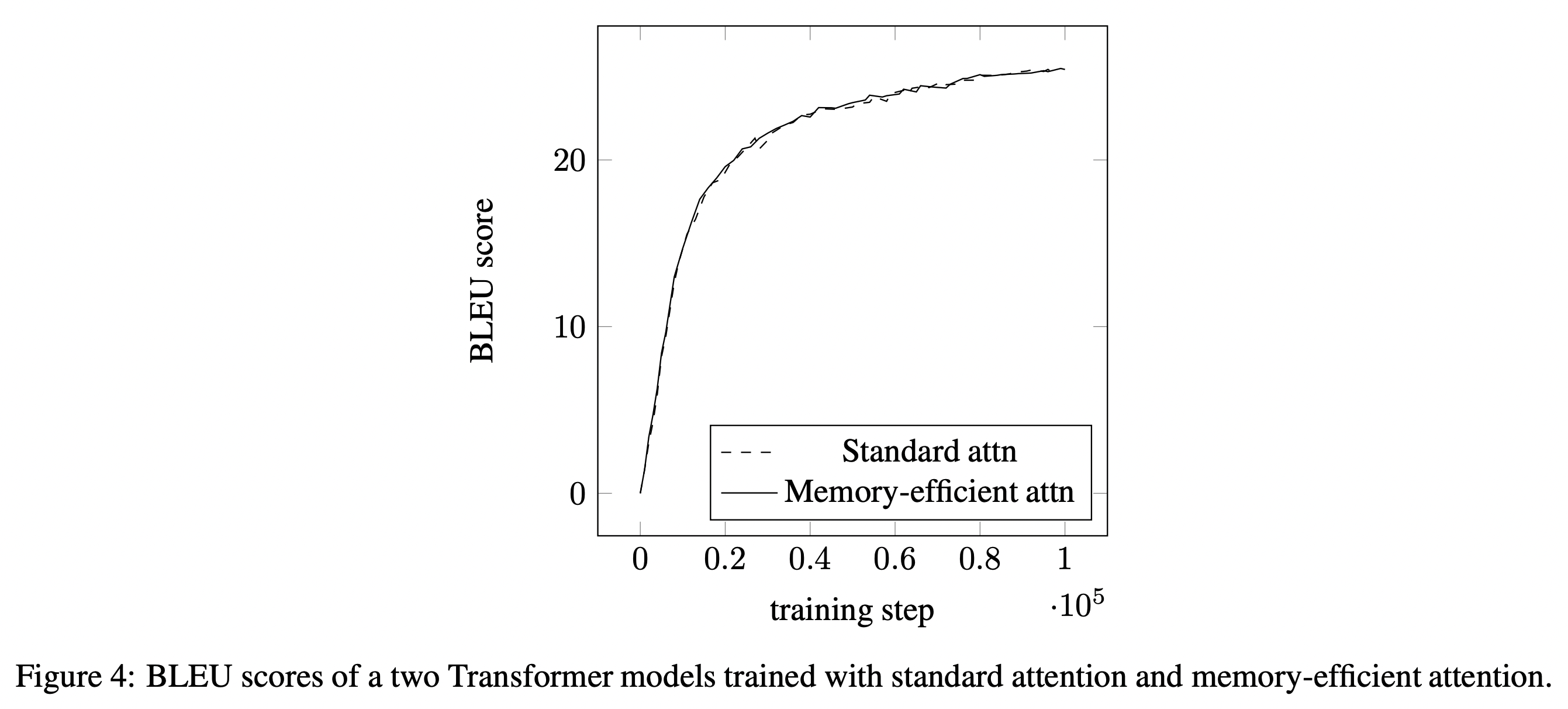

점수 차가 거의 없는 것을 확인할 수 있다.

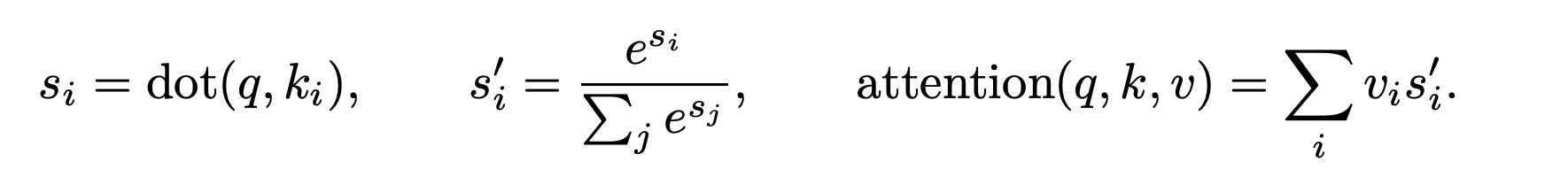

(질문) 아래 두 수식이 사실상 같은가?

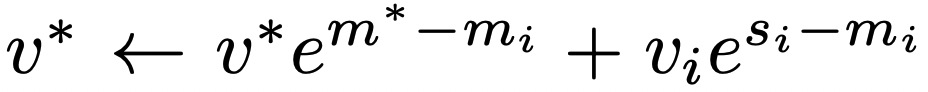

We initialize the vector ∈ and scalar ∈ with 0.

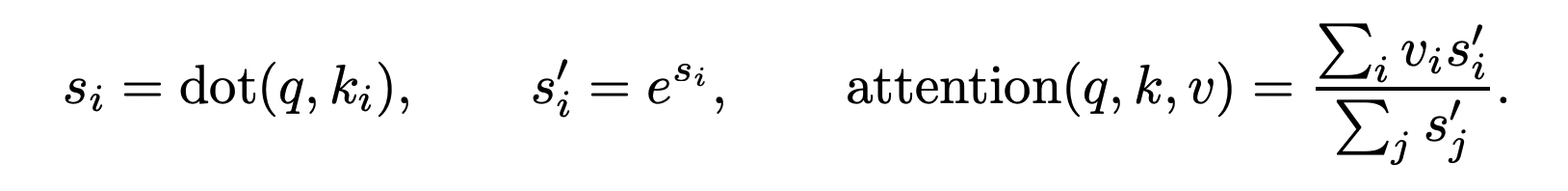

(질문)

- 위와 같이 , 업데이트 시킬 때에 가장 위 수식과 같은 계산을 하는가?

- 그렇다면 메모리 관점에서 얻을 수 있는 이득은?

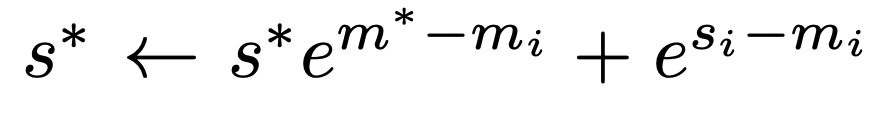

(질문)

- softmax 계산에서 수치적 안정성 문제가 발생하는 이유는?

- 수치적 안정성 문제를 해결하기 위해서 어떤 방법을 취할 수 있는가?

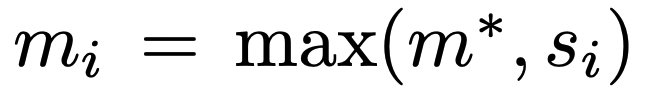

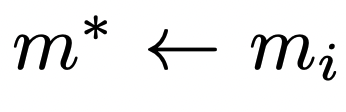

We initialize the vector ∈ and scalar ∈ with 0, and with .

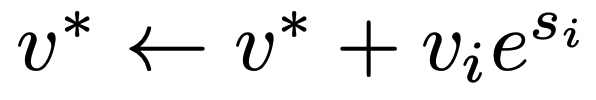

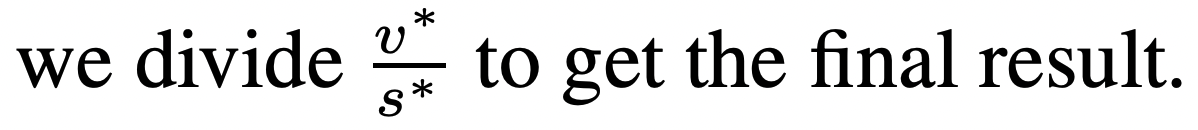

(질문)

- 위 수식에서 초깃값은?

- 위 수식에서 의 의미는?

- 다음과 같은 attention matrix 계산은 가장 위 수식과 동일한 결과값을 가져올 수 있는가?

- 이런 알고리즘이 TPU에서 parallel하게 동작할 수 있을까?