2차 회의록

안녕하세요, 텔레토비전입니다! 이전 회의에서 의논한 사항에 대해 각자 고민해보고 직접 실험까지 해보고 만났습니다. 공휴일 현충일에도 이렇게 열정적으로 회의하다니 최고의 팀원입니다!! 회의 사진은 제가 갑자기 찍었기에 다들 집중의 미간이 보이네요ㅎㅎ

2024년 06월 06일 (목) 회의록 시작하겠습니다.

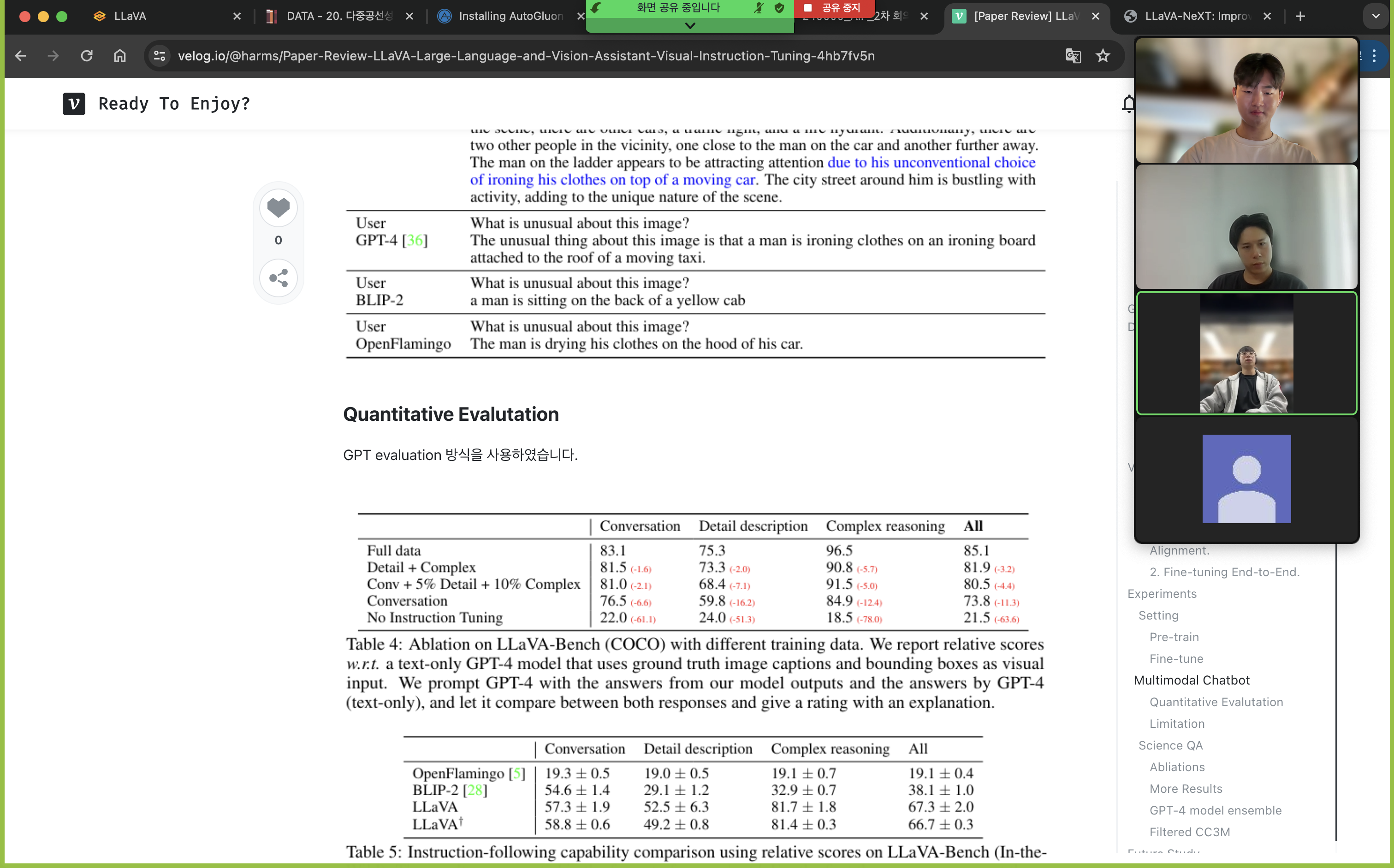

1. LLaVA 논문 리딩

첫 번째로, 팀원 모두가 베이스로 삼고 있는 LLaVA 논문을 읽고 완벽하게 이해하자는 목표를 두었습니다. 각자 블로그에 해당 내용을 정리하고 설명하는 시간을 가졌습니다. 제가 정리한 내용은 LLaVA 포스트에서 확인할 수 있습니다. 해당 논문에서 몇 가지 눈 여겨 볼 점이 있었습니다.

1. Generating Instruction-following Data Process with COCO

System message, fewshot example 을 어떻게 주었는지 정확하게 파악할 수 있었습니다.

2. Pre-training Visual Prompt Alignment with CM3M

실제 LLaVA 는 어떤 형식으로 visual input 에 대해서 text 와 align 시키는지 이해하고 넘어 갔습니다.

3. Fine-tuning LLM and Projection layer with #1 Data

LLaVA 가 지니고 있는 inductive bias 를 알고 저희의 프로젝트에 적합한지 확인할 수 있었습니다.

개괄적으로 말씀드렸지만, 논문 리뷰 포스트에 자세히 작성해두었습니다! 이렇게 팀원간 논문에 대한 리뷰와 인사이트를 공유하고 실험 파트로 넘어갔습니다.

2. Experiments using LLaVA

저의 Visual Instruction zero-shot 실험은 LLaVA Experiments 에 정리해 두었습니다.

실험의 방향성은 크게 2 가지로 두었습니다.

1. Visual Prompt + Image + Text Instruction 의 Zero-shot 성능

2. Temporal Image Input 에 대한 LLM 의 Zero-shot 성능

차례대로 간략히 살펴보겠습니다!

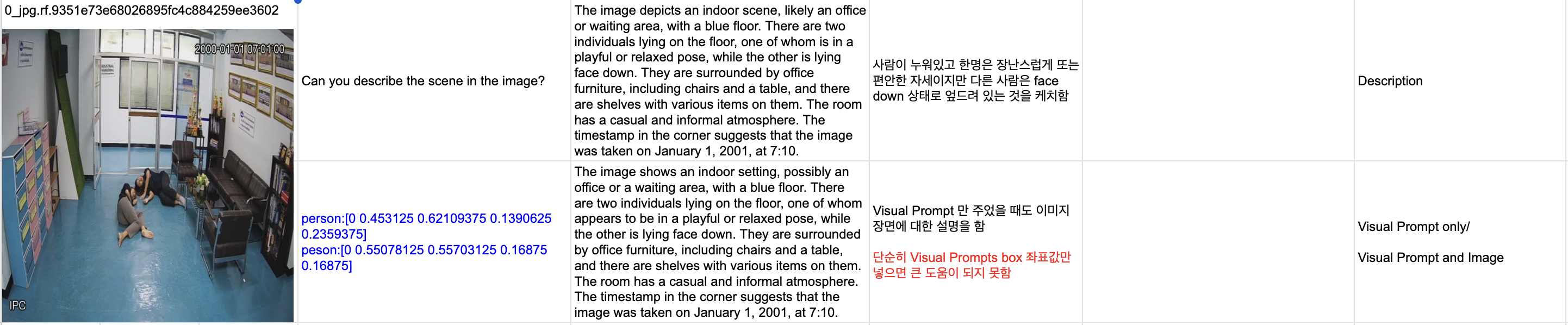

1. Visual prompt + Image + Text Instruction 의 가능성

Setting

Image: Roboflow 에 있는 Object Detection 데이터, Kaggle Human Action Video

Text Instruction: LLaVA 논문에서 제안한 Instruction 사용

Verbalization: MoAI 논문 에서 제안한 방법 사용

Meta Data: Bounding Box, Class label, In-context information 사용

실험 순서는

1. Text Instruction

2. Visual Prompt

3. Text Instruction + Visual Prompt

4. Text Instruction + Visual Prompt & Class meta information with Verbalization

결과를 살펴보면 첫번째 질문과 두번째 질문에 대해서는 답변 결과가 동일하며, visual prompt 에 대한 역할을 하고 있지 못함을 알 수 있었습니다.

반복된 이러한 결과에 MoAI 논문에서 제시된 verbalization 을 기반으로 instruction 을 주었습니다.

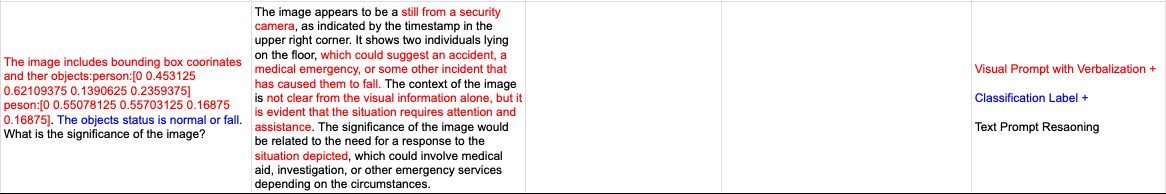

위의 이미지에서는 두 사람의 쓰러진 상황을 'playful or relaxed pose' 라고 설명하였으나 아래의 결과를 보면 정말 놀라운 점을 발견할 수 있습니다.

위의 이미지에서는 두 사람의 쓰러진 상황을 'playful or relaxed pose' 라고 설명하였으나 아래의 결과를 보면 정말 놀라운 점을 발견할 수 있습니다.

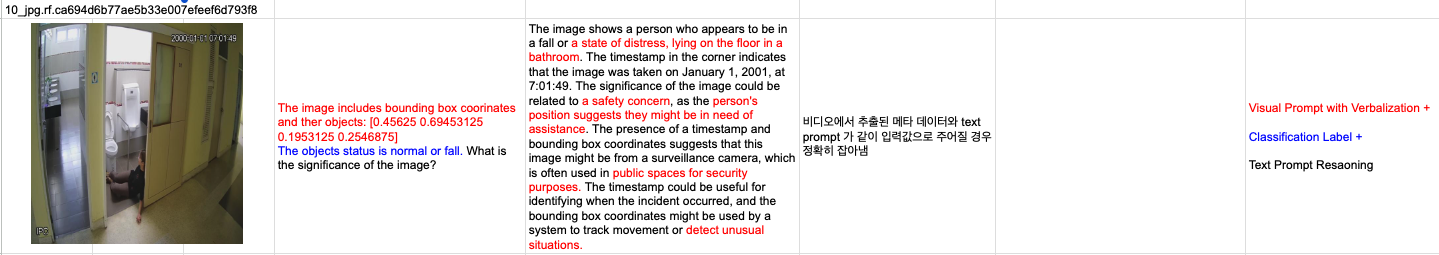

'still from security camera', 'medical emergency, or some other incident that has caused them to fall.' 현 상황에 대해서 LLM 이 정확하게 위험을 감지하고 있음을 볼 수 있습니다. 다른 예시를 하나 더 보여드리겠습니다.

저희 팀원 모두 깜짝 놀랐습니다. LLM 이 Zero-shot 으로 정확하게 상황을 파악하고 있음을 확인할 수 있었습니다.

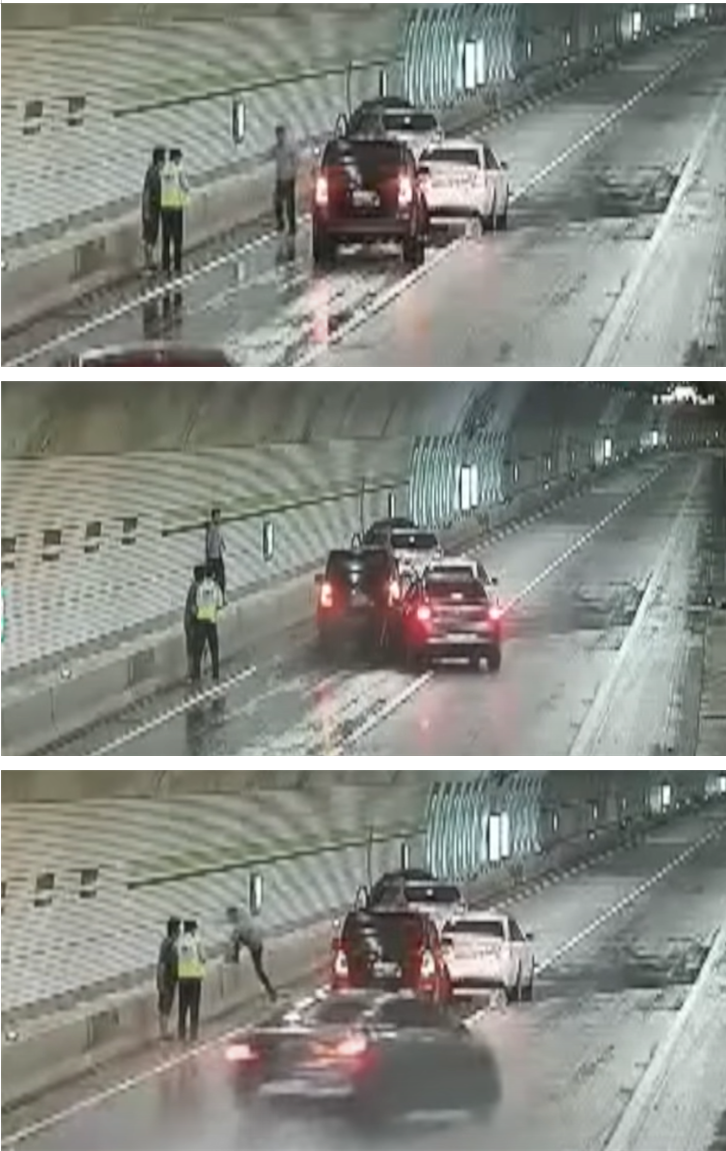

2. Temporal Image Input 에 대한 LLM 의 Zero-shot 성능

비디오의 연속된 이미지를 LLM 에 한번에 전달하기 위해 붙여넣어 입력하였습니다.

'''

제공한 이미지에는 자동차 사고로 이어지는 일련의 이벤트가 표시된 것으로 보입니다. 다음은 발생한 것으로 보이는 상황을 자세히 설명한 것입니다:

'''

제공한 이미지에는 자동차 사고로 이어지는 일련의 이벤트가 표시된 것으로 보입니다. 다음은 발생한 것으로 보이는 상황을 자세히 설명한 것입니다:

첫 번째 사진에는 비상등이 켜진 채 길가에 정차한 자동차가 보입니다. 차 근처에 운전자와 동승자 또는 도움을 주는 행인 두 명이 서 있습니다. 차량은 교통 흐름을 방해하지 않는 위치에 있으며, 도로가 젖어 있는 것으로 보아 최근에 비가 내린 것으로 보입니다.

두 번째 사진에서는 다른 차량이 정차된 차량에 빠른 속도로 접근하고 있습니다. 접근하는 차량의 운전자는 정차한 차량을 피하거나 추월하기 위해 차선 변경을 시도하는 것으로 보입니다.

세 번째 사진에서는 접근하는 차량이 정차한 차량과의 충돌을 피하기 위해 오른쪽으로 방향을 바꾼 것으로 보입니다. 그러나 운전자의 반응 시간이나 차량의 핸들링 능력으로는 사고를 방지하기에 충분하지 않았을 수 있으며, 차량이 도로를 벗어나 장벽과 충돌하는 과정에 있는 것으로 보입니다.

이 사고는 젖은 도로 상황으로 인해 트랙션이 감소하고 제동 거리가 늘어날 수 있으며, 운전자가 정지한 차량에 반응할 충분한 시간 없이 고속으로 차선을 변경하는 등 여러 요인이 복합적으로 작용하여 발생했을 가능성이 높습니다. 또한 마주 오는 차량의 운전자가 주의가 산만했거나 피곤했을 가능성도 사고의 원인이 될 수 있습니다.

'''

연속된 이미지에 대한 설명도 Zero-shot 으로 충분히 잘 이해하고 있음을 확인할 수 있었습니다.

3. 실험 결과

1. Visual Prompt 에 대한 활용 가능성 및 기대효과 확인

2. LLM Zero-shot 성능 확인

3. 연속된 장면 (Temporal Scene) 을 이해하는 LLM Zero-shot 성능 확인

3. Next Step

다음 회의까지 해야할 부분을 정하였습니다!

1. Wrap up!! 실험 한 것 정리

2. LLaVA 1.5 paper read (기존 LLaVA 의 한계점을 해결하였는지 중점)

3. PPT 자료 초안 작성

여기까지 필수 사항으로 정했습니다! 앞으로의 방향성 정립 및 아이디어도 정리하였습니다!

1. 프로젝트에 적합한 "비디오" 에 대한 X-CLIP, LLaVA-NeXT 와 같이 관련 논문 문헌 조사 및 대모 확인

2. GPT-4, LLaMA, Claude3 를 활용하여 Machine-generated data 를 통한 fine-tuning 가능성 확인하기

3. 최종적으로 Zero-shot 으로 성능 upper bound 정리하기

다음 회의록으로 뵙겠습니다! Fellow 분들 모두 화이팅입니다!!!

해당 포스트는 2024.06.06 (목) 에 진행한 회의록입니다.

소확행

이날 함께 AI 경진대회하는 팀원분들도 만나서 정말 힐링되는 카페에서 카공했다ㅎㅎ 짱오락실도 갔다!