PROLOG

- 앞으로 내가 AI에 대해 공부한 내용은 '내가보려고정리한AI🧐'시리즈에 정리하려고 한다

- 블로깅을 하는 표면적인 이유는 내가 공부한 내용들을 AI에 관심있는 사람들에게 알려주기 위함이며 나의 지식을 공유하며 좀 더 심층적으로 공부하기 위한 목표를 가지고 있다.

- 포장을 벗긴 순수한 의도는 각박한 채용시장에서 조금이라도 어필을 해보려는 나의 발버둥이라고 볼 수 있다😏

💁♀️ 그 첫번째 주제로 나의 최대 관심사인 딥러닝부터 시작할 것이다!

- 딥러닝이란 무엇인가?

- 딥러닝의 주요한 요소는 무엇일까?

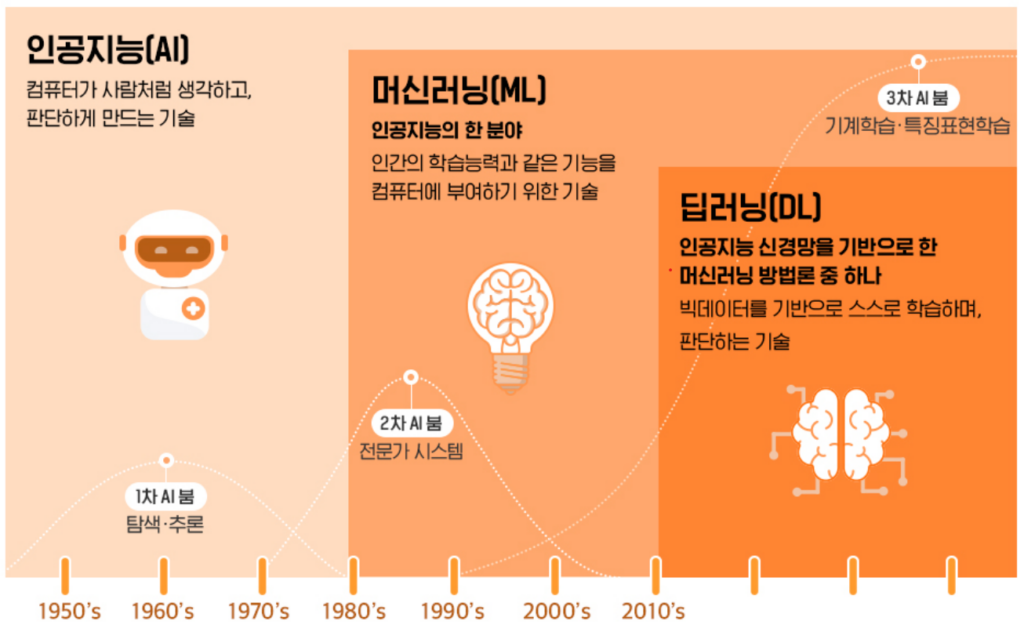

딥러닝이란 무엇인가?

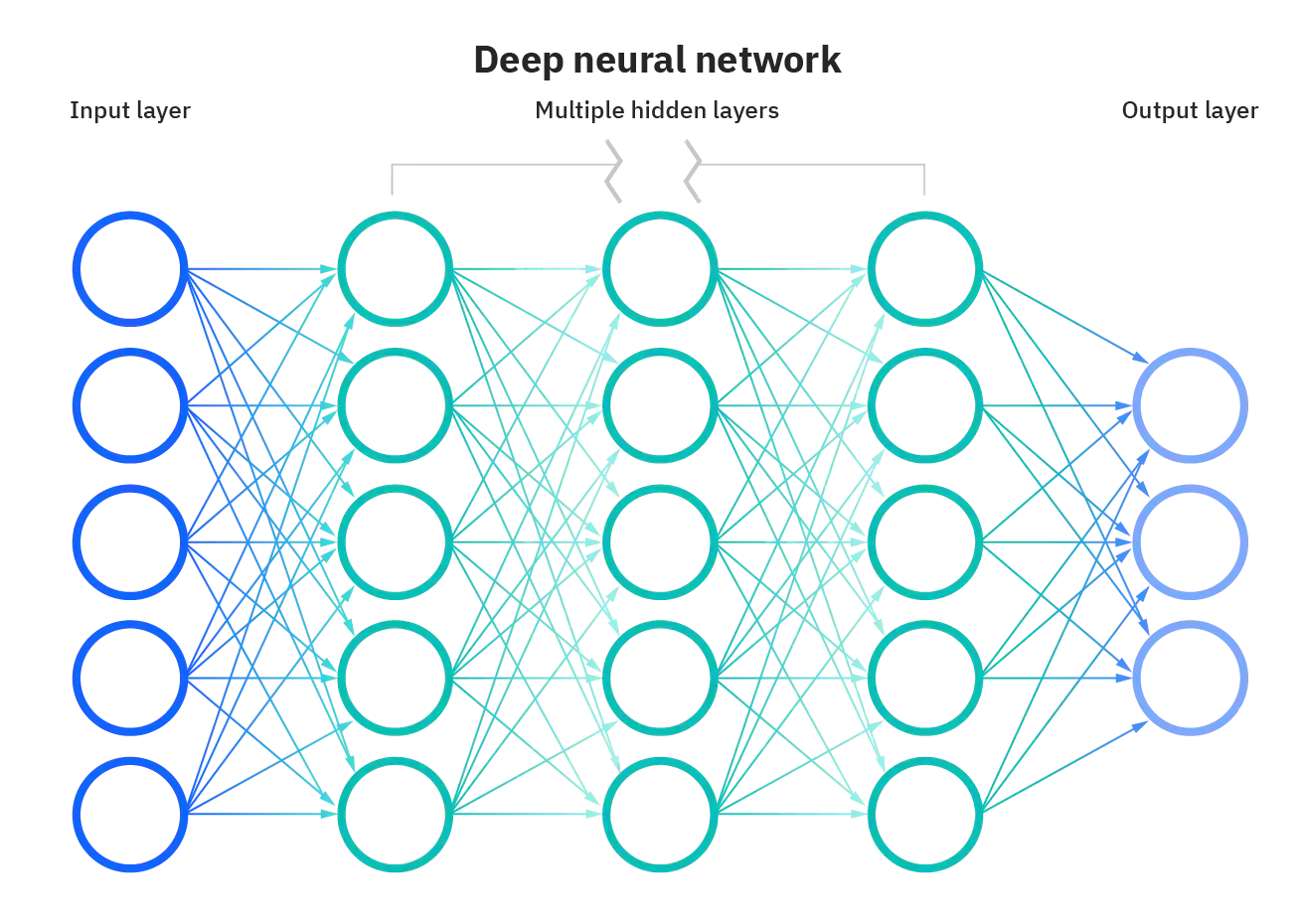

딥러닝(Deep Learning)이란 여러 층을 가진 인공신경망(Artificial Neural Network, ANN)을 사용하여 머신러닝 학습을 수행하는 것으로 심층학습이라고도 부릅니다.

- 벌써 듣기만해도 머리가 아프다

- 딥러닝을 이해하려면 인공신경망과 머신러닝의 뜻을 알아야 될 것 같다

🆀 인공신경망이란 무엇일까?

🅰 신경망은 인간의 두뇌에서 영감을 얻은 방식으로 데이터를 처리하도록 컴퓨터를 가르치는 인공 지능 방식이다. 인간의 두뇌와 비슷한 계층 구조로 상호 연결된 노드 또는 뉴런을 사용하는 딥 러닝이라고 불리는 머신러닝(기계 학습) 중 하나의 유형이다.

🆀 그렇다면 머신러닝이란 무엇일까?

🅰 인공지능의 하위 집합으로 학습과 개선을 위해 명시적으로 컴퓨터를 프로그래밍 하는 대신, 컴퓨터가 데이터를 통해 학습하고 경험을 통해 개선하도록 훈련하는데 중점을 두는 방식이다. 머신러닝에서 알고리즘은 대규모 데이터 세트에서 패턴과 상관관계를 찾고 분석을 토대로 최적의 의사결정과 예측을 수행하도록 훈련되고 이용 가능한 데이터가 증가할수록 더욱 정확해진다.

딥러닝의 주요한 요소는 무엇일까?

🆀 딥러닝을 하기 위해서 고려해야 될 요소는 무엇일까?

🅰 딥러닝의 주요한 요소에 대해 알아보려고 한다.

1. Data

- 데이터는 딥러닝 모델을 학습하기 위한 먹이라고 볼 수 있겠다.

- 데이터는 분류, 객체 탐지 등등 해결해야 하는 문제 유형에 따라 달라진다.

닝 애플리케이션은 적용을 통해 개선되며 이용 가능한 데이터가 증가할수록 더욱 정확해집니다.

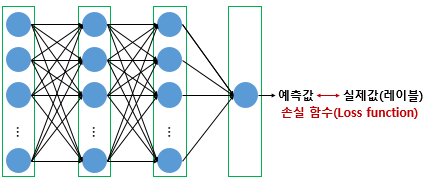

2. Model

- 모델은 데이터를 어떻게 변환 시킬지를 결정하는 요소라고 볼 수 있다

- ResNet, LSTM, GAN 등 세상에 나온 여러 모델들 중에서 문제 유형에 맞는 모델을 선택하는 것은 중요한 문제이다.

3. Loss Function

- 손실함수란 모델의 불량도(badness)를 정량화(quantifie)한다고 볼 수 있다

- 손실함수는 우리가 달성하고자 하는 것의 대리자(proxy)이다.

- MSE, CE, MLE 등 여러 오차함수의 성질을 알고 왜 내가 원하는 결과를 얻을 수 있는지 알아야 제대로된 모델을 만들 수 있다.

- 참고로 손실함수는 오차함수(Error Function), 비용함수(Cost Function), 목표함수(Objective Function) 등으로 다양하게 불린다.

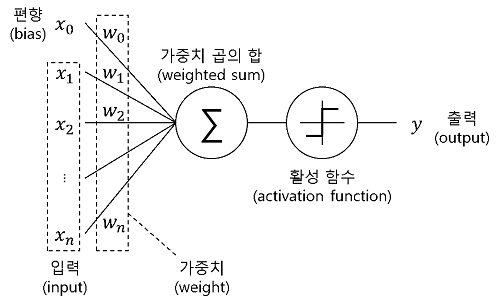

4. Activation Function

- 입력데이터에 대한 출력데이터를 비선형으로 나오게 하는 함수로 이전 Layerd의 결과값을 변환하여 다른 층의 뉴런으로 신호를 전달하는 역할을 한다.

- 활성화 함수는 모델의 복잡도를 올려 기존에 해결하지 못했던 비선형 문제를 해결할 수 있게 한다.

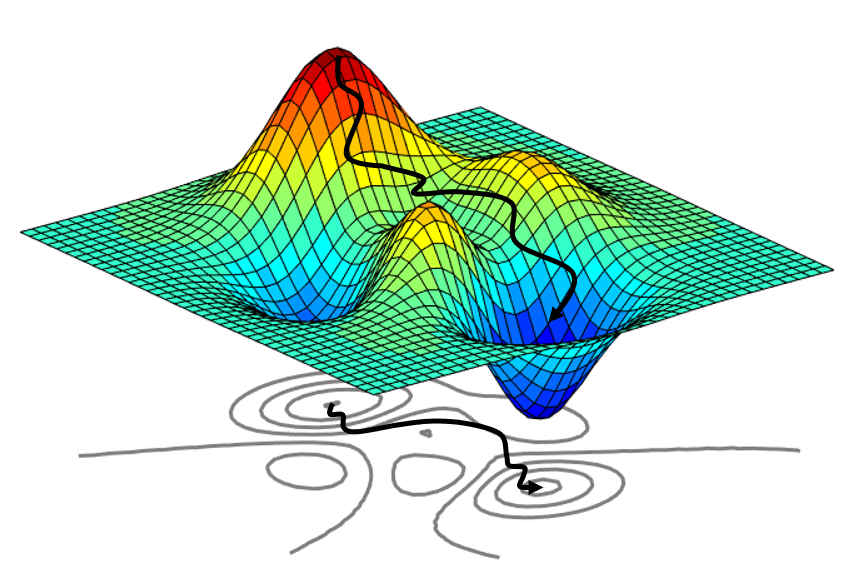

5. Optimization(최적화)를 위한 Algorithm

- 알고리즘이란 오차(손실함수)를 최소화하기 위한 매개변수(parameter)들을 조정하는 것이다. 즉, 최적화(optimization)라고 볼 수 있다.

- Dropout, Early stopping, Batch normalization 등 여러 방법론을 사용해 오차를 최소화 시키는 알고리즘을 만들어야 한다.

Epilogue

💁♀️ 앞으로 다룰 글에서는 딥러닝의 요소인 데이터, 모델, 손실함수, 최적화를 기준으로 딥러닝의 구체적인 방법론들을 하나 하나씩 알아갈 것 이다.

-참고-

네이버 부스트캠프 AI Tech 5기

tcpschool.com

AWS 신경망이란 무엇인가요?

SAP 머신러닝이란?

[AI랑 산다] #1 인공지능 역사로 알아보는 핵쉬운 용어사전

딥 러닝의 학습 방법