정규화

학습데이터에만 너무 특화되어 있지 않고, 일반화(generalization)가 가능하도록 규제(penalty)를 가하는 기법

👉 정규화 기법

-

Early stopping

학습 진행 중 최적의 적합지점을 넘어가면 과적합되어 loss가 커지는 때가 오면 학습을 정지 시킨다 -

Parameter norm penalty

네트워크 파라미터가 커지지 않게 하는 방법, 파라미터의 크기가 작으면 작을 수록 좋다. 함수 공간 속 함수를 부드러울수록 일반화가 잘될 것이라는 아이디어임 -

Data augmentation

데이터가 많으면 학습이 잘되므로 레이블이 바뀌는 않는 선에서 이미지를 변형해서 증량 해보는 것 ex) 6 이미지를 뒤집음 9가되고 레이블이 바뀜 -

Noise robustness

일반화가 잘 되기 위해 학습테이터에 노이즈를 넣어서 학습해보자 -

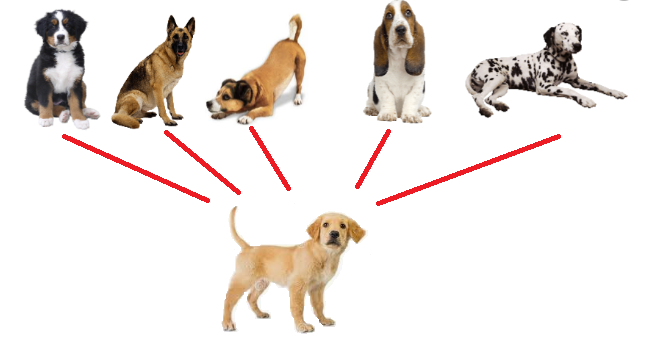

Label smoothing

서로 다른 레이블을 가진 데이터들을 섞어 학습시켜 모델의 분류 경계를 부드럽게 만든다. 이 방법으로 학습 시 최적화가 되는 이유는 논리적이유보단 경험적인 이유임 -

Dropout

랜덤하게 뉴런을 0으로 만들어 과대적합을 막자 -

Batch normalization

하나의 레이러의 파라미터 값들이 평균0이 되도록 스케일링(정규화)해준다. 해당 방법은 레이어가 깊을 때 성능이 좋다고 알려져있다.

또한 간단 분류 문제일때 효과가 좋다고 알려져있으나 효과에 대한 논란은 있다.