GPT란?

GPT는 Generative Pre-trained Transformer의 약자로, 인공지능 분야에서 사람의 언어를 이해하고 생성할 수 있도록 하는 기술인 언어 모델의 한 종류이다.

기본적으로 언어 모델은 이전 단어들로부터 다음 단어를 예측하는 생성 모델이고 GPT는 많은 언어모델 중 하나이다. 외에 다른 언어 모델로는 구글의 Gemini, 네이버의 CLOVA X등이 있다.

이들 중 딥러닝 언어 모델로써 파라미터 개수가 큰 언어 모델을 거대 언어 모델(Large Language Model)이라고 한다.

GPT 아키텍처

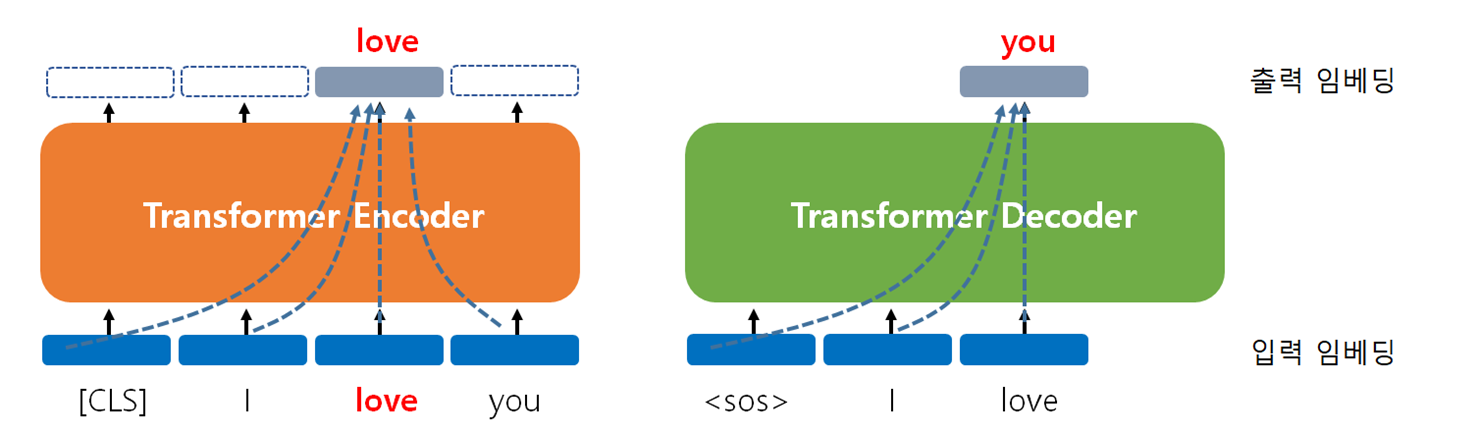

이전에 트랜스포머글에서 정리한 것처럼 트랜스포머는 인코더-디코더 구조인데 BERT는 그중 인코더로만 구성한 것이고 GPT는 디코더로만 구성한 것이다.

GPT는 기본적으로 BERT와 달리 이전 단어들로 다음 단어를 예측하는 모델이기 때문에 다음 단어를 지속적으로 생성할 수 있어서 글쓰기가 가능한 생성 모델이다.

현재 대부분의 거대 언어 모델이 채택하고 있는 구조이기도 하다.

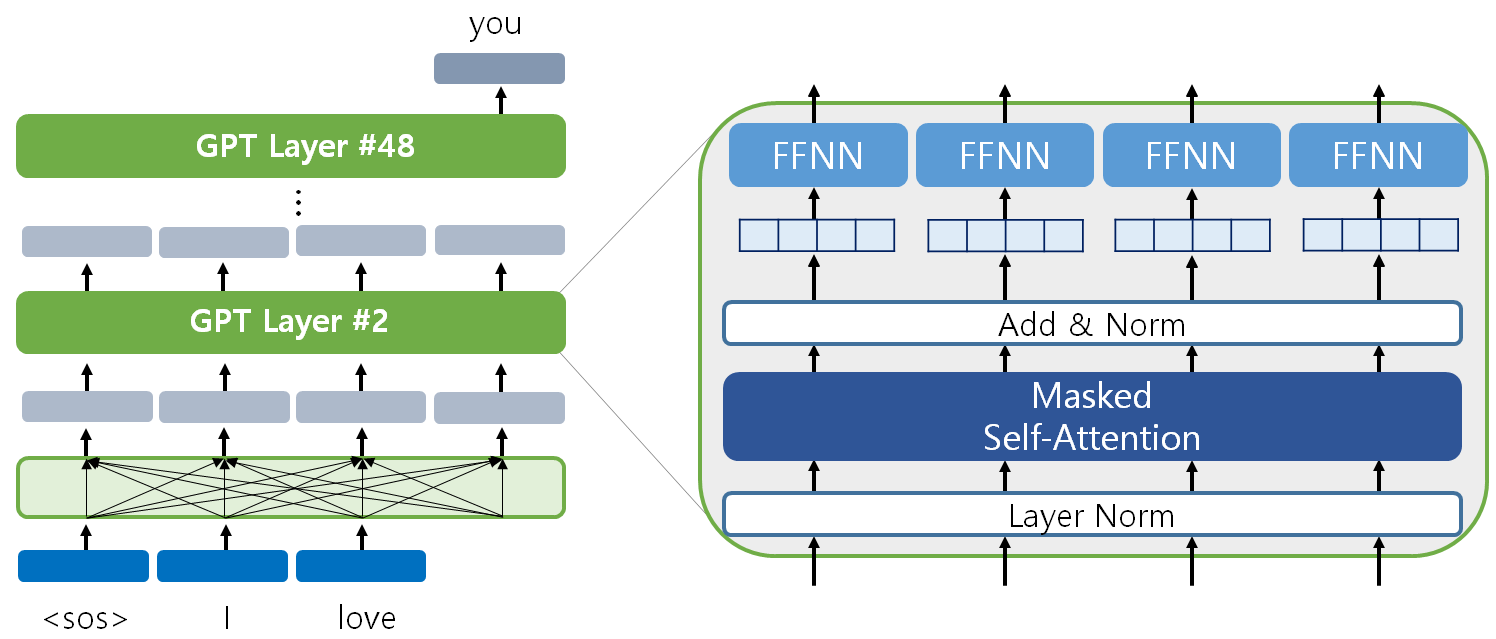

위 그림은 GPT-2 아키텍처를 도식화 한 그림이다.

트랜스포머와 달리 인코더가 없기 때문에 인코더-디코더 어텐션은 제거되었지만 나머지 층은 크게 달라지지 않았다.

GPT 모델은 대량의 학습 데이터 덕분에 사전학습 만으로도 특정 문제를 풀 수 있는 일반화 모델로 발전하고 있다. 현재의 수많은 언어 모델들도 마찬가지이다.

정리

GPT(Generative Pre-trained Transformer) 모델은 트랜스포머(Transformer) 구조를 기반으로 한 언어 생성 모델이다.

대량의 텍스트 데이터를 사전 학습하여 언어의 문맥과 구조를 이해하며, 이를 통해 자연스러운 문장을 생성할 수 있다.

GPT는 입력된 텍스트를 바탕으로 다음 단어를 예측하는 방식으로 작동하며, 대화, 번역, 요약, 창작 등 다양한 언어 처리 작업에 활용된다.

사전 학습 단계에서 일반적인 언어 패턴과 규칙을 학습하고, 이후 특정 작업에 맞게 파인튜닝하여 세부적인 기능을 학습한다.

현재 자연어 처리 분야에서 널리 활용되고 있는 대표적인 모델이다.

마무리

드디어 지피티까지 정리를 끝냈다.. 다음글은 바트로 돌아오겠다!