분류모델 검증 방법

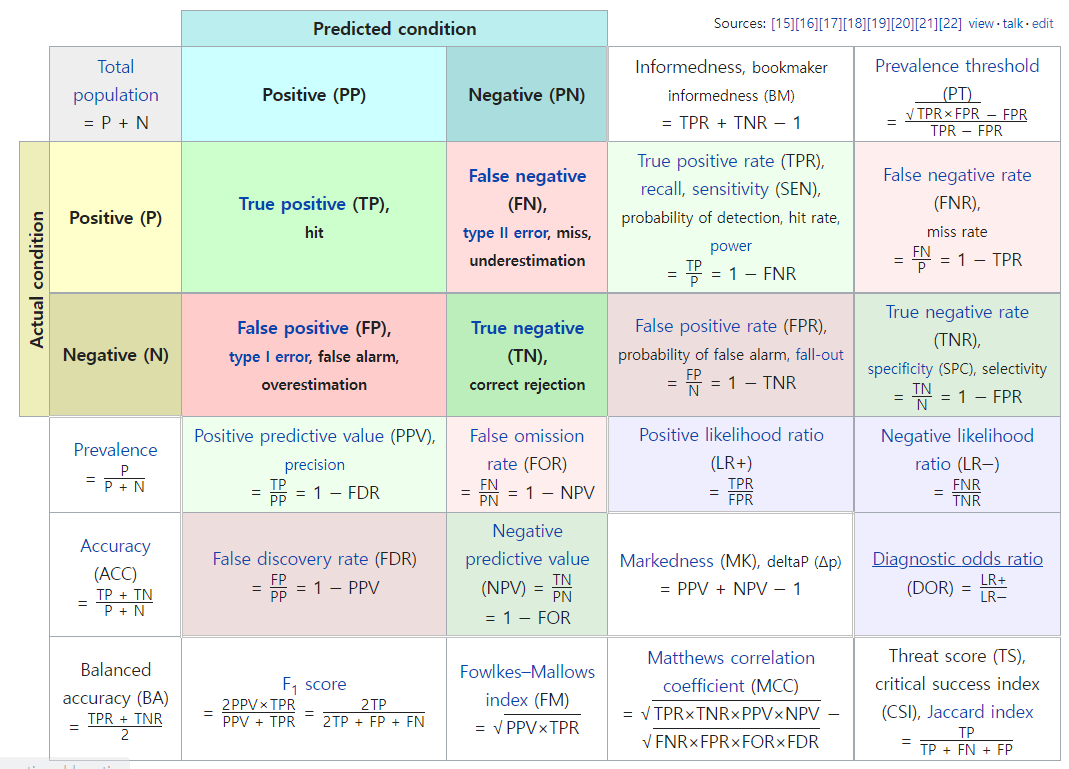

암을 초기진단할때 프리시즌보다 리콜이 더 중요(사망률이 높아져서)

스팸메일 분류 프리시즌이 더 좋음 (정확히 분류해야해서)

이렇게 상황에 따라 다르다.

리콜은 독감 백신에 사용함

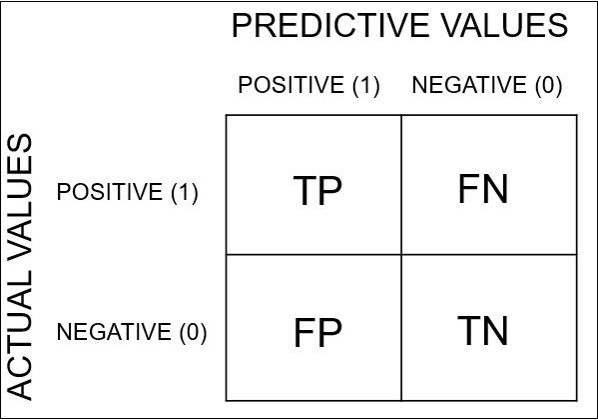

사이킷런은 예측범주 가로, 실제범주 세로측

임계값을 높일수록 정밀도가 높아지고 재현률이 낮아짐

ROC커브는 재현율과 위양성율의 관계를 보여주는 그래프

Confusion Matrix

출처: https://leedakyeong.tistory.com/

-레이블 0,1을 가진 데이터를 분류한다고 할때 관심 범주를 1로 둔다

오차 행렬 보는법

True positives: 정답이 1인데 모델이 1이라고 한다 => 관심 범주를 정확하게 분류함

False negatives: 정답이 1인데 모델이 잘못된 답인 0이라고 한다 => 관심 범주가 아닌것으로 잘못 분류함

False positives: 정답이 0인데 모델이 잘못된 답인 1이라고한다

True negatives: 정답이 0인데 모델이 0이라고 한다

- 축과 순서를 유의해서 보기

임계값

- 기본적으로 50퍼를 기준으로 함

- 귀무 가설 하 검정 통계량의 분포에서 귀무 가설을 기각해야 하는 값

- 분류를 하는 기준

각각이 뭐가 의미하는지

** 임계값을 조정했는데 f1-score가 변하지 않을수가 있음

그럴떈 좋은 모델을 만들어보기

평가지표를 보고 모델 성능을 높여놓고 마지막에 임계값을 수정해서 성능이 좋은 모델을 만든다.

F1-score

정밀도, 재현률

fp/fn등 예시를 들면서 설명할수 있는정도로 연습(예시들을 많이 찾기)

fp때문에 정밀도를 봐야한다

Roc curve, Auc 점수

- 재현률, 위양성률을 찍은것, 각각의 임계값에 따른 값들을

- 알오씨 커브 는 재현율과 위양성률의 관계를 보여줌

<머신러닝 플로우>

1. 전처리

2. 모델(rf):내가 만든 문제에 따라서 평가지표-정밀도

3. val set 검정 - 정밀도/roc_curve, score(평가지표)

a.과적합

b. 성능이 너무 낮네

4. 모델 수정/발전(핏쳐 엔지니어링, 하이퍼 파라미터 조정, 로지스틱, 부스팅)

*3-4번을 반복

5. 최종모델

6. 임계값 조정 ->최최종 모델(임계값 조정을 위해서 roc_curve)

7. 테스트 -> 결과(정밀도)

8. 모델 해석

넷플릭스 추천시스템은 어떤 평가지표를 활용하면 좋을지?

https://ysyblog.tistory.com/72 수정할때 참고