모두를 위한 딥러닝 강좌

1.기본적인 Machine Learning의 용어와 개념 설명

머신 러닝 용어와 개념

2.Linear Regression의 Hypothesis와 cost 설명, Minimize Cost

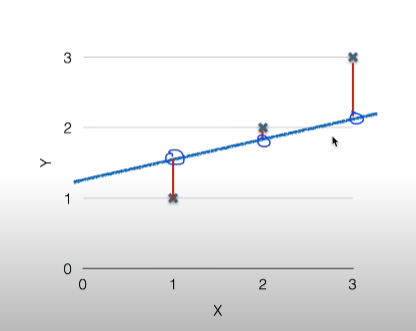

H(x) = Wx + b어떤 선, 모델이 우리 가설에 잘 맞을까?각각의 실제 데이터와 우리의 가설(일차방정식)의 차이가 적을수록 좋음실제 데이터와 직선에서 적은 거리값이 뭔지 계산하는 것을 cost function(=loss function)how fit the lin

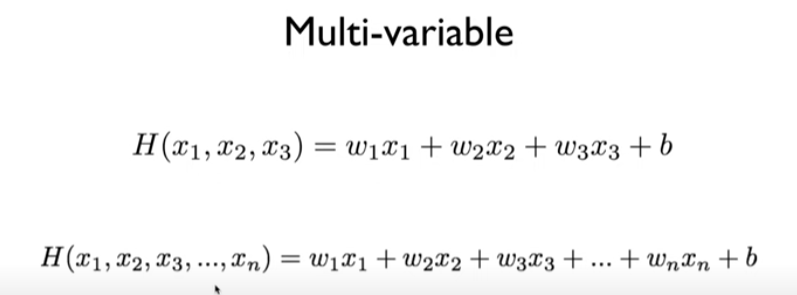

3.Multi variable linear regression, Logistic regression

다변량 선형 회귀운동시간, 칼로리 흡수, 스쿼트 횟수에 따라 체중이 몇 kg 빠지나 결정되는 것회귀분석 문제와 분류문제데 모두 사용할 수 있음종속변수가 범주형이면서 0 or 1인 경우에 사용하는 회귀 분석각 독립볌수에 대해 실패/성공에 대한 확률을 구한 뒤, 각각 구하

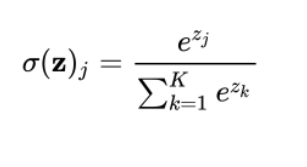

4.Softmax classification&multinomial classification, softmax classifier의 cost 함수

Binary classification데이터를 0, 1 두 그룹으로 구별해주는 역할만약 3개 클래스로 나눠야한다면 이진분류를 3번하는 것처럼 binary classification을 확장한 모델이진 분류가 아닌 다중 분류를 해결하기 위한 함수소프트 맥스 함수는 여러 개

5.Learning Rate, Overfitting, Regularization(일반화), Training/Testing

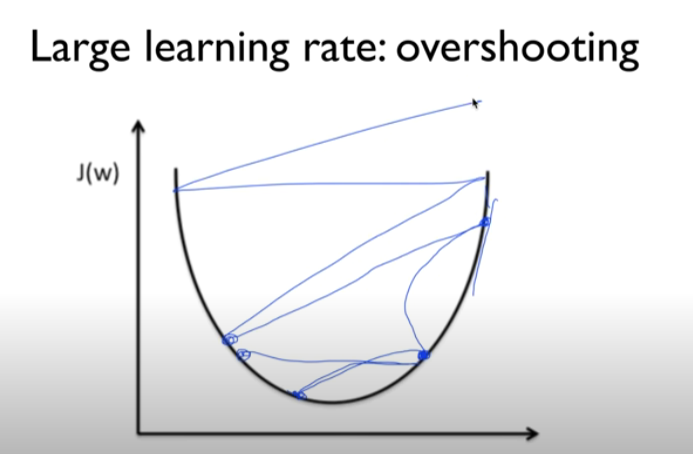

모두를 위한 딥러닝 강좌학습률이 크면? 경사면을 따라 내려가는 스텝이 크면 최저점 도착하지않고 튕겨 나갈 수 있음학습률이 굉장히 작으면?아주 작은 스텝으로 내려가서 시간이 오래걸릴 수 있음어떤 데이터가 범위 안에 들어가도록 하는 것학습 데이터에 너무 잘 맞게 훈련됨실제

6.딥러닝의 기본 개념: 시작과 XOR 문제, 딥러닝의 기본 개념2: Back-propagation과 딥의 출현

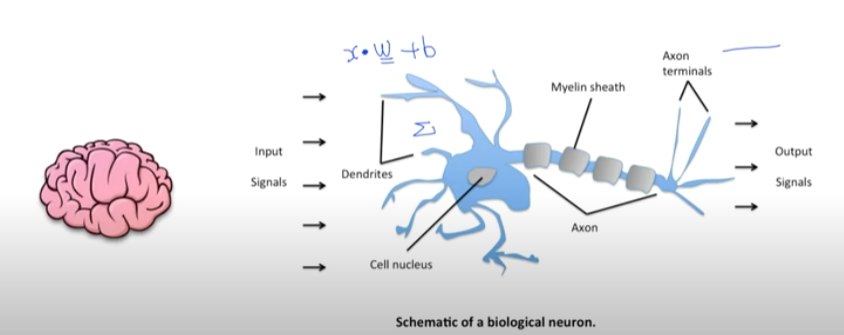

뉴런이라는 유닛이 단순하게 동작됨단순한 동작이 어떻게 인간이 생각할 수 있게 되는걸까인풋에 웨이트의양을 곱해주고(신호를 주고) 그 이후에 다 합해져서 Sum이 이뤄짐그 다음 바이어스를 더해서 통과가 됨더해준 값이 특정 값 이상이되면 활성화(activate)되고 특정 값

7.XOR 딥러닝으로 풀기, Backpropagation

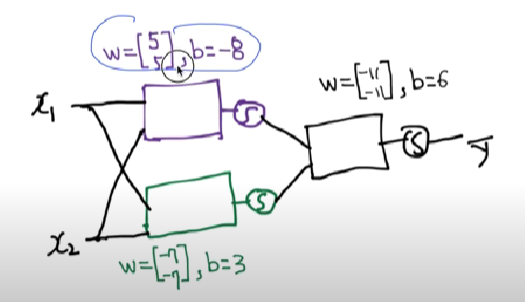

수학적으로 증명됨근데 unit을 여러개로 합치면? 풀수는 있지만 각각의 네트워크 속 가중치와 편향이 학습이 불가능하다는 문제가 생김x1, x2가 각각의 유닛으로 들어간 후 sigmoid로 나온 값이 다른 유닛 입력값으로 들어가서 W(웨이트=가중치),B(바이어스=편향)값

8.Sigmoid보다 Relu가 더 좋아, Weight 초기화 잘해보자, Dropout과 앙상블, 레고처럼 넷트웍 모듈을 마음껏 쌓아 보자

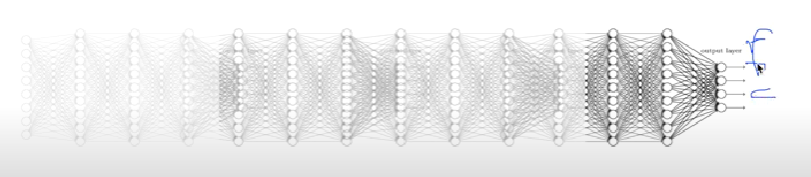

그림 왼쪽으로 갈수록 경사도가 사라지고 있음 == 학습하기 어렵다 == 그림 가장 왼쪽의 입력이 가름 가장 오른쪽 결과에 영향을 미치지 않는 다는 것이 문제 때문에 NN은 2차 겨울에 들어감we used the wrong type of non-linearity시그모이드

9.ConvNet의 Conv 레이어 만들기, Max pooling and others, RNN

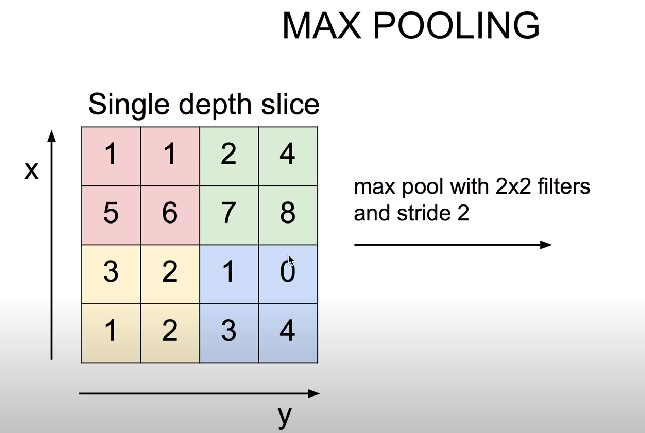

이미지가 급격하게 작아지는 것을 방지이미지의 테두리라는 것을 네트워크에 알려줌conv layer에서 resize(=sampling)하는 것을 pooling이라고 함pooling 한 값을 다시 쌓음2\*2안에 있는 값들 중 가장큰 값을 사용