심층학습 자연어 처리

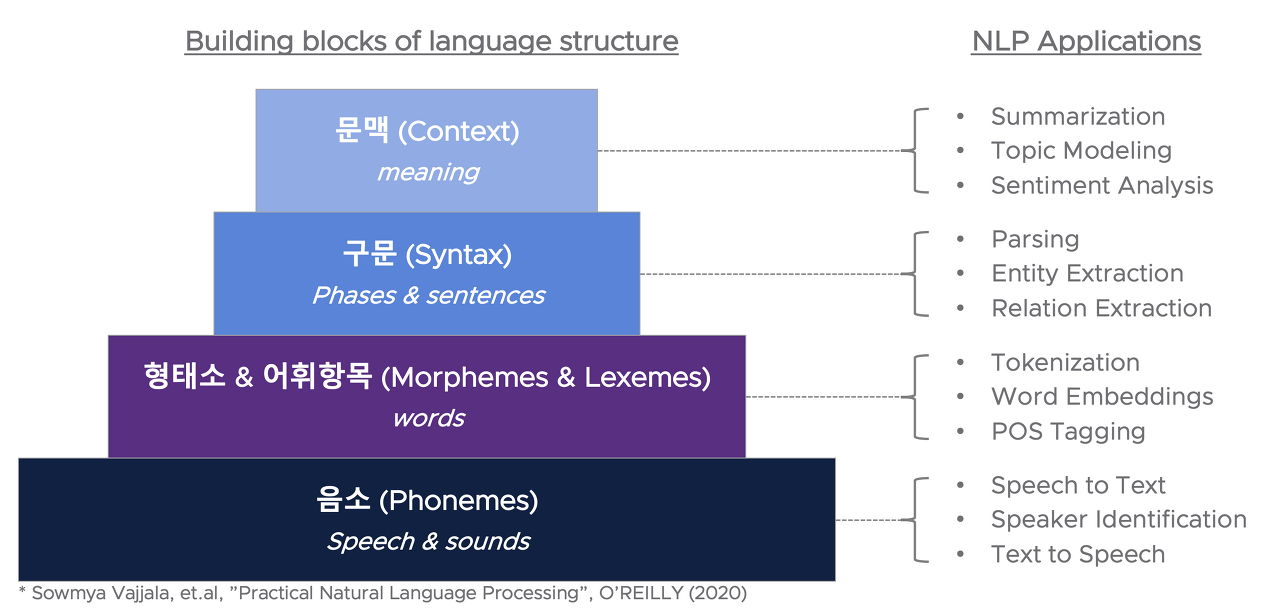

1.Levels of Language

심층학습 자연어 처리 Day1

2023년 2월 20일

2.<Day1>Language Model

NLP 개념1

2023년 1월 26일

3.<Day2> Word Representation

NLP 개념2

2023년 1월 26일

4.<Day3> RNN, LSTM, GRU

NLP 개념3

2023년 1월 29일

5.<Day4> Seq2Seq

NLP 개념4

2023년 2월 2일

6.<Day5> Pre-trained LM

pre-trained 모델을 비교, 설명

2023년 2월 14일

7.Attention Mechanism

기존 seq2seq 모델 input 2개 1) $h_{t-1}$(or context vector:디코터 RNN셀의 첫번째 은닉 상태에 사용됨) 2) $s_{t}$ Attention Mechanism 어텐션의 기본 아이디어는 디코더에서 출력 단어를 예측하는 매 시점(t

2023년 2월 21일

8.Transformer

transformer 개념 설명

2023년 2월 21일