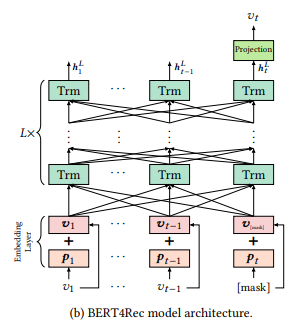

BERT4Rec (Sequential Recommendation with Bidirectional Encoder Representations from Transformer)

Recommendation System

목록 보기

1/3

네이버 Glace CIC의 비슷한 음식점 취향 유저 추천 모델 개발기에서 BERT4Rec를 사용했다고 하여 확인해보려 함

BERT4Rec

- BERT를 추천에서 사용하는 방법에 대한 연구

- 간단하게 정리해놓고 추후 논문을 좀 더 자세히 보게되면 다시 정리

Different from BERT

-

Next Sentence Prediction (NSP)와 Segement Embeddings 를 제거

- 그 이유는 BERT의 후속 연구들에서 위 loss들이 별로 좋지않다는 결과가 있었다고 함

- 각각이 무엇인지는 지난 BERT 블로그 포스트를 참고

-

마지막에

[Mask]토큰을 추가하고 이를 예측하여 추천에 사용 !

Restrictions

- NLP와 다르게 아이템과 유저가 계속해서 바뀐다는 점

- 위의 이유 등으로 주기적인 트레이닝이 필요할 수 있으므로 트레이닝 속도를 고려해야함.

- 성능이 좋더라도 트레이닝이 빠르다면 더 좋은 모델일 수 있음.

- 공개된 데이터셋의 도메인이나 유저, 아이템 등이 너무 달라서 실제 성능이 좋지 않을 수 있음.