1. 문서 정보

- 제목: ERNIE 4.5 Technical Report

- 저자: Baidu ERNIE Team

- 형식: 기술 보고서 / 모델 기술 리포트

- 발행: 2025 (ERNIE 공식 블로그 공개)

한 줄 요약

ERNIE 4.5는 Baidu가 발표한 차세대 대규모 언어 및 멀티모달 모델 계열로, 이 기술 리포트는 그 아키텍처, 훈련 전략, 최적화 기법, 그리고 범용·도메인 특화 성능을 정리한 문서이다.

2. 배경 및 동기

최근 AI 모델 경쟁에서 대규모 언어 모델(LLM)과 비전-언어 모델(VLM)의 범용성과 효율성이 핵심 지표가 됐다.

ERNIE 4.5는 다음 요구를 해결하기 위해 설계되었다:

- 범용적 멀티모달 이해와 생성 능력

- 효율적인 대규모 사전학습 및 추론

- 실사용 환경에서의 성능 및 배포 최적화

Baidu는 이러한 요구를 기존 ERNIE 시리즈에서 한 단계 발전시켜,

멀티모달, 지식, 추론, 효율을 고르게 갖춘 모델을 제공하려 한다.

3. 아키텍처 및 기술 구성

3.1 모델 스펙 및 구조

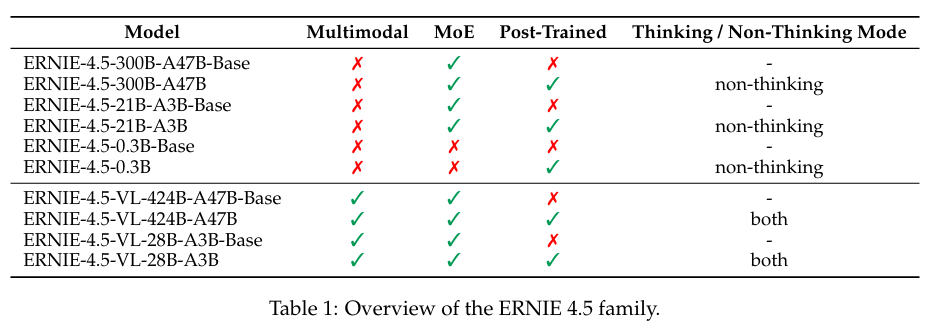

ERNIE 4.5는 단일 아키텍처가 아니라 모델 계열(Family)로 설계된다:

- Dense 모델: 소형/중형 모델 (예: 0.3B)

- MoE 모델: Mixture-of-Experts 구조 기반 대형 모델

- 최대 424B total 파라미터 규모

- 활성화(active) 파라미터는 47B 등 확장성 있는 구성

이 MoE 구조는 모달리티 간 유연한 파라미터 공유와 각 모달리티 전용 파라미터를 모두 포함해,

텍스트 및 비전 정보 모두를 효과적으로 표현할 수 있도록 설계되었다.

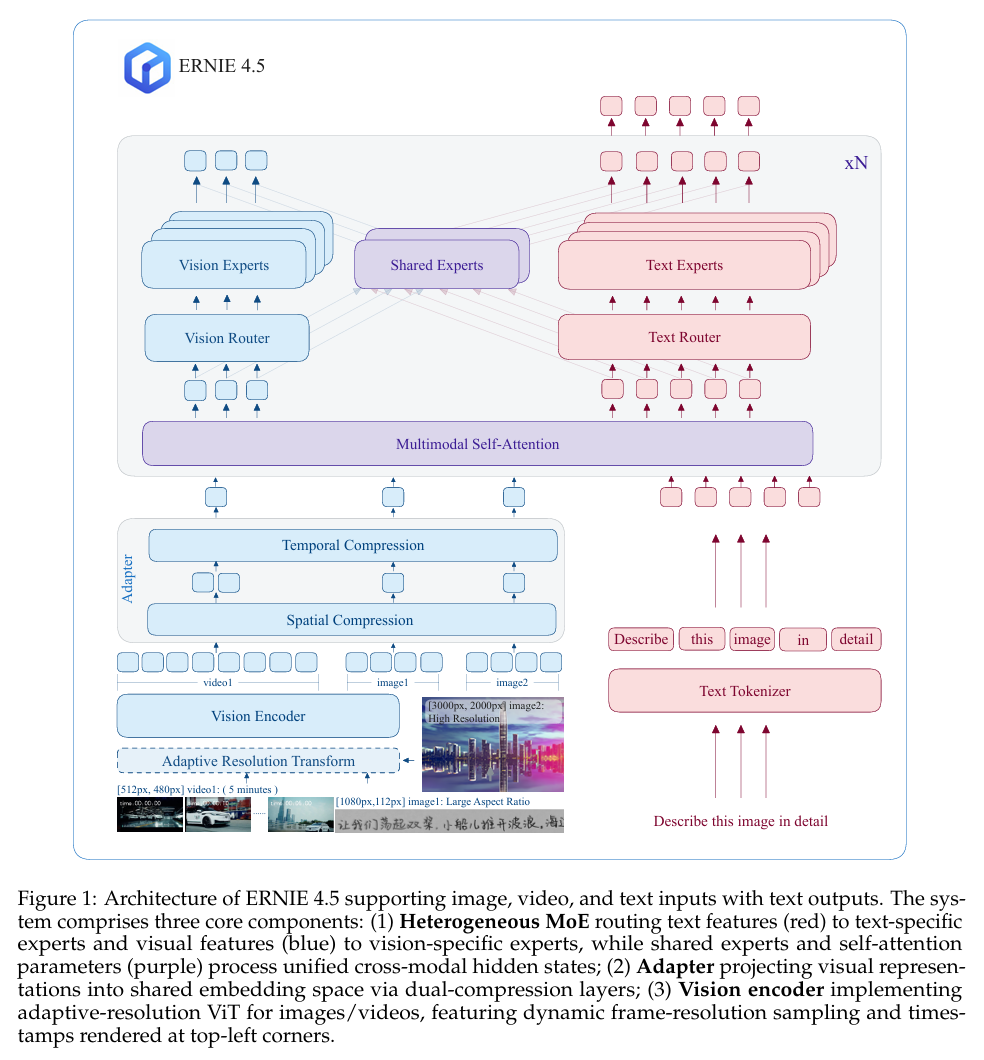

3.2 멀티모달 통합 (Heterogeneous MoE)

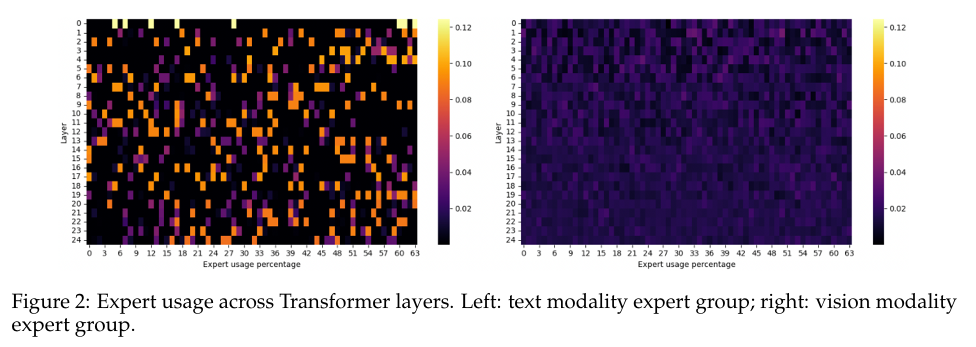

핵심 기술 중 하나는 멀티모달 비정질 MoE (Heterogeneous MoE) 구조다:

- 텍스트/이미지/비디오 등 모달리티가 섞여도 성능 저하 없이 상호 보완 가능

- 모달리티-격리형 라우팅(Modality-Isolated Routing)

- 서로 다른 모달리티 토큰이 각기 다른 전문가(expert)에 선택적으로 할당될 수 있도록 함

- 라우터 직교 손실(Router Orthogonal Loss) 및 멀티모달 토큰 평형 손실(Token-Balanced Loss) 등 특수 학습 항을 적용하여, 모달리티간 불균형 이슈를 해결한다.

이 구조 덕분에 단일 구조로 텍스트 및 시각 정보 모두 처리할 수 있고,

모달간 신호가 서로 간섭하지 않도록 설계된다.

4. 훈련 전략과 인프라

ERNIE 4.5 기술 리포트는 효율적 대규모 훈련/추론을 위한 여러 최적화 기법을 소개한다:

4.1 훈련 최적화

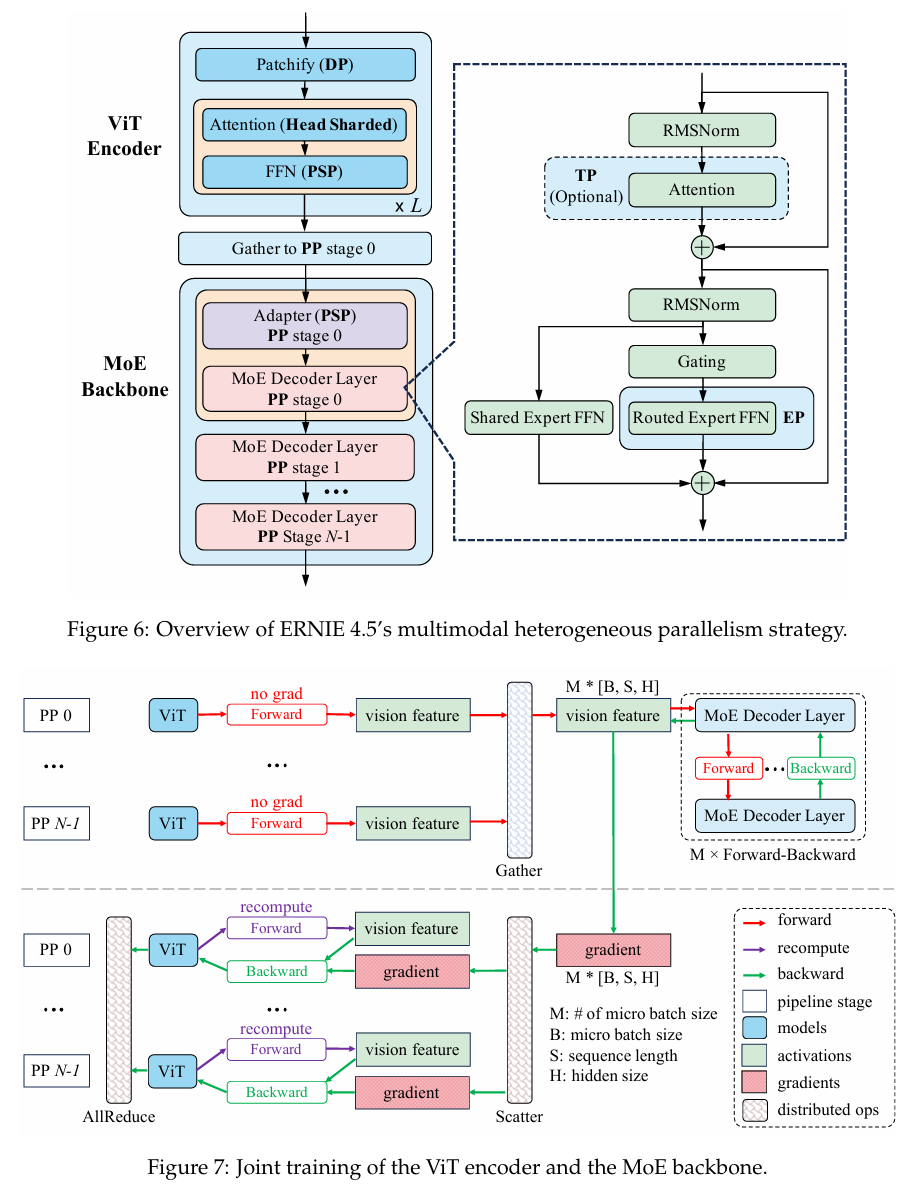

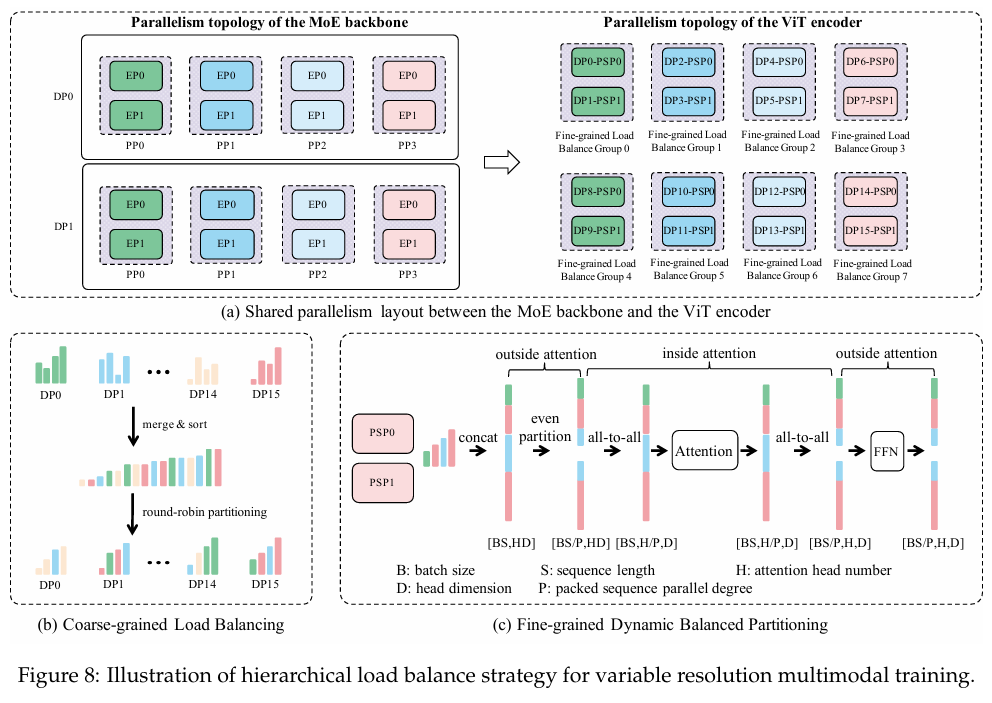

- 이종 혼합 병렬(Heterogeneous Hybrid Parallelism)

→ GPU/노드 레벨에서 메모리 효율과 연산 효율을 극대화 - FP8 혼합 정밀도(FP8 Mixed Precision)와 재계산(Recomputation) 기법

→ 메모리/연산 효율 향상 - 메모리 효율적 파이프라인 스케줄링 등 인프라 최적화

이런 최적화는 특히 MoE 모델의 높은 자원 요구를 상당히 줄이면서,

일반 GPU 클러스터에서도 훈련·추론 가능성을 높이는데 큰 역할을 한다.

5. 후처리 및 특화 튜닝

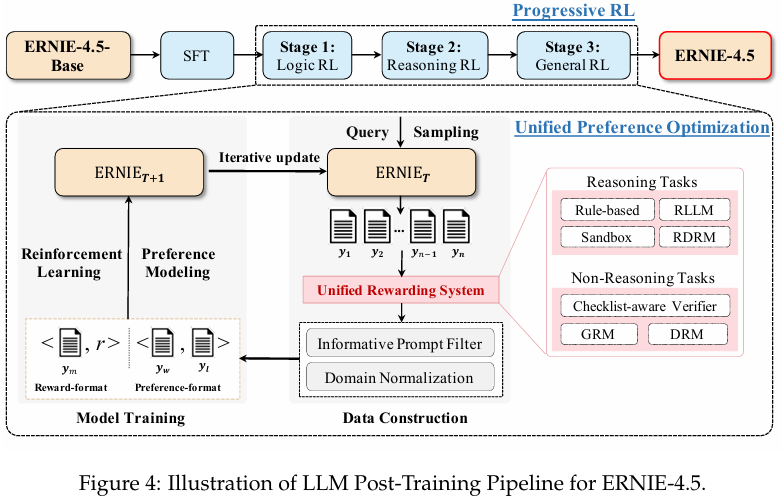

훈련 후 도메인·모달리티 특화 모델을 만들기 위해:

5.1 후학습(모달리티별 포스트 트레이닝)

- Supervised Fine-Tuning (SFT)

- Direct Preference Optimization (DPO)

- Unified Preference Optimization (UPO) — 리포트에서 소개된 강화학습 스타일 방법을 통해 자연어 생성 능력, 멀티모달 이해 능력, 명령 준수 능력 등을 강화한다.

6. 실험 결과 및 성능

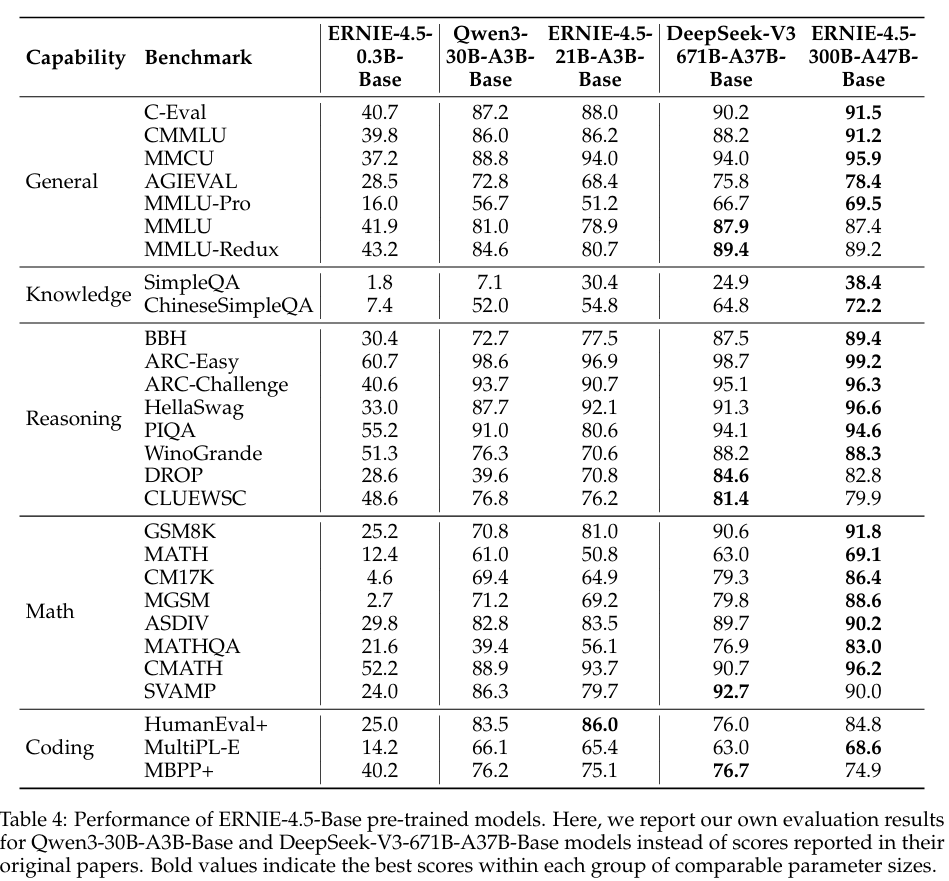

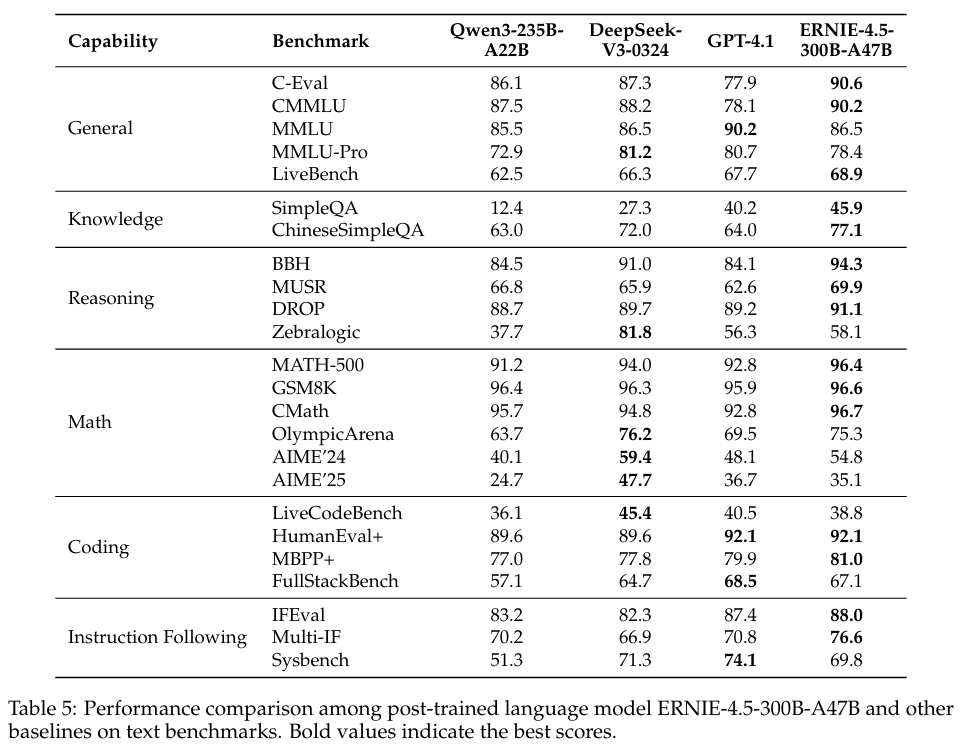

리포트 자체는 정량 테이블을 포함하며 다음과 같은 성능 주장을 제시한다:

6.1 LLM 성능

- ERNIE-4.5-300B-A47B-Base가 DeepSeek-V3-671B-A37B-Base 보다

↳ 22/28 벤치마크에서 우수한 결과를 보임 - ERNIE-4.5-21B-A3B-Base는

↳ Qwen3-30B-A3B-Base보다 수학/추론 벤치마크에서 경쟁력 있는 결과를 보임

이 결과는 파라미터 수 대비 성능 효율과

대형 모델의 추론/지식/추론 능력 향상을 설명한다.

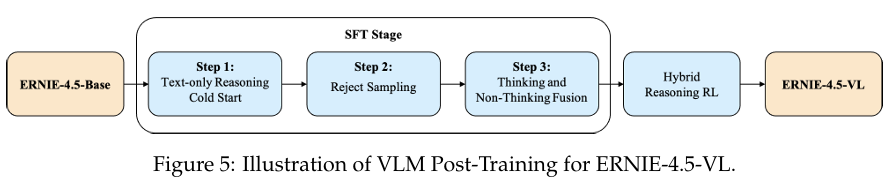

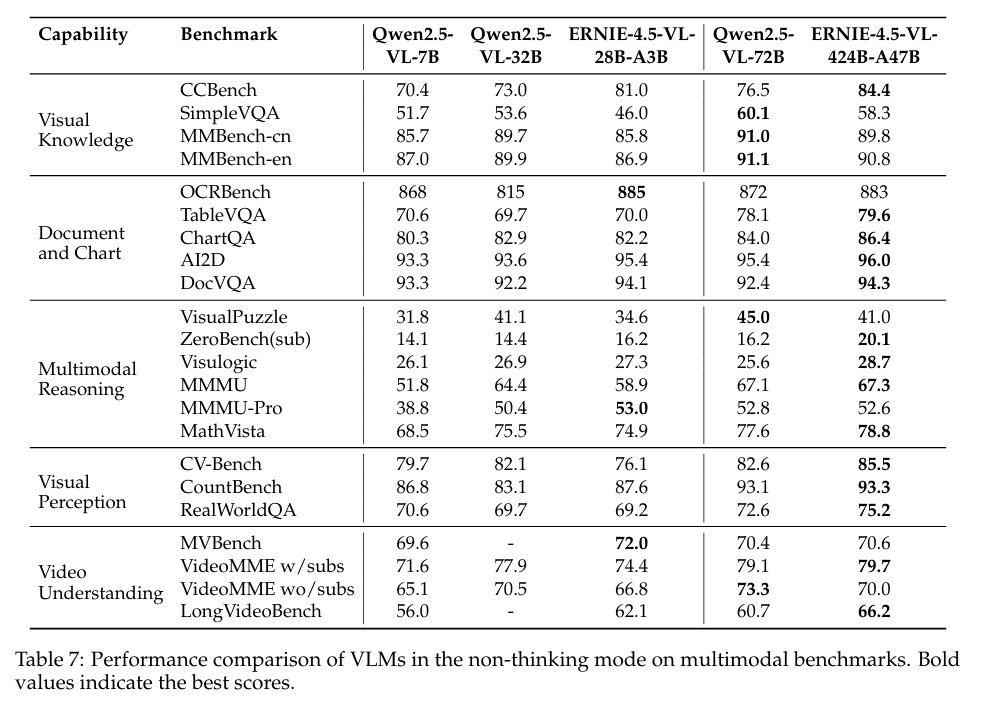

6.2 멀티모달 성능

- ERNIE-4.5-VL 계열 모델들은

- 지각(perception), 문서/차트 인식, 비주얼 추론 능력 등에서

- 생각(thinking) 모드가 추론력 강화까지 가능함을 보고

이 보고서는 VLM에 “생각 모드(thinking mode)” 개념을 도입하여

단순 인식/설명 → 고차원 추론/생각 수행까지 확장하려 했다는 점도 강조한다.

7. 장점 및 한계

✔ 장점

- 범용성 vs 특화성의 균형:

하나의 모델 패밀리로 일반 언어 + 멀티모달 + 도메인 특화 능력을 동시에 확보함 - 모달리티간 상호 강화 구조 (heterogeneous MoE) 도입

- 훈련/추론 인프라 최적화로 실제 대형 모델 적용 가능성을 높임

- 오픈소스 배포로 연구/산업 응용 확장성 확보

⚠ 한계

- 리포트는 공학/제품 중심 기술 문서이므로 학술적 검증은 제한적임

→ peer review가 아닌 사내 검토 문서 형태임. - MoE 구조의 복잡성/불확실성

→ 실 환경에서 training instability, routing overhead 이슈 가능 - 일부 성능 비교가 업계 벤치마크 조건에 따라 편차 발생 가능

8. 한 문장 요약

ERNIE 4.5 Technical Report는 Baidu의 최신 범용 및 멀티모달 AI 모델 계열의 설계·훈련·최적화·성능을 체계적으로 정리한 기술 리포트로, heterogenous MoE 구조와 대규모 최적화 전략을 통해 범용 멀티모달 능력과 도메인 특화 성능을 동시에 확보한 모델 패밀리를 설명한다.