논문 리뷰

1.[논문 리뷰] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

논문링크 : DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning주요 요약:DeepSeek-R1-Zero은 DeepSeek-V3에 large-scale reinforcemen

2.[논문 리뷰] Dual-Channel Deepfake Audio Detection : Leveraging Direct and Reverberant Waveforms

논문링크 : Dual-Channel Deepfake Audio Detection : Leveraging Direct and Reverberant Waveforms: 환경 요인이 반영된 Dual-channel을 사용해서 DeepFake Audio를 더 잘 구분할 수 있다

3.[논문 리뷰] Attention Is All You Need

논문링크 : Attention Is All You Need: GPT를 통해서 더 이상 공부하지 않을 수 없는 NLP에서 Transformer의 중요성을 알게 되어 한 번쯤 공부하고 싶었습니다. 그리고, SuperGlue 논문을 통해서 attention이 다양한 영역에도

4.[논문 리뷰] Denoising Diffusion Probabilistic Models

논문링크 : Denoising Diffusion Probabilistic Models: Diffusion 모델의 성능이 상당히 좋다는 점에서 감명받았고, transformer와 같은 중요한 논문이라고 판단해서 리뷰하게 됐습니다.이 논문에서 소개할 diffusion pr

5.[논문 리뷰] Link Prediction Based on Graph Neural Networks

논문링크 : Link Prediction Based on Graph Neural Networks: GNN을 공부하다보니 Link Prediction에 대한 내용이 많이 나오고 그에 따른 유명한 논문을 찾아보다 보게 됐습니다.각각의 target link 주변의 local

6.[논문 리뷰] GNNExplainer: Generating Explanations for Graph Neural Networks

논문 링크 : GNNExplainer: Generating Explanations for Graph Neural Networks: GNN에 대한 폭넓은 지식 습득을 위해 시도입니다.다음 3가지 이유 때문에, GNN prediction을 이해하는 것은 유용한다.GNN m

7.[논문 리뷰] Hierarchical Graph Representation Learning with Differentiable Pooling

논문 링크 : Hierarchical Graph Representation Learning with Differentiable Pooling: 그래프 관련해서 기본 지식들을 탑재하고자 state-of-the-art의 코드가 많은 순서대로 공부하던 중 관심이 생겼습니다.

8.[논문 리뷰] SuperGlue : Learning Feature Matching with Graph Neural Networks

논문 : SuperGlue : Learning Feature Matching with Graph Neural Networks: GNN이라는 기술에 관심이 생겨서 논문을 읽어보려고 하는데, 최신 기술 중 가장 구현이 많이 된 논문이라서 선택하게 됐습니다.SuperGlue

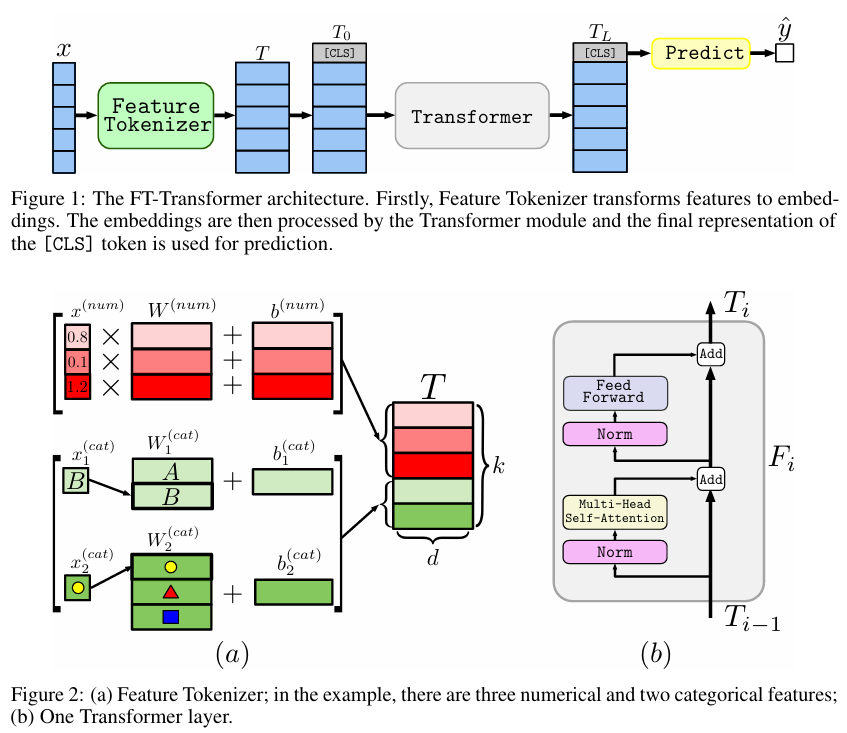

9.[논문 리뷰] Revisiting Deep Learning Models for Tabular Data

Title: Revisiting Deep Learning Models for Tabular DataConference: NeurIPS 2021Authors: Yury Gorishniy et al.주요 모델: FT-Transformer (Feature Tokenizer

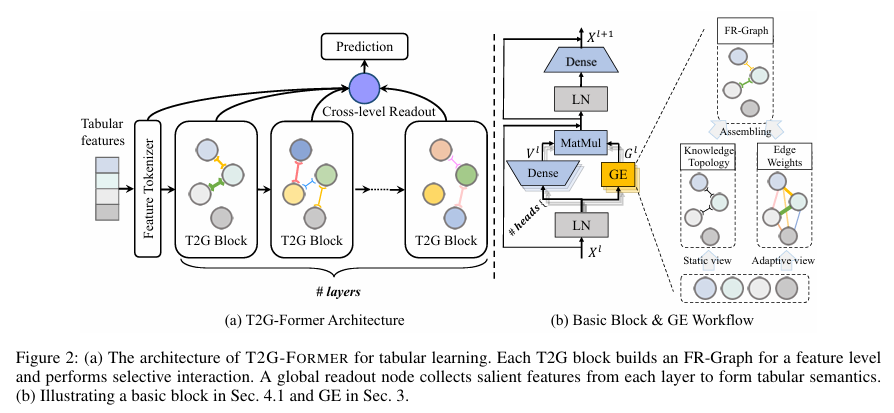

10.[논문 리뷰] T2G-FORMER: Organizing Tabular Features into Relation Graphs Promotes Heterogeneous Feature Interaction

제목: T2G-FORMER: Organizing Tabular Features into Relation Graphs Promotes Heterogeneous Feature Interaction학회: AAAI 2023한 줄 요약:테이블 데이터를 그냥 attention으로

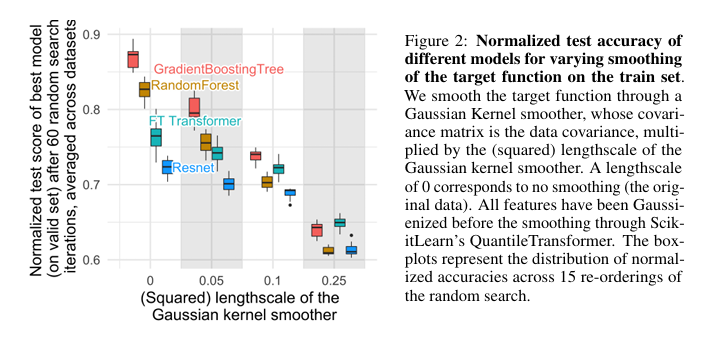

11.[논문 리뷰] Why do tree-based models still outperform deep learning on typical tabular data?

사용자가 작성해주신 T2G-Former 블로그 포스트의 흐름과 문체, 그리고 시각적 요소를 완벽하게 반영하여 "Why do tree-based models still outperform deep learning on typical tabular data?" 논문을 다시

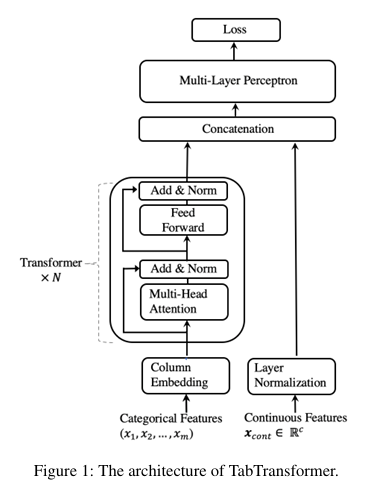

12.[논문 리뷰] TabTransformer: Tabular Data Modeling Using Contextual Embeddings

제목: TabTransformer: Tabular Data Modeling Using Contextual Embeddings학회/연도: arXiv 2020 (Amazon AWS)한 줄 요약:범주형 변수를 단순 숫자로 바꾸지 말고, Transformer를 통해 피처 간

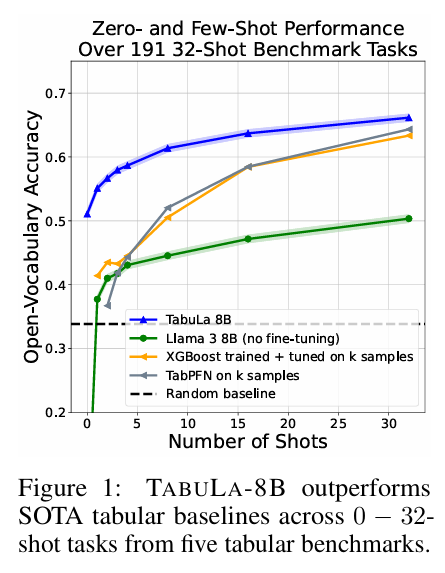

13.[논문 리뷰] Large Scale Transfer Learning for Tabular Data via Language Modeling

제목: Large Scale Transfer Learning for Tabular Data via Language Modeling학회/연도: arXiv 2024 (NeurIPS 2024 제출 추정)내가 정의한 한 줄 요약:"방대한 20억 개(2.1B)의 테이블 데이터로

14.[논문 리뷰] Large Language Models on Tabular Data - A Survey

제목:Large Language Models on Tabular Data – A Survey학회/연도:arXiv, 2024년 2월내가 정의한 한 줄 요약:“트리 기반 모델의 한계를 넘어, LLM의 추론 및 생성 능력을 정형 데이터에 이식하기 위한 전 과정을 체계적으로

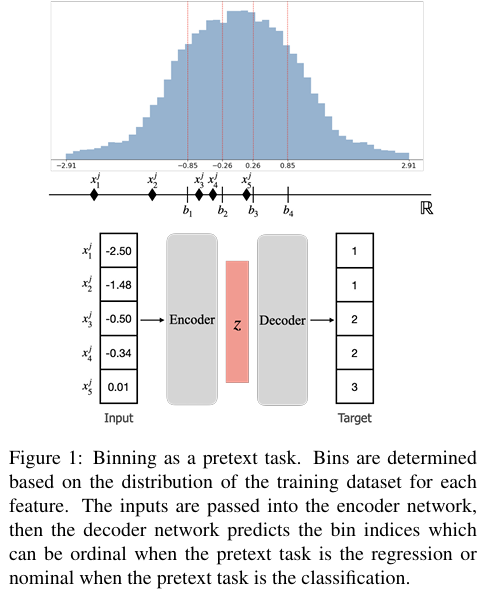

15.[논문 리뷰] Binning as a Pretext Task: Improving Self-Supervised Learning in Tabular Domains

제목:Binning as a Pretext Task: Improving Self-Supervised Learning in Tabular Domains학회/연도:ICML 2024 (accepted), arXiv, 2024년 5월내가 정의한 한 줄 요약:연속형/이질적인 T

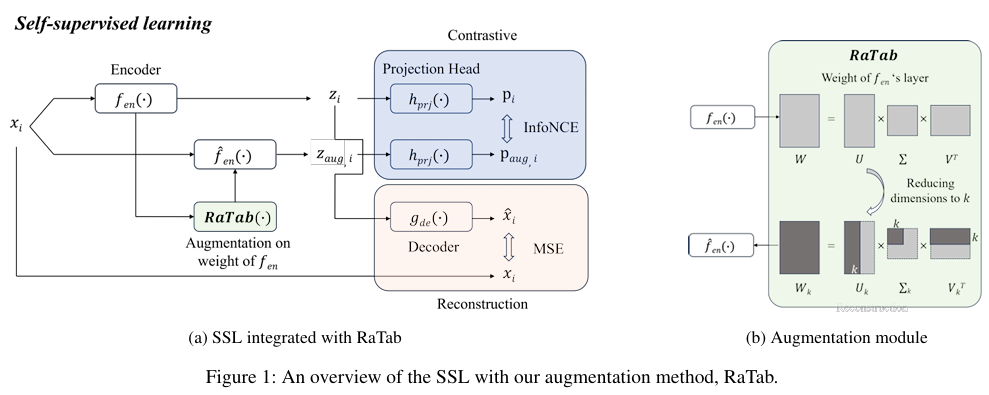

16.[논문 리뷰] Representation Space Augmentation for Effective Self-Supervised Learning on Tabular Data

제목: Representation Space Augmentation for Effective Self-Supervised Learning on Tabular Data(AAAI Conference on Artificial Intelligence 2025)학회/연도:AAA

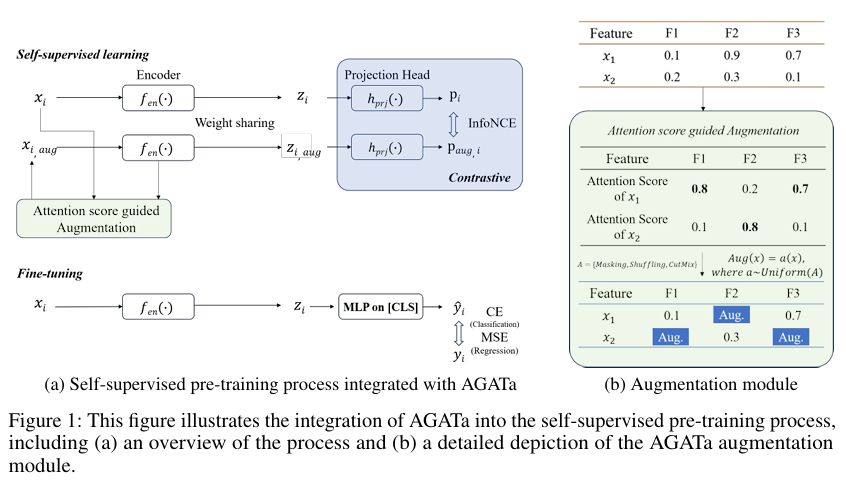

17.[논문 리뷰] AGATa: Attention-Guided Augmentation for Tabular Data in Contrastive Learning

제목: AGATa: Attention-Guided Augmentation for Tabular Data in Contrastive Learning(https://openreview.net/forum?id=l5VGHbRVW0\* 저자: Moonjung Eo, K

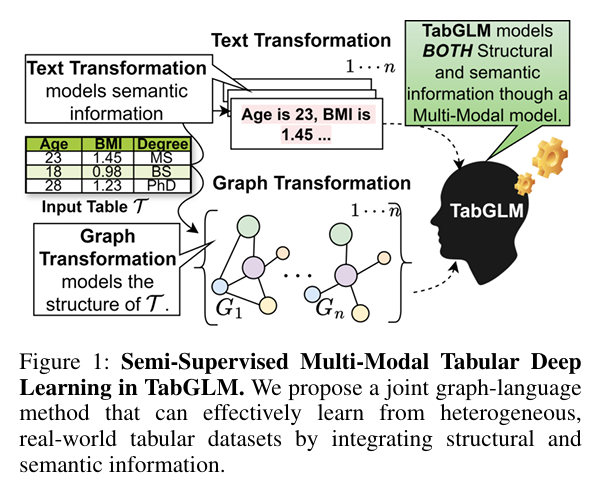

18.[논문 리뷰] TabGLM: Tabular Graph Language Model for Learning Transferable Representations Through Multi-Modal Consistency Minimization

제목: TabGLM: Tabular Graph Language Model for Learning Transferable Representations Through Multi-Modal Consistency Minimization저자: Anay Majee, Maria X

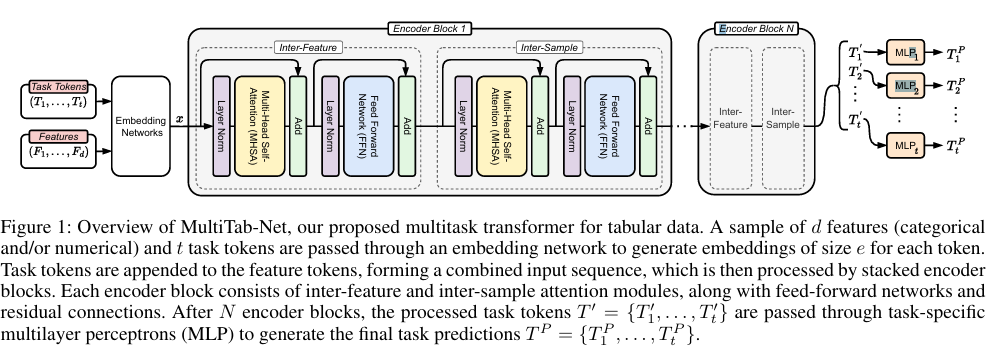

19.[논문 리뷰] MultiTab: A Scalable Foundation for Multitask Learning on Tabular Data

제목: MultiTab: A Scalable Foundation for Multitask Learning on Tabular Data저자: Dimitrios Sinodinos, Jack Yi Wei, Narges Armanfard소속: McGill University,

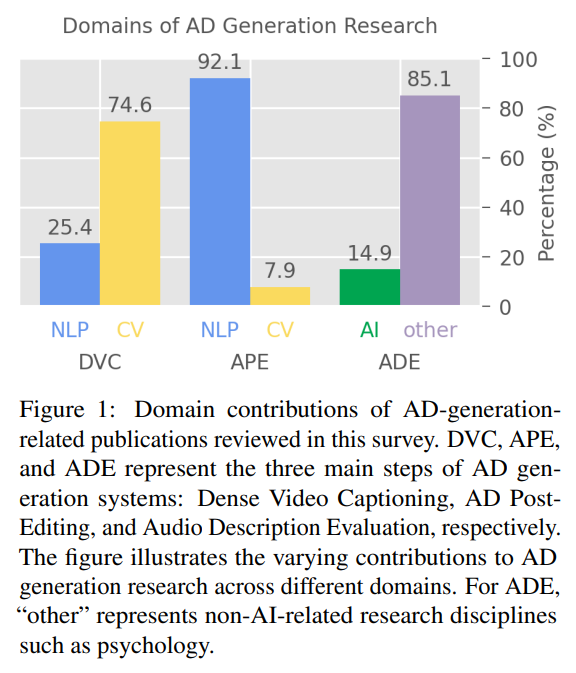

20.[논문 리뷰] Audio Description Generation in the Era of LLMs and VLMs: A Review of Transferable Generative AI Technologies

제목: Audio Description Generation in the Era of LLMs and VLMs: A Review of Transferable Generative AI Technologies저자: Yingqiang Gao, Lukas Fischer, Ale

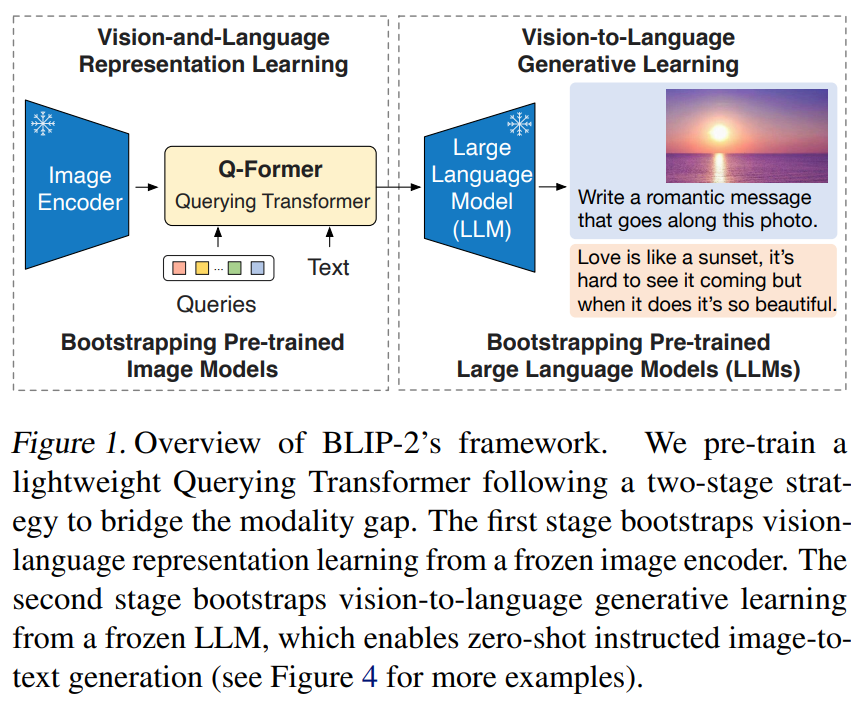

21.[논문 리뷰] BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

제목: BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models저자: Junnan Li, Dongxu Li, Silvio Savarese, S

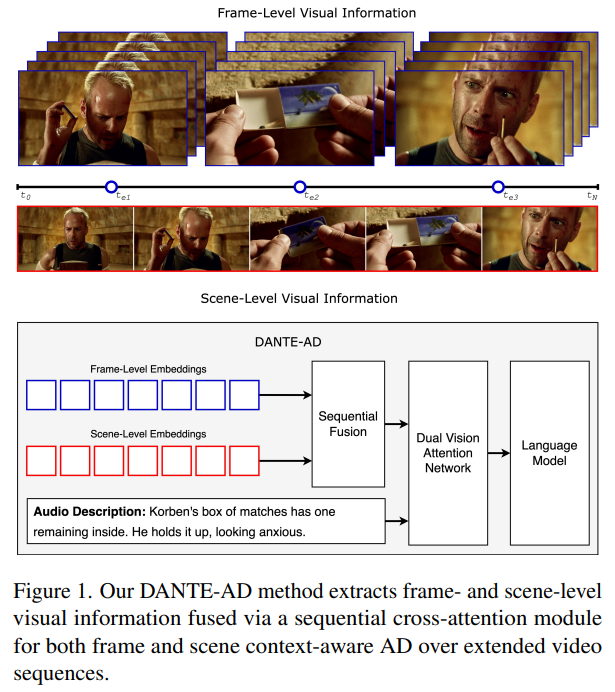

22.[논문 리뷰] DANTE-AD: Dual-Vision Attention Network for Long-Term Audio Description

제목: DANTE-AD: Dual-Vision Attention Network for Long-Term Audio Description 저자: Adrienne Deganutti, Simon Hadfield, Andrew Gilbert 소속: University of S

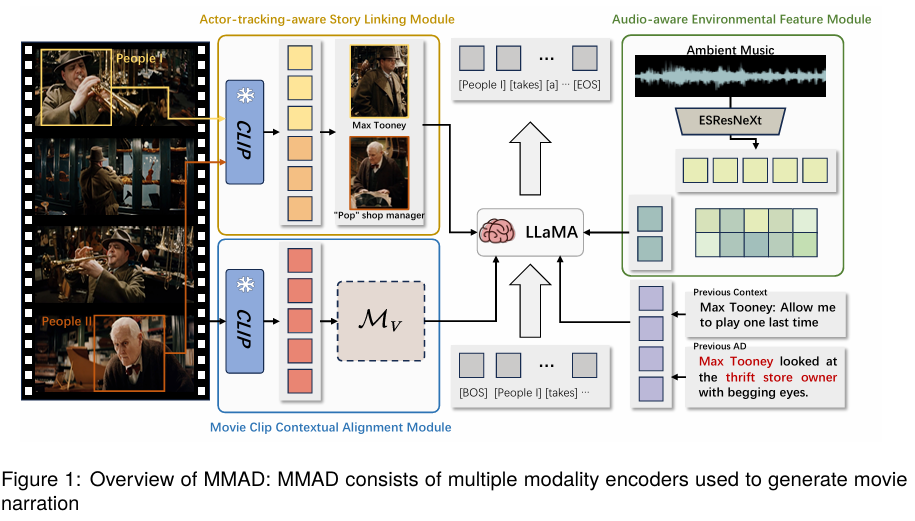

23.[논문 리뷰] MMAD: Multi-modal Movie Audio Description

제목: MMAD: Multi-modal Movie Audio Description저자: Xiaojun Ye, Junhao Chen, Xiang Li, Haidong Xin, Chao Li, Sheng Zhou, Jiajun Bu 학회: Proceedings of the

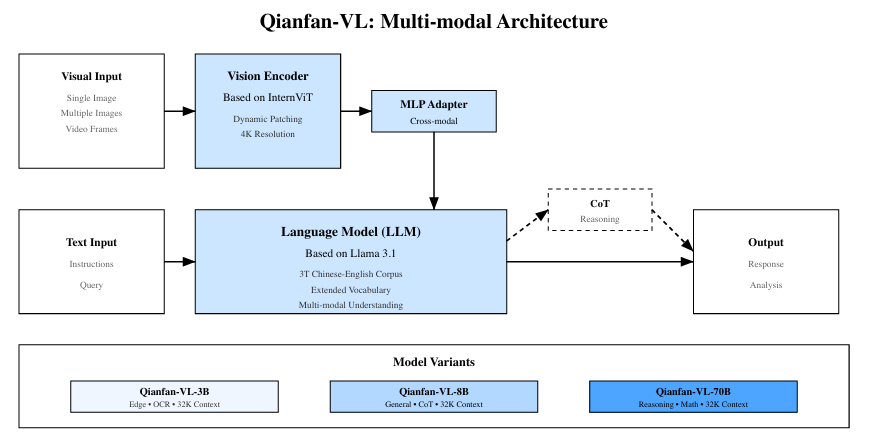

24.[논문 리뷰] Qianfan-VL: Domain-Enhanced Universal Vision-Language Models

제목: Qianfan-VL: Domain-Enhanced Universal Vision-Language Models저자: Daxiang Dong 외 다수 (Baidu AI Cloud / Qianfan 팀)제출: 2025년 9월 (arXiv preprint)분야: Vis

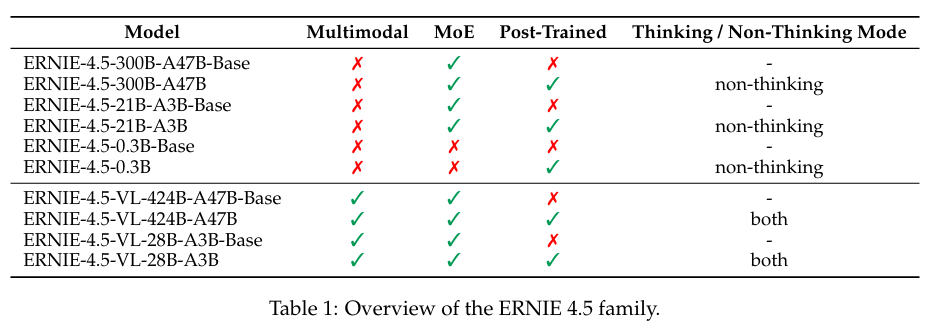

25.[논문 리뷰] ERNIE4.5 Technical Report

제목: ERNIE 4.5 Technical Report저자: Baidu ERNIE Team형식: 기술 보고서 / 모델 기술 리포트발행: 2025 (ERNIE 공식 블로그 공개)ERNIE 4.5는 Baidu가 발표한 차세대 대규모 언어 및 멀티모달 모델 계열로, 이 기술

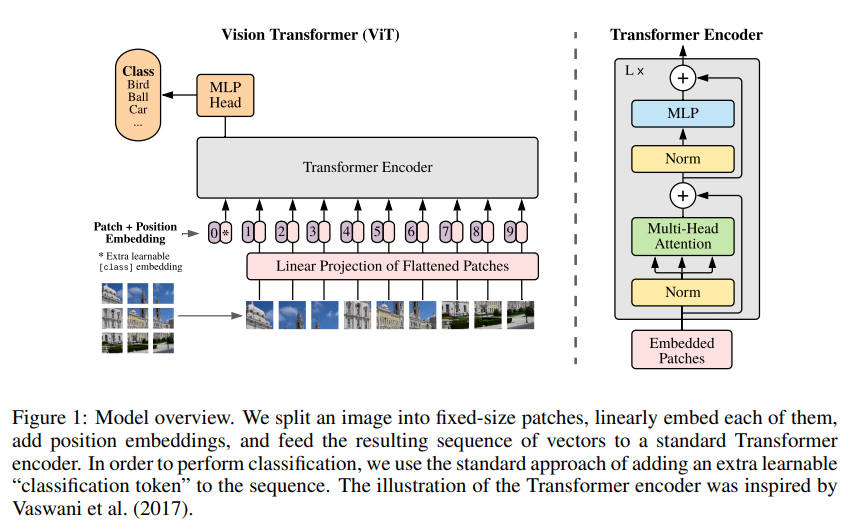

26.[논문 리뷰] An Image Is Worth 16×16 Words: Transformers for Image Recognition at Scale

제목: An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale저자: Alexey Dosovitskiy et al. (Google Research)형식: 학술 논문 (ICLR 2021)발행:

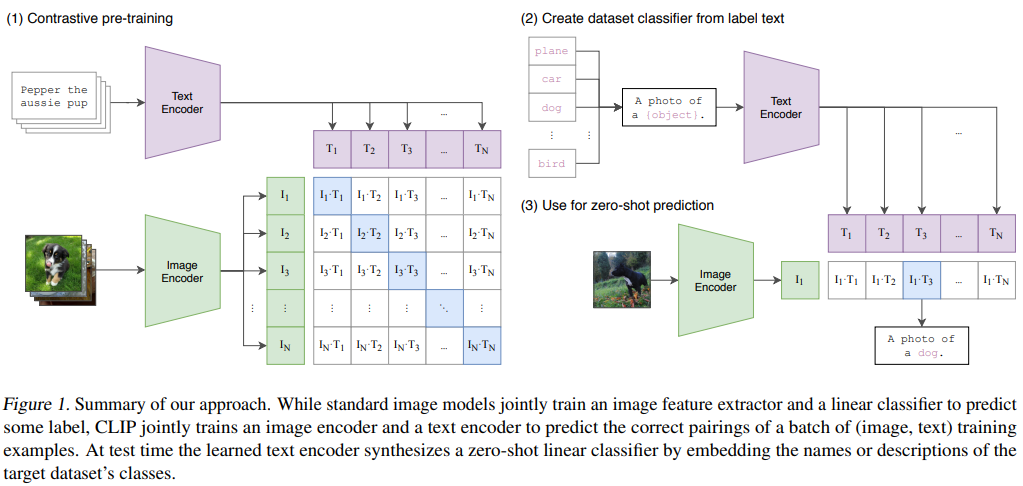

27.[논문 리뷰] Learning Transferable Visual Models From Natural Language Supervision

제목: Learning Transferable Visual Models From Natural Language Supervision저자: Alec Radford et al. (OpenAI)형식: 학술 논문발행: 2021 (ICML)CLIP은 이미지와 자연어를 동일한 임

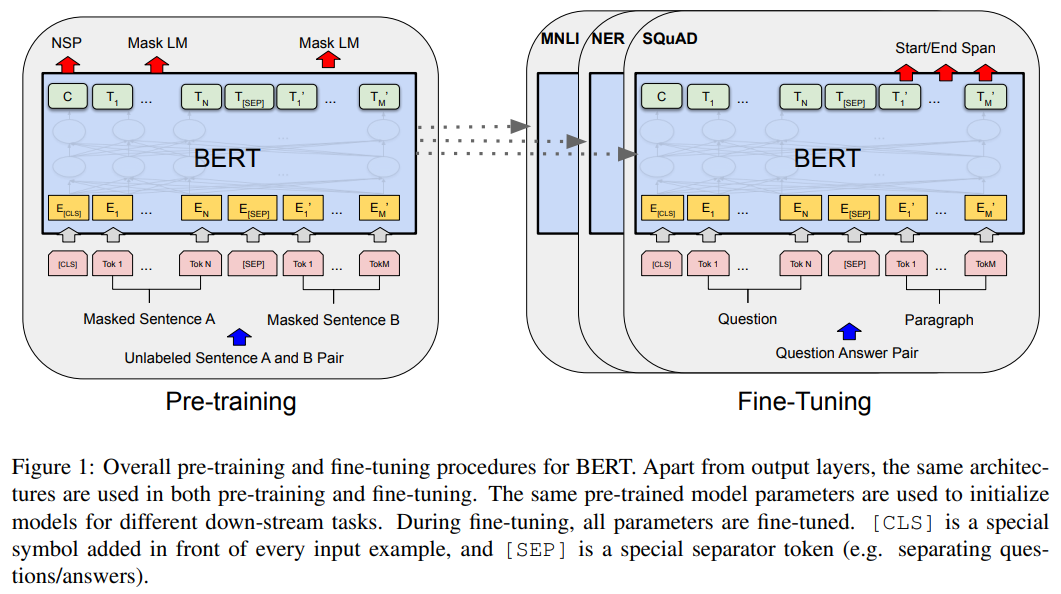

28.[논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

제목: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding저자: Jacob Devlin et al. (Google AI Language)형식: 학술 논문 (NAACL 2019)

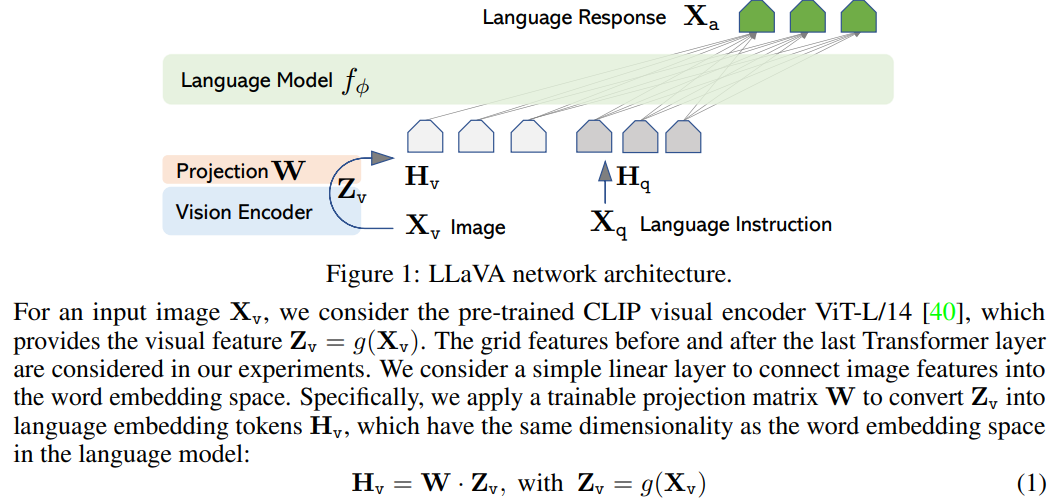

29.[논문 리뷰] Visual Instruction Tuning

제목: Visual Instruction Tuning저자: Haotian Liu et al. (UW–Madison, Microsoft Research)형식: 학술 논문 (NeurIPS 2023)발행: 2023 (arXiv)LLaVA는 이미지 인코더가 생성한 시각적 표현