📄 Paper

Representation Learning with Large Language Models for Recommendation [arxiv]

Jiayi Liao ACM SIGIR 24

📝 Key Point

Abstract

목적 : 사용자 과거 상호작용 시퀀스를 기반으로 다음 상호작용을 예측하는 순차 추천 시스템을 개발한다.

배경 : 최근 대형 언어 모델(LLMs)의 발전으로 순차 추천에서 언어 모델링을 활용하려는 관심이 높아지고 있다. 기존 연구들은 아이템을 LLM의 입력 프롬프트에 ID 인덱스나 텍스트 메타데이터로 표현하였으나, 이들 접근법은 포괄적인 세계 지식이나 충분한 행동 이해를 결여하고 있다.

제안 : LLaRA(대형 언어 추천 어시스턴트)를 소개하여 전통적인 추천 시스템의 행동 패턴 캡처 능력과 LLM의 세계 지식 인코딩 능력을 결합한다. 이 시스템은 전통적인 추천 모델로 학습된 ID 기반 아이템 임베딩과 텍스트 아이템 특징을 통합하는 새로운 하이브리드 프롬프트 방법을 사용한다. 사용자 행동을 텍스트와는 별개의 모달리티로 취급하고, 전통 추천 모델의 ID 임베딩을 LLM의 입력 공간에 맞추기 위해 프로젝터를 활용한다.

훈련 전략 : 하이브리드 프롬프트를 LLM에 직접 노출하기보다는 커리큘럼 학습 전략을 채택하여 점진적으로 훈련 복잡성을 증가시킨다. 초기에는 텍스트 전용 프롬프트로 LLM을 워밍업하여 언어 모델링 능력에 적합하게 만든 후, 점진적으로 하이브리드 프롬프트로 전환하여 전통적인 순차 추천 모델의 행동 지식을 LLM에 원활하게 통합하도록 훈련한다.

결과 : 실험 결과는 제안한 프레임워크의 효과성을 입증한다.

Figure

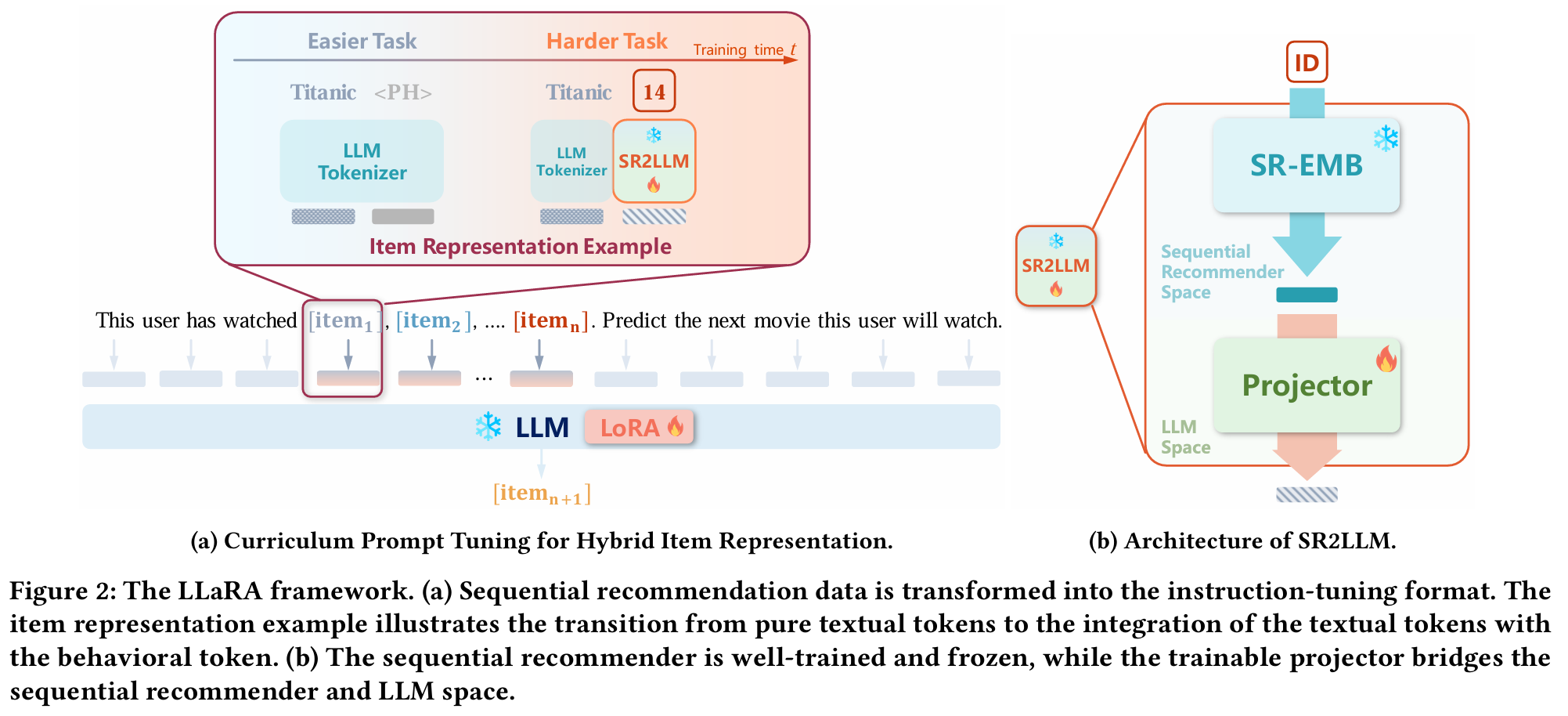

LLaRA 프레임워크

(a) 순차 추천 데이터는 instruction-tuning 형식으로 변환된다. 아이템 표현 예시는 순수 텍스트 토큰에서 행동 토큰과의 통합으로의 전환을 보여준다.

(b) 순차 추천 모델은 잘 훈련되어 고정되며, 훈련 가능한 프로젝터가 순차 추천 모델과 LLM 공간을 연결한다.

1. Introduction

목적 : 순차 추천은 사용자의 역사적 상호작용을 기반으로 다음 관심 아이템을 예측하는 것이다. 전통적인 순차 추천 모델은 아이템에 고유 ID를 부여하고 이를 학습 가능한 임베딩으로 변환한 후, 이 임베딩을 통해 사용자 선호도를 포착한다.

LLM의 활용 : 최근 LLM의 성공에 영감을 받아 LLM을 순차 추천에 활용하려는 관심이 증가하고 있다. LLM을 통해 행동 시퀀스를 텍스트 입력 프롬프트로 변환하는 방법이 제안되며, 이는 사용자 행동 패턴을 반영하여 추천의 정확성을 높일 수 있다.

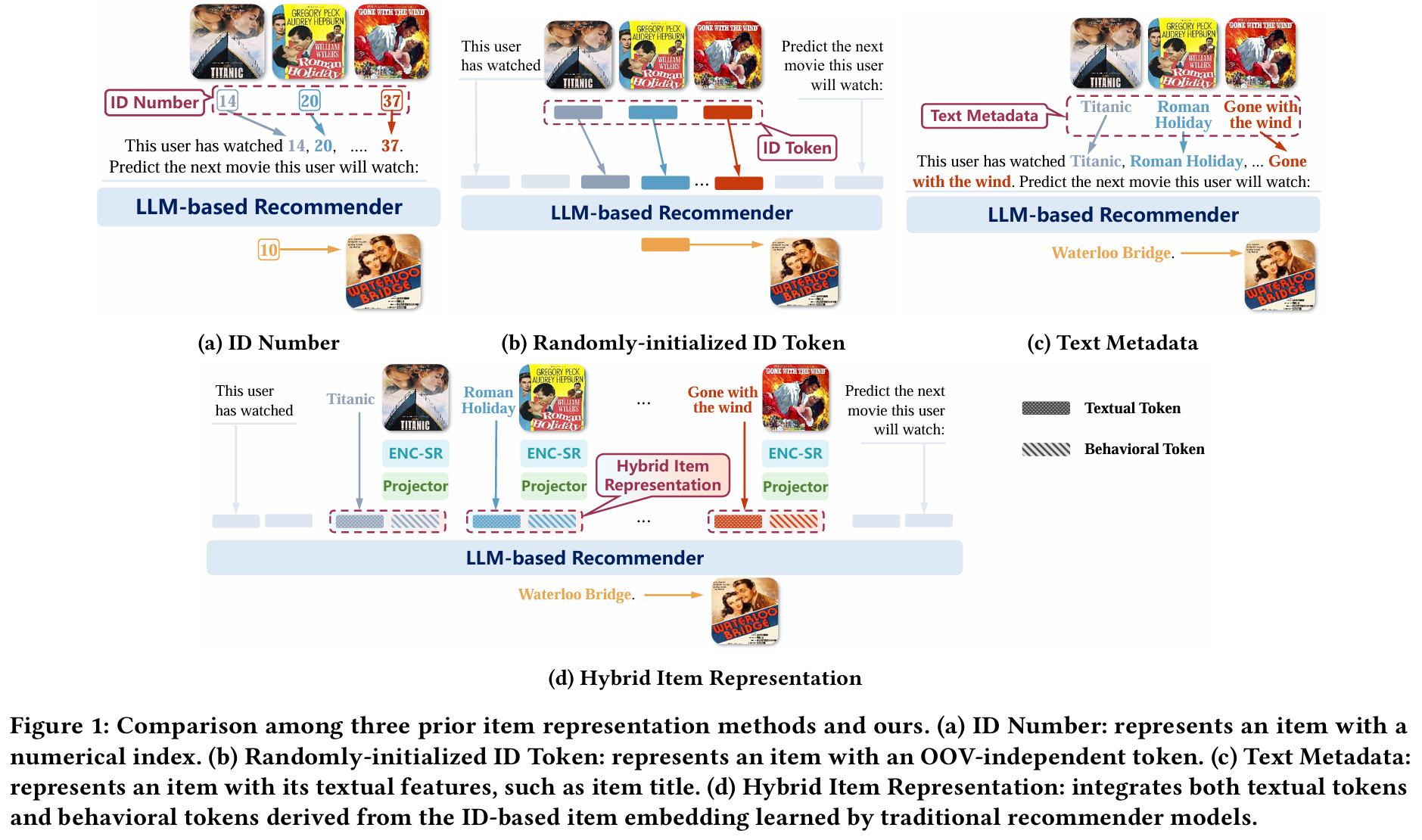

아이템 표현 방법 :

- ID 기반 표현은 아이템을 ID 번호로 나타내지만, 텍스트적 특성을 활용하지 못해 LLM의 지식을 저조하게 활용한다.

- 텍스트 기반 표현은 아이템의 메타데이터(e.g. 제목)를 통해 표현되지만, 사용자 행동 패턴을 충분히 반영하지 못한다.

제안 방법 : 단순한 ID 또는 텍스트 표현 대신, LLM이 사용자 행동 패턴을 깊이 이해할 수 있도록 정렬하는 방법을 탐구한다. 이를 위해 LLaRA(Large Language-Recommendation Assistant)라는 새로운 프레임워크를 제안한다.

LLaRA 프레임워크 :

- 하이브리드 프롬프트 설계 : 텍스트 전용 및 하이브리드 프롬프트를 통해 아이템의 다면적 표현을 만든다. 하이브리드 프롬프트는 추천 모델에서의 행동 패턴을 통합하여 사용자 행동을 보다 포괄적으로 묘사한다.

- 커리큘럼 프롬프트 튜닝 : 초기에는 텍스트 전용 프롬프트로 LLM을 워밍업한 후, 하이브리드 프롬프트로 전환하여 추천 모델에서의 행동 지식을 효과적으로 주입한다. 이 전략은 LLM의 순차 추천 능력을 향상시킨다.

실험 결과 : 세 가지 데이터셋(MovieLens, Steam, LastFM)에서 LLaRA의 성능을 평가한 결과, HitRatio@1 지표에서 기존 순차 추천 모델과 LLM 기반 방법들을 일관되게 초월하였다. 또한, 하이브리드 프롬프트와 커리큘럼 프롬프트 튜닝의 중요성을 입증하는 아블레이션 연구도 수행하였다.

결론 : LLaRA는 LLM에 순차 추천 모델을 통합하여 글로벌 지식과 행동 패턴을 아이템 표현에 통합하는 하이브리드 프롬프트 방법과 모달리티 정렬을 위한 커리큘럼 프롬프트 튜닝을 도입하여 효과성을 입증한다.

3. Preliminary

작업 정의 : 사용자에게 시간 순서대로 상호작용한 아이템 시퀀스 이 주어질 때, 순차 추천 모델은 사용자가 다음에 상호작용할 아이템 을 예측하는 것이다.

커리큘럼 학습 : 커리큘럼 학습은 모델을 단순한 작업에서 복잡한 작업으로 점진적으로 훈련하는 방법이다. 일반적으로 세 가지 주요 단계로 구성된다:

- 복잡성 평가 : 각 데이터 포인트 또는 작업의 복잡성을 정량화하여 학습 우선순위를 할당한다.

- 스케줄러 구성 : 복잡성을 기반으로 모델에 제시할 작업의 순서와 빈도를 배열하는 훈련 스케줄러를 개발한다. 일반적으로 쉬운 작업부터 시작하여 점진적으로 어려운 작업으로 진행한다.

- 훈련 실행 : 미리 정해진 진행에 따라 커리큘럼 학습 과정을 구현한다.

Instruction 튜닝 : Instruction 튜닝은 LLM이 인간의 작업 특정 instruction을 따르도록하여 성능을 크게 향상시킬 수 있는 중요한 접근법이다. 데이터는 형태로 재조직되어, 는 텍스트 instruction, 는 해당 응답을 나타낸다. 이 쌍 형식은 작업 설명을 포함할 뿐만 아니라 훈련 데이터를 자연어 형식으로 변환하여 포괄적인 instruction적 맥락을 만든다.

Parameter-Efficient Fine-Tuning : LLM의 모든 파라미터를 fine-tuning하는 것은 시간과 자원이 많이 소모된다. 이를 완화하기 위해 Parameter-Efficient Fine-Tuning(PEFT)은 더 작은 파라미터 집합을 최적화하여 계산 요구 사항을 크게 줄이면서도 우수한 성능을 달성한다. LoRA는 전형적인 PEFT 알고리즘으로, LLM 가중치를 고정하고 업데이트할 가중치를 학습 가능한 저차원 행렬로 분해한다.

4. Large Language-Recommendation Assistant (LLARA)

개요 : LLaRA는 전통적인 추천 모델에서 학습한 행동 패턴을 LLM에 통합하기 위한 end-to-end 프레임워크이다. 텍스트 전용 프롬프트를 넘어서 하이브리드 프롬프트를 활용하여 추천 시스템에서 파생된 행동 표현을 LLM의 언어 공간과 정렬한다. 커리큘럼 학습을 적용하여 처음에는 텍스트 전용 프롬프트에 집중한 후 점진적으로 하이브리드 프롬프트로 전환한다. 이 전략은 LLM이 추천 메커니즘을 익히고 전통적인 추천 모델의 행동 지식을 내재화하도록 돕는다.

4.1 Item Representation

텍스트 토큰 표현 : 아이템의 제목과 설명과 같은 텍스트적 특징은 LLM의 지식을 활용하는 데 핵심이다. 아이템 의 텍스트 메타데이터 는 다음과 같이 텍스트 토큰으로 변환된다.

여기서 는 LLM의 토크나이저와 단어 임베딩 레이어를 나타낸다.

행동 토큰 표현 : 전통적인 순차 추천 모델(e.g. GRU4Rec, Caser, SASRec)은 역사적 상호작용 데이터에 기반하여 ID 기반 아이템 임베딩 내에서 순차적 패턴을 효과적으로 포착한다. 아이템 의 ID 기반 표현은 다음과 같이 표현된다.

여기서 는 추천 모델에 의해 생성된 아이템 임베딩 함수이다. ID 기반 표현은 텍스트 데이터와는 별개의 모달리티로 간주되며, 이를 LLM의 언어 공간과 정렬하기 위해 특별한 모듈인 SR2LLM을 도입한다. ID 기반 표현 를 LLM 공간으로 로 (i.e., two-layer perceptions) 투영하여 행동 토큰 표현 를 생성한다.

하이브리드 토큰 표현 : 텍스트 토큰 와 행동 토큰 를 통합하여 아이템 의 포괄적인 설명을 생성한다.

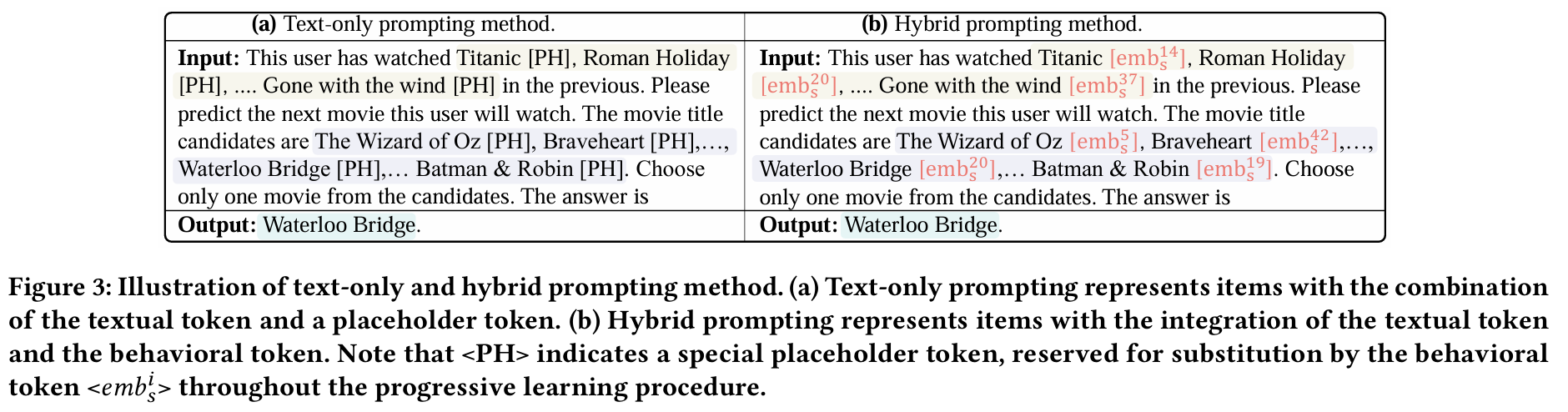

4.2 Hybrid Prompt Design

텍스트 전용 프롬프트 : 순차 상호작용 데이터를 LLM의 instruction 튜닝에 적합한 훈련 데이터로 변환하기 위해 텍스트 전용 프롬프트 방법을 사용한다. 입력 프롬프트 는 다음과 같은 요소를 포함한다.

- 작업 정의 : 순차 추천 작업의 명확한 설명

- 상호작용 시퀀스 : 역사적 사용자-아이템 상호작용 시퀀스

- 후보 세트 : LLM이 응답을 생성할 후보 아이템 세트

하이브리드 프롬프트 : 추천 모델에서 포착한 행동 인사이트를 프롬프트에 통합하기 위해 하이브리드 프롬프트 방법을 개발한다. 하이브리드 입력 프롬프트 는 다음 세 가지 주요 구성 요소로 변환된다.

- 작업 정의 : 텍스트 전용 프롬프트와 동일

- 하이브리드 아이템 표현을 포함한 상호작용 시퀀스 : 역사적 사용자-아이템 상호작용 시퀀스를 하이브리드 아이템 표현으로 나타냄

- 하이브리드 아이템 표현을 포함한 후보 세트 : 텍스트 및 행동 토큰의 통합으로 표현된 후보 아이템 세트

하이브리드 프롬프트는 텍스트 메타데이터와 ID 기반 아이템 임베딩을 통합하여, ID 기반 또는 텍스트 데이터만 의존하는 프롬프트의 한계를 해결하고 더 정확한 추천을 생성한다.

- (a) 텍스트 전용 프롬프트 : 아이템을 텍스트 토큰과 PH(PlaceHolder) 토큰의 조합으로 표현한다.

- (b) 하이브리드 프롬프트 : 아이템을 텍스트 토큰과 행동 토큰의 통합으로 표현한다. 여기서 < PH >는 행동 토큰 < >로 대체하기 위해 예약된 PlaceHolder 토큰을 나타낸다.

4.3 Curriculum Prompt Tuning

4.3 커리큘럼 프롬프트 튜닝

개요 : LLM의 설계에 따르면, 주로 텍스트 데이터로 훈련되므로 추천 모델에서 추출한 행동 토큰을 이해하는 작업은 상당한 도전 과제가 된다. 텍스트 전용 프롬프트는 LLM의 훈련과 잘 맞아 쉽게 습득될 수 있지만, 하이브리드 프롬프트는 일반적인 언어 데이터에서 벗어나 더 복잡한 작업을 도입한다.

커리큘럼 학습에서 영감을 받아 LLaRA에서는 커리큘럼 프롬프트 튜닝 방식을 설계한다. 이 튜닝 과정은 더 간단한 프롬프트 방법인 텍스트 전용 프롬프트에 초점을 맞추며 시작된다. 초기 단계에서 모델은 순차 추천 작업에 대한 기본적인 이해를 형성한다. 이후, 행동 토큰을 포함하는 하이브리드 프롬프트 방법을 점진적으로 도입하여 튜닝 과정의 복잡성을 높인다. 이러한 단계적 전략은 모델이 복잡한 작업에 압도되지 않도록 보장한다.

학습 과정의 단계 : 이 학습 과정은 커리큘럼 학습의 세 가지 주요 단계와 일치하며, 다음과 같이 설명할 수 있다:

- 복잡성 평가 : 커리큘럼 학습의 초기 단계는 각 작업의 복잡성을 평가하는 것이다. LLaRA에서는 하이브리드 프롬프트 설계에서 행동 토큰의 통합과 관련된 작업 복잡성을 정의한다. 여기서 쉬운 작업은 텍스트 전용 프롬프트로 재구성된 순차 데이터로 이루어지고, 어려운 작업은 하이브리드 프롬프트로 재구성된 데이터를 사용한다.

- 쉬운 작업 손실 함수:

- 어려운 작업 손실 함수:

- 쉬운 작업 손실 함수:

이러한 접근 방식은 LLaRA가 행동 토큰을 통합한 하이브리드 아이템 표현으로 완전히 통합될 수 있도록 하는 데 기여한다.

4.3.1 스케줄러 구성

학습 목표 설정 : 쉬운 작업과 어려운 작업의 학습 목표를 설정한 후(식 (7) 및 (8)), 커리큘럼 스케줄러를 구성하여 훈련 과정에서 쉬운 작업에서 어려운 작업으로 점진적으로 전환한다.

- 학습 확률 정의 : 시점에서 어려운 작업을 학습할 확률을 로 정의하며, 는 쉬운 작업의 확률이다. 초기에는 가 작고, 학습 과정이 진행됨에 따라 점차 증가하도록 설정한다. 이를 연속적으로 표현하면 다음과 같다:

여기서 는 총 훈련 시간을 의미한다.

4.3.2 훈련 실행

효율성과 효과성의 균형 : LLaRA에 대해 LoRA 튜닝(식 (2) 참조)을 수행하는 동시에 프로젝터도 함께 훈련한다.

- 지표 함수 정의 :

- 학습 목표의 진화 : LLaRA의 학습 목표는 쉬운 작업에서 어려운 작업으로 전환된다:

이러한 점진적인 학습 과정은 추가 모달리티를 주입하여 하이브리드 프롬프트 방법을 실현하는 데 기여한다. 커리큘럼 프롬프트 튜닝 전략을 채택함으로써 모델이 텍스트 메타데이터를 이해하는 초기 단계에서 전통적인 추천 모델의 더 복잡한 ID 기반 아이템 임베딩을 이해하는 단계로 원활하게 전환할 수 있도록 한다. 이 전략은 LLM이 추천 메커니즘을 익히고, 순차 추천기에 내재된 행동 지식으로 LLM을 향상시키는 데 기여한다.