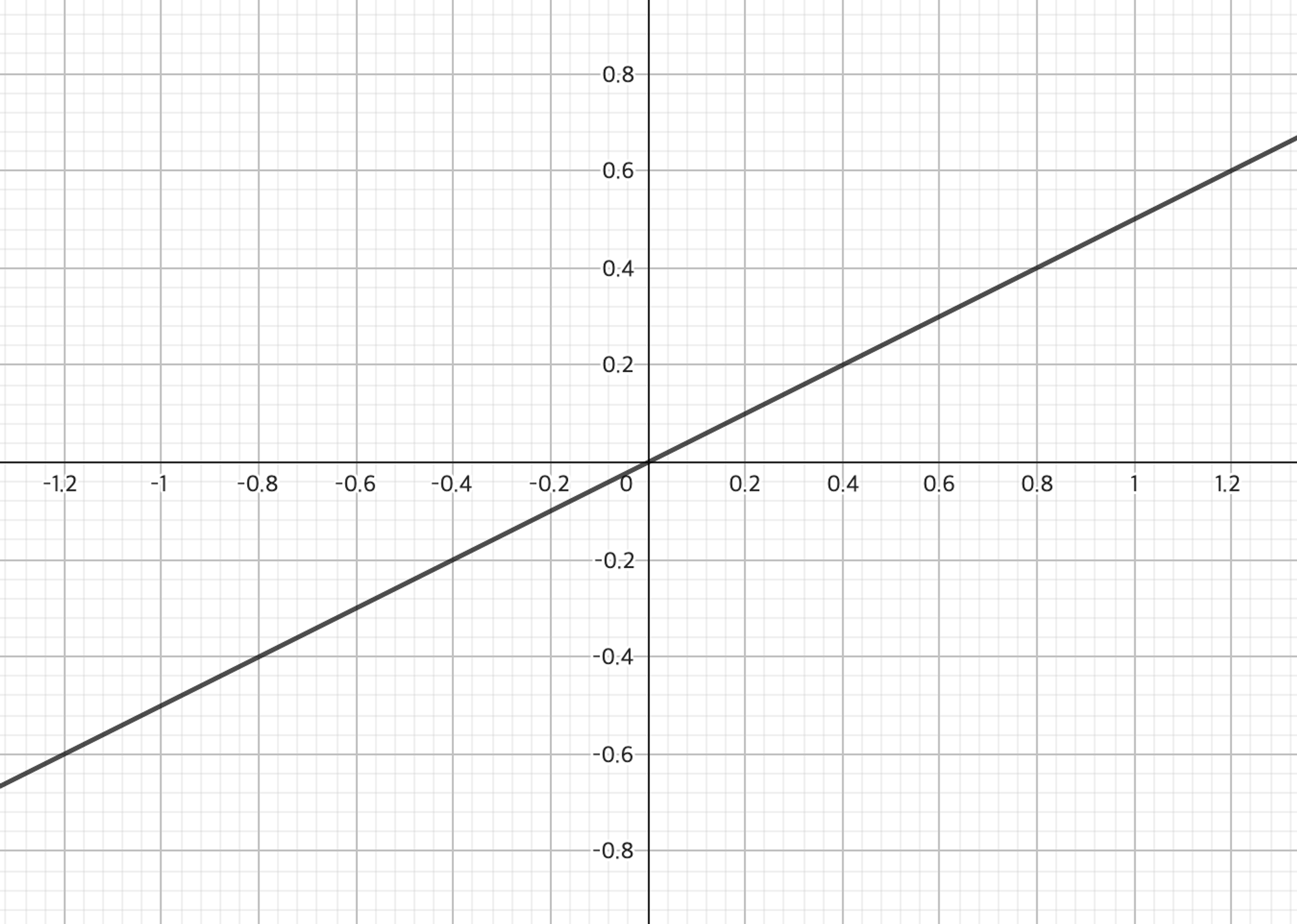

1. 선형 함수(linear function)

선형 함수는 사실 활성화 함수에 포함되지 않는다. 미분 시 항상 같은 값인 기울기를 반환하므로 학습에 영향을 주지 않는다.

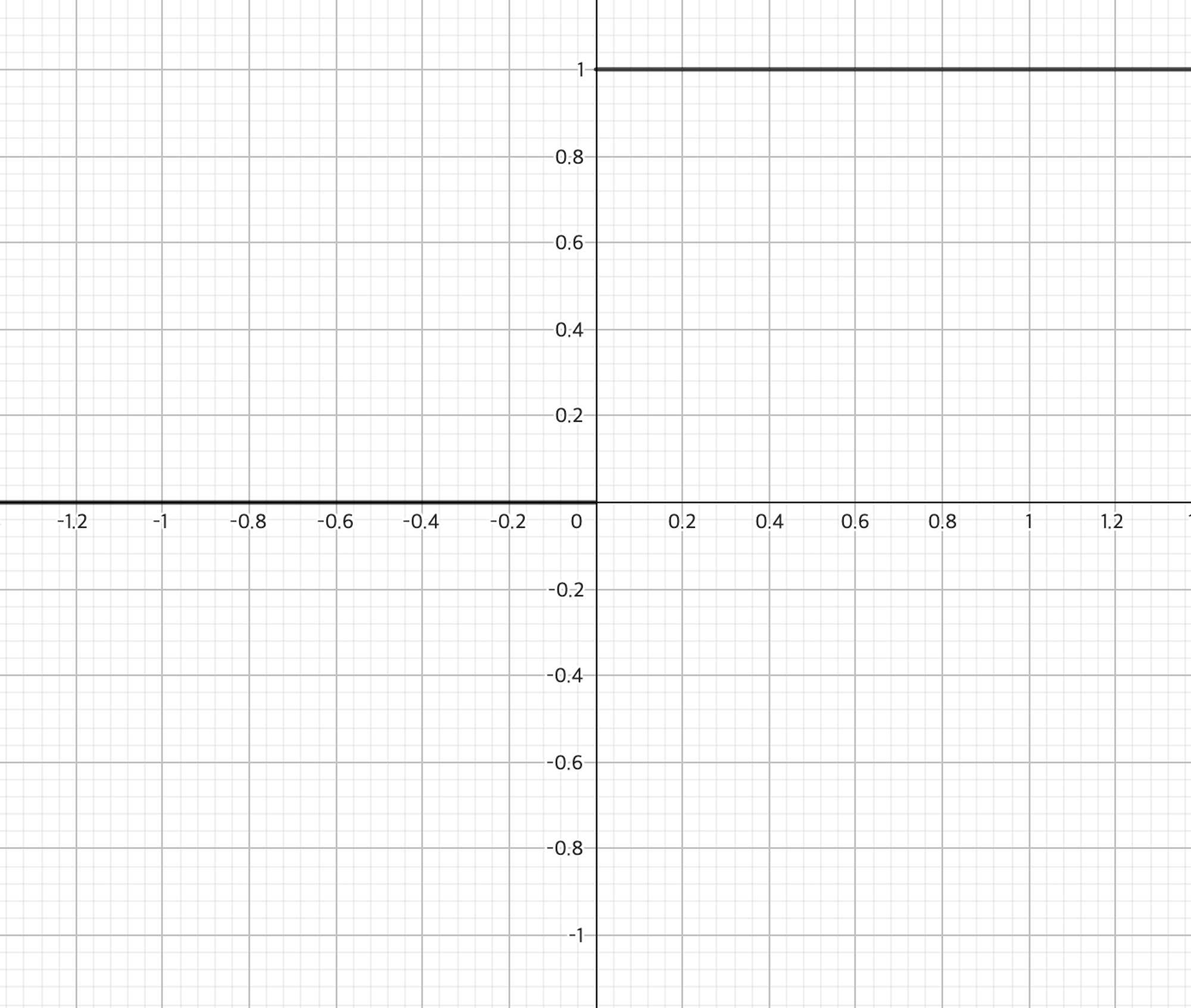

2. 계단 함수(step function)

이진 활성화 함수(Binary Activation Function)라고도 불리는 계단 함수는 입력값의 합이 임곗값을 넘으면 0을 출력하고, 넘지 못하면 1을 출력한다.

3. 비선형 함수(non-linear function)

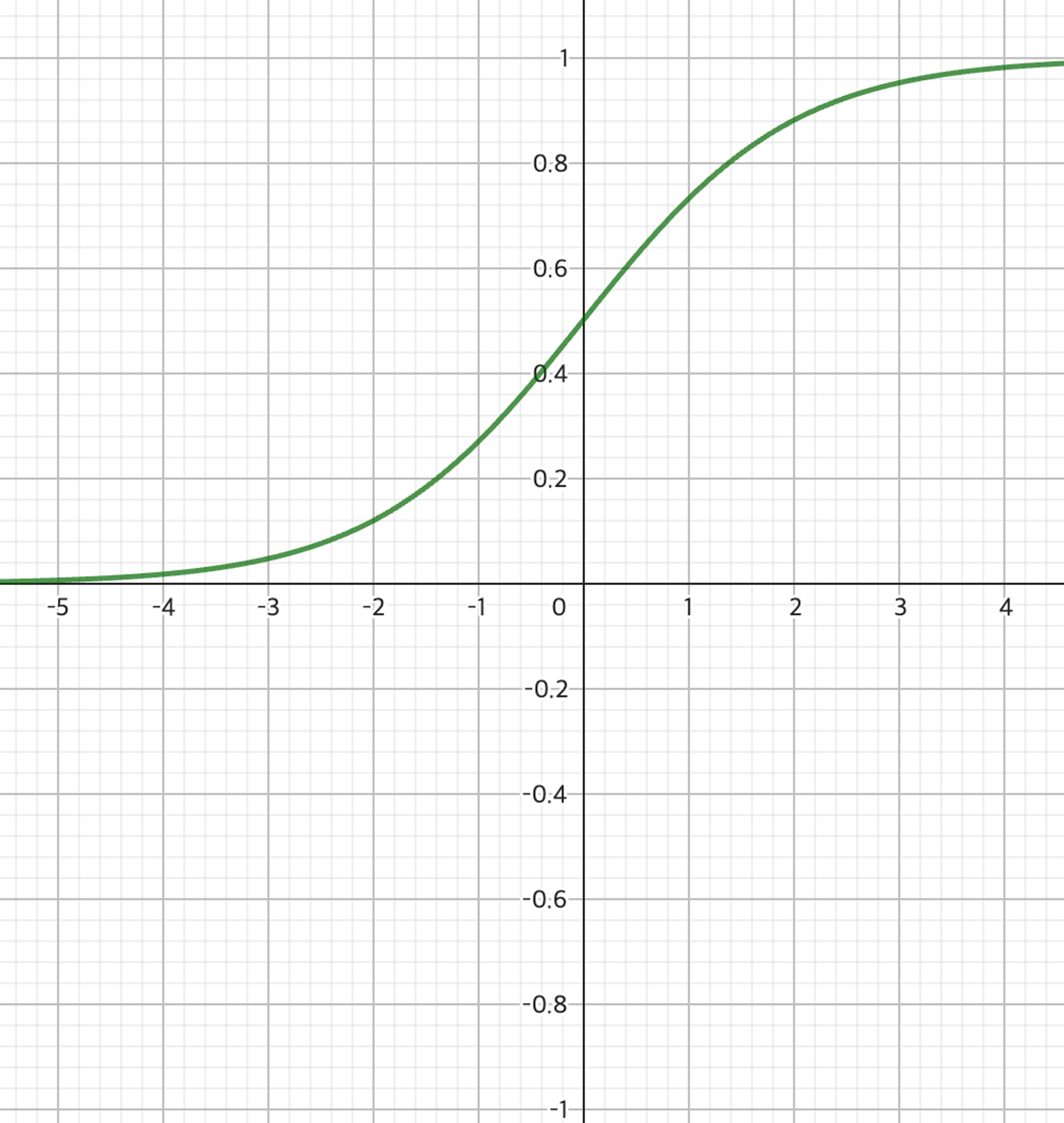

(1) 시그모이드 함수(sigmoid function)

시그모이드 함수는 미분식이 단순한 형태로 입력값에 따라 출력값이 급격하게 변하지 않는다. 미분 후 나오는 출력값이 0과 1 사이이기 때문에 기울기 폭주 문제가 일어나지 않지만, 그 출력값이 0과 1 사이이기 때문에 기울기 소실 문제가 발생할 수 있다.

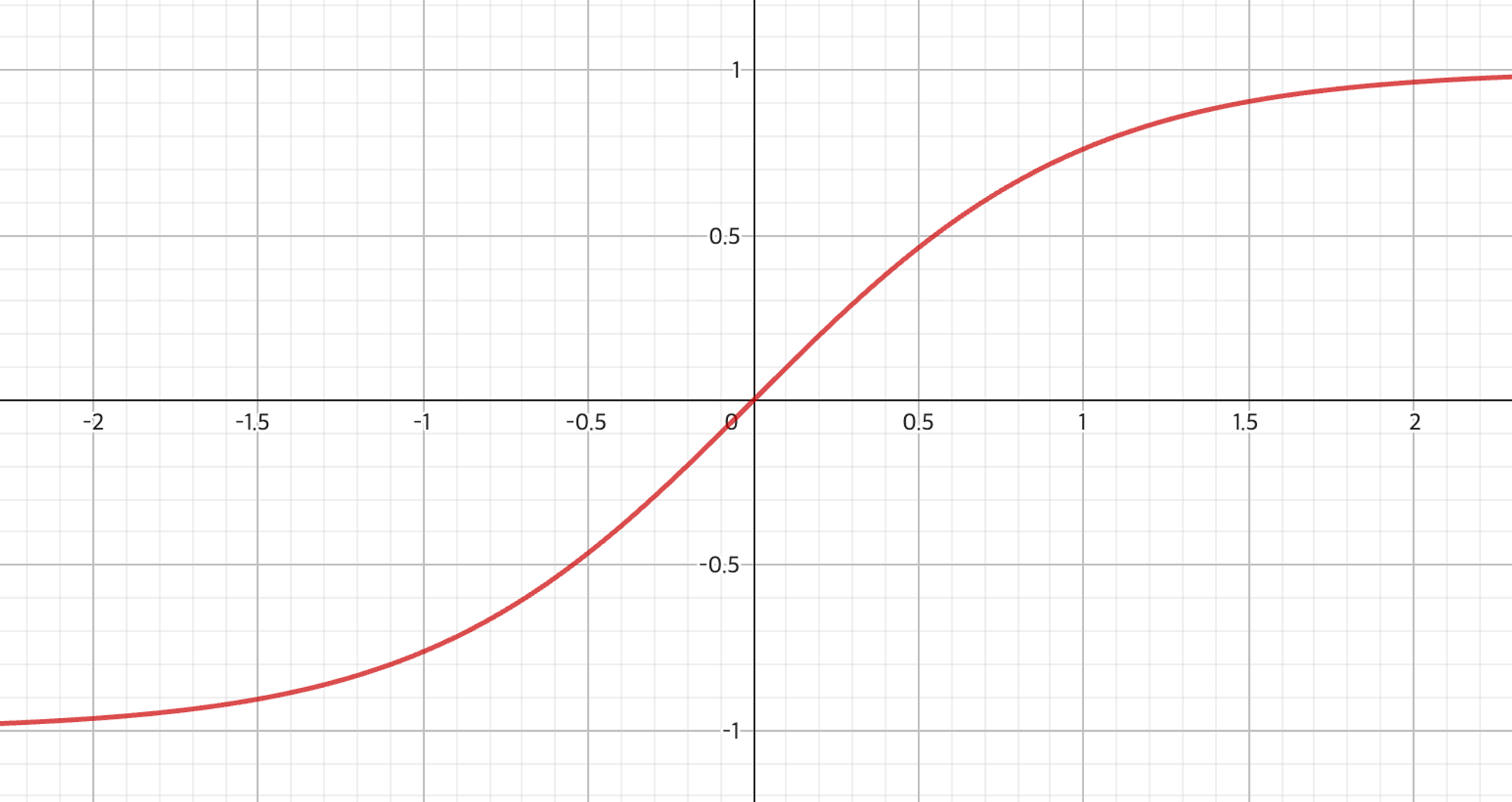

(2) 하이퍼볼릭 탄젠트 함수(tanh)

하이퍼볼릭 탄젠트 함수는 시그모이드 함수(Sigmoid Function)와 유사한 형태를 지니지만, 출력값의 중심이 0을 갖는다. 또한, 출력값이 -1과 1 사이이기 때문에 음수값 반환이 가능하다.

출력값의 범위가 더 넓고 다양한 형태로 활성화 시킬 수 있으므로 기울기 소실(Vanishing Gradient)이 비교적 덜 발생한다.

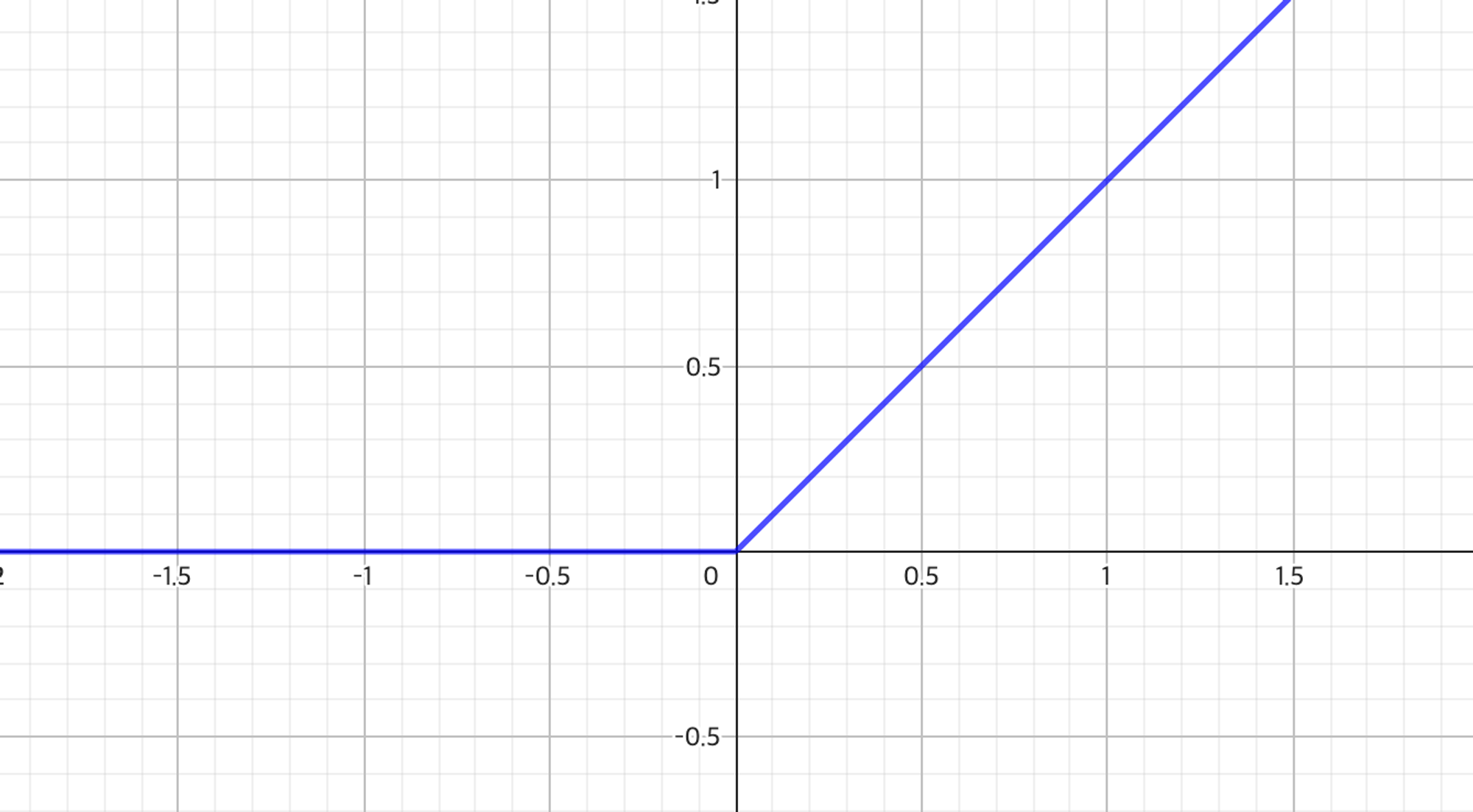

(3) ReLU 함수

ReLU 함수(Rectified Linear Unit Function)는 0보다 작거나 같으면 0을 반환하며, 0보다 크면 선형 함수에 값을 대입하는 구조를 갖는다.

입력값이 양수라면 미분 값이 일정해 기울기 소실이 발생하지 않는다. 하지만 입력값이 음수인 경우 항상 0을 반환하므로, 가중치(Weight)나 편향(Bias)이 갱신(Update)되지 않을 수 있다.

(4) 소프트맥스 함수(softmax function)

소프트맥스 함수는 세 개 이상으로 분류하는 다중 클래스 분류에서 사용되는 활성화함수이다. n차원의 벡터를 입력받아 각 클래스에 속할 확률을 추정한다. 시그모이드 함수와 다르게 확률의 총합이 1이므로, 어떤 분류에 속할 확률에 대해 정확히 알 수 있다.