금일 팀원 중에서 AI 모델링의 기초 내용을 약 45분 가량 설명해주셨다. 나는 책으로만 접했었기 때문에 한 번 꼭 들어보고 싶어서 참여하였고, 내용을 듣다가 모르는 부분을 보충하기 위해 포스팅한다.

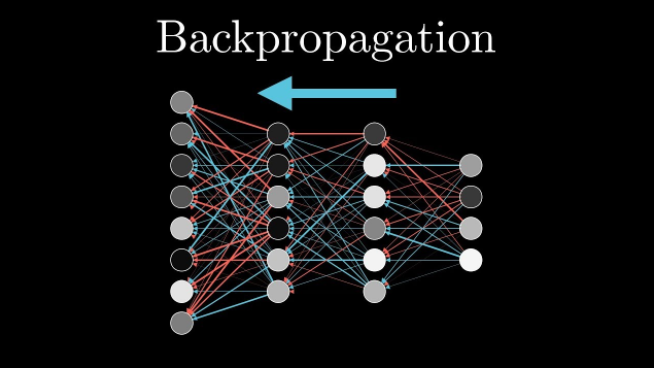

역전파(Back Propagation,backprop)

신경망은 입력값을 받아 출력을 만들지만, 처음에는 엉뚱한 값을 내보내서 출력값과 실제 값 사이의 오차를 줄이는 과정이 필요하다.

해결방법 : 신경망이 순방향으로 값을 계산하고 오차를 구한 다음, 연쇄 법칙을 이용해 가중치를 조정한다.

=> 역방향으로 미분(Gradient Descent)하면서 학습하는 과정이 역전파이다.

✅ 여기서 연쇄 법칙(Chain Rule)이란?

합성함수를 미분할 때 사용하는 규칙

즉, 함수 안에 다른 함수가 있을 때 미분하는 방법을 알려주는 법칙이다.

바깥 함수 미분 x 안쪽 함수 미분

오차를 역으로 전달하며 가중치를 조정한다.

1. 입력값-> 은닉층 -> 출력값 계산 후출력값과 정답의 차이를 비교(오차계산)

2. 오차 계산 (Loss Function)

손실 측정 e.g) MSE, Cross-Entropy

3. 역전파(Backpropagation)

연쇄법칙을 이용해 가중치의 변화량을 계산

각 층의 가중치를 조금씩 업데이트

4. 가중치 업데이트

가중치를 조정해서 오차를 줄임

순전파 -> 역전파 반복

=> 오차가 줄어들면서 신경망이 학습됨.

신경망은 합성함수의 연속적인 구조이기 때문에, 미분을 구하려면 연쇄 법칙이 필수이다.

역전파의 쓰임

✅ 딥러닝(Deep Learning)에서 인공지능 학습의 핵심 알고리즘!

✅ 이미지 인식(CNN), 자연어 처리(RNN), 챗봇, 음성 인식 등에서 사용

✅ 모든 최신 AI 모델(예: ChatGPT, AlphaGo)도 역전파를 사용함!

에폭(Epoch)

전체 데이터셋을 한 번에 학습하는 과정을 의미한다.

즉, 모든 훈련 데이터를 한 번 다 사용해서 신경망을 학습하는 횟수를 말한다. (= 학습이 한 바퀴 도는 것)

에폭을 여러 번 반복해야 신경망 패턴을 제대로 학습

데이터가 많으면 한 번의 학습으로는 충분하지 않음

너무 적으면 학습이 부족하고, 너무 많으면 과적합

✔ 배치(Batch)

👉 전체 데이터셋을 한 번에 처리하기 어렵기 때문에, 작은 묶음(Batch)으로 나눠서 학습

✔ 배치 크기(Batch Size)

👉 한 번에 학습할 데이터 개수

배치 크기 = 32 → 한 번에 32개씩 학습

배치 크기 = 64 → 한 번에 64개씩 학습

✔ 스텝(Step)

👉 한 에폭에서 수행되는 배치의 개수

예: 데이터 1,000개 / 배치 크기 100 → 1 에폭 = 10 스텝

✔ 이터레이션(Iteration)

👉 한 번의 배치를 학습하는 과정

배치 크기 = 50 → 1 이터레이션 = 50개 데이터 학습