2.2 벡터와 행렬의 연산

벡터/행렬의 덧셈과 뺄셈

같은 크기를 가진 두 개의 벡터나 행렬은 덧셈과 뺄셈을 할 수 있다. 두 벡터와 행렬에서 같은 위치에 있는 원소끼리 덧셈과 뺄셈을 하면 된다. 이러한 연산을 요소별(element-wise) 연산 이라고 한다.

예를 들어 벡터 x x x y y y

x = [ 10 11 12 ] , y = [ 0 1 2 ] (2.2.1) x= \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} ,\;\; y= \begin{bmatrix} 0 \\ 1 \\ 2 \\ \end{bmatrix} \tag{2.2.1} x = ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ , y = ⎣ ⎢ ⎡ 0 1 2 ⎦ ⎥ ⎤ ( 2 . 2 . 1 ) 벡터 x x x y y y x + y x+y x + y x − y x-y x − y

x + y = [ 10 11 12 ] + [ 0 1 2 ] = [ 10 + 0 11 + 1 12 + 2 ] = [ 10 12 14 ] (2.2.2) x + y = \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} + \begin{bmatrix} 0 \\ 1 \\ 2 \\ \end{bmatrix} = \begin{bmatrix} 10 + 0 \\ 11 + 1 \\ 12 + 2 \\ \end{bmatrix} = \begin{bmatrix} 10 \\ 12 \\ 14 \\ \end{bmatrix} \tag{2.2.2} x + y = ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ + ⎣ ⎢ ⎡ 0 1 2 ⎦ ⎥ ⎤ = ⎣ ⎢ ⎡ 1 0 + 0 1 1 + 1 1 2 + 2 ⎦ ⎥ ⎤ = ⎣ ⎢ ⎡ 1 0 1 2 1 4 ⎦ ⎥ ⎤ ( 2 . 2 . 2 ) x − y = [ 10 11 12 ] − [ 0 1 2 ] = [ 10 − 0 11 − 1 12 − 2 ] = [ 10 10 10 ] (2.2.3) x - y = \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} - \begin{bmatrix} 0 \\ 1 \\ 2 \\ \end{bmatrix} = \begin{bmatrix} 10 - 0 \\ 11 - 1 \\ 12 - 2 \\ \end{bmatrix} = \begin{bmatrix} 10 \\ 10 \\ 10 \\ \end{bmatrix} \tag{2.2.3} x − y = ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ − ⎣ ⎢ ⎡ 0 1 2 ⎦ ⎥ ⎤ = ⎣ ⎢ ⎡ 1 0 − 0 1 1 − 1 1 2 − 2 ⎦ ⎥ ⎤ = ⎣ ⎢ ⎡ 1 0 1 0 1 0 ⎦ ⎥ ⎤ ( 2 . 2 . 3 ) 벡터의 덧셈과 뺄셈을 넘파이로 계산하면 다음과 같다. 여기에서는 편의상 1차원 배열로 벡터를 표시하였다.

x = np. array( [ 10 , 11 , 12 , 13 , 14 ] )

y = np. array( [ 0 , 1 , 2 , 3 , 4 ] ) x + yarray([10, 12, 14, 16, 18])

x - yarray([10, 10, 10, 10, 10])

행렬도 같은 방법으로 덧셈과 뺄셈을 할 수 있다.

[ 5 6 7 8 ] + [ 10 20 30 40 ] − [ 1 2 3 4 ] = [ 14 24 34 44 ] (2.2.4) \begin{bmatrix} 5 & 6 \\ 7 & 8 \end{bmatrix} + \begin{bmatrix} 10 & 20 \\ 30 & 40 \\ \end{bmatrix} - \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} = \begin{bmatrix} 14 & 24 \\ 34 & 44 \end{bmatrix} \tag{2.2.4} [ 5 7 6 8 ] + [ 1 0 3 0 2 0 4 0 ] − [ 1 3 2 4 ] = [ 1 4 3 4 2 4 4 4 ] ( 2 . 2 . 4 ) np. array( [ [ 5 , 6 ] , [ 7 , 8 ] ] ) + np. array( [ [ 10 , 20 ] , [ 30 , 40 ] ] ) -

np. array( [ [ 1 , 2 ] , [ 3 , 4 ] ] ) array([[14, 24],

[34, 44]])

스칼라와 벡터/행렬의 곱셈

벡터 x x x A A A c c c 벡터 x x x A A A c c c 과 같다.

c [ x 1 x 2 ] = [ c x 1 c x 2 ] (2.2.5) c \begin{bmatrix} x_1 \\ x_2 \end{bmatrix} = \begin{bmatrix} cx_1 \\ cx_2 \end{bmatrix} \tag{2.2.5} c [ x 1 x 2 ] = [ c x 1 c x 2 ] ( 2 . 2 . 5 ) c [ a 11 a 12 a 21 a 22 ] = [ c a 11 c a 12 c a 21 c a 22 ] (2.2.6) c \begin{bmatrix} a_{11} & a_{12} \\ a_{21} & a_{22} \end{bmatrix} = \begin{bmatrix} ca_{11} & ca_{12} \\ ca_{21} & ca_{22} \end{bmatrix} \tag{2.2.6} c [ a 1 1 a 2 1 a 1 2 a 2 2 ] = [ c a 1 1 c a 2 1 c a 1 2 c a 2 2 ] ( 2 . 2 . 6 ) 브로드캐스팅

원래 덧셈과 뺄셈은 크기(차원)가 같은 두 벡터에 대해서만 할 수 있다. 하지만 벡터와 스칼라의 경우에는 관례적으로 다음처럼 1-벡터를 사용하여 스칼라를 벡터로 변환한 연산을 허용한다. 이를 브로드캐스팅(broadcasting) 이라고 한다.

[ 10 11 12 ] − 10 = [ 10 11 12 ] − 10 ⋅ 1 = [ 10 11 12 ] − [ 10 10 10 ] (2.2.7) \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} - 10 = \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} - 10\cdot \mathbf{1} = \begin{bmatrix} 10 \\ 11 \\ 12 \\ \end{bmatrix} - \begin{bmatrix} 10 \\ 10 \\ 10 \\ \end{bmatrix} \tag{2.2.7} ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ − 1 0 = ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ − 1 0 ⋅ 1 = ⎣ ⎢ ⎡ 1 0 1 1 1 2 ⎦ ⎥ ⎤ − ⎣ ⎢ ⎡ 1 0 1 0 1 0 ⎦ ⎥ ⎤ ( 2 . 2 . 7 ) 데이터 분석에서는 원래의 데이터 벡터 x x x 평균제거(mean removed) 벡터 혹은 0-평균(zero-mean) 벡터 를 사용하는 경우가 많다.

x = [ x 1 x 2 ⋮ x N ] → x − m = [ x 1 − m x 2 − m ⋮ x N − m ] (2.2.8) x = \begin{bmatrix} x_1 \\ x_2 \\ \vdots \\ x_N \end{bmatrix} \;\; \rightarrow \;\; x - m = \begin{bmatrix} x_1 - m\\ x_2 - m \\ \vdots \\ x_N - m \end{bmatrix} \tag{2.2.8} x = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 x 2 ⋮ x N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ → x − m = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 − m x 2 − m ⋮ x N − m ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ( 2 . 2 . 8 ) 위 식에서 m m m

m = 1 N ∑ i = 1 N x i (2.2.9) m = \dfrac{1}{N}\sum_{i=1}^N x_i \tag{2.2.9} m = N 1 i = 1 ∑ N x i ( 2 . 2 . 9 ) 선형조합

벡터/행렬에 다음처럼 스칼라값을 곱한 후 더하거나 뺀 것을 벡터/행렬의 선형조합(linear combination) 이라고 한다. 벡터나 행렬을 선형조합해도 크기는 변하지 않는다.

c 1 x 1 + c 2 x 2 + c 3 x 3 + ⋯ + c L x L = x (2.2.10) c_1x_1 + c_2x_2 + c_3x_3 + \cdots + c_Lx_L = x \tag{2.2.10} c 1 x 1 + c 2 x 2 + c 3 x 3 + ⋯ + c L x L = x ( 2 . 2 . 1 0 ) c 1 A 1 + c 2 A 2 + c 3 A 3 + ⋯ + c L A L = A (2.2.11) c_1A_1 + c_2A_2 + c_3A_3 + \cdots + c_LA_L = A \tag{2.2.11} c 1 A 1 + c 2 A 2 + c 3 A 3 + ⋯ + c L A L = A ( 2 . 2 . 1 1 ) c 1 , c 2 , … , c L ∈ R (2.2.12) c_1, c_2, \ldots, c_L \in \mathbf{R} \tag{2.2.12} c 1 , c 2 , … , c L ∈ R ( 2 . 2 . 1 2 ) x 1 , x 2 , … , x L , x ∈ R M (2.2.13) x_1, x_2, \ldots, x_L, x \in \mathbf{R}^M \tag{2.2.13} x 1 , x 2 , … , x L , x ∈ R M ( 2 . 2 . 1 3 ) A 1 , A 2 , … , A L , A ∈ R M × N (2.2.14) A_1, A_2, \ldots, A_L, A \in \mathbf{R}^{M \times N} \tag{2.2.14} A 1 , A 2 , … , A L , A ∈ R M × N ( 2 . 2 . 1 4 ) 벡터나 행렬의 크기를 직사각형으로 표시하면 다음과 같다.

c 1 \mathstrut x 1 \mathstrut + c 2 \mathstrut x 2 \mathstrut + ⋯ + c L \mathstrut x L \mathstrut (2.2.15) \begin{matrix} c_1\,\boxed{\begin{matrix} \phantom{\LARGE\mathstrut} \\ x_1 \\ \phantom{\LARGE\mathstrut} \end{matrix}} & + & c_2\,\boxed{\begin{matrix} \phantom{\LARGE\mathstrut} \\ x_2 \\ \phantom{\LARGE\mathstrut} \end{matrix}} & + & \cdots \!\!\!\!& + & c_L\,\boxed{\begin{matrix} \phantom{\LARGE\mathstrut} \\ x_L \\ \phantom{\LARGE\mathstrut} \end{matrix}} \end{matrix} \tag{2.2.15} c 1 \mathstrut x 1 \mathstrut + c 2 \mathstrut x 2 \mathstrut + ⋯ + c L \mathstrut x L \mathstrut ( 2 . 2 . 1 5 ) c 1 A 1 + c 2 A 2 + ⋯ + c L A L (2.2.16) \begin{matrix} c_1\,\boxed{\begin{matrix} \phantom{} & \phantom{} & \phantom{} \\ & A_1 & \\ \phantom{} & \phantom{} & \phantom{} \end{matrix}} & + & c_2\,\boxed{\begin{matrix} \phantom{} & \phantom{} & \phantom{} \\ & A_2 & \\ \phantom{} & \phantom{} & \phantom{} \end{matrix}} & + & \cdots & + & c_L\,\boxed{\begin{matrix} \phantom{} & \phantom{} & \phantom{} \\ & A_L & \\ \phantom{} & \phantom{} & \phantom{} \end{matrix}} \end{matrix} \tag{2.2.16} c 1 A 1 + c 2 A 2 + ⋯ + c L A L ( 2 . 2 . 1 6 ) 벡터와 벡터의 곱셈

행렬의 곱셈을 정의하기 전에 우선 두 벡터의 곱셈을 알아보자. 벡터를 곱셈하는 방법은 여러 가지가 있지만 여기서는 내적(inner product) 에 대해서만 다룬다. 벡터 x x x y y y

x T y (2.2.17) x^T y \tag{2.2.17} x T y ( 2 . 2 . 1 7 ) 내적은 다음처럼 점(dot)으로 표기하는 경우도 있어서 닷 프로덕트(dot product) 라고도 부르고 < x , y x,y x , y

x ⋅ y = < x , y > = x T y (2.2.18) x \cdot y = \, < x, y > \, = x^T y \tag{2.2.18} x ⋅ y = < x , y > = x T y ( 2 . 2 . 1 8 ) 두 벡터를 내적하려면 다음과 같은 조건이 만족되어야 한다.

우선 두 벡터의 차원(길이)이 같아야 한다.

앞의 벡터가 행 벡터이고 뒤의 벡터가 열 벡터여야 한다.

이때 내적의 결과는 스칼라값이 되며 다음처럼 계산한다. 우선 같은 위치에 있는 원소들을 요소별 곱셈처럼 곱한 다음, 그 값들을 다시 모두 더해서 하나의 스칼라값으로 만든다.

x T y = [ x 1 x 2 ⋯ x N ] [ y 1 y 2 ⋮ y N ] = x 1 y 1 + ⋯ + x N y N = ∑ i = 1 N x i y i (2.2.19) x^T y = \begin{bmatrix} x_{1} & x_{2} & \cdots & x_{N} \end{bmatrix} \begin{bmatrix} y_{1} \\ y_{2} \\ \vdots \\ y_{N} \\ \end{bmatrix} = x_1 y_1 + \cdots + x_N y_N = \sum_{i=1}^N x_i y_i \tag{2.2.19} x T y = [ x 1 x 2 ⋯ x N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ y 1 y 2 ⋮ y N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = x 1 y 1 + ⋯ + x N y N = i = 1 ∑ N x i y i ( 2 . 2 . 1 9 ) x ∈ R N × 1 (2.2.20) x \in \mathbf{R}^{N \times 1} \tag{2.2.20} x ∈ R N × 1 ( 2 . 2 . 2 0 ) y ∈ R N × 1 (2.2.21) y \in \mathbf{R}^{N \times 1} \tag{2.2.21} y ∈ R N × 1 ( 2 . 2 . 2 1 ) x T y ∈ R (2.2.22) x^T y \in \mathbf{R} \tag{2.2.22} x T y ∈ R ( 2 . 2 . 2 2 ) 다음은 두 벡터의 내적의 예다.

x = [ 1 2 3 ] , y = [ 4 5 6 ] (2.2.23) x = \begin{bmatrix} 1 \\ 2 \\ 3 \\ \end{bmatrix} ,\;\;\; y = \begin{bmatrix} 4 \\ 5 \\ 6 \\ \end{bmatrix} \tag{2.2.23} x = ⎣ ⎢ ⎡ 1 2 3 ⎦ ⎥ ⎤ , y = ⎣ ⎢ ⎡ 4 5 6 ⎦ ⎥ ⎤ ( 2 . 2 . 2 3 ) x T y = [ 1 2 3 ] [ 4 5 6 ] = 1 ⋅ 4 + 2 ⋅ 5 + 3 ⋅ 6 = 32 (2.2.24) x^T y = \begin{bmatrix} 1 & 2 & 3 \end{bmatrix} \begin{bmatrix} 4 \\ 5 \\ 6 \\ \end{bmatrix} = 1 \cdot 4 + 2 \cdot 5 + 3 \cdot 6 = 32 \tag{2.2.24} x T y = [ 1 2 3 ] ⎣ ⎢ ⎡ 4 5 6 ⎦ ⎥ ⎤ = 1 ⋅ 4 + 2 ⋅ 5 + 3 ⋅ 6 = 3 2 ( 2 . 2 . 2 4 ) 넘파이에서 벡터와 행렬의 내적은 dot()이라는 명령 또는 @(at이라고 읽는다)이라는 연산자로 계산한다. 2차원 배열로 표시한 벡터를 내적했을 때는 결과값이 스칼라가 아닌 2차원 배열이다.

x = np. array( [ [ 1 ] , [ 2 ] , [ 3 ] ] )

y = np. array( [ [ 4 ] , [ 5 ] , [ 6 ] ] )

x. T @ y array([[32]])

넘파이에서는 1차원 배열끼리도 내적을 계산한다. 이때는 넘파이가 앞의 벡터는 행 벡터이고 뒤의 벡터는 열 벡터라고 가정한다.

x = np. array( [ 1 , 2 , 3 ] )

y = np. array( [ 4 , 5 , 6 ] )

x @ y 32

왜 벡터의 내적은 덧셈이나 뺄셈과 달리 이렇게 복잡하게 정의된 것일까? 그 이유는 데이터 분석을 할 때 이러한 연산이 필요하기 때문이다. 벡터의 내적을 사용하여 데이터를 분석하는 몇 가지 예를 살펴보자.

가중합

벡터의 내적은 가중합을 계산할 때 쓰일 수 있다. 가중합(weighted sum) 이란 복수의 데이터를 단순히 합하는 것이 아니라 각각의 수에 어떤 가중치 값을 곱한 후 이 곱셈 결과들을 다시 합한 것을 말한다.

만약 데이터 벡터가 x = [ x 1 , ⋯ , x N ] T x=[x_1, \cdots, x_N]^T x = [ x 1 , ⋯ , x N ] T w = [ w 1 , ⋯ , w N ] T w=[w_1, \cdots, w_N]^T w = [ w 1 , ⋯ , w N ] T

w 1 x 1 + ⋯ + w N x N = ∑ i = 1 N w i x i (2.2.25) w_1 x_1 + \cdots + w_N x_N = \sum_{i=1}^N w_i x_i \tag{2.2.25} w 1 x 1 + ⋯ + w N x N = i = 1 ∑ N w i x i ( 2 . 2 . 2 5 ) 이 값을 벡터 x x x w w w w T x w^Tx w T x x T w x^Tw x T w

∑ i = 1 N w i x i = [ w 1 w 2 ⋯ w N ] [ x 1 x 2 ⋮ x N ] = w T x = [ x 1 x 2 ⋯ x N ] [ w 1 w 2 ⋮ w N ] = x T w (2.2.26) \begin{aligned} \sum_{i=1}^N w_i x_i &= \begin{bmatrix} w_{1} && w_{2} && \cdots && w_{N} \end{bmatrix} \begin{bmatrix} x_1 \\ x_2 \\ \vdots \\ x_N \end{bmatrix} &= w^Tx \\ &= \begin{bmatrix} x_{1} && x_{2} && \cdots && x_{N} \end{bmatrix} \begin{bmatrix} w_1 \\ w_2 \\ \vdots \\ w_N \end{bmatrix} &= x^Tw \end{aligned} \tag{2.2.26} i = 1 ∑ N w i x i = [ w 1 w 2 ⋯ w N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 x 2 ⋮ x N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = [ x 1 x 2 ⋯ x N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ w 1 w 2 ⋮ w N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = w T x = x T w ( 2 . 2 . 2 6 ) 예를 들어 쇼핑을 할 때 각 물건의 가격은 데이터 벡터, 각 물건의 수량은 가중치로 생각하여 내적을 구하면 총금액을 계산할 수 있다.

만약 가중치가 모두 1이면 일반적인 합(sum)을 계산한다.

w 1 = w 2 = ⋯ = w N = 1 (2.2.27) w_1 = w_2 = \cdots = w_N = 1 \tag{2.2.27} w 1 = w 2 = ⋯ = w N = 1 ( 2 . 2 . 2 7 ) 또는

w = 1 N (2.2.28) w = \mathbf{1}_N \tag{2.2.28} w = 1 N ( 2 . 2 . 2 8 ) 이면

∑ i = 1 N x i = 1 N T x (2.2.29) \sum_{i=1}^N x_i = \mathbf{1}_N^T x \tag{2.2.29} i = 1 ∑ N x i = 1 N T x ( 2 . 2 . 2 9 ) 연습 문제 2.2.1

A, B, C 세 회사의 주식은 각각 100만원, 80만원, 50만원이다. 이 주식을 각각 3주, 4주, 5주를 매수할 때 필요한 금액을 구하고자 한다.

(1) 주식의 가격과 수량을 각각 p p p n n n

(2) 주식을 매수할 때 필요한 금액을 곱셈으로 표시하고 넘파이 연산으로 그 값을 계산한다.

import numpy as np

import matplotlib. pylab as plt

p = np. array( [ 100 , 80 , 50 ] )

n = np. array( [ 3 , 4 , 5 ] )

print ( p @ n)

print ( p. T @ n)

print ( p @ n. T)

print ( p. T @ n. T) 가중평균

가중합의 가중치값을 전체 가중치값의 합으로 나누면 가중평균(weighted average) 이 된다. 가중평균은 대학교의 평균 성적 계산 등에 사용할 수 있다.

예를 들어 고등학교에서는 국어, 영어, 두 과목의 평균 점수를 구할 때 단순히 두 과목의 점수(숫자)를 더한 후 2으로 나눈다. 그러나 대학교에서는 중요한 과목과 중요하지 않는 과목을 구분하는 학점(credit)이라는 숫자가 있다. 일주일에 한 시간만 수업하는 과목은 1학점짜리 과목이고 일주일에 세 시간씩 수업하는 중요한 과목은 3학점짜리 과목이다. 1학점과 3학점 과목의 점수가 각각 100점, 60점이면 학점을 고려한 가중 평균(weighted average) 성적은 다음과 같이 계산한다.

1 1 + 3 × 100 + 3 1 + 3 × 60 = 70 (2.2.30) \dfrac{1}{1 + 3} \times 100 + \dfrac{3}{1 + 3} \times 60 = 70 \tag{2.2.30} 1 + 3 1 × 1 0 0 + 1 + 3 3 × 6 0 = 7 0 ( 2 . 2 . 3 0 ) 벡터로 표현된 N N N

x ˉ = 1 N ∑ i = 1 N x i = 1 N 1 N T x (2.2.31) \bar{x} = \dfrac{1}{N}\sum_{i=1}^N x_i = \dfrac{1}{N} \mathbf{1}_N^T x \tag{2.2.31} x ˉ = N 1 i = 1 ∑ N x i = N 1 1 N T x ( 2 . 2 . 3 1 ) 위 수식에서 보인 것처럼 x x x x ˉ \bar{x} x ˉ

다음은 넘파이로 평균을 계산하는 방법이다.

x = np. arange( 10 )

N = len ( x)

np. ones( N) @ x / N4.5

현실적으로는 mean()이라는 메서드를 사용하는 것이 편하다.

x. mean( ) 4.5

연습 문제 2.2.2

벡터 x x x

x − 1 N 1 N T x 1 N (2.2.32) x - \dfrac{1}{N}\mathbf{1}_N^Tx \mathbf{1}^{}_N \tag{2.2.32} x − N 1 1 N T x 1 N ( 2 . 2 . 3 2 ) 1 N T x \mathbf{1}_N^Tx 1 N T x x x x x x x x x x

이를 N N N x x x

element-wise하게 이 스칼라값을 벡터 x x x

주어진 식은 벡터 x x x 1 N \mathbf{1}^{}_N 1 N 1 N T x 1 N \mathbf{1}_N^Tx \mathbf{1}^{}_N 1 N T x 1 N x x x x x x

벡터 x x x m m m m m m 1 N T x 1 N \mathbf{1}_N^Tx \mathbf{1}^{}_N 1 N T x 1 N m m m

유사도

벡터의 곱셈(내적)은 두 벡터 간의 유사도를 계산하는 데도 이용할 수 있다. 유사도(similarity)는 두 벡터가 닮은 정도를 정량적으로 나타낸 값 으로 두 벡터가 비슷한 경우에는 유사도가 커지고 비슷하지 앟은 경우에는 유사도가 작아진다. 내적을 이용하면 코사인 유사도(cosine similarity) 라는 유사도를 계산할 수 있다. 추후 선형대수의 기하학적 의미를 공부할 때 코사인 유사도에 대해 살펴볼 것이다.

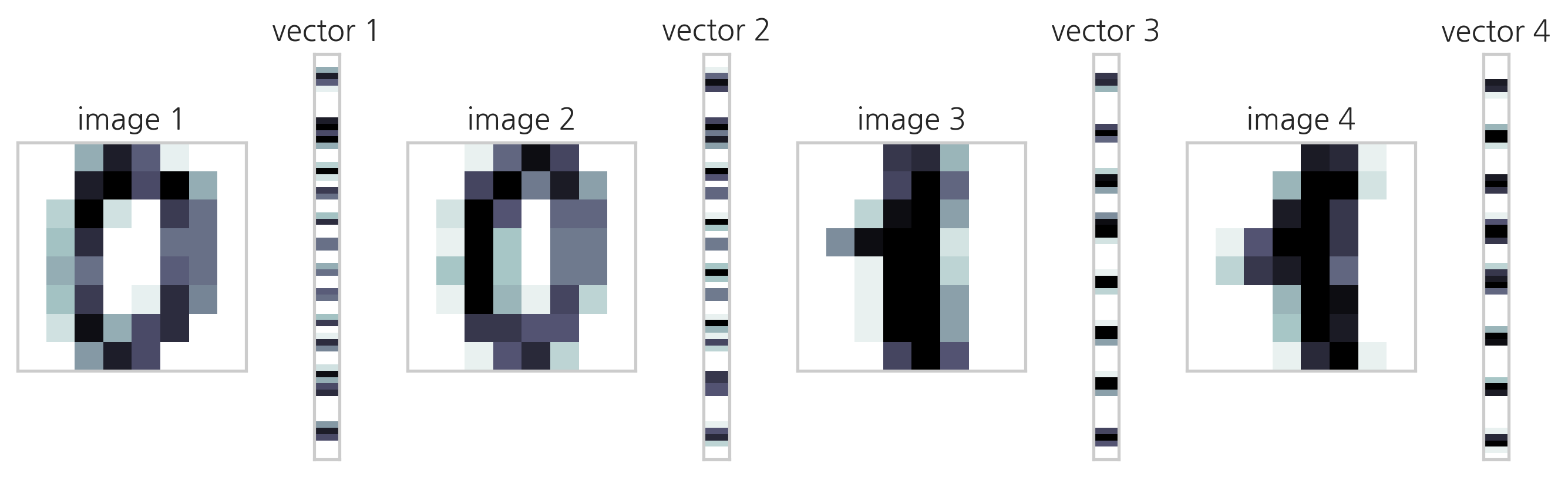

예를 들어 0과 1을 나타내는 MNIST 이미지에 대해 내적을 계산해보자.

from sklearn. datasets import load_digits

import matplotlib. gridspec as gridspec

digits = load_digits( )

d1 = digits. images[ 0 ]

d2 = digits. images[ 10 ]

d3 = digits. images[ 1 ]

d4 = digits. images[ 11 ]

v1 = d1. reshape( 64 , 1 )

v2 = d2. reshape( 64 , 1 )

v3 = d3. reshape( 64 , 1 )

v4 = d4. reshape( 64 , 1 )

plt. figure( figsize= ( 9 , 9 ) )

gs = gridspec. GridSpec( 1 , 8 , height_ratios= [ 1 ] ,

width_ratios= [ 9 , 1 , 9 , 1 , 9 , 1 , 9 , 1 ] )

for i in range ( 4 ) :

plt. subplot( gs[ 2 * i] )

plt. imshow( eval ( "d" + str ( i + 1 ) ) , aspect= 1 ,

interpolation= 'nearest' , cmap= plt. cm. bone_r)

plt. grid( False )

plt. xticks( [ ] )

plt. yticks( [ ] )

plt. title( "image {}" . format ( i + 1 ) )

plt. subplot( gs[ 2 * i + 1 ] )

plt. imshow( eval ( "v" + str ( i + 1 ) ) , aspect= 0.25 ,

interpolation= 'nearest' , cmap= plt. cm. bone_r)

plt. grid( False )

plt. xticks( [ ] )

plt. yticks( [ ] )

plt. title( "vector {}" . format ( i + 1 ) )

plt. tight_layout( )

plt. show( )

"0" 이미지와 "0" 이미지, 또는 "1" 이미지와 "1" 이미지의 내적값은 다음과 같다.

( v1. T @ v2) [ 0 ] [ 0 ] , ( v3. T @ v4) [ 0 ] [ 0 ] (3064.0, 3661.0)

상대적으로 "0" 이미지와 "1" 이미지, 또는 "1" 이미지와 "0" 이미지의 내적값은 작다.

( v1. T @ v3) [ 0 ] [ 0 ] , ( v1. T @ v4) [ 0 ] [ 0 ] , ( v2. T @ v3) [ 0 ] [ 0 ] , ( v2. T @ v4) [ 0 ] [ 0 ] (1866.0, 1883.0, 2421.0, 2479.0)

연습 문제 2.2.3

다음 코드를 실행하면 MNIST 숫자 이미지 전체 데이터를 모두 벡터로 변환하여 하나의 넘파이 행렬 X를 만든다.

이 행렬을 이용하여 다음 문제를 풀어라.

from sklearn.datasets import load_digits

X = load_digits().data

(1) 내적을 이용하여 첫 번째 이미지와 10번째 이미지의 유사도를 구하라.

(2) 내적을 이용하여 모든 이미지의 조합에 대해 유사도를 구하라. 어떻게 구현하는 것이 효율적일까? (힌트 : 이 문제는 뒤에서 배울 행렬과 행렬의 곱셈을 이용한다.)

import numpy as np

import matplotlib. pylab as plt

from sklearn. datasets import load_digits

import time

X = load_digits( ) . data

print ( type ( X) , X. shape )

print ( X[ 0 ] @ X[ 9 ] )

start = time. time( )

P = np. ones( ( 1797 , 1797 ) )

for i in range ( 1797 ) :

for j in range ( i+ 1 ) :

P[ i] [ j] = X[ i] @ X[ j]

if i != j:

P[ j] [ i] = P[ i] [ j]

print ( "for문으로 계산하는데 걸린 시간:" , f" { time. time( ) - start: .4f } sec" )

print ( P. shape, P[ 0 ] [ 9 ] )

start = time. time( )

Q = X @ X. T

print ( "행렬곱으로 계산하는데 걸린 시간:" , f" { time. time( ) - start: .4f } sec" )

print ( Q. shape, Q[ 0 ] [ 9 ] )

<class 'numpy.ndarray'>

(1797, 64)

2807.0

for문으로 계산하는데 걸린 시간: 4.6719 sec

(1797, 1797) 2807.0

행렬곱으로 계산하는데 걸린 시간: 0.0358 sec

(1797, 1797) 2807.0

선형회귀 모형

선형회귀 모형(linear regression model) 이란 독립변수 x x x y y y x x x w w w y {y} y y ^ \hat{y} y ^

y ^ = w 1 x 1 + ⋯ + w N x N (2.2.33) \hat{y} = w_1 x_1 + \cdots + w_N x_N \tag{2.2.33} y ^ = w 1 x 1 + ⋯ + w N x N ( 2 . 2 . 3 3 ) 이 수식에서 기호 ^는 "캐럿(caret)"이라는 기호이다. y ^ \hat{y} y ^

이 수식은 다음처럼 벡터의 내적으로 나타낼 수 있다.

y ^ = w T x (2.2.34) \hat{y} = w^Tx \tag{2.2.34} y ^ = w T x ( 2 . 2 . 3 4 ) 선형회귀 모형은 가장 단순하면서도 가장 널리 쓰이는 예측 모형이다.

예를 들어 어떤 아파트 단지의 아파트 가격을 조사하였더니 아파트 가격은 (1)면적, (2)층수, (3)한강이 보이는지의 여부, 즉 이 세 가지 특징에 의해 달라진다는 사실을 알게 되었다. 이때 이 단지 내의 아파트 가격을 예측하는 예측 모형을 다음과 같이 만들 수 있다.

면적(m 2 m^2 m 2 x 1 x_1 x 1

층수를 입력 데이터 x 2 x_2 x 2

한강이 보이는지의 여부를 입력 데이터 x 3 x_3 x 3 x 3 = 1 x_3 = 1 x 3 = 1 x 3 = 0 x_3 = 0 x 3 = 0

출력 데이터 y ^ \hat{y} y ^

위와 같이 입력 데이터와 출력 데이터를 정의하고 회귀분석을 한 결과, 아파트값이 다음과 같은 선형회귀 모형으로 나타난다고 가정하자. 이러한 모형을 실제로 찾는 방법은 나중에 회귀분석 파트에서 공부하게 된다.

y ^ = 500 x 1 + 200 x 2 + 1000 x 3 (2.2.35) \hat{y} = 500 x_1 + 200 x_2 + 1000 x_3 \tag{2.2.35} y ^ = 5 0 0 x 1 + 2 0 0 x 2 + 1 0 0 0 x 3 ( 2 . 2 . 3 5 ) 이 모형은 다음과 같이 해석할 수 있다.

면적이 1m 2 m^2 m 2

층수가 1층 높아질수록 가격은 200만 원이 증가한다.

한강이 보이는 집은 1,000만 원의 웃돈(프리미엄)이 존재한다.

위 식은 다음과 같이 벡터의 내적으로 고쳐 쓸 수 있다.

y ^ = [ 500 200 1000 ] [ x 1 x 2 x 3 ] = w T x (2.2.36) \hat{y} = \begin{bmatrix} 500 & 200 & 1000 \end{bmatrix} \begin{bmatrix} x_1 \\ x_2 \\ x_3 \end{bmatrix} = w^T x \tag{2.2.36} y ^ = [ 5 0 0 2 0 0 1 0 0 0 ] ⎣ ⎢ ⎡ x 1 x 2 x 3 ⎦ ⎥ ⎤ = w T x ( 2 . 2 . 3 6 ) 즉, 위 선형회귀 모형은 다음 가중치 벡터로 대표된다.

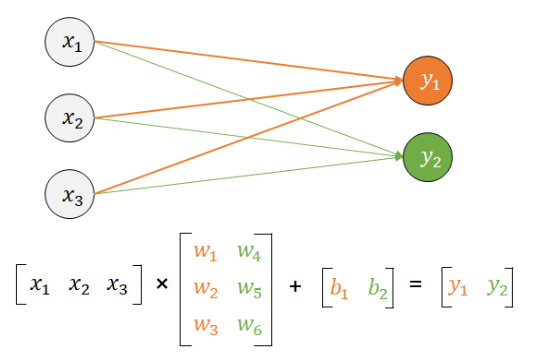

w T = [ 500 200 1000 ] (2.2.37) w^T = \begin{bmatrix} 500 & 200 & 1000 \end{bmatrix} \tag{2.2.37} w T = [ 5 0 0 2 0 0 1 0 0 0 ] ( 2 . 2 . 3 7 ) 인공신경망(artificial neural network)에서는 선형회귀 모형을 다음과 같은 그림으로 표현한다. 데이터는 노드(node) 혹은 뉴런(neuron)이라는 동그라미로 표시하고 곱셈은 선분(line)위에 곱할 숫자를 써서 나타낸다. 덧셈은 여러 개의 선분이 만나는 것으로 표시한다.

선형회귀 모형의 단점

선형회귀 모형은 비선형적인 현실 세계의 데이터를 잘 예측하지 못할 수 있다는 단점이 있다. 예를 들어 집값은 면적에 단순 비례하지 않는다. 소형 면적의 집과 대형 면적의 집은 단위 면적당 집값의 증가율이 다를 수 있다. 또한 저층이 보통 고층보다 집값이 싸지만 층수가 올라갈수록 정확히 층수에 비례하여 가격이 증가하지도 않는다.

이러한 현실 세계의 데이터와 선형회귀 모형의 괴리를 줄이기 위해 선형회귀 모형이 아닌 완전히 다른 모형을 쓰기보다는 선형회귀 모형을 기반으로 여러 기법을 사용해 수정한 모형을 사용하는 것이 일반적이다. 이러한 수정 선형회귀 모형에 대해서는 나중에 공부하게 된다.

제곱합

데이터의 분산(variance)이나 표준 편차(standard deviation) 등을 구하는 경우에는 각각의 데이터를 제곱한 뒤 이 값을 모두 더한 제곱합(sum of squares) 을 계산해야 한다. 이 경우에도 벡터의 내적을 사용하여 x T x x^Tx x T x

x T x = [ x 1 x 2 ⋯ x N ] [ x 1 x 2 ⋮ x N ] = ∑ i = 1 N x i 2 (2.2.38) x^T x = \begin{bmatrix} x_{1} & x_{2} & \cdots & x_{N} \end{bmatrix} \begin{bmatrix} x_{1} \\ x_{2} \\ \vdots \\ x_{N} \\ \end{bmatrix} = \sum_{i=1}^{N} x_i^2 \tag{2.2.38} x T x = [ x 1 x 2 ⋯ x N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 x 2 ⋮ x N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = i = 1 ∑ N x i 2 ( 2 . 2 . 3 8 ) 행렬과 행렬의 곱셈

벡터의 곱셈을 정의한 후에는 이를 이용하여 행렬의 곱셈을 정의할 수 있다. 행렬과 행렬을 곱하면 행렬이 된다. 방법은 다음과 같다.

A A A B B B C C C

C C C i i i j j j c i j c_{ij} c i j A A A i i i a i T a_i^T a i T B B B j j j b j b_j b j

C = A B → c i j = a i T b j (2.2.39) C = AB \; \rightarrow \; c_{ij} = a_i^T b_j \tag{2.2.39} C = A B → c i j = a i T b j ( 2 . 2 . 3 9 ) 이 정의가 성립하려면 앞의 행렬 A A A B B B

A ∈ R N × L , B ∈ R L × M → A B ∈ R N × M (2.2.40) A \in \mathbf{R}^{N \times L} , \; B \in \mathbf{R}^{L \times M} \; \rightarrow \; AB \in \mathbf{R}^{N \times M} \tag{2.2.40} A ∈ R N × L , B ∈ R L × M → A B ∈ R N × M ( 2 . 2 . 4 0 ) 다음은 4 × 3 4 \times 3 4 × 3 3 × 2 3 \times 2 3 × 2 4 × 2 4 \times 2 4 × 2

[ a 11 a 12 a 13 a 21 a 22 a 23 a 31 a 32 a 33 a 41 a 42 a 43 ] [ b 11 b 12 b 21 b 22 b 31 b 32 ] = [ ( a 11 b 11 + a 12 b 21 + a 13 b 31 ) ( a 11 b 12 + a 12 b 22 + a 13 b 32 ) ( a 21 b 11 + a 22 b 21 + a 23 b 31 ) ( a 21 b 12 + a 22 b 22 + a 23 b 32 ) ( a 31 b 11 + a 32 b 21 + a 33 b 31 ) ( a 31 b 12 + a 32 b 22 + a 33 b 32 ) ( a 41 b 11 + a 42 b 21 + a 43 b 31 ) ( a 41 b 12 + a 42 b 22 + a 43 b 32 ) ] (2.2.41) \begin{bmatrix} a_{11} & a_{12} & a_{13} \\ a_{21} & a_{22} & a_{23} \\ a_{31} & a_{32} & a_{33} \\ a_{41} & a_{42} & a_{43} \\ \end{bmatrix} \begin{bmatrix} {b_{11}} & b_{12} \\ {b_{21}} & b_{22} \\ {b_{31}} & b_{32} \\ \end{bmatrix} = \begin{bmatrix} (a_{11}b_{11} + a_{12}b_{21} + a_{13}b_{31}) & (a_{11}b_{12} + a_{12}b_{22} + a_{13}b_{32}) \\ (a_{21}b_{11} + a_{22}b_{21} + a_{23}b_{31}) & (a_{21}b_{12} + a_{22}b_{22} + a_{23}b_{32}) \\ (a_{31}b_{11} + a_{32}b_{21} + a_{33}b_{31}) & (a_{31}b_{12} + a_{32}b_{22} + a_{33}b_{32}) \\ (a_{41}b_{11} + a_{42}b_{21} + a_{43}b_{31}) & (a_{41}b_{12} + a_{42}b_{22} + a_{43}b_{32}) \\ \end{bmatrix} \tag{2.2.41} ⎣ ⎢ ⎢ ⎢ ⎡ a 1 1 a 2 1 a 3 1 a 4 1 a 1 2 a 2 2 a 3 2 a 4 2 a 1 3 a 2 3 a 3 3 a 4 3 ⎦ ⎥ ⎥ ⎥ ⎤ ⎣ ⎢ ⎡ b 1 1 b 2 1 b 3 1 b 1 2 b 2 2 b 3 2 ⎦ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎢ ⎡ ( a 1 1 b 1 1 + a 1 2 b 2 1 + a 1 3 b 3 1 ) ( a 2 1 b 1 1 + a 2 2 b 2 1 + a 2 3 b 3 1 ) ( a 3 1 b 1 1 + a 3 2 b 2 1 + a 3 3 b 3 1 ) ( a 4 1 b 1 1 + a 4 2 b 2 1 + a 4 3 b 3 1 ) ( a 1 1 b 1 2 + a 1 2 b 2 2 + a 1 3 b 3 2 ) ( a 2 1 b 1 2 + a 2 2 b 2 2 + a 2 3 b 3 2 ) ( a 3 1 b 1 2 + a 3 2 b 2 2 + a 3 3 b 3 2 ) ( a 4 1 b 1 2 + a 4 2 b 2 2 + a 4 3 b 3 2 ) ⎦ ⎥ ⎥ ⎥ ⎤ ( 2 . 2 . 4 1 ) 다음은 실제 행렬을 사용한 곱셈의 예다.

A = [ 1 2 3 4 5 6 ] (2.2.42) A = \begin{bmatrix} 1 & 2 & 3 \\ 4 & 5 & 6 \end{bmatrix} \tag{2.2.42} A = [ 1 4 2 5 3 6 ] ( 2 . 2 . 4 2 ) B = [ 1 2 3 4 5 6 ] (2.2.43) B = \begin{bmatrix} 1 & 2 \\ 3 & 4 \\ 5 & 6 \end{bmatrix} \tag{2.2.43} B = ⎣ ⎢ ⎡ 1 3 5 2 4 6 ⎦ ⎥ ⎤ ( 2 . 2 . 4 3 ) C = A B = [ 22 28 49 64 ] (2.2.44) C = AB = \begin{bmatrix} 22 & 28 \\ 49 & 64 \end{bmatrix} \tag{2.2.44} C = A B = [ 2 2 4 9 2 8 6 4 ] ( 2 . 2 . 4 4 ) 넘파이를 이용하여 행렬의 곱을 구할 때도 @ 연산자 또는 dot() 명령을 사용한다.

A = np. array( [ [ 1 , 2 , 3 ] , [ 4 , 5 , 6 ] ] )

B = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] , [ 5 , 6 ] ] )

C = A @ B

Carray([[22, 28],

[49, 64]])

연습 문제 2.2.4

(1) A A A B B B A B AB A B

(2) 순서를 바꾸어 B A BA B A B A BA B A A B AB A B

(3) A A A B B B A B AB A B B A BA B A A B AB A B B A BA B A

A = [ 1 2 3 ] (2.2.45) A = \begin{bmatrix} 1 & 2 & 3 \end{bmatrix} \tag{2.2.45} A = [ 1 2 3 ] ( 2 . 2 . 4 5 ) B = [ 4 7 5 8 6 9 ] (2.2.46) B = \begin{bmatrix} 4 & 7 \\ 5 & 8 \\ 6 & 9 \end{bmatrix} \tag{2.2.46} B = ⎣ ⎢ ⎡ 4 5 6 7 8 9 ⎦ ⎥ ⎤ ( 2 . 2 . 4 6 ) (4) A A A B B B A B AB A B B A BA B A A B AB A B B A BA B A B A BA B A A B AB A B

A = [ 1 2 3 4 ] (2.2.47) A = \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} \tag{2.2.47} A = [ 1 3 2 4 ] ( 2 . 2 . 4 7 ) B = [ 5 6 7 8 ] (2.2.48) B = \begin{bmatrix} 5 & 6 \\ 7 & 8 \end{bmatrix} \tag{2.2.48} B = [ 5 7 6 8 ] ( 2 . 2 . 4 8 ) (5) A A A A A T AA^T A A T A T A A^TA A T A A A T AA^T A A T A T A A^TA A T A

A = [ 1 2 3 4 5 6 ] (2.2.49) A = \begin{bmatrix} 1 & 2 \\ 3 & 4 \\ 5 & 6 \end{bmatrix} \tag{2.2.49} A = ⎣ ⎢ ⎡ 1 3 5 2 4 6 ⎦ ⎥ ⎤ ( 2 . 2 . 4 9 ) (6) x x x x T x x^Tx x T x x x T xx^T x x T x T x x^Tx x T x x x T xx^T x x T

x = [ 1 2 3 ] (2.2.50) x = \begin{bmatrix} 1 \\ 2 \\ 3 \end{bmatrix} \tag{2.2.50} x = ⎣ ⎢ ⎡ 1 2 3 ⎦ ⎥ ⎤ ( 2 . 2 . 5 0 ) import numpy as np

A = np. array( [ [ 1 , 2 , 3 ] , [ 4 , 5 , 6 ] ] )

B = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] , [ 5 , 6 ] ] )

print ( "(1)" , A @ B)

print ( "(2)" , B @ A)

A = np. array( [ 1 , 2 , 3 ] )

B = np. array( [ [ 4 , 7 ] , [ 5 , 8 ] , [ 6 , 9 ] ] )

print ( "(3)" , A @ B)

A = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] ] )

B = np. array( [ [ 5 , 6 ] , [ 7 , 8 ] ] )

print ( "(4)" , A @ B, B @ A )

A = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] , [ 5 , 6 ] ] )

print ( "(5)" , A @ A. T, A. T @ A )

x = np. array( [ 1 , 2 , 3 ] ) . reshape( 3 , 1 )

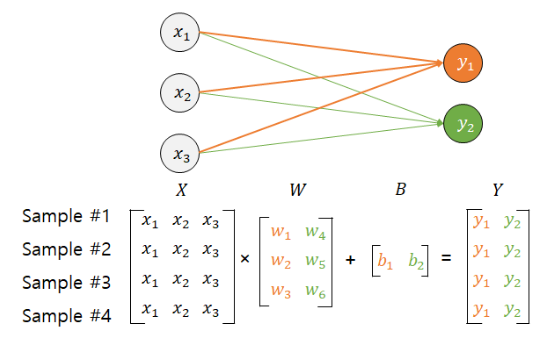

print ( "(6)" , x. T@x, x@x. T) 인공 신경망은 내부적으로 다음과 같이 여러 개의 선형회귀 모형을 사용한다. 이 구조는 행렬과 벡터의 곱으로 나타낼 수 있다.

위 그림을 행렬식으로 표현하면 다음과 같다.

[ y ^ 1 y ^ 2 ] = [ w 11 w 12 w 13 w 21 w 22 w 23 ] [ x 1 x 2 x 3 ] (2.2.51) \begin{bmatrix} \hat{y}_{1} \\ \hat{y}_{2} \\ \end{bmatrix} = \begin{bmatrix} w_{11} & w_{12} & w_{13} \\ w_{21} & w_{22} & w_{23} \\ \end{bmatrix} \begin{bmatrix} x_{1} \\ x_{2} \\ x_{3} \\ \end{bmatrix} \tag{2.2.51} [ y ^ 1 y ^ 2 ] = [ w 1 1 w 2 1 w 1 2 w 2 2 w 1 3 w 2 3 ] ⎣ ⎢ ⎡ x 1 x 2 x 3 ⎦ ⎥ ⎤ ( 2 . 2 . 5 1 ) y ^ = W x (2.2.52) \hat{y} = Wx \tag{2.2.52} y ^ = W x ( 2 . 2 . 5 2 ) 그림에서 벡터 x x x

참조: 행렬곱으로 병렬 연산 이해하기

교환 법칙과 분배 법칙

행렬의 곱셈은 곱하는 행렬의 순서를 바꾸는 교환 법칙이 성립하지 않는다. 그러나 덧셈에 대한 분배 법칙은 성립한다.

A B ≠ B A (2.2.53) AB \neq BA \tag{2.2.53} A B = B A ( 2 . 2 . 5 3 ) A ( B + C ) = A B + A C (2.2.54) A(B + C) = AB + AC \tag{2.2.54} A ( B + C ) = A B + A C ( 2 . 2 . 5 4 ) ( A + B ) C = A C + B C (2.2.55) (A + B)C = AC + BC \tag{2.2.55} ( A + B ) C = A C + B C ( 2 . 2 . 5 5 ) A A A B B B C C C

A = [ 1 2 3 4 ] (2.2.56) A = \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} \tag{2.2.56} A = [ 1 3 2 4 ] ( 2 . 2 . 5 6 ) B = [ 5 6 7 8 ] (2.2.57) B = \begin{bmatrix} 5 & 6 \\ 7 & 8 \end{bmatrix} \tag{2.2.57} B = [ 5 7 6 8 ] ( 2 . 2 . 5 7 ) C = [ 9 8 7 6 ] (2.2.58) C = \begin{bmatrix} 9 & 8 \\ 7 & 6 \end{bmatrix} \tag{2.2.58} C = [ 9 7 8 6 ] ( 2 . 2 . 5 8 ) A = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] ] )

B = np. array( [ [ 5 , 6 ] , [ 7 , 8 ] ] )

C = np. array( [ [ 9 , 8 ] , [ 7 , 6 ] ] ) A B AB A B B A BA B A

A @ Barray([[19, 22],

[43, 50]])

B @ Aarray([[23, 34],

[31, 46]])

분배법칙은 다음과 같이 성립한다.

A @ ( B + C) array([[42, 42],

[98, 98]])

A @ B + A @ Carray([[42, 42],

[98, 98]])

( A + B) @ Carray([[110, 96],

[174, 152]])

A @ C + B @ Carray([[110, 96],

[174, 152]])

전치 연산도 마찬가지로 덧셈/뺄셈에 대해 분배 법칙이 성립한다.

( A + B ) T = A T + B T (2.2.59) (A + B)^T = A^T + B^T \tag{2.2.59} ( A + B ) T = A T + B T ( 2 . 2 . 5 9 ) 전치 연산과 곱셈의 경우에는 분배 법칙이 성립하기는 하지만 전치 연산이 분배되면서 곱셈의 순서가 바뀐다.

( A B ) T = B T A T (2.2.60) (AB)^T = B^T A^T \tag{2.2.60} ( A B ) T = B T A T ( 2 . 2 . 6 0 ) ( A B C ) T = C T B T A T (2.2.61) (ABC)^T = C^T B^T A^T \tag{2.2.61} ( A B C ) T = C T B T A T ( 2 . 2 . 6 1 ) 마찬가지로 넘파이로 위 법칙이 성립하는지 살펴보자.

( A + B) . Tarray([[ 6, 10],

[ 8, 12]])

A. T + B. Tarray([[ 6, 10],

[ 8, 12]])

( A @ B) . Tarray([[19, 43],

[22, 50]])

B. T @ A. Tarray([[19, 43],

[22, 50]])

연습 문제 2.2.5

(1) 길이가 같은 일벡터 1 N ∈ R N 1_N \in \mathbf{R}^N 1 N ∈ R N x ∈ R N x \in \mathbf{R}^N x ∈ R N x x x

1 N x T = [ x T x T ⋮ x T ] (2.2.62) \mathbf{1}_N^{} x^T = \begin{bmatrix} {x}^T \\ {x}^T \\ \vdots \\ {x}^T \\ \end{bmatrix} \tag{2.2.62} 1 N x T = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x T x T ⋮ x T ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ( 2 . 2 . 6 2 ) ✒️

[ 1 1 ⋮ 1 ] [ x 1 x 2 … x N ] \begin{bmatrix} 1 \\ 1 \\ \vdots \\ 1 \\ \end{bmatrix} \begin{bmatrix} x_1 & x_2 & \dots & x_N\end{bmatrix} ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ 1 1 ⋮ 1 ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ [ x 1 x 2 … x N ] 이고 행렬의 사이즈는 N x 1 과 1 x N 의 행렬곱이므로 N x N 행렬이 됨을 알 수 있다. 각 element 별로 살펴보면 행렬곱의 결과가 (2.2.62) 와 같이 됨을 알 수 있다.

(2) 행렬 X ( X ∈ R N × M ) X \,( X \in \mathbf{R}^{N \times M}) X ( X ∈ R N × M ) x ˉ ( x ˉ ∈ R M ) \bar{x}\,( \bar{x} \in \mathbf{R}^{M}) x ˉ ( x ˉ ∈ R M )

x ˉ = 1 N X T 1 N (2.2.63) \bar{x} = \dfrac{1} {N} X^T \mathbf{1}_N \tag{2.2.63} x ˉ = N 1 X T 1 N ( 2 . 2 . 6 3 ) ✒️X X X X T 1 N X^T\mathbf{1}_N X T 1 N N N N N N N

(3) 행렬 X ˉ ( X ˉ ∈ R N × M ) \bar{X}\ ( \bar{X} \in \mathbf{R}^{N \times M}) X ˉ ( X ˉ ∈ R N × M ) x ˉ T \bar{x}^T x ˉ T N N N

X ˉ = [ x ˉ T x ˉ T ⋮ x ˉ T ] (2.2.64) \bar{X} = \begin{bmatrix} \bar{x}^T \\ \bar{x}^T \\ \vdots\\ \bar{x}^T \\ \end{bmatrix} \tag{2.2.64} X ˉ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x ˉ T x ˉ T ⋮ x ˉ T ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ( 2 . 2 . 6 4 ) 이때 X ˉ \bar{X} X ˉ

X ˉ = 1 N 1 N 1 N T X (2.2.65) \bar{X} = \dfrac{1}{N} \mathbf{1}_N^{} \mathbf{1}_N^T X \tag{2.2.65} X ˉ = N 1 1 N 1 N T X ( 2 . 2 . 6 5 ) ✒️1 N x ˉ T = 1 N 1 N ( X T 1 N ) T \mathbf{1}_N^{} \bar{x}^T=\dfrac{1}{N}\mathbf{1}_N (X^T \mathbf{1}_N)^T 1 N x ˉ T = N 1 1 N ( X T 1 N ) T

(4) 다음 코드를 실행하면 붓꽃 전체 데이터를 모두 벡터로 변환하여 하나의 넘파이 행렬 X 를 만든다.

from sklearn.datasets import load_iris

X = load_iris().data

이 데이터로 행렬 X ˉ \bar{X} X ˉ

✒️

import numpy as np

from sklearn. datasets import load_iris

X = load_iris( ) . data

N = 150

Y = ( np. ones( ( N, 1 ) ) @ np. ones( ( N, 1 ) ) . T @ X ) / N

print ( Y) 곱셈의 연결

연속된 행렬의 곱셈은 계산 순서를 임의의 순서로 해도 상관없다.

A B C = ( A B ) C = A ( B C ) (2.2.66) ABC = (AB)C = A(BC) \tag{2.2.66} A B C = ( A B ) C = A ( B C ) ( 2 . 2 . 6 6 ) A B C D = ( ( A B ) C ) D = ( A B ) ( C D ) = A ( B C D ) = A ( B C ) D (2.2.67) ABCD = ((AB)C)D = (AB)(CD) = A(BCD) = A(BC)D \tag{2.2.67} A B C D = ( ( A B ) C ) D = ( A B ) ( C D ) = A ( B C D ) = A ( B C ) D ( 2 . 2 . 6 7 ) 연습 문제 2.2.6

다음 행렬의 곱셈을 순서를 바꾸어 두 가지 방법으로 해본다.

[ 1 2 ] [ 1 2 3 4 ] [ 5 6 ] (2.2.68) \begin{bmatrix} 1 & 2 \end{bmatrix} \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} \begin{bmatrix} 5 \\ 6 \end{bmatrix} \tag{2.2.68} [ 1 2 ] [ 1 3 2 4 ] [ 5 6 ] ( 2 . 2 . 6 8 ) ✒️

[ 1 2 ] [ 1 2 3 4 ] [ 5 6 ] = [ 7 10 ] [ 5 6 ] = 95 \begin{bmatrix} 1 & 2 \end{bmatrix} \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} \begin{bmatrix} 5 \\ 6 \end{bmatrix} = \begin{bmatrix} 7 & 10 \end{bmatrix} \begin{bmatrix} 5 \\ 6 \end{bmatrix} = 95 [ 1 2 ] [ 1 3 2 4 ] [ 5 6 ] = [ 7 1 0 ] [ 5 6 ] = 9 5 [ 1 2 ] [ 1 2 3 4 ] [ 5 6 ] = [ 1 2 ] [ 17 39 ] = 17 + 78 = 95 \begin{bmatrix} 1 & 2 \end{bmatrix} \begin{bmatrix} 1 & 2 \\ 3 & 4 \end{bmatrix} \begin{bmatrix} 5 \\ 6 \end{bmatrix} = \begin{bmatrix} 1 & 2 \end{bmatrix} \begin{bmatrix} 17 \\ 39 \end{bmatrix} = 17 + 78 = 95 [ 1 2 ] [ 1 3 2 4 ] [ 5 6 ] = [ 1 2 ] [ 1 7 3 9 ] = 1 7 + 7 8 = 9 5 항등행렬의 곱셈

어떤 행렬이든 항등행렬을 곱하면 그 행렬의 값이 변하지 않는다.

A I = I A = A (2.2.69) AI = IA = A \tag{2.2.69} A I = I A = A ( 2 . 2 . 6 9 ) 넘파이로 다음과 같이 확인한다.

A = np. array( [ [ 1 , 2 ] , [ 3 , 4 ] ] )

I = np. eye( 2 ) A @ Iarray([[1., 2.],

[3., 4.]])

I @ Aarray([[1., 2.],

[3., 4.]])

행렬과 벡터의 곱

그럼 이러한 행렬의 곱셈은 데이터 분석에서 어떤 경우에 사용될까? 행렬의 곱셈 중 가장 널리 쓰이는 것은 다음과 같은 형태의 행렬 M M M v v v

M v (2.2.70) Mv \tag{2.2.70} M v ( 2 . 2 . 7 0 ) 벡터와 행렬의 크기를 직사각형으로 표시하면 다음과 같다.

M \mathstrut v \mathstrut = M v (2.2.71) \boxed{\begin{matrix} \phantom{} & \phantom{} & \phantom{} & \phantom{} & \phantom{} \\ & & M & &\\ \phantom{} & \phantom{} & \phantom{} & \phantom{} & \phantom{} \\ \end{matrix}} \, \boxed{\begin{matrix} \phantom{\LARGE\mathstrut} \\ v \\ \phantom{\LARGE\mathstrut} \end{matrix}} = \boxed{\begin{matrix} \phantom{} \\ Mv \\ \phantom{} \end{matrix}} \tag{2.2.71} M \mathstrut v \mathstrut = M v ( 2 . 2 . 7 1 ) 행렬과 벡터의 곱을 사용하는 몇가지 예를 살펴보자.

열 벡터의 선형조합

행렬 X X X w w w X X X c 1 , c 2 , … , c M c_1, c_2, \ldots, c_M c 1 , c 2 , … , c M w w w w 1 , w 2 , … , w M w_1, w_2, \ldots, w_M w 1 , w 2 , … , w M

X w = [ c 1 c 2 ⋯ c M ] [ w 1 w 2 ⋮ w M ] = w 1 c 1 + w 2 c 2 + ⋯ + w M c M (2.2.72) Xw= \begin{bmatrix} c_1 & c_2 & \cdots & c_M \end{bmatrix} \begin{bmatrix} w_1 \\ w_2 \\ \vdots \\ w_M \end{bmatrix} = w_1 c_1 + w_2 c_2 + \cdots + w_M c_M \tag{2.2.72} X w = [ c 1 c 2 ⋯ c M ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ w 1 w 2 ⋮ w M ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = w 1 c 1 + w 2 c 2 + ⋯ + w M c M ( 2 . 2 . 7 2 ) 연습 문제 2.2.7

다음 행렬 X X X w w w X w Xw X w c 1 , c 2 , c 3 c_1, c_2, c_3 c 1 , c 2 , c 3 w 1 c 1 + w 2 c 2 + w 3 c 3 w_1c_1 + w_2c_2 + w_3c_3 w 1 c 1 + w 2 c 2 + w 3 c 3

X = [ 1 2 3 4 5 6 ] , w = [ 2 3 4 ] (2.2.74) X = \begin{bmatrix} 1 & 2 & 3 \\ 4 & 5 & 6 \end{bmatrix}, \;\; w = \begin{bmatrix} 2 \\ 3 \\ 4 \end{bmatrix} \tag{2.2.74} X = [ 1 4 2 5 3 6 ] , w = ⎣ ⎢ ⎡ 2 3 4 ⎦ ⎥ ⎤ ( 2 . 2 . 7 4 ) ✒️

import numpy as np

x = np. array( [ 1 , 2 , 3 , 4 , 5 , 6 ] ) . reshape( 2 , 3 )

w = np. array( [ 2 , 3 , 4 ] ) . reshape( 3 , 1 )

xw = ( x@w) . reshape( 2 , 1 )

lc = ( x[ : , 0 ] * w[ 0 ] + x[ : , 1 ] * w[ 1 ] + x[ : , 2 ] * w[ 2 ] ) . reshape( 2 , 1 )

print ( x@w)

print ( lc) 연습 문제 2.2.8

벡터 v 1 , v 2 , v 3 v_1, v_2, v_3 v 1 , v 2 , v 3 V V V λ \lambda λ λ 1 \lambda_1 λ 1

V λ = [ v 1 v 2 v 3 ] [ λ 1 0 0 ] = λ 1 v 1 (2.2.75) V\lambda = \begin{bmatrix} v_1 & v_2 & v_3 \end{bmatrix} \begin{bmatrix} \lambda_{1} \\ 0 \\ 0 \end{bmatrix} = \lambda_1 v_1 \tag{2.2.75} V λ = [ v 1 v 2 v 3 ] ⎣ ⎢ ⎡ λ 1 0 0 ⎦ ⎥ ⎤ = λ 1 v 1 ( 2 . 2 . 7 5 ) ✒️v 2 v2 v 2 v 3 v3 v 3

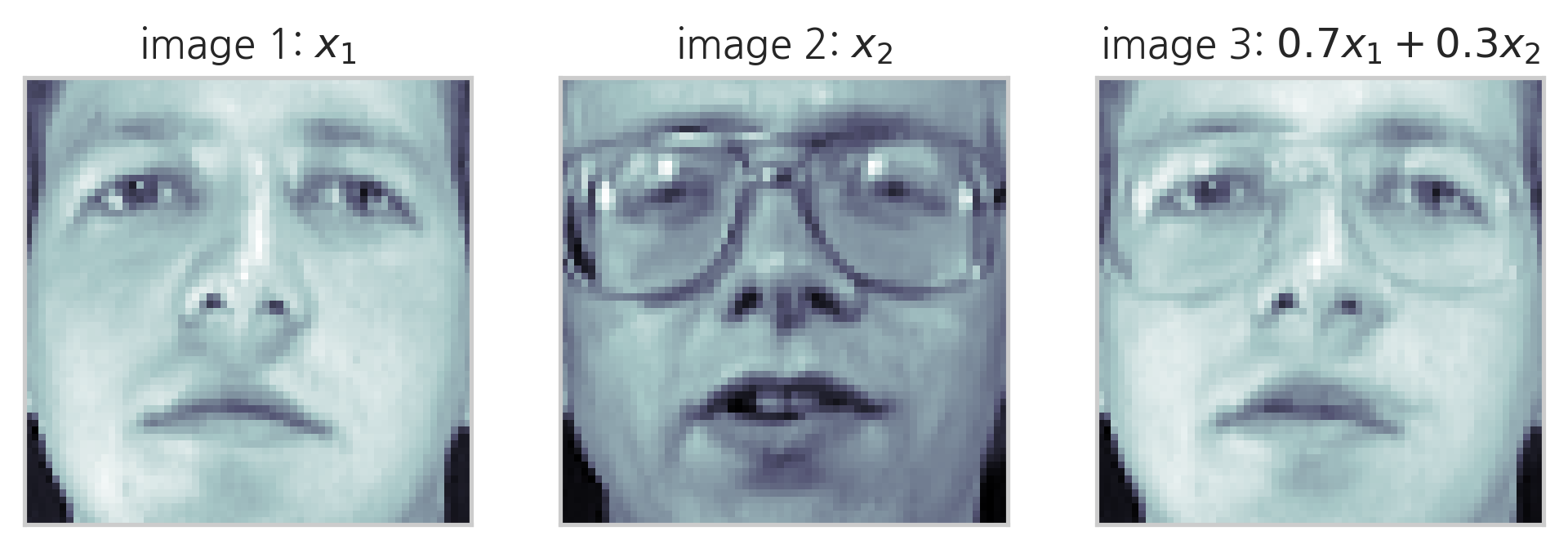

벡터의 선형조합은 다양한 분야에 응용된다. 예를 들어 두 이미지 벡터의 선형조합은 두 이미지를 섞어놓은 모핑(morphing) 효과를 얻는 데 사용할 수 있다.

모핑(morphing)이란?

VIDEO

from sklearn. datasets import fetch_olivetti_faces

faces = fetch_olivetti_faces( )

f, ax = plt. subplots( 1 , 3 )

ax[ 0 ] . imshow( faces. images[ 6 ] , cmap= plt. cm. bone)

ax[ 0 ] . grid( False )

ax[ 0 ] . set_xticks( [ ] )

ax[ 0 ] . set_yticks( [ ] )

ax[ 0 ] . set_title( "image 1: $x_1$" )

ax[ 1 ] . imshow( faces. images[ 10 ] , cmap= plt. cm. bone)

ax[ 1 ] . grid( False )

ax[ 1 ] . set_xticks( [ ] )

ax[ 1 ] . set_yticks( [ ] )

ax[ 1 ] . set_title( "image 2: $x_2$" )

new_face = 0.7 * faces. images[ 6 ] + 0.3 * faces. images[ 10 ]

ax[ 2 ] . imshow( new_face, cmap= plt. cm. bone)

ax[ 2 ] . grid( False )

ax[ 2 ] . set_xticks( [ ] )

ax[ 2 ] . set_yticks( [ ] )

ax[ 2 ] . set_title( "image 3: $0.7x_1 + 0.3x_2$" )

plt. show( )

여러 개의 벡터에 대한 가중합 동시 계산

벡터 하나의 가중합은 w T x w^Tx w T x x T w x^Tw x T w w w w x x x x 1 , ⋯ , x M x_1, \cdots, x_M x 1 , ⋯ , x M x 1 , x 2 , x 3 , ⋯ , x N x_1, x_2, x_3, \cdots, x_N x 1 , x 2 , x 3 , ⋯ , x N y 1 , y 2 , y 3 , ⋯ , y N y_1, y_2, y_3, \cdots, y_N y 1 , y 2 , y 3 , ⋯ , y N X X X y ^ = X w \hat{y} = Xw y ^ = X w

y ^ = [ y ^ 1 y ^ 2 ⋮ y ^ M ] = [ w 1 x 1 , 1 + w 2 x 1 , 2 + ⋯ + w N x 1 , N w 1 x 2 , 1 + w 2 x 2 , 2 + ⋯ + w N x 2 , N ⋮ w 1 x M , 1 + w 2 x M , 2 + ⋯ + w N x M , N ] = [ x 1 , 1 x 1 , 2 ⋯ x 1 , N x 2 , 1 x 2 , 2 ⋯ x 2 , N ⋮ ⋮ ⋮ ⋮ x M , 1 x M , 2 ⋯ x M , N ] [ w 1 w 2 ⋮ w N ] = [ x 1 T x 2 T ⋮ x M T ] [ w 1 w 2 ⋮ w N ] = X w (2.2.76) \begin{aligned} \hat{y} = \begin{bmatrix} \hat{y}_1 \\ \hat{y}_2 \\ \vdots \\ \hat{y}_M \\ \end{bmatrix} &= \begin{bmatrix} w_1 x_{1,1} + w_2 x_{1,2} + \cdots + w_N x_{1,N} \\ w_1 x_{2,1} + w_2 x_{2,2} + \cdots + w_N x_{2,N} \\ \vdots \\ w_1 x_{M,1} + w_2 x_{M,2} + \cdots + w_N x_{M,N} \\ \end{bmatrix} \\ &= \begin{bmatrix} x_{1,1} & x_{1,2} & \cdots & x_{1,N} \\ x_{2,1} & x_{2,2} & \cdots & x_{2,N} \\ \vdots & \vdots & \vdots & \vdots \\ x_{M,1} & x_{M,2} & \cdots & x_{M,N} \\ \end{bmatrix} \begin{bmatrix} w_1 \\ w_2 \\ \vdots \\ w_N \end{bmatrix} \\ &= \begin{bmatrix} x_1^T \\ x_2^T \\ \vdots \\ x_M^T \\ \end{bmatrix} \begin{bmatrix} w_1 \\ w_2 \\ \vdots \\ w_N \end{bmatrix} \\ &= X w \end{aligned} \tag{2.2.76} y ^ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ y ^ 1 y ^ 2 ⋮ y ^ M ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ w 1 x 1 , 1 + w 2 x 1 , 2 + ⋯ + w N x 1 , N w 1 x 2 , 1 + w 2 x 2 , 2 + ⋯ + w N x 2 , N ⋮ w 1 x M , 1 + w 2 x M , 2 + ⋯ + w N x M , N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 , 1 x 2 , 1 ⋮ x M , 1 x 1 , 2 x 2 , 2 ⋮ x M , 2 ⋯ ⋯ ⋮ ⋯ x 1 , N x 2 , N ⋮ x M , N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ w 1 w 2 ⋮ w N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 T x 2 T ⋮ x M T ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ w 1 w 2 ⋮ w N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = X w ( 2 . 2 . 7 6 ) 즉.

y ^ = X w (2.2.77) \hat{y} = Xw \tag{2.2.77} y ^ = X w ( 2 . 2 . 7 7 ) 연습 문제 2.2.9

x 1 x_1 x 1 x 2 x_2 x 2

x 1 = [ x 11 x 21 x 31 ] x 2 = [ x 12 x 22 x 32 ] (2.2.78) x_1 = \begin{bmatrix} x_{11} \\ x_{21} \\ x_{31} \\ \end{bmatrix} \;\; x_2 = \begin{bmatrix} x_{12} \\ x_{22} \\ x_{32} \\ \end{bmatrix} \tag{2.2.78} x 1 = ⎣ ⎢ ⎡ x 1 1 x 2 1 x 3 1 ⎦ ⎥ ⎤ x 2 = ⎣ ⎢ ⎡ x 1 2 x 2 2 x 3 2 ⎦ ⎥ ⎤ ( 2 . 2 . 7 8 ) 다음 등식이 성립함을 보인다.

X w = [ x 1 T x 2 T ] [ w 1 w 2 w 3 ] = [ x 1 T w x 2 T w ] (2.2.79) Xw = \begin{bmatrix} x_1^T \\ x_2^T \\ \end{bmatrix} \begin{bmatrix} w_1 \\ w_2 \\ w_3 \end{bmatrix} = \begin{bmatrix} x_1^Tw \\ x_2^Tw \\ \end{bmatrix} \tag{2.2.79} X w = [ x 1 T x 2 T ] ⎣ ⎢ ⎡ w 1 w 2 w 3 ⎦ ⎥ ⎤ = [ x 1 T w x 2 T w ] ( 2 . 2 . 7 9 ) ✒️

import numpy as np

x1 = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

x2 = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

w = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

X = np. array( [ x1, x2] ) . reshape( 2 , 3 )

print ( X @ w == np. array( [ x1. T @ w, x2. T @ w] ) . reshape( 2 , 1 ) ) 잔차

선형 회귀분석(linear regression)을 한 결과는 가중치 벡터 w w w x i x_i x i w T x i w^Tx_i w T x i y i y_{i} y i 오차(error) 혹은 잔차(residual) e i e_i e i e e e

e i = y i − y ^ i = y i − w T x i (2.2.80) e_i = y_i - \hat{y}_i = y_i - w^Tx_i \tag{2.2.80} e i = y i − y ^ i = y i − w T x i ( 2 . 2 . 8 0 ) 잔차 벡터는 다음처럼 y − X w y-Xw y − X w

e = [ e 1 e 2 ⋮ e M ] = [ y 1 y 2 ⋮ y M ] − [ x 1 T w x 2 T w ⋮ x M T w ] = y − X w (2.2.81) \begin{aligned} e &= \begin{bmatrix} e_{1} \\ e_{2} \\ \vdots \\ e_{M} \\ \end{bmatrix} \\ &= \begin{bmatrix} y_{1} \\ y_{2} \\ \vdots \\ y_{M} \\ \end{bmatrix} - \begin{bmatrix} x^T_{1}w \\ x^T_{2}w \\ \vdots \\ x^T_{M}w \\ \end{bmatrix} \\ &= y - Xw \end{aligned} \tag{2.2.81} e = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ e 1 e 2 ⋮ e M ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ y 1 y 2 ⋮ y M ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ − ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 T w x 2 T w ⋮ x M T w ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = y − X w ( 2 . 2 . 8 1 ) e = y − X w (2.2.82) e = y - Xw \tag{2.2.82} e = y − X w ( 2 . 2 . 8 2 ) 잔차 제곱합

잔차의 크기는 잔차 벡터의 각 원소를 제곱한 후 더한 잔차 제곱합(RSS: Residual Sum of Squares) 을 이용하여 구한다. 이 값은 e T e e^Te e T e

∑ i = 1 N e i 2 = ∑ i = 1 N ( y i − w T x i ) 2 = e T e = ( y − X w ) T ( y − X w ) (2.2.83) \sum_{i=1}^{N} e_i^2 = \sum_{i=1}^{N} (y_i - w^Tx_i)^2 = e^Te = (y - Xw)^T (y - Xw) \tag{2.2.83} i = 1 ∑ N e i 2 = i = 1 ∑ N ( y i − w T x i ) 2 = e T e = ( y − X w ) T ( y − X w ) ( 2 . 2 . 8 3 ) 연습 문제 2.2.10

분배 법칙을 사용하여 위 식 ( y − X w ) T ( y − X w ) (y - Xw)^T (y - Xw) ( y − X w ) T ( y − X w )

( y − X w ) T ( y − X w ) = y T y − w T X T y − y T X w + w T X T X w (2.2.84) (y - Xw)^T (y - Xw) = y^Ty - w^TX^Ty - y^TXw + w^TX^TXw \tag{2.2.84} ( y − X w ) T ( y − X w ) = y T y − w T X T y − y T X w + w T X T X w ( 2 . 2 . 8 4 ) ✒️X w Xw X w w T X T w^T X^T w T X T

이차형식

위의 연습 문제에서 마지막 항은 w T X T X w w^TX^TXw w T X T X w X T X X^TX X T X A A A w T A w w^TAw w T A w

벡터의 이차형식(Quadratic Form) 이란 이처럼 어떤 벡터와 정방행렬이 '행벡터 × \times × × \times ×

이 수식을 풀면 i = 1 , … , N , j = 1 , … , N i=1,\ldots,N, j=1,\ldots,N i = 1 , … , N , j = 1 , … , N i , j i,j i , j i i i j j j x i x_i x i x j x_j x j a i , j a_{i,j} a i , j a i , j x i x j a_{i,j}x_ix_j a i , j x i x j

이차 형식 더 알아보기

x T A x = [ x 1 x 2 ⋯ x N ] [ a 1 , 1 a 1 , 2 ⋯ a 1 , N a 2 , 1 a 2 , 2 ⋯ a 2 , N ⋮ ⋮ ⋱ ⋮ a N , 1 a N , 2 ⋯ a N , N ] [ x 1 x 2 ⋮ x N ] = ∑ i = 1 N ∑ j = 1 N a i , j x i x j (2.2.85) \begin{aligned} x^T A x &= \begin{bmatrix} x_{1} & x_{2} & \cdots & x_{N} \end{bmatrix} \begin{bmatrix} a_{1,1} & a_{1,2} & \cdots & a_{1,N} \\ a_{2,1} & a_{2,2} & \cdots & a_{2,N} \\ \vdots & \vdots & \ddots & \vdots \\ a_{N,1} & a_{N,2} & \cdots & a_{N,N} \\ \end{bmatrix} \begin{bmatrix} x_{1} \\ x_{2} \\ \vdots \\ x_{N} \\ \end{bmatrix} \\ &= \sum_{i=1}^{N} \sum_{j=1}^{N} a_{i,j} x_i x_j \end{aligned} \tag{2.2.85} x T A x = [ x 1 x 2 ⋯ x N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ a 1 , 1 a 2 , 1 ⋮ a N , 1 a 1 , 2 a 2 , 2 ⋮ a N , 2 ⋯ ⋯ ⋱ ⋯ a 1 , N a 2 , N ⋮ a N , N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ x 1 x 2 ⋮ x N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = i = 1 ∑ N j = 1 ∑ N a i , j x i x j ( 2 . 2 . 8 5 ) 연습 문제 2.2.11

다음 3차원 벡터와 행렬에 대해 이차형식을 쓰고 값을 계산하라.

x = [ x 1 x 2 x 3 ] (2.2.86) x = \begin{bmatrix} x_1 \\ x_2 \\ x_3 \end{bmatrix} \tag{2.2.86} x = ⎣ ⎢ ⎡ x 1 x 2 x 3 ⎦ ⎥ ⎤ ( 2 . 2 . 8 6 ) ✒️x T A x x^TAx x T A x a 11 x 11 + a 12 x 12 + a 13 x 13 + a 21 x 21 + a 22 x 22 + a 23 x 23 + a 31 x 31 + a 32 x 32 + a 33 x 33 a_{11}x_{11}+a_{12}x_{12}+a_{13}x_{13}+a_{21}x_{21}+a_{22}x_{22}+a_{23}x_{23}+a_{31}x_{31}+a_{32}x_{32}+a_{33}x_{33} a 1 1 x 1 1 + a 1 2 x 1 2 + a 1 3 x 1 3 + a 2 1 x 2 1 + a 2 2 x 2 2 + a 2 3 x 2 3 + a 3 1 x 3 1 + a 3 2 x 3 2 + a 3 3 x 3 3 x i j = x i x j x_{ij}=x_ix_j x i j = x i x j

A = [ a 11 a 12 a 13 a 21 a 22 a 23 a 31 a 32 a 33 ] (2.2.87) A = \begin{bmatrix} a_{11} & a_{12} & a_{13} \\ a_{21} & a_{22} & a_{23} \\ a_{31} & a_{32} & a_{33} \\ \end{bmatrix} \tag{2.2.87} A = ⎣ ⎢ ⎡ a 1 1 a 2 1 a 3 1 a 1 2 a 2 2 a 3 2 a 1 3 a 2 3 a 3 3 ⎦ ⎥ ⎤ ( 2 . 2 . 8 7 ) 예를 들어 $ x = [1, 2, 3]^T $ 이고 A가 다음과 같다면

A = [ 1 2 3 4 5 6 7 8 9 ] (2.2.88) A = \begin{bmatrix} 1 & 2 & 3 \\ 4 & 5 & 6 \\ 7 & 8 & 9 \\ \end{bmatrix} \tag{2.2.88} A = ⎣ ⎢ ⎡ 1 4 7 2 5 8 3 6 9 ⎦ ⎥ ⎤ ( 2 . 2 . 8 8 ) 넘파이 에서 벡터의 이차형식은 다음처럼 계산한다.

x = np. array( [ 1 , 2 , 3 ] )

xarray([1, 2, 3])

A = np. arange( 1 , 10 ) . reshape( 3 , 3 )

Aarray([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

x. T @ A @ x228

연습 문제 2.2.12

다음 식이 성립함을 증명하라.

x T A x = 1 2 x T ( A + A T ) x (2.2.89) x^TAx = \dfrac{1}{2}x^T(A + A^T)x \tag{2.2.89} x T A x = 2 1 x T ( A + A T ) x ( 2 . 2 . 8 9 ) ✒️A + A T A + A^T A + A T A A A x x x A A A x T A x = x T A T x x^TAx = x^TA^Tx x T A x = x T A T x ∑ i = 1 N ∑ j = 1 N a i , j x i x j \sum_{i=1}^{N} \sum_{j=1}^{N} a_{i,j} x_i x_j ∑ i = 1 N ∑ j = 1 N a i , j x i x j ∑ j = 1 N ∑ i = 1 N a i , j x j x i \sum_{j=1}^{N} \sum_{i=1}^{N} a_{i,j} x_j x_i ∑ j = 1 N ∑ i = 1 N a i , j x j x i x T A T x x^TA^Tx x T A T x

부분행렬

다음과 같은 2차원 정방행렬 A A A B B B

A = [ a 11 a 12 a 21 a 22 ] , B = [ b 11 b 12 b 21 b 22 ] (2.2.90) A = \begin{bmatrix} a_{11} & a_{12} \\ a_{21} & a_{22} \end{bmatrix} ,\;\; B = \begin{bmatrix} b_{11} & b_{12} \\ b_{21} & b_{22} \end{bmatrix} \tag{2.2.90} A = [ a 1 1 a 2 1 a 1 2 a 2 2 ] , B = [ b 1 1 b 2 1 b 1 2 b 2 2 ] ( 2 . 2 . 9 0 ) 이때 두 행렬의 곱 A B AB A B A A A B B B 부분행렬(submatrix) 을 이용하여 여러 방법으로 계산할 수 있다.

(1) 우선 앞에 곱해지는 행렬을 행벡터로 나누어 계산해도 된다.

A = [ a 1 T a 2 T ] (2.2.91) A = \begin{bmatrix} \boxed{\begin{matrix} \phantom{} & a_1^T & \phantom{} \end{matrix}} \\ \boxed{\begin{matrix} \phantom{} & a_2^T & \phantom{} \end{matrix}} \\ \end{bmatrix} \tag{2.2.91} A = ⎣ ⎢ ⎡ a 1 T a 2 T ⎦ ⎥ ⎤ ( 2 . 2 . 9 1 ) 즉,

a 1 T = [ a 11 a 12 ] , a 2 T = [ a 21 a 22 ] (2.2.92) a_1^T = \begin{bmatrix} a_{11} & a_{12} \end{bmatrix} ,\;\; a_2^T = \begin{bmatrix} a_{21} & a_{22} \end{bmatrix} \tag{2.2.92} a 1 T = [ a 1 1 a 1 2 ] , a 2 T = [ a 2 1 a 2 2 ] ( 2 . 2 . 9 2 ) 이면

A B = [ a 1 T a 2 T ] B = [ a 1 T B a 2 T B ] (2.2.93) AB = \begin{bmatrix} \boxed{\begin{matrix} \phantom{} & a_1^T & \phantom{} \end{matrix}} \\ \boxed{\begin{matrix} \phantom{} & a_2^T & \phantom{} \end{matrix}} \\ \end{bmatrix} B = \begin{bmatrix} \boxed{\begin{matrix} \phantom{} & a_1^TB & \phantom{} \end{matrix}} \\ \boxed{\begin{matrix} \phantom{} & a_2^TB & \phantom{} \end{matrix}} \\ \end{bmatrix} \tag{2.2.93} A B = ⎣ ⎢ ⎡ a 1 T a 2 T ⎦ ⎥ ⎤ B = ⎣ ⎢ ⎡ a 1 T B a 2 T B ⎦ ⎥ ⎤ ( 2 . 2 . 9 3 ) (2) 아니면 뒤에 곱해지는 행렬을 열벡터로 나누어 계산해도 된다.

B = [ \mathstrut b 1 \mathstrut \mathstrut b 2 \mathstrut ] (2.2.94) B = \begin{bmatrix} \boxed{\begin{matrix} \phantom{\mathstrut} \\ b_1 \\ \phantom{\mathstrut} \end{matrix}} \!\!\!\! & \boxed{\begin{matrix} \phantom{\mathstrut} \\ b_2 \\ \phantom{\mathstrut} \end{matrix}} \end{bmatrix} \tag{2.2.94} B = ⎣ ⎢ ⎢ ⎡ \mathstrut b 1 \mathstrut \mathstrut b 2 \mathstrut ⎦ ⎥ ⎥ ⎤ ( 2 . 2 . 9 4 ) 즉,

b 1 = [ b 11 b 21 ] , b 2 = [ b 21 b 22 ] (2.2.95) b_1 = \begin{bmatrix} b_{11} \\ b_{21} \\ \end{bmatrix} ,\;\; b_2 = \begin{bmatrix} b_{21} \\ b_{22} \end{bmatrix} \tag{2.2.95} b 1 = [ b 1 1 b 2 1 ] , b 2 = [ b 2 1 b 2 2 ] ( 2 . 2 . 9 5 ) 이면

A B = A [ \mathstrut b 1 \mathstrut \mathstrut b 2 \mathstrut ] = [ \mathstrut A b 1 \mathstrut \mathstrut A b 2 \mathstrut ] (2.2.96) AB = A \begin{bmatrix} \boxed{\begin{matrix} \phantom{\mathstrut} \\ b_1 \\ \phantom{\mathstrut} \end{matrix}} \!\!\!\! & \boxed{\begin{matrix} \phantom{\mathstrut} \\ b_2 \\ \phantom{\mathstrut} \end{matrix}} \end{bmatrix} = \begin{bmatrix} \boxed{\begin{matrix} \phantom{\mathstrut} \\ Ab_1 \\ \phantom{\mathstrut} \end{matrix}} \!\!\!\! & \boxed{\begin{matrix} \phantom{\mathstrut} \\ Ab_2 \\ \phantom{\mathstrut} \end{matrix}} \end{bmatrix} \tag{2.2.96} A B = A ⎣ ⎢ ⎢ ⎡ \mathstrut b 1 \mathstrut \mathstrut b 2 \mathstrut ⎦ ⎥ ⎥ ⎤ = ⎣ ⎢ ⎢ ⎡ \mathstrut A b 1 \mathstrut \mathstrut A b 2 \mathstrut ⎦ ⎥ ⎥ ⎤ ( 2 . 2 . 9 6 ) (3) 앞에 곱해지는 행렬을 열벡터로, 뒤에 곱해지는 행렬을 행벡터로 나누어 스칼라처럼 계산해도 된다.

A B = [ a 1 a 2 ] [ b 1 T b 2 T ] = a 1 b 1 T + a 2 b 2 T (2.2.97) AB = \begin{bmatrix} a_1 & a_2 \end{bmatrix} \begin{bmatrix} b_1^T \\ b_2^T \end{bmatrix} = a_1b_1^T + a_2b_2^T \tag{2.2.97} A B = [ a 1 a 2 ] [ b 1 T b 2 T ] = a 1 b 1 T + a 2 b 2 T ( 2 . 2 . 9 7 ) 벡터의 크기를 직사각형으로 표시하면 다음과 같다.

A B = [ \mathstrut a 1 \mathstrut \mathstrut a 2 \mathstrut ] [ b 1 T b 2 T ] = \mathstrut a 1 \mathstrut b 1 T + \mathstrut b 1 \mathstrut b 2 T (2.2.98) AB = \begin{bmatrix} \boxed{\begin{matrix} \phantom{\mathstrut} \\ a_1 \\ \phantom{\mathstrut} \end{matrix}} \!\!\!\!& \boxed{\begin{matrix} \phantom{\mathstrut} \\ a_2 \\ \phantom{\mathstrut} \end{matrix}} \! \end{bmatrix} \begin{bmatrix} \boxed{\begin{matrix} \phantom{} & b_1^T & \phantom{} \end{matrix}} \\ \boxed{\begin{matrix} \phantom{} & b_2^T & \phantom{} \end{matrix}} \\ \end{bmatrix} = \boxed{\begin{matrix} \phantom{\mathstrut} \\ a_1 \\ \phantom{\mathstrut} \end{matrix}} \boxed{\begin{matrix} \phantom{} & b_1^T & \phantom{} \end{matrix}} + \boxed{\begin{matrix} \phantom{\mathstrut} \\ b_1 \\ \phantom{\mathstrut} \end{matrix}} \boxed{\begin{matrix} \phantom{} & b_2^T & \phantom{} \end{matrix}} \tag{2.2.98} A B = ⎣ ⎢ ⎢ ⎡ \mathstrut a 1 \mathstrut \mathstrut a 2 \mathstrut ⎦ ⎥ ⎥ ⎤ ⎣ ⎢ ⎡ b 1 T b 2 T ⎦ ⎥ ⎤ = \mathstrut a 1 \mathstrut b 1 T + \mathstrut b 1 \mathstrut b 2 T ( 2 . 2 . 9 8 ) 여기에서는 2차원 행렬의 예를 들었지만 일반적인 N N N

연습 문제 2.2.13

행렬 V V V v i ( i = 1 , … , N ) v_i\;(i=1,\ldots,N) v i ( i = 1 , … , N ) V V V A A A Λ \Lambda Λ

A V = A [ v 1 ⋯ v N ] = [ A v 1 ⋯ A v N ] (2.2.99) AV = A \left[ v_1 \cdots v_N \right] = \left[ A v_1 \cdots A v_N \right] \tag{2.2.99} A V = A [ v 1 ⋯ v N ] = [ A v 1 ⋯ A v N ] ( 2 . 2 . 9 9 ) V Λ = [ v 1 ⋯ v N ] [ λ 1 0 ⋯ 0 0 λ 2 ⋯ 0 ⋮ ⋮ ⋱ ⋮ 0 0 ⋯ λ N ] = [ λ 1 v 1 ⋯ λ N v N ] (2.2.100) V\Lambda = \left[ v_1 \cdots v_N \right] \begin{bmatrix} \lambda_{1} & 0 & \cdots & 0 \\ 0 & \lambda_{2} & \cdots & 0 \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \cdots & \lambda_{N} \\ \end{bmatrix} = \left[ \lambda_1 v_1 \cdots \lambda_N v_N \right] \tag{2.2.100} V Λ = [ v 1 ⋯ v N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ λ 1 0 ⋮ 0 0 λ 2 ⋮ 0 ⋯ ⋯ ⋱ ⋯ 0 0 ⋮ λ N ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = [ λ 1 v 1 ⋯ λ N v N ] ( 2 . 2 . 1 0 0 ) N = 3 N=3 N = 3

✒️

import numpy as np

A = np. random. randint( 1 , 100 , 9 ) . reshape( 3 , 3 )

H = np. diag( np. random. randint( 1 , 100 , 3 ) )

v1 = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

v2 = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

v3 = np. random. randint( 1 , 100 , 3 ) . reshape( 3 , 1 )

V = np. hstack( [ v1, v2, v3] ) . reshape( 3 , 3 )

print ( A @ V == np. hstack( [ A @ v1, A @ v2, A @ v3] ) )

print ( V @ H == np. hstack( [ H[ 0 , 0 ] * v1, H[ 1 , 1 ] * v2, H[ 2 , 2 ] * v3] ) ) 연습 문제 2.2.14

부분행렬 공식 (3)으로부터 A A A a i T ( i = 1 , … , N ) a_i^T\;(i=1,\ldots,N) a i T ( i = 1 , … , N ) N N N

A = [ a 1 T a 2 T ⋮ a N T ] (2.2.101) A = \begin{bmatrix} a_1^T \\ a_2^T \\ \vdots \\ a_N^T \end{bmatrix} \tag{2.2.101} A = ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ a 1 T a 2 T ⋮ a N T ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ ( 2 . 2 . 1 0 1 ) 다음 관계가 성립한다.

A T A = [ a 1 a 2 ⋯ a N ] [ a 1 T a 2 T ⋮ a N T ] = ∑ i = 1 N a i a i T (2.2.102) A^T A = \begin{bmatrix} a_1 & a_2 & \cdots & a_N \end{bmatrix} \begin{bmatrix} a_1^T \\ a_2^T \\ \vdots \\ a_N^T \end{bmatrix} = \sum_{i=1}^N a_ia_i^T \tag{2.2.102} A T A = [ a 1 a 2 ⋯ a N ] ⎣ ⎢ ⎢ ⎢ ⎢ ⎡ a 1 T a 2 T ⋮ a N T ⎦ ⎥ ⎥ ⎥ ⎥ ⎤ = i = 1 ∑ N a i a i T ( 2 . 2 . 1 0 2 ) N = 3 N=3 N = 3

✒️A = [ a 11 a 12 a 13 a 21 a 22 a 23 a 31 a 32 a 33 ] A = \begin{bmatrix}a_{11} & a_{12} & a_{13} \\a_{21} & a_{22} & a_{23} \\a_{31} & a_{32} & a_{33}\end{bmatrix} A = ⎣ ⎢ ⎡ a 1 1 a 2 1 a 3 1 a 1 2 a 2 2 a 3 2 a 1 3 a 2 3 a 3 3 ⎦ ⎥ ⎤

A T = [ a 11 a 21 a 31 a 12 a 22 a 32 a 13 a 23 a 33 ] A^T = \begin{bmatrix}a_{11} & a_{21} & a_{31} \\a_{12} & a_{22} & a_{32} \\a_{13} & a_{23} & a_{33}\end{bmatrix} A T = ⎣ ⎢ ⎡ a 1 1 a 1 2 a 1 3 a 2 1 a 2 2 a 2 3 a 3 1 a 3 2 a 3 3 ⎦ ⎥ ⎤

좌변: A T A = [ a 11 a 21 a 31 a 12 a 22 a 32 a 13 a 23 a 33 ] [ a 11 a 12 a 13 a 21 a 22 a 23 a 31 a 32 a 33 ] … ( 1 ) A^TA = \begin{bmatrix}a_{11} & a_{21} & a_{31} \\a_{12} & a_{22} & a_{32} \\a_{13} & a_{23} & a_{33}\end{bmatrix}\begin{bmatrix}a_{11} & a_{12} & a_{13} \\a_{21} & a_{22} & a_{23} \\a_{31} & a_{32} & a_{33}\end{bmatrix}\dots(1) A T A = ⎣ ⎢ ⎡ a 1 1 a 1 2 a 1 3 a 2 1 a 2 2 a 2 3 a 3 1 a 3 2 a 3 3 ⎦ ⎥ ⎤ ⎣ ⎢ ⎡ a 1 1 a 2 1 a 3 1 a 1 2 a 2 2 a 3 2 a 1 3 a 2 3 a 3 3 ⎦ ⎥ ⎤ … ( 1 )

우변: ∑ i = 1 3 a i a i T = a 1 a 1 T + a 2 a 2 T + a 3 a 3 T \sum_{i=1}^3 a_ia_i^T=a_1a_1^T+a_2a_2^T+a_3a_3^T ∑ i = 1 3 a i a i T = a 1 a 1 T + a 2 a 2 T + a 3 a 3 T

= [ a 11 a 12 a 13 ] [ a 11 a 12 a 13 ] + [ a 21 a 22 a 23 ] [ a 21 a 22 a 23 ] + [ a 31 a 32 a 33 ] [ a 31 a 32 a 33 ] … ( 2 ) =\begin{bmatrix} a_{11} \\ a_{12} \\ a_{13} \end{bmatrix}\begin{bmatrix} a_{11} & a_{12} & a_{13} \end{bmatrix}+\begin{bmatrix} a_{21} \\ a_{22} \\ a_{23} \end{bmatrix}\begin{bmatrix} a_{21} & a_{22} & a_{23} \end{bmatrix}+\begin{bmatrix} a_{31} \\ a_{32} \\ a_{33} \end{bmatrix}\begin{bmatrix} a_{31} & a_{32} & a_{33} \end{bmatrix}\dots(2) = ⎣ ⎢ ⎡ a 1 1 a 1 2 a 1 3 ⎦ ⎥ ⎤ [ a 1 1 a 1 2 a 1 3 ] + ⎣ ⎢ ⎡ a 2 1 a 2 2 a 2 3 ⎦ ⎥ ⎤ [ a 2 1 a 2 2 a 2 3 ] + ⎣ ⎢ ⎡ a 3 1 a 3 2 a 3 3 ⎦ ⎥ ⎤ [ a 3 1 a 3 2 a 3 3 ] … ( 2 )

(1), (2) 를 전개하면 같다.