이 블로그글은 2019년 조재영(Kevin Jo), 김승수(SeungSu Kim)님의 딥러닝 홀로서기 세미나를 수강하고 작성한 글임을 밝힙니다.

Github : 실습 코드 링크

Linear Rergression (with pure python)

💡 목표 : Linear Regression Problem에 대해 pytorch, numpy, pandas를 사용하지 않고 구현하기

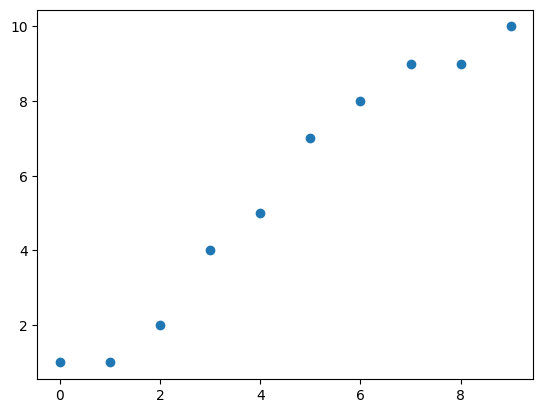

데이터 생성(정의)

- 공부시간에 따른 성적

| 공부 시간 | 성적 |

|---|---|

| 0 | 1 |

| 1 | 1 |

| 2 | 2 |

| 3 | 4 |

| 4 | 5 |

| 5 | 7 |

| 6 | 8 |

| 7 | 9 |

| 8 | 9 |

| 9 | 10 |

X = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

Y = [1, 1, 2, 4, 5, 7, 8, 9, 9, 10]시각화

import matplotlib.pyplot as plt

plt.scatter(X, Y)

plt.show()

Hypothesis 정의 (모델 정의)

- f(x) = Wx라는 모델 정

class H():

def __init__(self, w):

self.w = w

def forward(self, x):

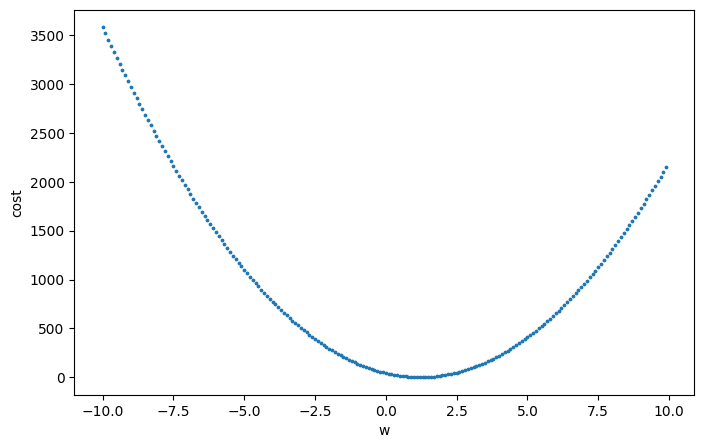

return self.w * xCost Function 정의

- Regression problem의 cost function 정의

def cost(pred_y, true_y):

error = 0

for i in range(len(X)):

error += (pred_y[i] - Y[i]) ** 2

return error / len(X)w에 따른 cost의 변화 시각화

list_w = []

list_c = []

for i in range(-100, 100):

w = i * 0.1

h = H(w)

pred_y = [h.forward(x) for x in X]

c = cost(pred_y, Y)

list_w.append(w)

list_c.append(c)

plt.figure(figsize=(8, 5))

plt.xlabel('w')

plt.ylabel('cost')

plt.scatter(list_w, list_c, s=3)

plt.show()

→w = 1.25 쯤 cost가 최소가 됨

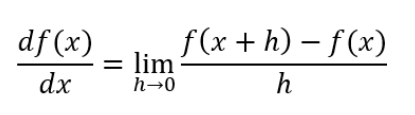

Gradient Descent Algorithm

-

두 가지 방법으로 정의가 가능함

-

수치 미분을 이용한 방법

-

편미분을 이용한 방법 (여기서는 가중치가 W만 존재)

-

수치 미분을 이용한 그래디언트 정의

def cal_grad(w, cost):

eps = 0.00001

h1 = H(w)

pred_y1 = [h1.forward(x) for x in X]

cost1 = cost(pred_y1, Y)

h2 = H(w + eps)

pred_y2 = [h2.forward(x) for x in X]

cost2 = cost(pred_y2, Y)

dcost = cost2 - cost1

dw = eps

grad = dcost / dw

return grad, (cost1 + cost2) / 2편미분을 이용한 그래디언트 정의

def cal_grad2(w, cost):

h = H(w)

grad = 0

pred_y = [h.forward(x) for x in X]

for i in range(len(X)):

grad += 2 * (pred_y[i] - Y[i]) * X[i]

grad /= len(X)

c = cost(pred_y, Y)

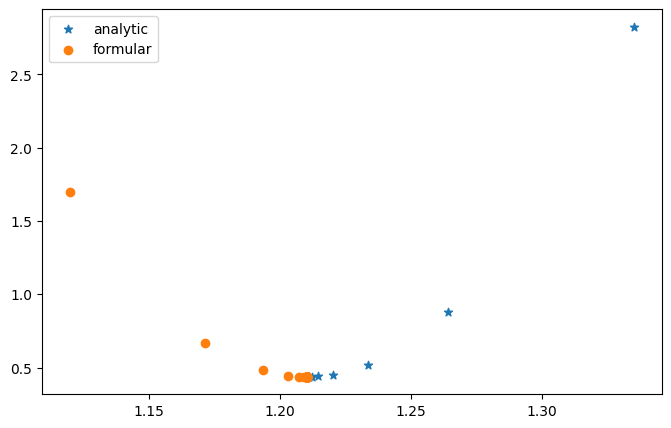

return grad, c두 가지 방법 비교

# 초기 가중치와 학습률

w1 = 1.5

w2 = 1

lr = 0.01

list_w1 = []

list_c1 = []

list_w2 = []

list_c2 = []

# 학습 진행

for i in range(100):

grad1, mean_cost1 = cal_grad(w1, cost)

grad2, mean_cost2 = cal_grad2(w2, cost)

w1 -= lr * grad1

w2 -= lr * grad2

list_w1.append(w1)

list_c1.append(mean_cost1)

list_w2.append(w2)

list_c2.append(mean_cost2)

# 학습 100번 이후에 결과

print(f"수치해석학을 이용한 방법 : w = {w1}, cost = {mean_cost1})")

print(f"편미분을 이용한 방법 : w = {w2}, cost = {mean_cost2})")

# w 값에 따른 cost 시각화

plt.figure(figsize=(8, 5))

plt.scatter(list_w1, list_c1, label='analytic', marker='*')

plt.scatter(list_w2, list_c2, label='formular')

plt.legend()

plt.show()

→ 두 가지 방법 모두에서 결국 비슷한 값으로 수렴됨